📬📬我是上进小菜猪,沈工大软件工程专业,爱好敲代码,持续输出干货,欢迎关注。

引言: 随着大数据技术的快速发展,企业和组织需要从各种来源采集海量数据。数据采集是大数据处理流程中至关重要的一环,而Apache Flume作为一个可靠的、可扩展的数据采集工具,在大数据领域扮演着重要的角色。本文将深入探索Apache Flume的技术原理和核心组件,并通过代码实例展示其在实际应用中的使用方法。

一、Apache Flume概述

Apache Flume是一个开源的、分布式的数据采集系统,旨在可靠地、高效地从各种数据源采集、聚合和传输数据到目的地。Flume的设计目标是解决大规模数据采集的可靠性和扩展性问题。其基于可插拔的架构和配置驱动的方式,使得用户可以方便地定制和扩展数据采集的流程。

二、Flume的核心组件

2.1 Source(数据源)

Flume的数据源是指数据采集的起点,它负责从外部数据源读取数据并将其传递给Flume的通道。Flume提供了多种数据源类型,例如Avro Source、Thrift Source和Spooling Directory Source。Avro Source支持通过Avro协议接收数据,Thrift Source支持通过Thrift协议接收数据,而Spooling Directory Source则监控指定目录下的文件,并将文件内容作为数据源。

2.2 Channel(通道)

通道是Flume的核心组件之一,用于缓存和传递从数据源接收到的数据。Flume提供了多种通道类型,如Memory Channel、File Channel和Kafka Channel。Memory Channel将数据存储在内存中,适用于高吞吐量和低延迟的场景;File Channel将数据存储在本地文件系统中,适用于对数据持久化有要求的场景;Kafka Channel基于Apache Kafka实现,支持高可靠性和可扩展性。

2.3 Sink(数据目的地)

Sink是Flume的数据目的地,它负责将数据从通道中取出并发送到指定的目标系统。Flume提供了多种Sink类型,如HDFS Sink、Hive Sink和Elasticsearch Sink。HDFS Sink将数据写入Hadoop分布式文件系统,Hive Sink将数据写入Hive表,Elasticsearch Sink将数据写入Elasticsearch索引。

三、Flume的工作流程与数据流

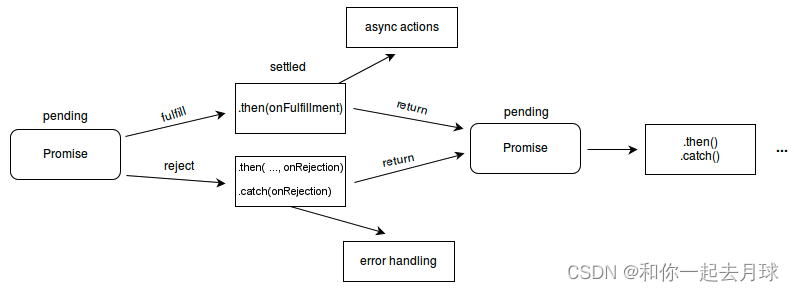

3.1 Agent与Event

Flume的工作单元称为Agent,一个Agent由一个或多个Source、Channel和Sink组成。Agent从数据源接收数据,将其转换为Event并传递给通道,然后Sink从通道中获取Event并将其发送到目的地。Event是Flume中的基本数据单元,它包含了原始数据以及相关的元数据。

3.2 Flume的工作流程

在Flume的工作流程中,数据源通过Source将数据发送到通道,然后Sink从通道中取出数据并发送到目的地。整个过程是基于事件驱动的,Flume通过事件的传递来实现数据的采集和传输。

四、Flume的配置与部署

4.1 Flume的配置文件结构

Flume的配置文件由多个部分组成,包括Agent名称、Source配置、Channel配置和Sink配置等。通过配置文件,用户可以定义数据源、通道、目的地以及它们之间的关系和属性。

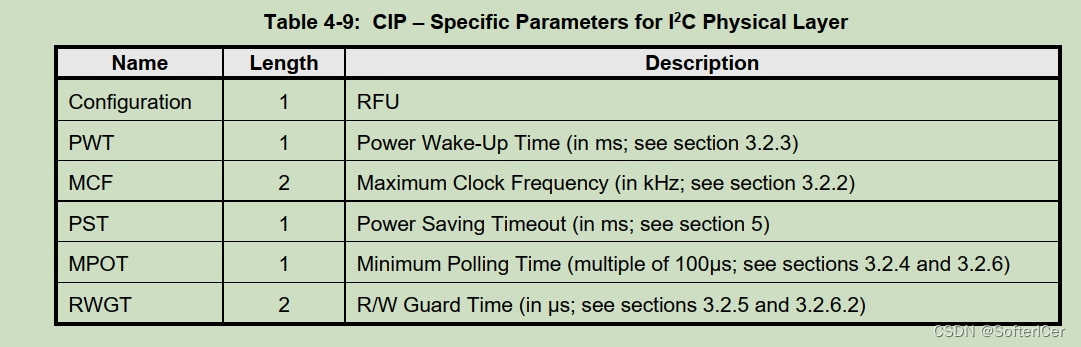

4.2 常用配置参数解析

在配置Flume时,用户需要理解和配置一些常用的参数。例如,Source的配置参数包括数据源类型、监听地址和端口等;Channel的配置参数包括通道类型、容量和事务等;Sink的配置参数包括目的地类型、目标地址和端口等。

代码实例: 下面是一个简单的Flume配置文件示例,用于将日志数据从一个Avro Source发送到一个HDFS Sink。

# flume.conf

agent.sources = avroSource

agent.channels = memoryChannel

agent.sinks = hdfsSink

# Avro Source

agent.sources.avroSource.type = org.apache.flume.source.avro.AvroSource

agent.sources.avroSource.bind = 0.0.0.0

agent.sources.avroSource.port = 44444

# Memory Channel

agent.channels.memoryChannel.type = memory

agent.channels.memoryChannel.capacity = 10000

# HDFS Sink

agent.sinks.hdfsSink.type = hdfs

agent.sinks.hdfsSink.hdfs.path = hdfs://localhost:9000/flume/logs

agent.sinks.hdfsSink.hdfs.fileType = DataStream

agent.sinks.hdfsSink.hdfs.writeFormat = Text

# Binding Source and Sink with Channel

agent.sources.avroSource.channels = memoryChannel

agent.sinks.hdfsSink.channel = memoryChannel

通过以上配置文件,可以启动一个Flume Agent,监听44444端口接收Avro格式的数据,并将数据写入到HDFS的指定路径中。

结论:

本文深入探索了Apache Flume在大数据领域的应用,介绍了其技术原理和核心组件。通过代码实例,读者可以更好地理解Flume的使用方法和工作流程。作为一个可靠的数据采集工具,Flume在大数据处理中扮演着重要的角色,为企业和组织提供了高效、可扩展的数据采集解决方案。随着大数据技术的不断发展,我们可以期待Flume在未来的进一步演进和创新。