文章目录

- Denoising for Relaxing: Unsupervised Domain Adaptive Fundus Image Segmentation Without Source Data

- 摘要

- 本文方法

- Pseudo Labeling with Class-Dependent Thresholds

- Label Self-correction Towards Effective Adaptation

- Class-Conditional Label Error Estimation

- Uncertainty-Rectified Label Soft Correction

- 总损失函数

- 实验结果

Denoising for Relaxing: Unsupervised Domain Adaptive Fundus Image Segmentation Without Source Data

摘要

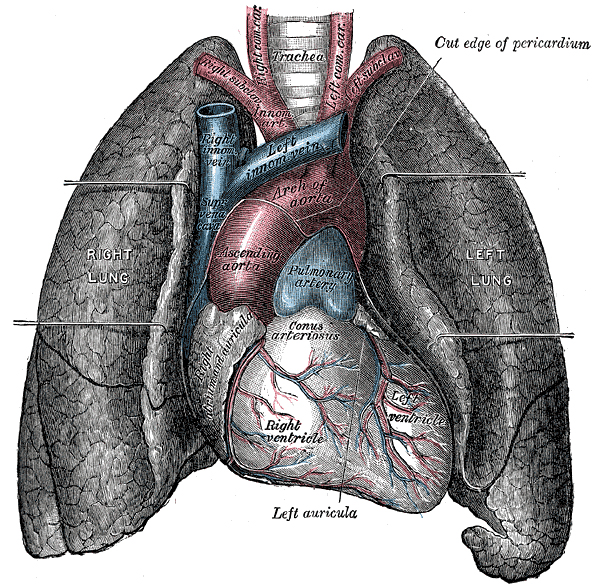

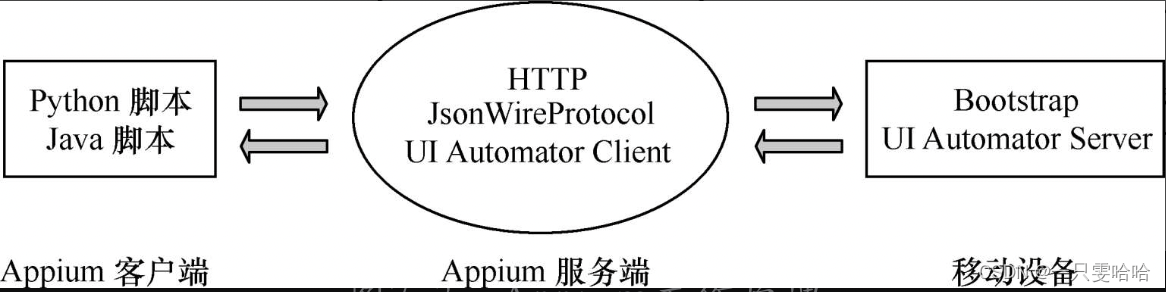

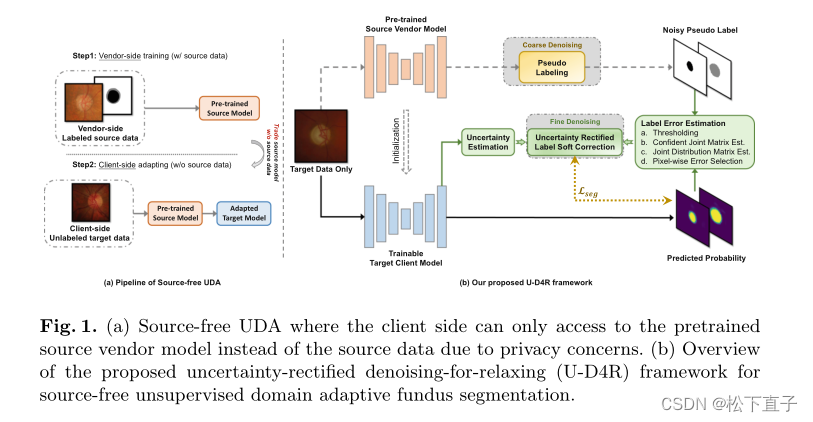

最近,无监督域自适应(UDA)被积极探索用于具有域差异的多点眼底图像分割。尽管放宽了对目标标签的要求,但典型的UDA仍然需要标记的源数据来在适应过程中实现分布对齐。不幸的是,由于隐私问题,供应商方在临床实践中往往无法向目标客户方提供源数据,这使得适应更具挑战性。

为了解决这一问题

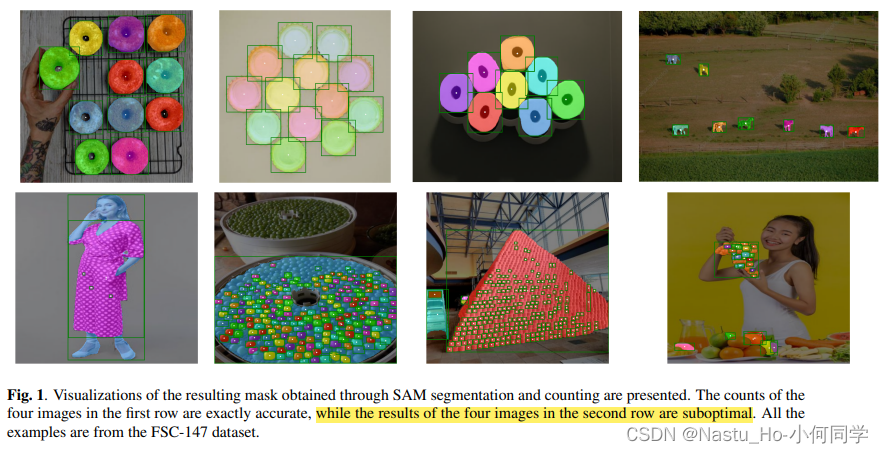

- 提出了一种新的不确定性校正去噪放松(U-D4R)框架,旨在完全放松源数据,并将预训练的源模型有效地适应目标域

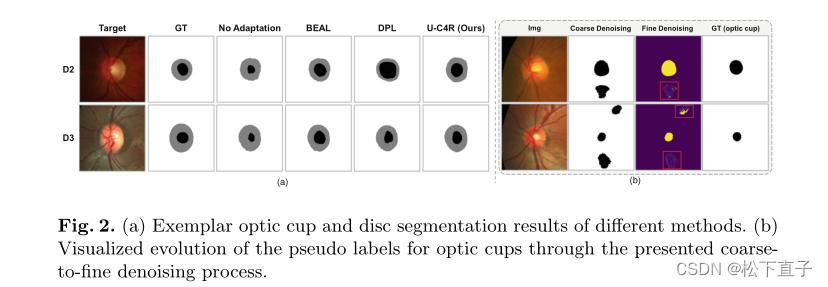

- 考虑到目标域上的源模型预测不可靠,我们首先提出了一种自适应类相关阈值策略作为粗去噪过程来生成伪标签

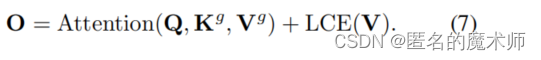

- 通过估计观察到的标签和潜在标签之间的联合分布矩阵,引入不确定性校正的标签软校正进行精细去噪

本文方法

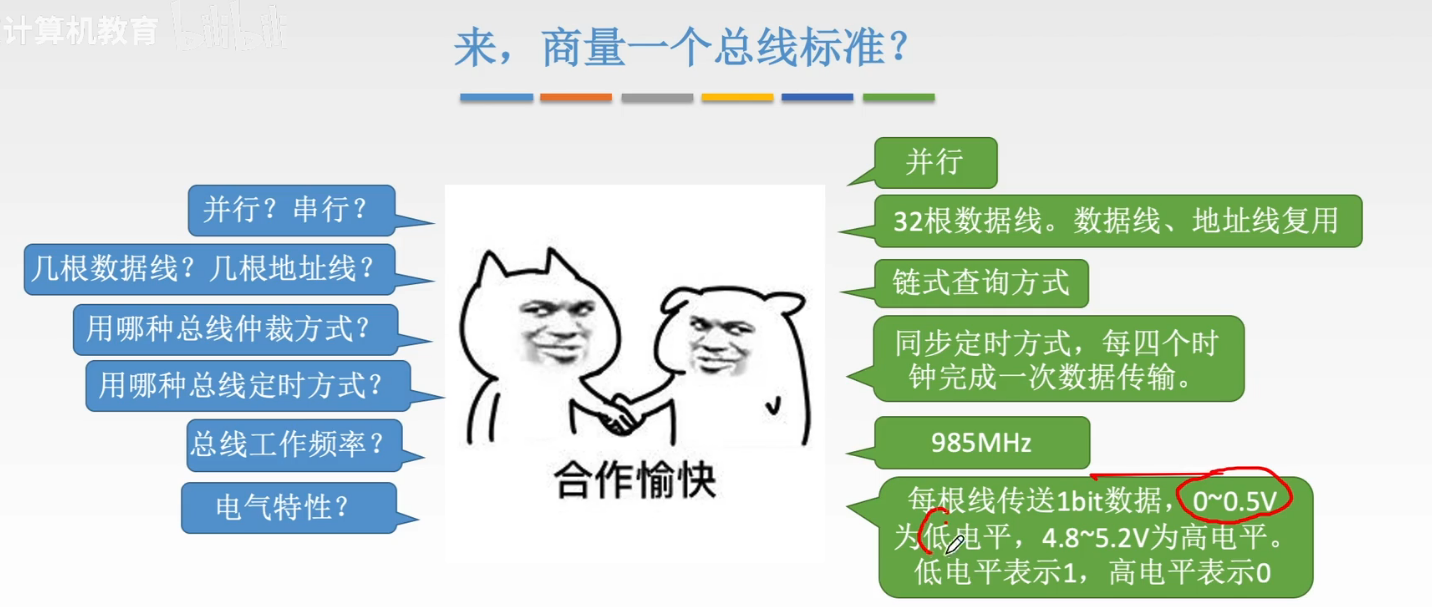

Pseudo Labeling with Class-Dependent Thresholds

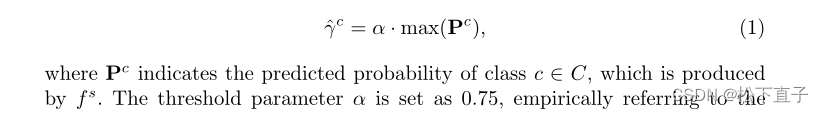

由于源数据和目标数据之间的域偏移,直接对预测概率应用argmax运算可能会导致不可靠的伪标签,而最近的策略是根据经验设置类别不可知的阈值γ来选择高置信度标签。尽管这种策略在过滤掉大多数噪声标签方面是有效的,但它可能会造成一个困境,即模型会偏向多数类而忽略少数类。为了避免不平衡的选择,我们建议将类相关阈值计算为:

Label Self-correction Towards Effective Adaptation

尽管伪标签质量有所提高,但简单阈值策略只能被视为一个粗略的去噪过程。我们发现,源域和目标域之间的差异往往会导致严重的过度自信的错误预测,因此伪标签中不可避免地存在重噪声。如果处理不当,噪声仍然会误导网络训练。因此,有必要进一步引入精细去噪过程。与利用从fs导出的不确定性和类原型来进一步丢弃不可靠的像素进行最终损失计算不同,我们采用了利用fs的预测→t作为第三方对伪标签进行精细校正。首先,我们考虑了类条件分类噪声过程(CNP)假设,该假设已在先前关于噪声标签的工作中被证明是有效的。

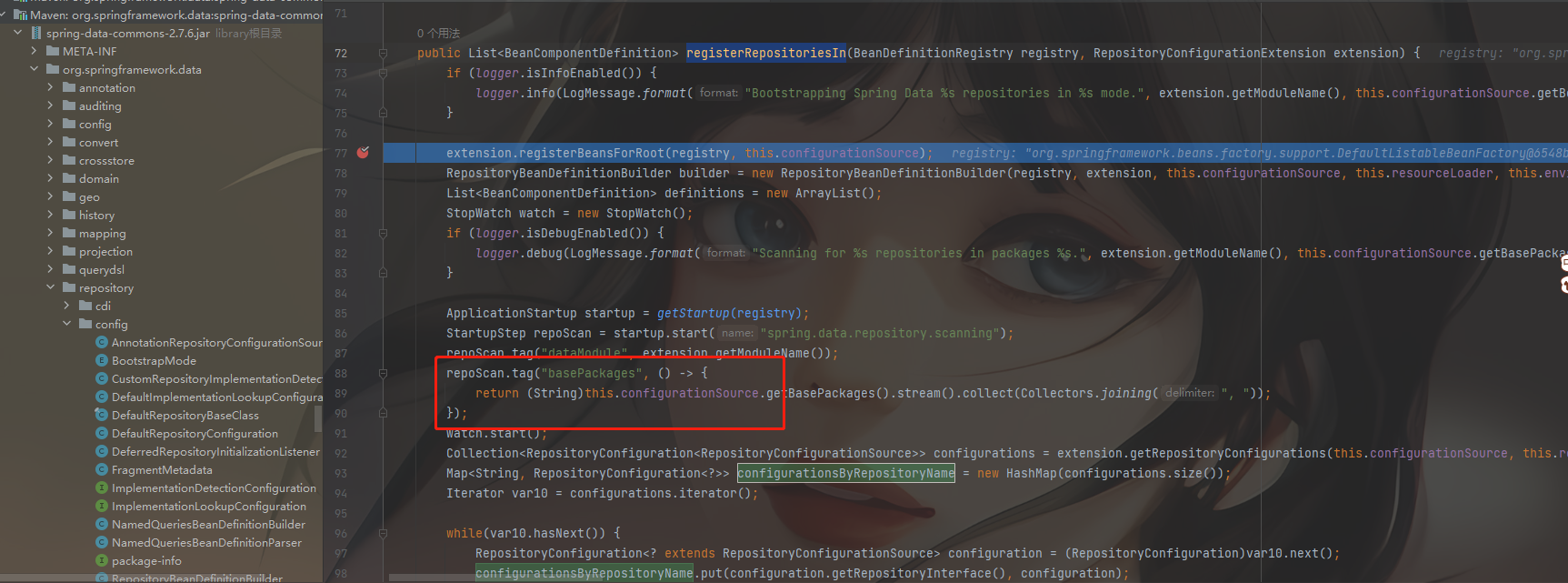

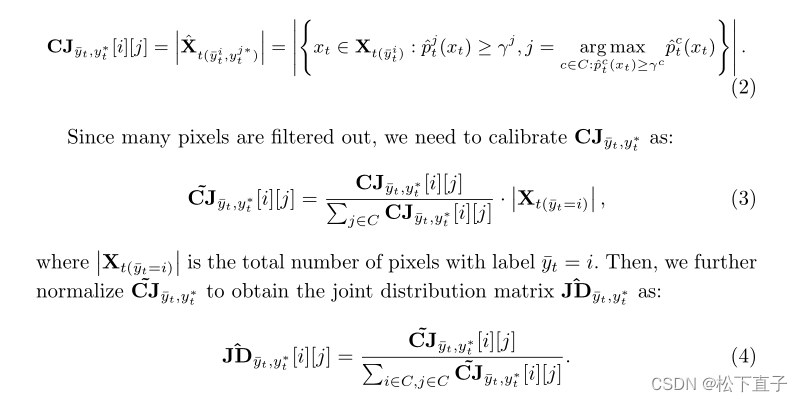

Class-Conditional Label Error Estimation

基于CNP假设,先前的工作揭示了置信联合矩阵,即将阈值策略集成到香草混淆矩阵中,提高了对类不平衡和过置信预测概率的鲁棒性,而其归一化统计量,此处称为联合分布矩阵,在从潜在标签噪声中估计任意不确定性方面是有效的

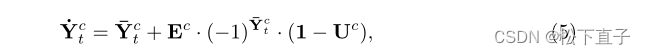

Uncertainty-Rectified Label Soft Correction

由于多部位眼底图像中的域偏移、边界模糊和器官形态复杂,很难从固有标签噪声中消除模型误差以完美估计这种联合分布,因此估计的误差图也可能包含噪声。

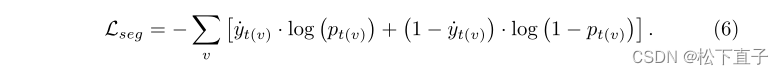

总损失函数

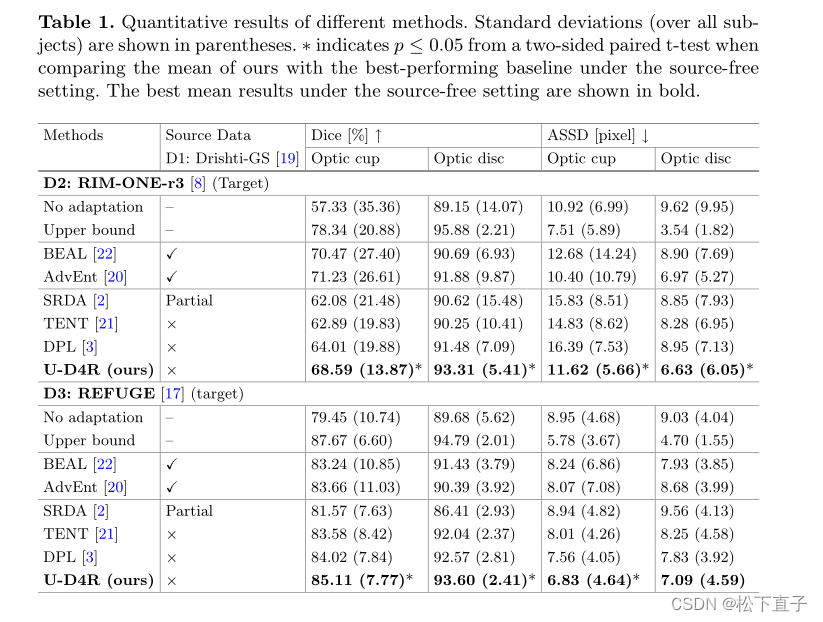

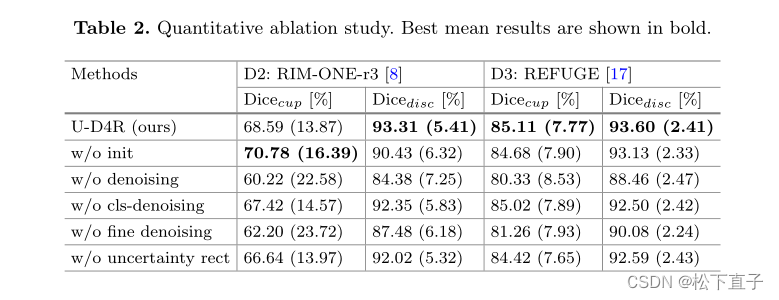

实验结果