2023年认证杯SPSSPRO杯数学建模

A题 碳板跑鞋

原题再现:

在专业运动鞋上使用的碳板,也可被称为碳纤维增强环氧树脂材料,事实上是将碳纤维织成布,再浸入环氧树脂固化后形成的板材。它以较轻的重量达到了相当好的弹性和刚度。在上世纪 90 年代就出现了鞋底嵌入碳板的篮球鞋。相比于软质鞋底,它可以提高对足底和足弓的支撑能力,使足部在发力时,足底更不容易变形,承托力更加均匀,进而提高抗扭性。这样可以提高运动能力,减少受伤的可能。最近几年,市场上又出现了一种鞋底嵌入碳板的跑鞋,生产商声称通过精心调整碳板的形状和弹性,配合高弹性的缓冲层,可以在跑步过程中恰当地发挥碳板的回弹能力,提高能量的利用率,最终有助于提高长跑成绩。著名长跑运动员基普乔格(Eliud Kipchoge)在 2017 年首次将碳板跑鞋应用于大型赛事中,并取得了相当惊人的成绩。他在近几年连破马拉松世界纪录,很多人认为,他所使用的最新技术的碳板跑鞋对此成绩也有一定的贡献。

第一阶段问题:

1. 我们可以看到多数普通马拉松跑鞋的鞋底从侧面看呈现向下凸起的弧形,鞋头和鞋跟都会略微上翘。请你和你的团队建立合理的数学模型,优化鞋底的侧剖面外形。请着重考虑跑鞋以及运动员的哪些特性会影响模型的结果。

2. 在上一问的基础上,如果我们在鞋底嵌入一块全长、侧剖面形状和外底相同的碳板。请你和你的团队建立合理的数学模型,估计此种设计会对长跑步伐的能量消耗起到怎样的作用,对成绩可能产生怎样的影响?

3. 如果我们打算全新设计一种在鞋底嵌入全长、侧剖面形状和外底相同的碳板的马拉松跑鞋,请为此目的来优化设计鞋底的侧剖面外形。并请与第一问的结果对比,判断二者是否存在区别并解释其成因。

整体求解过程概述(摘要)

本文拟研究基于有限元与神经网络的碳板跑鞋优化设计的问题,结合实际情况与马拉松运动员的不同特性进行分析,建立相关数学模型.

随着马拉松赛跑越来越流行,马拉松跑鞋也成了马拉松比赛的核心装备. 经过多年的发展,碳板跑鞋已经成为当下市场上主流路跑竞速鞋的模样. 碳板跑鞋配合高弹性的缓冲层,可以在跑步过程中恰当地发挥碳板的回弹能力,可有助于提高长跑成绩.

对于问题一,设计了跑鞋的结构数学模型,研究了跑鞋结构设计对马拉松运动员的影响,考虑了跑鞋的中底材料与属性、纵向弯曲刚度、鞋后跟角度、鞋质量、跟稳定剂等对跑步相关性能和损伤的影响,设计出适合大多数马拉松运动员的跑鞋. 然后考虑从运动员的年龄、性别以及马拉松的距离方面考虑并从损伤和效率方面评估跑鞋,并得出相应的结论. 再运用 Logistic 回归模型,评估年龄、性别、马拉松距离、速度以及运动员损伤程度等对跑鞋的选择的影响程度.

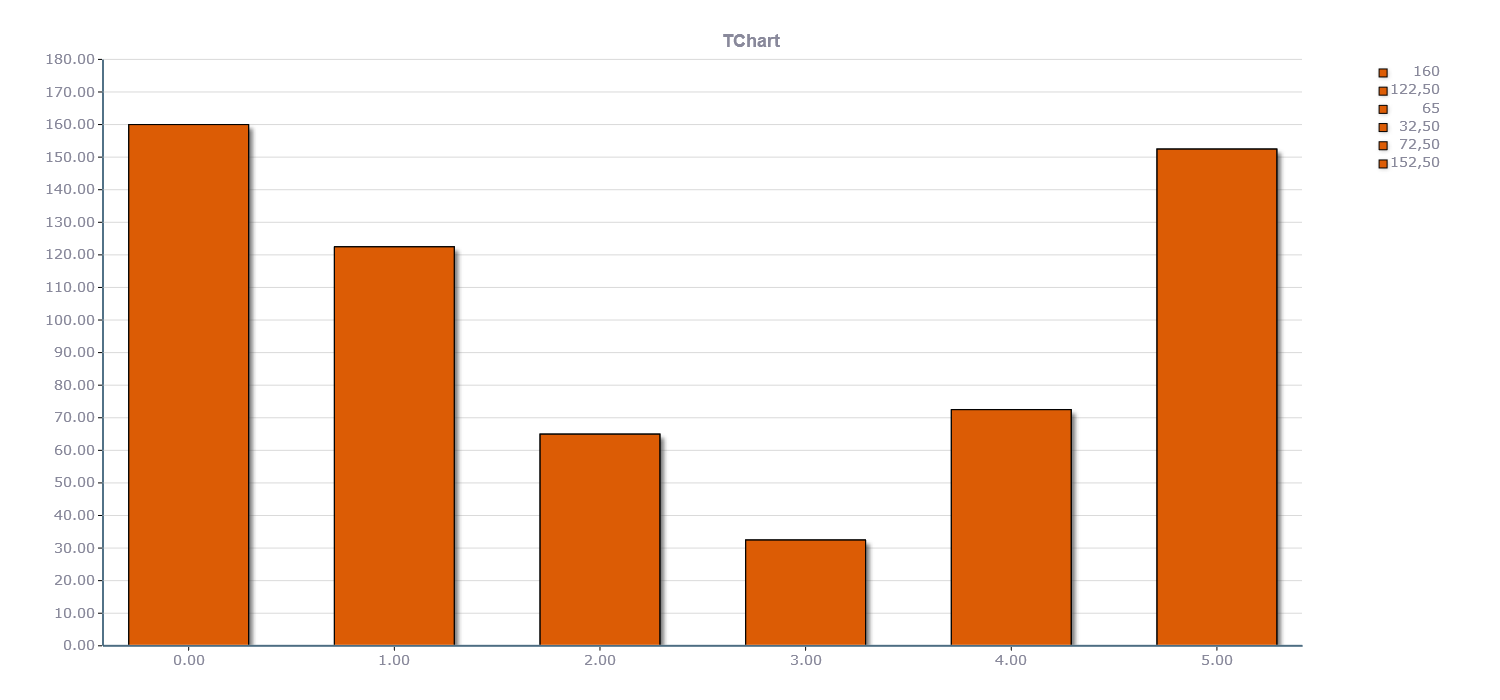

对于问题二,运用有限元模拟的方法,将普通跑鞋中加入碳板元素,并且探讨了不同跑鞋对马拉松运动员消耗能量以及比赛成绩的影响. 首先鉴于不同跑鞋的设计对马拉松运动员产生的影响,进行有限元模拟. 在第一问跑鞋设计的基础上,在鞋底嵌入一块全长、侧剖面形状和外底相同的碳板. 利用 ABAQUS 软件对外底、中底和两种碳纤维板进行了三维建模. 运用数学软件 SPSS 对不同的跑鞋与心率以及能量消耗量进行回归分析,并且通过了相关性检验. 从拟合的结果中可以看出,碳板跑鞋的设计目的是减少足部运动和冲击负荷的幅度或速率以降低受伤风险,减少能量消耗,进而可以提高运动成绩.

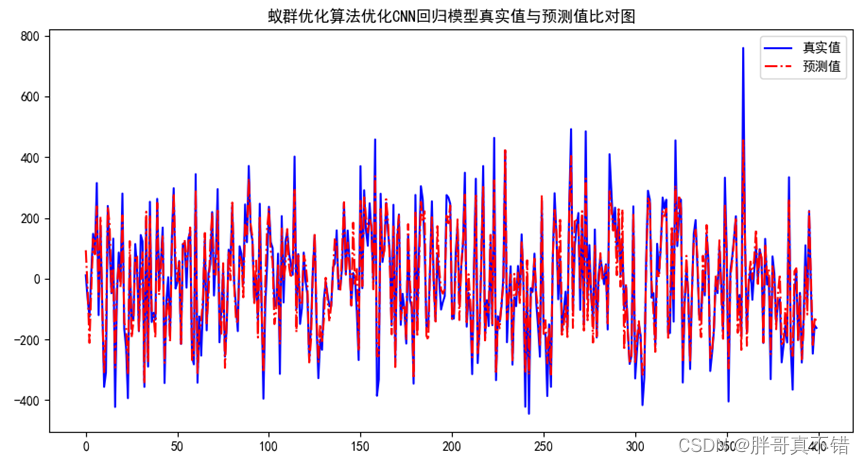

对于问题三,基于对能量经济和运动经济的分析,对碳板跑鞋进行优化设计,首先采用 PCA 和偏最小二乘对研究数据进行预处理,然后将它与神经网络相结合,以实现模型的建立和训练,为碳板跑鞋的图像提供了最佳的参考组合. 最终我们设计了适用于不同人群不同适用场合的七款不同性能的碳板跑鞋:铲形推进式直碳板超厚底竞速跑鞋、X 形厚底碳板竞速跑鞋、碳纤维 WAVE 波浪板竞速跑鞋、全(半)掌抗扭碳板训练鞋、Y 型复合碳板跑鞋、全掌异构碳板训练鞋、H 形碳板长距离慢跑鞋.

最后本文对模型的优缺点进行了评价,结合实际对模型的推广进行了分析.

问题分析:

经过多年的发展,碳板跑鞋已经成为当下市场上主流路跑竞速鞋的模样. 碳板跑鞋配合高弹性的缓冲层,可以在跑步过程中恰当地发挥碳板的回弹能力,提高能量的利用率,最终有助于提高长跑成绩. 研究表明,跑鞋的设计对牵引力和运动经济的性能有重要的影响,马拉松跑鞋的缓冲性能对于运动员身体能量的消耗乃至成绩的影响至关重要.

问题一分析:

本题主要研究跑鞋结构设计对马拉松运动员的影响,因此先设计跑鞋的结构数学模型,其中主要考虑跑鞋的中底材料与属性、纵向弯曲刚度、鞋后跟角度、鞋质量、跟稳定剂等对跑步相关性能和损伤的影响,设计出适合大多数马拉松运动员的跑鞋. 然后考虑到跑鞋及运动员的特性会影响马拉松比赛的运动时间,在跑鞋规定的厚度,中底结构材料,鞋跟的角度范围内,从运动员的年龄、性别以及马拉松的距离方面考虑并从损伤和效率方面评估跑鞋,得出相应的结论. 再利用 Logistic 回归模型,评估年龄、性别、马拉松距离、速度以及运动员损伤程度等对跑鞋的选择的影响程度.

问题二分析:

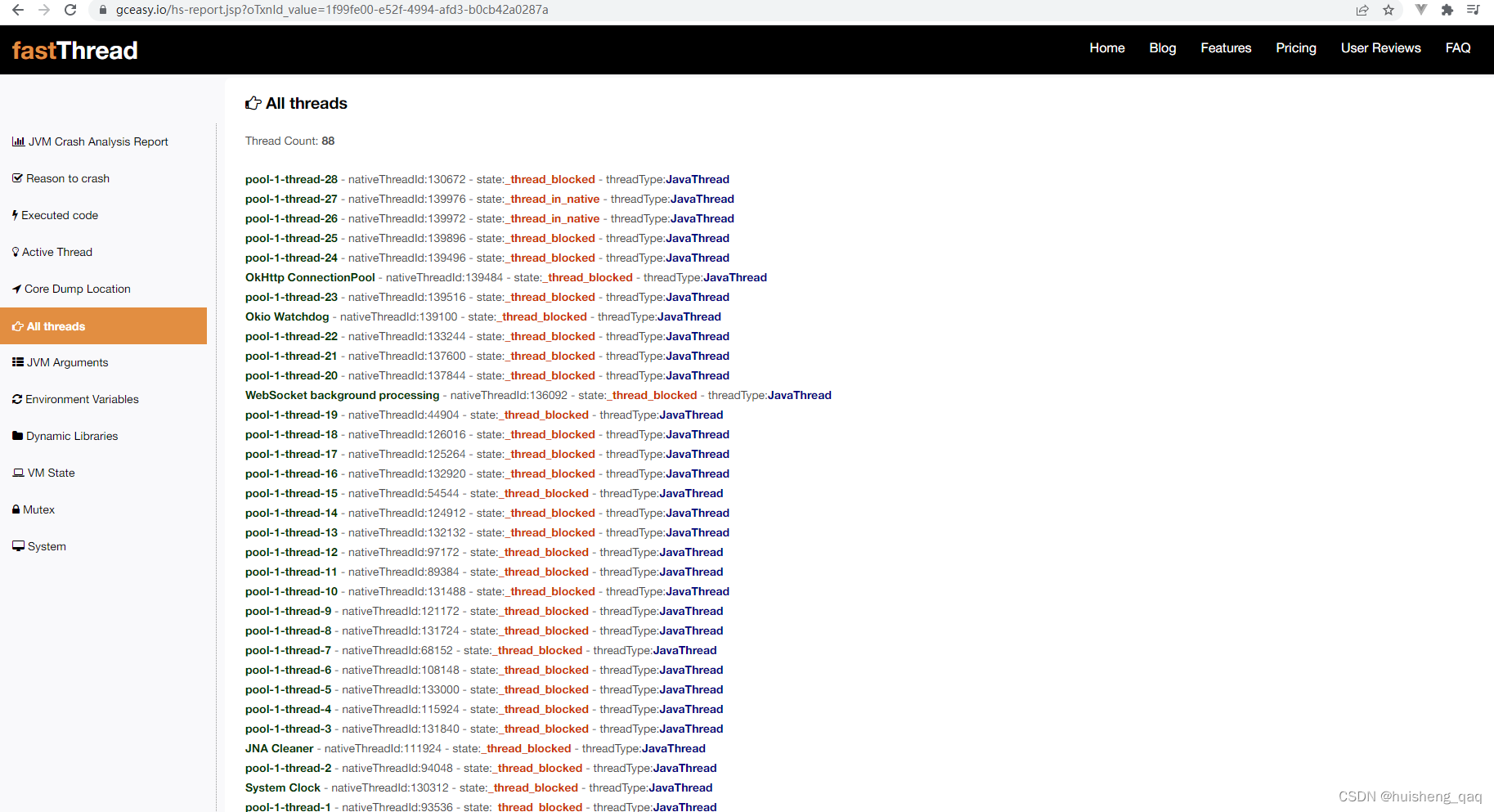

本题基于有限元模拟的方法,将普通跑鞋中加入碳板元素,并且探讨了不同跑鞋对马拉松运动员消耗能量以及比赛成绩的影响. 首先鉴于不同跑鞋的设计对马拉松运动员产生的影响,进行有限元模拟. 在第一问跑鞋设计的基础上,在鞋底嵌入一块全长、侧剖面形状和外底相同的碳板. 利用 ABAQUS 软件对外底、中底和两种碳纤维板进行了三维建模. 由 SPSS 进行处理统计的数据. 本研究将跑步速度、跑鞋和受试者的因子重复测量方差分析,进而来评价这些因素对生物力学变量的主效应和交互作用. 运用数学软件 SPSS 对不同的跑鞋与心率以及能量消耗量进行回归分析,并且通过了相关性检验. 从拟合的结果中可以看出,碳板跑鞋的设计目的是减少足部运动和冲击负荷的幅度或速率以降低受伤风险,减少能量消耗,进而可以提高运动成绩.

问题三分析:

本题基于对能量经济和运动经济的分析,对碳板跑鞋进行优化设计,首先采用 PCA和偏最小二乘对研究数据进行预处理,然后将它与神经网络相结合,以实现模型的建立和训练,为碳板跑鞋的图像提供了最佳的参考组合. 最终我们设计了适用于不同人群不同适用场合的七款不同性能的碳板跑鞋:铲形推进式直碳板超厚底竞速跑鞋、X 形厚底碳板竞速跑鞋、碳纤维 WAVE 波浪板竞速跑鞋、全(半)掌抗扭碳板训练鞋、Y 型复合碳板跑鞋、全掌异构碳板训练鞋、H 形碳板长距离慢跑鞋.

模型假设:

假设一:本模型涉及相应的统计分析时排除了非生物力学相关的研究.

假设二:由于表格中数据量大,部分数据偏差不影响模型的真实性,故不考虑建模过程中的误差.

假设三:假设不考虑计算机拟合和预测数据时产生的误差.

假设四:假设选取的指标具有典型性,能够全面反映跑鞋以及运动员影响模型的结果.

假设五:假设模型设计的碳板跑鞋具有很好的代表性

完整论文缩略图

全部论文请见下方“ 只会建模 QQ名片” 点击QQ名片即可

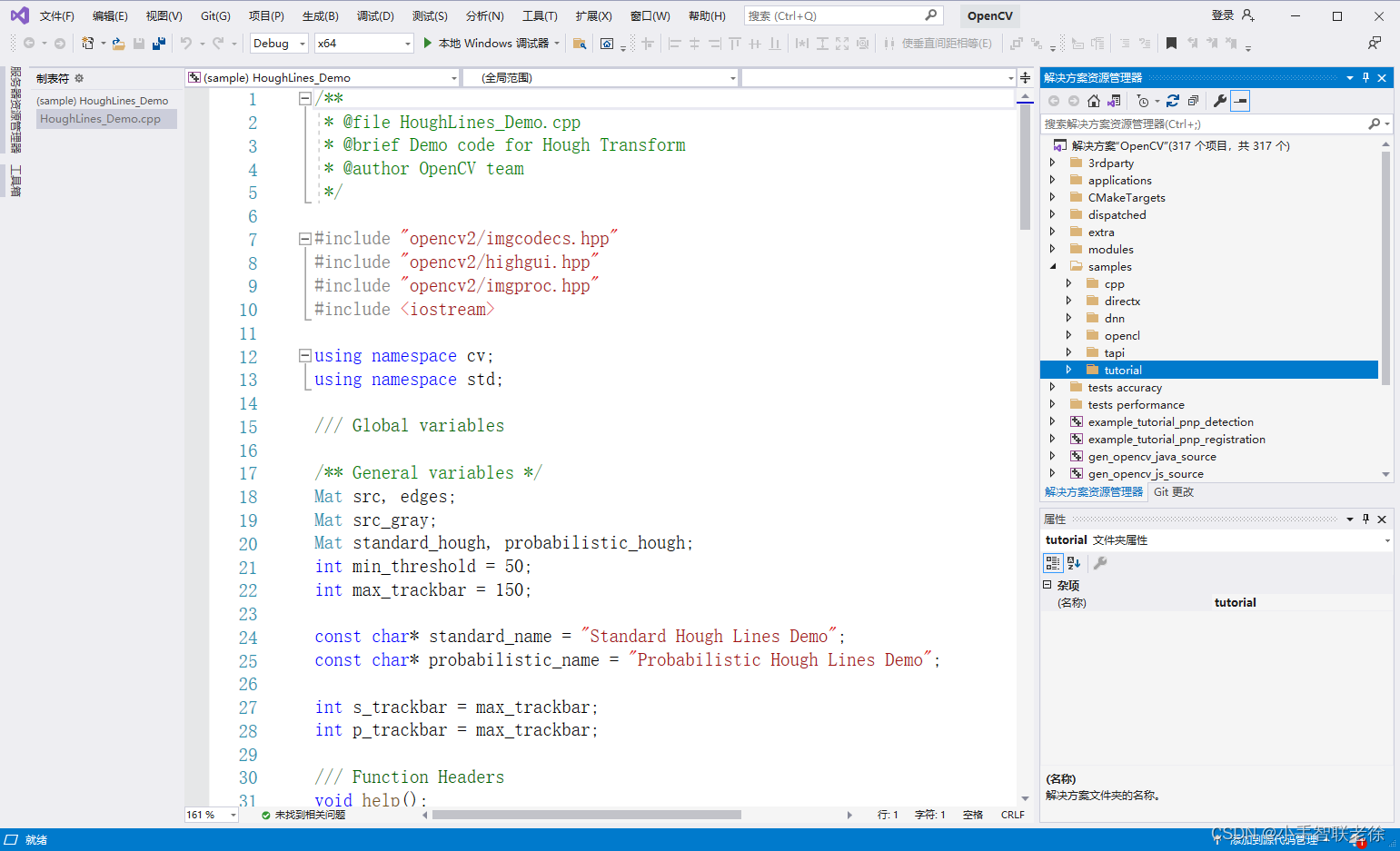

部分程序代码:(代码和文档not free)

import numpy as np

def sigmoid(x):

# Sigmoid 激活函数: f(x) = 1 / (1 + e^(-x))

return 1 / (1 + np.exp(-x))

def deriv_sigmoid(x):

# sigmoid 的倒数: f'(x) = f(x) * (1 - f(x))

fx = sigmoid(x)

return fx * (1 - fx)

def mse_loss(y_true, y_pred):

# MSE 损失函数

return ((y_true - y_pred) ** 2).mean()

class OurNeuralNetwork:

def __init__(self):

# 权值矩阵

self.w1 = np.random.normal()

self.w2 = np.random.normal()

self.w3 = np.random.normal()

self.w4 = np.random.normal()

self.w5 = np.random.normal()

self.w6 = np.random.normal()

# 偏置

self.b1 = np.random.normal()

self.b2 = np.random.normal()

self.b3 = np.random.normal()

def feedforward(self, x):

# sum_h1 = self.w1 * x[0] + self.w2 * x[1] + self.b1

# h1 = sigmoid(sum_h1)

#

# sum_h2 = self.w3 * x[0] + self.w4 * x[1] + self.b2

# h2 = sigmoid(sum_h2)

#

# sum_o1 = self.w5 * h1 + self.w6 * h2 + self.b3

# o1 = sigmoid(sum_o1)

# y_pred = o1

# return y_pre

h1 = sigmoid(self.w1 * x[0] + self.w2 * x[1] + self.b1)

h2 = sigmoid(self.w3 * x[0] + self.w4 * x[1] + self.b2)

o1 = sigmoid(self.w5 * h1 + self.w6 * h2 + self.b3)

return o1

# x 是输入数据,这里输入只有两个属性. def train(self, data, all_y_trues):

learn_rate = 0.1

epochs = 1000 # 迭代次数

for epoch in range(epochs):

for x, y_true in zip(data, all_y_trues):

# feed forward

sum_h1 = self.w1 * x[0] + self.w2 * x[1] + self.b1

h1 = sigmoid(sum_h1)

sum_h2 = self.w3 * x[0] + self.w4 * x[1] + self.b2

h2 = sigmoid(sum_h2)

sum_o1 = self.w5 * h1 + self.w6 * h2 + self.b3

o1 = sigmoid(sum_o1)

y_pred = o1

# 计算偏导数. # 对目标函数求导

d_L_d_ypred = -2*(y_true - y_pred)

# # Neuron o1

# d_ypred_d_w5 = h1 * deriv_sigmoid(self.w5 * h1 + self.w6 * h2 +

self.b3)

# d_ypred_d_w6 = h2 * deriv_sigmoid(self.w5 * h1 + self.w6 * h2 +

self.b3)

# d_ypred_d_b3 = deriv_sigmoid(self.w5 * h1 + self.w6 * h2 + self.b3)

#

# d_ypred_d_h1 = self.w5 * deriv_sigmoid(self.w5 * h1 + self.w6 * h2 +

self.b3)

# d_ypred_d_h2 = self.w6 * deriv_sigmoid(self.w5 * h1 + self.w6 * h2 +

self.b3)

#

# # Neuron h1

# d_h1_d_w1 = x[0]*deriv_sigmoid(self.w1*x[0] + self.w2*x[1] +

self.b1)

# d_h1_d_w2 = x[1]*deriv_sigmoid(self.w1*x[0] + self.w2*x[1] +

self.b1)

# d_h1_d_b1 = deriv_sigmoid(self.w1*x[0] + self.w2*x[1] + self.b1)

#

# # Neuron h2

# d_h2_d_w3 = x[0]*deriv_sigmoid(self.w3*x[0] + self.w4*x[1] +

self.b2)

# d_h2_d_w4 = x[1]*deriv_sigmoid(self.w3*x[0] + self.w4*x[1] +

self.b2)

# d_h2_d_b2 = deriv_sigmoid(self.w3*x[0] + self.w4*x[1] + self.b2)

# Neuron o1

d_ypred_d_w5 = h1 * deriv_sigmoid(sum_o1)

d_ypred_d_w6 = h2 * deriv_sigmoid(sum_o1)

d_ypred_d_b3 = deriv_sigmoid(sum_o1)

d_ypred_d_h1 = self.w5 * deriv_sigmoid(sum_o1)

d_ypred_d_h2 = self.w6 * deriv_sigmoid(sum_o1)

# Neuron h1

d_h1_d_w1 = x[0] * deriv_sigmoid(sum_h1)

d_h1_d_w2 = x[1] * deriv_sigmoid(sum_h1)

d_h1_d_b1 = deriv_sigmoid(sum_h1)

# Neuron h2

d_h2_d_w3 = x[0] * deriv_sigmoid(sum_h2)

d_h2_d_w4 = x[1] * deriv_sigmoid(sum_h2)

d_h2_d_b2 = deriv_sigmoid(sum_h2)

# 更新权值和偏置

# Neuron h1

self.w1 -= learn_rate*d_L_d_ypred*d_ypred_d_h1*d_h1_d_w1

self.w2 -= learn_rate*d_L_d_ypred*d_ypred_d_h1*d_h1_d_w2

self.b1 -= learn_rate*d_L_d_ypred*d_ypred_d_h1*d_h1_d_b1

# Neuron h2

self.w3 -= learn_rate*d_L_d_ypred*d_ypred_d_h2*d_h2_d_w3

self.w4 -= learn_rate*d_L_d_ypred*d_ypred_d_h2*d_h2_d_w4

self.b2 -= learn_rate*d_L_d_ypred*d_ypred_d_h2*d_h2_d_b2

# Neuron o1

self.w5 -= learn_rate*d_L_d_ypred*d_ypred_d_w5

self.w6 -= learn_rate*d_L_d_ypred*d_ypred_d_w6

self.b3 -= learn_rate*d_L_d_ypred*d_ypred_d_b3

# 计算误差

if epoch % 10 == 0:

y_preds = np.apply_along_axis(self.feedforward, 1, data)

loss = mse_loss(all_y_trues, y_preds)

print("Epoch %d loss: %.3f" % (epoch, loss))

# 数据集定义

data = np.array([

[-2, -1], # Alice

[25, 6], # Bob

[17, 4], # Charlie

[-15, -6], # Diana

])

all_y_trues = np.array([

1, # Alice

0, # Bob

0, # Charlie

1, # Diana

])

# 模型训练

network = OurNeuralNetwork()

network.train(data, all_y_trues)