hadoop和spark配置问题记录

Spark的WebUI访问不了

直接启动的start-all.sh是环境变量中配置的hadoop的脚本,不是spark的,因此启动spark的start-all.sh脚本即可。

Spark看不到Worker信息

启动Spark在UI界面上看不到worker节点的信息_潇洒哥WH3的博客-CSDN博客

此问题和下一问题:“Hadoop的Live Nodes显示为0” 是同一问题。

根本原因同“Hadoop的Live Nodes显示为0”,临时解决方法是:修改hadoop的start-env.sh,将其中的MASTER_IP改为MASTER_HOST,并将Master名改为Master的IP。

Hadoop的Live Nodes显示为0

Hadoop集群活跃节点为0解决方案_Ichimaru_Gin_的博客-CSDN博客

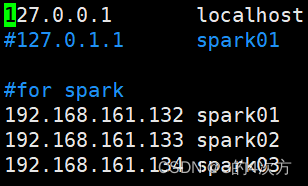

原因是/etc/hosts中配置的IP发生了覆盖,只需要去掉127.0.0.1的masterIP就行,同时保留master和slave的真实IP

IDEA配置Scala+Maven项目相关

-

一些配置:使用IntelliJ IDEA开发Spark应用程序_厦大数据库实验室博客 (xmu.edu.cn),其他教程在CSDN的收藏

-

打包jar:在idea中将java项目中的单个类打包成jar包操作_java_脚本之家 (jb51.net)