文章目录

- 一、概述

- 二、集群概况

- 三、升级集群

- 2.1 确定升级版本

- 2.2 升级Master

- 2.3 升级 Worker

- 四、验证集群

一、概述

搭建k8s集群的方式有很多种,比如二进制,kubeadm,RKE(Rancher)等,k8s集群升级方式也各有千秋,本文主要介绍使用kubeadm方式搭建的k8s集群升级方法。

需要注意的是,升级集群版本建议逐步升级,比如 v1.20.4–>v1.21.4–>v1.22.4–>v1.23.4–>v1.24.4,不能跨度过大,否则会报错。

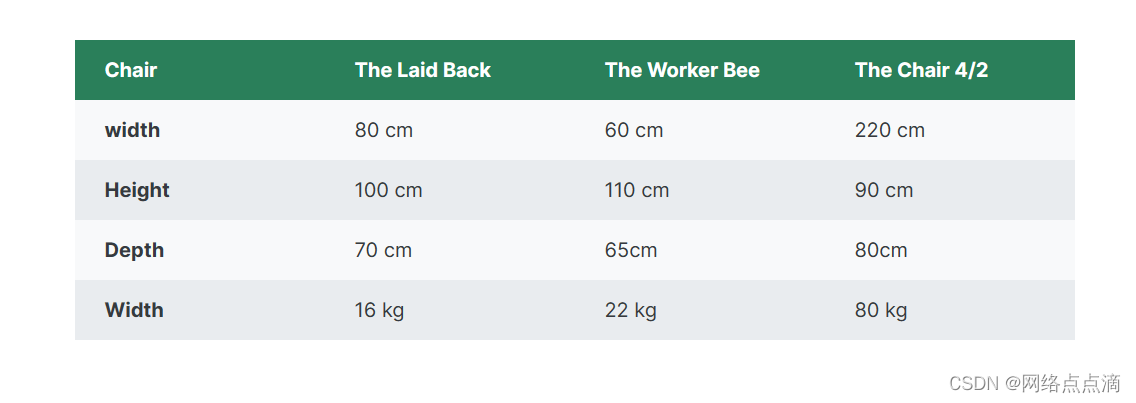

二、集群概况

| 节点名称 | IP | 版本 | 目标版本 |

|---|---|---|---|

| k8s-master1 | 192.168.2.245 | v1.19.12 | v1.20.15 |

| k8s-master2 | 192.168.2.246 | v1.19.12 | v1.20.15 |

| k8s-master3 | 192.168.2.247 | v1.19.12 | v1.20.15 |

| k8s-master4 | 192.168.2.247 | v1.19.12 | v1.20.15 |

三、升级集群

2.1 确定升级版本

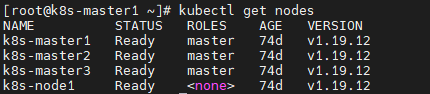

kubectl get nodes # 查看集群版本

可以看到目前的版本是v1.19.12。

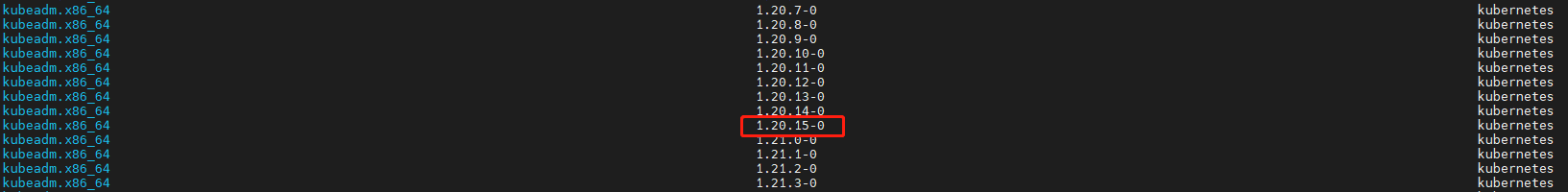

# 执行如下命令确定升级版本

yum list --showduplicates kubeadm --disableexcludes=kubernetes

我的目标版本是1.20.15-0。

我的目标版本是1.20.15-0。

2.2 升级Master

1. 升级 kubeadm

所有 master 节点操作

# 升级kubeadm

yum install -y kubeadm-1.20.15-0 --disableexcludes=kubernetes # --disableexcludes=kubernetes:禁掉除了这个kubernetes之外的别的仓库

# 升级完成后验证版本

kubeadm version

2. 升级 master1 节点

master1节点操作即可

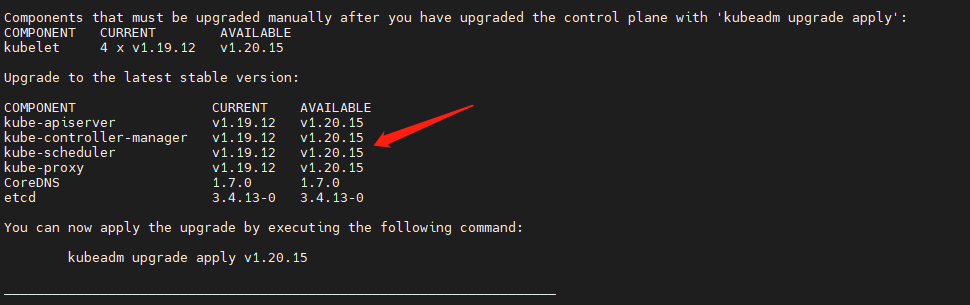

# 验证升级计划。检查当前集群是否可被升级

kubeadm upgrade plan

最高可以升级到 v1.20.15 版本,正好与我们的目标版本一致;只要可允许升级的最高版本高于你的目标版本,就可以升级。

注意:

kubeadm upgrade命令也会自动对kubeadm在节点上所管理的证书执行续约操作。如果需要略过证书续约操作,可以使用

标志--certificate-renewal=false。

确定集群升级目标版本,并且查看升级计划符合条件后,就可以在 master1 节点上执行升级集群的命令了。

# 将 master1 升级到目标版本

kubeadm upgrade apply v1.20.15

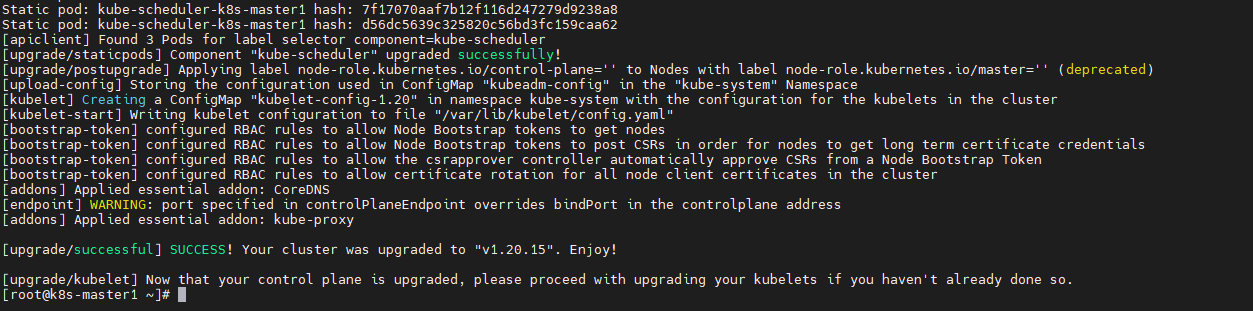

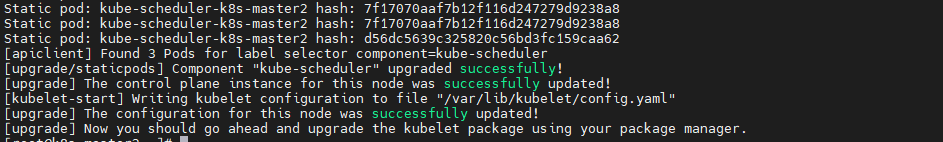

3. 升级 master2&master3 节点

master2 & master3节点操作

升级master2 & master3 节点与 master1 节点相同,但是使用下面的命令,而不是kubeadm upgrade apply命令。

kubeadm upgrade node

4. 升级kubectl和kubelet

三台 master 节点操作,操作顺序:master1——>master2——>master3

分别在三台master节点上执行如下操作,注意更改<节点名称>。

# 1.将当前节点标记为不可调度,并驱逐节点上的Pod

kubectl drain <节点名称> --ignore-daemonsets

##说明:

## --ignore-daemonsets 无视DaemonSet管理下的Pod。即--ignore-daemonsets往往需要指定的,这是

#因为deamonset会忽略unschedulable标签(使用kubectl drain时会自动给节点打上不可调度标签),

#由于deamonset控制器控制的pod被删除后可能马上又在此节点上启动起来,这样就会成为死循环。因此

#这里忽略daemonset。

# 2.升级kubelet和kubectl组件

yum install -y kubelet-1.20.15-0 kubectl-1.20.15-0 --disableexcludes=kubernetes

## 说明: --disableexcludes=kubernetes:禁掉除了这个kubernetes之外的别的仓库

# 3.重启kubelet

systemctl daemon-reload

systemctl restart kubelet

# 4.恢复当前节点上的Pod调度,使其上线

kubectl uncordon <节点名称>

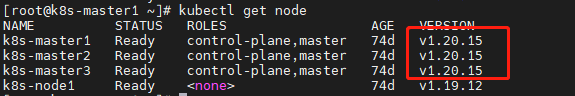

此时查看节点版本,发现三台master节点已经升级完毕。

接下来我们升级worker节点。

2.3 升级 Worker

工作节点上的升级过程应该一次执行一个节点,或者一次执行几个节点,以不影响运行工作负载所需的最小容量。

由于我的集群中只有一个worker节点,所以这里只在一台机器上操作;如果你的集群中有多个worker节点,每个节点都需要操作。

# 升级kubeadm

yum install -y kubeadm-1.20.15-0 --disableexcludes=kubernetes

# 查看版本

kubeadm version

# 升级 node 节点

kubeadm upgrade node

# 设置节点不可调度并排空节点。只有1个worker节点时忽略此步,因为可能会报错

kubectl drain k8s-node1 --ignore-daemonsets

# 升级kubelet和kubectl组件

yum install -y kubelet-1.20.15-0 kubectl-1.20.15-0 --disableexcludes=kubernetes

# 重启kubelet

systemctl daemon-reload

systemctl restart kubelet

# 恢复当前节点上的Pod调度。只有1个worker节点时忽略此步

kubectl uncordon k8s-node1 # k8s-node1 为worker节点名称

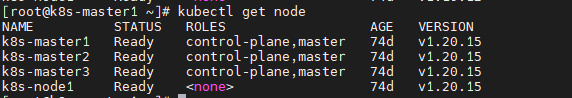

四、验证集群

1. 验证集群状态是否正常

kubectl get nodes

# 结果如下:

[root@k8s-master1 ~]# kubectl get node

NAME STATUS ROLES AGE VERSION

k8s-master1 Ready control-plane,master 74d v1.20.15

k8s-master2 Ready control-plane,master 74d v1.20.15

k8s-master3 Ready control-plane,master 74d v1.20.15

k8s-node1 Ready <none> 74d v1.20.15

版本均已升级到 v1.20.15。

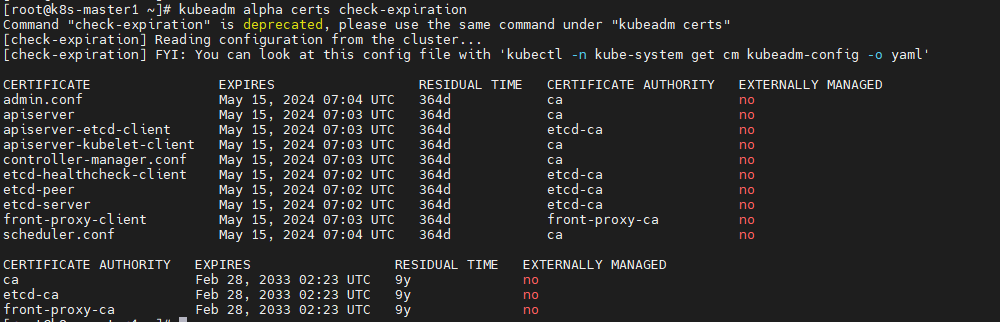

2. 验证集群证书是否正常

kubeadm alpha certs check-expiration

## 结果如下:

[root@k8s-master1 ~]# kubeadm alpha certs check-expiration

Command "check-expiration" is deprecated, please use the same command under "kubeadm certs"

[check-expiration] Reading configuration from the cluster...

[check-expiration] FYI: You can look at this config file with 'kubectl -n kube-system get cm kubeadm-config -o yaml'

CERTIFICATE EXPIRES RESIDUAL TIME CERTIFICATE AUTHORITY EXTERNALLY MANAGED

admin.conf May 15, 2024 07:04 UTC 364d ca no

apiserver May 15, 2024 07:03 UTC 364d ca no

apiserver-etcd-client May 15, 2024 07:03 UTC 364d etcd-ca no

apiserver-kubelet-client May 15, 2024 07:03 UTC 364d ca no

controller-manager.conf May 15, 2024 07:03 UTC 364d ca no

etcd-healthcheck-client May 15, 2024 07:02 UTC 364d etcd-ca no

etcd-peer May 15, 2024 07:02 UTC 364d etcd-ca no

etcd-server May 15, 2024 07:02 UTC 364d etcd-ca no

front-proxy-client May 15, 2024 07:03 UTC 364d front-proxy-ca no

scheduler.conf May 15, 2024 07:04 UTC 364d ca no

CERTIFICATE AUTHORITY EXPIRES RESIDUAL TIME EXTERNALLY MANAGED

ca Feb 28, 2033 02:23 UTC 9y no

etcd-ca Feb 28, 2033 02:23 UTC 9y no

front-proxy-ca Feb 28, 2033 02:23 UTC 9y no

参考文章:

https://cloud.tencent.com/developer/article/1771832

https://blog.csdn.net/Sebastien23/article/details/129479140

kubenetes 调度:https://blog.csdn.net/m0_47293933/article/details/126027843

k8s官网:https://kubernetes.io/zh-cn/docs/tasks/administer-cluster/kubeadm/kubeadm-upgrade/