上进小菜猪,沈工大软件工程专业,爱好敲代码,持续输出干货。

本文将深入探讨Apache Spark作为一种强大的大数据处理框架的基本概念、特点和应用。我们将详细介绍Spark的核心组件,包括Spark Core、Spark SQL、Spark Streaming和Spark MLlib,并通过实例演示其在大数据处理和分析中的应用。同时,我们还将讨论Spark的分布式计算模型和性能优化策略,以及Spark在实际应用中的最佳实践。

一、Apache Spark简介

随着大数据时代的到来,处理大规模数据的需求越来越迫切。Apache Spark作为一个快速、可扩展的大数据处理框架,获得了广泛的应用。相比于传统的MapReduce模型,Spark采用了内存计算和基于弹性分布式数据集(Resilient Distributed Datasets,简称RDD)的抽象模型,从而实现了更快的数据处理速度和更高的可扩展性。

Apache Spark是由加州大学伯克利分校AMPLab开发的开源分布式计算框架。Spark的设计目标是解决大数据处理中的瓶颈和性能问题。相比于传统的MapReduce模型,Spark采用了内存计算和基于弹性分布式数据集(Resilient Distributed Datasets,简称RDD)的抽象模型,从而实现了更快的数据处理速度和更高的可扩展性。

二、Spark的核心组件

- Spark Core:Spark的核心组件提供了RDD的定义和操作接口。RDD是Spark的核心数据抽象,它是一个可容错、可并行计算的分布式数据集。Spark Core还负责任务调度、内存管理和与存储系统的交互。

- Spark SQL:Spark SQL提供了结构化数据处理的功能,使得可以使用SQL语言或DataFrame API对数据进行查询、转换和分析。它支持从各种数据源(如Hive、HBase、JSON、Parquet等)读取数据,并提供了SQL查询优化和代码生成等功能。

- Spark Streaming:Spark Streaming允许实时流数据的处理和分析。它可以将实时数据流划分为一系列小批次,然后使用Spark的批处理引擎对其进行处理。这样,Spark可以实现对实时数据的高效分析和处理。

- Spark MLlib:Spark MLlib是Spark的机器学习库,提供了一系列机器学习算法和工具。它支持常见的机器学习任务,如分类、回归、聚类和推荐等。MLlib还提供了特征提取、模型评估和模型持久化等功能。

三、使用Spark进行分布式计算

- 数据准备与导入:首先,需要将数据加载到Spark中。Spark支持从多种数据源加载数据,例如HDFS、本地文件系统、数据库等。可以使用Spark的API来读取和解析数据,创建RDD或DataFrame对象。

- 数据转换与处理:一旦数据加载到Spark中,可以使用Spark提供的丰富操作符和函数对数据进行转换和处理。例如,可以进行过滤、映射、聚合等操作,以满足具体的分析需求。这些操作可以串联起来形成数据处理的流水线。

// 创建SparkSession对象

import org.apache.spark.sql.SparkSession

val spark = SparkSession.builder()

.appName("DataProcessingExample")

.getOrCreate()

// 读取CSV文件并创建DataFrame对象

val df = spark.read.format("csv")

.option("header", "true")

.load("data.csv")

// 过滤数据

val filteredData = df.filter(df("age") > 25)

// 对数据进行聚合

val aggregatedData = filteredData.groupBy("city")

.agg(count("name").alias("count"))

// 打印结果

aggregatedData.show()

以上代码展示了如何使用Spark读取CSV文件并进行数据处理。首先,创建SparkSession对象用于与Spark交互。然后,使用read方法加载CSV文件并创建DataFrame对象。接下来,通过调用filter方法过滤出年龄大于25的数据,并使用groupBy和agg方法对城市进行分组和聚合。最后,使用show方法打印结果。

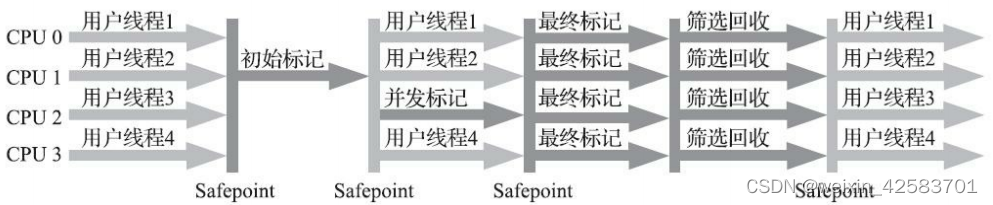

分布式计算与优化:Spark利用分布式计算的能力,将任务分割成多个小任务并在集群中并行执行。它通过内存计算和RDD的持久化等技术来提高计算性能。此外,Spark还提供了一些优化技术,如数据分区、数据倾斜处理和并行度设置等,以进一步提升计算效率。

总结

Spark作为一个开源的大数据处理框架将继续发挥重要作用,为数据科学家和工程师提供强大的工具和技术支持,帮助他们处理和分析大规模数据。

需要注意的是,由于代码示例和详细讲解的篇幅有限,本文只能涵盖部分内容。读者可以进一步深入学习和探索Spark的其他组件和功能,如GraphX用于图处理、SparkR用于R语言集成等。同时,也可以参考Spark的官方文档和开源社区资源,以获取更多关于Spark的技术细节和最佳实践。

希望本文能够帮助读者对Apache Spark有一个更全面的了解,并为他们在大数据处理领域提供指导和启示。通过合理的使用和优化,Spark将成为处理大数据的得力助手,帮助企业和组织从海量数据中获得更有价值的洞察和决策依据。