以下内容来自从零开始机器人SLAM知识星球 每日更新内容

点击领取学习资料 → 机器人SLAM学习资料大礼包

#论文##开源代码# Understanding Bird’s-Eye View of Road Semantics using an Onboard Camera

论文地址:https://arxiv.org/abs/2012.03040

作者单位:苏黎世ETH计算机视觉实验室

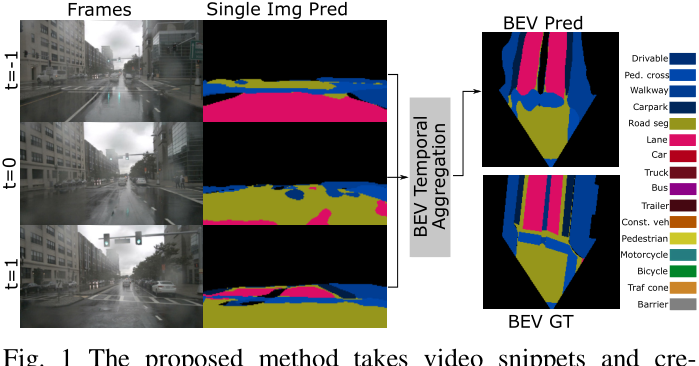

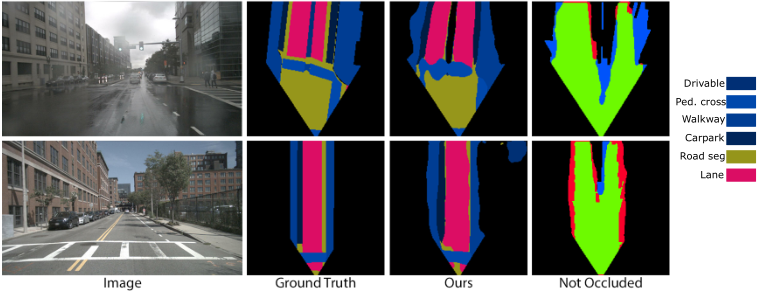

开源代码:https://github.com/ybarancan/BEV_feat_stitch

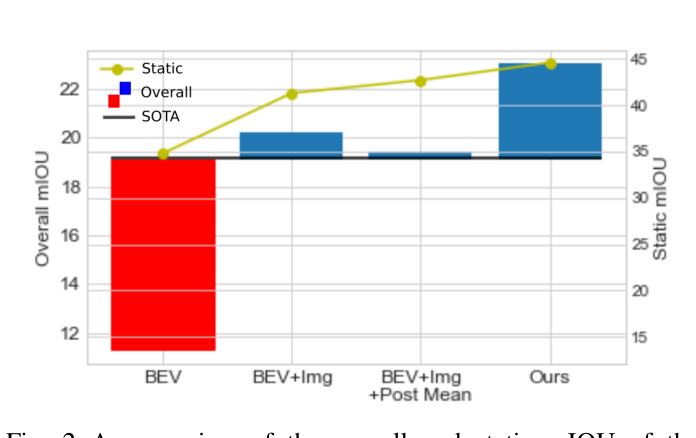

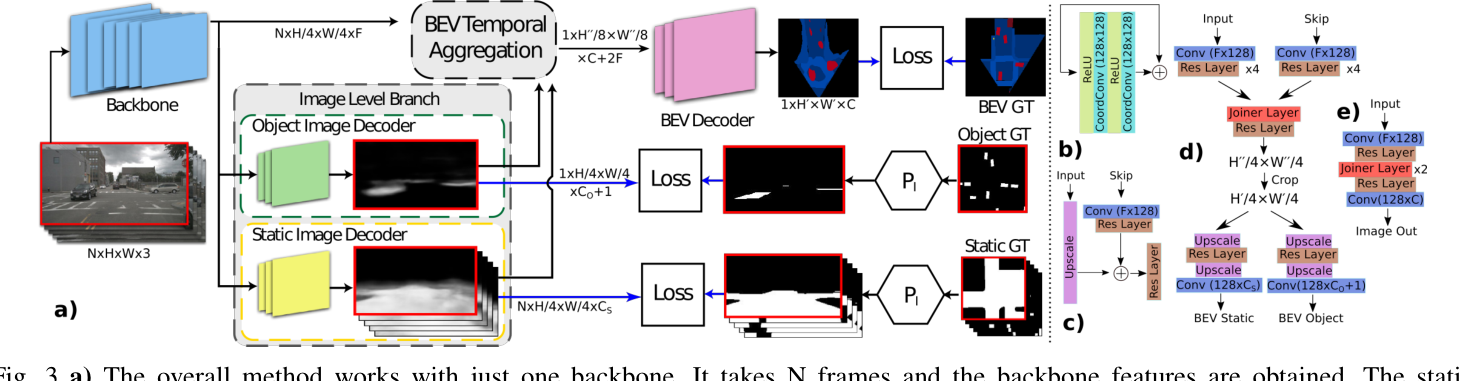

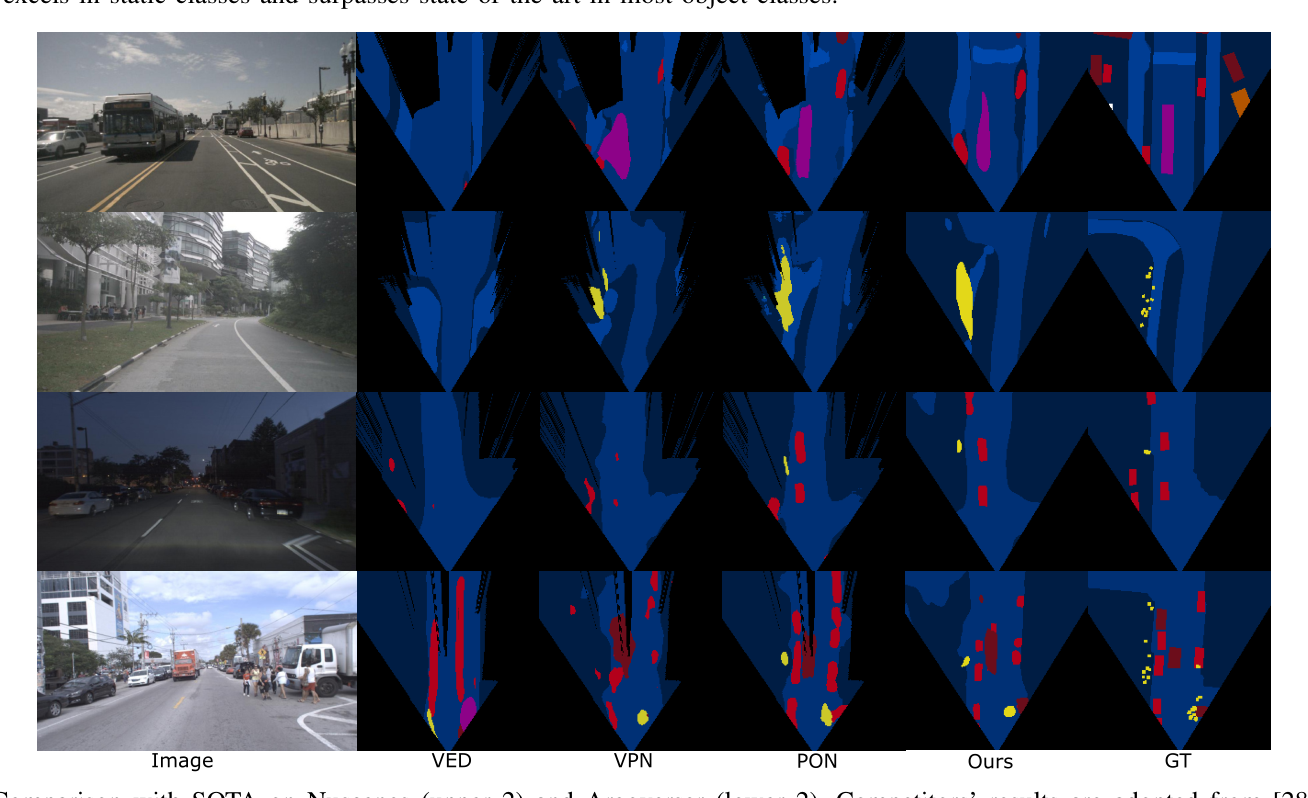

自主导航需要对空间的场景理解,以移动或预测事件。对于自动驾驶车辆,这可以转化为鸟瞰视图(BEV)中的场景理解。然而,自动驾驶汽车的车载摄像头通常是水平安装的,以更好地查看周围环境。在这项工作中,我们使用单个车载摄像头输入的视频,通过在线估计语义Bev地图的形式来研究场景理解。我们研究了这项任务的三个关键方面:图像级理解、BEV级理解和时间信息的聚合。在这基础上,我们提出了一种结合了这三个方面的新型体系结构。在我们广泛的实验中,我们证明了所考虑的方面对于BEV的理解是相辅相成的。此外,本文的架构大大超过了目前最先进的架构。

本文贡献如下:

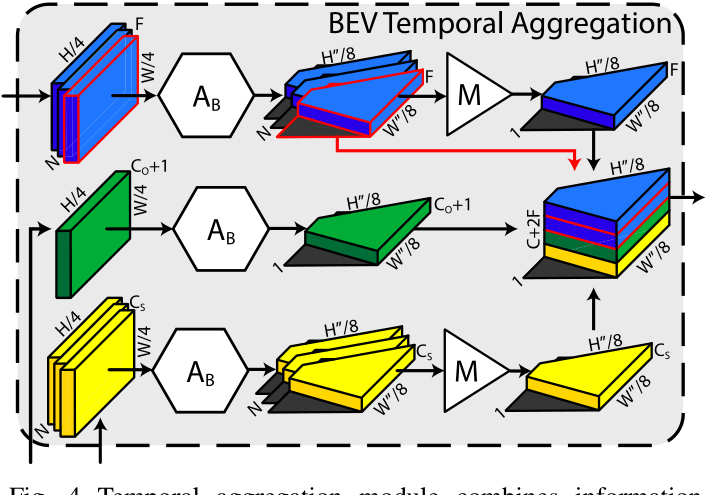

1、我们提出了一种新的基于单目视频的BEV道路语义深度神经体系结构,用于静态hd地图部分和动态对象理解。

2、我们研究了独立和联合学习在图像和/或BEV平面上的影响,以及时间信息。

3、该方法得到的结果明显优于现有的方法。

以下内容来自从零开始机器人SLAM知识星球 每日更新内容

点击领取学习资料 → 机器人SLAM学习资料大礼包

![[附源码]计算机毕业设计ssm新能源电动汽车充电桩服务APPSpringboot程序](https://img-blog.csdnimg.cn/b5c8c2605fca462d905d8bc504f55bfc.png)