YOLOv5:添加SE、CBAM、CoordAtt、ECA注意力机制

- 前言

- 前提条件

- 相关介绍

- 注意力机制

- SE

- 添加SE注意力机制到YOLOv5

- CBAM

- 添加CBAM注意力机制到YOLOv5

- CoordAtt

- 添加CoordAtt注意力机制到YOLOv5

- ECA

- 添加ECA注意力机制到YOLOv5

- 参考

前言

- 记录在YOLOv5添加注意力机制,方便自己查阅。

- 由于本人水平有限,难免出现错漏,敬请批评改正。

- 更多精彩内容,可点击进入YOLO系列专栏或我的个人主页查看

- YOLOv5:IoU、GIoU、DIoU、CIoU、EIoU

https://blog.csdn.net/FriendshipTang/article/details/129969044- YOLOv7训练自己的数据集(口罩检测)

https://blog.csdn.net/FriendshipTang/article/details/126513426- YOLOv8训练自己的数据集(足球检测)

https://blog.csdn.net/FriendshipTang/article/details/129035180

前提条件

- 熟悉Python

相关介绍

- Python是一种跨平台的计算机程序设计语言。是一个高层次的结合了解释性、编译性、互动性和面向对象的脚本语言。最初被设计用于编写自动化脚本(shell),随着版本的不断更新和语言新功能的添加,越多被用于独立的、大型项目的开发。

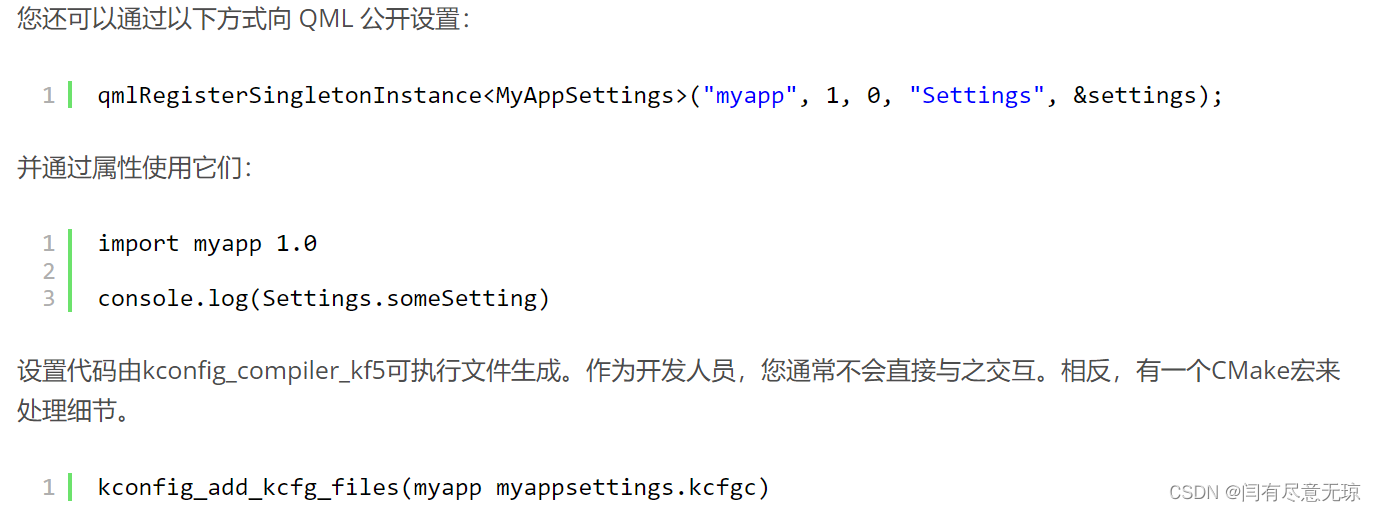

- PyTorch 是一个深度学习框架,封装好了很多网络和深度学习相关的工具方便我们调用,而不用我们一个个去单独写了。它分为 CPU 和 GPU 版本,其他框架还有 TensorFlow、Caffe 等。PyTorch 是由 Facebook 人工智能研究院(FAIR)基于 Torch 推出的,它是一个基于 Python 的可续计算包,提供两个高级功能:1、具有强大的 GPU 加速的张量计算(如 NumPy);2、构建深度神经网络时的自动微分机制。

- YOLOv5是一种单阶段目标检测算法,该算法在YOLOv4的基础上添加了一些新的改进思路,使其速度与精度都得到了极大的性能提升。它是一个在COCO数据集上预训练的物体检测架构和模型系列,代表了Ultralytics对未来视觉AI方法的开源研究,其中包含了经过数千小时的研究和开发而形成的经验教训和最佳实践。

- 注意力机制是一种通过网络自主学习出的一组权重系数,并以“动态加权”的方式来强调我们所感兴趣的区域同时抑制不相关背景区域的机制。在计算机视觉领域中,注意力机制可以大致分为两大类:强注意力和软注意力。强注意力是指在给定的输入下,只有一个区域被强调,其他区域被抑制。而软注意力则是对所有区域进行加权,每个区域都有一个权重,但权重不是0或1,而是一个介于0和1之间的实数。

注意力机制

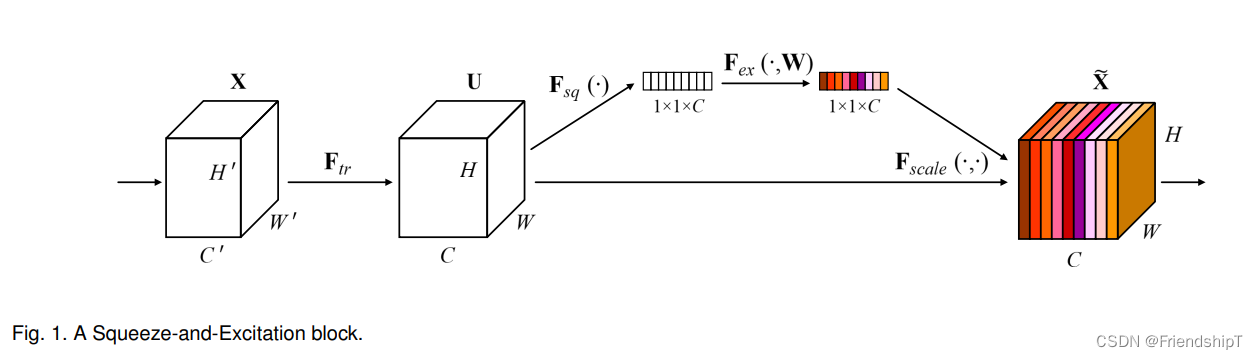

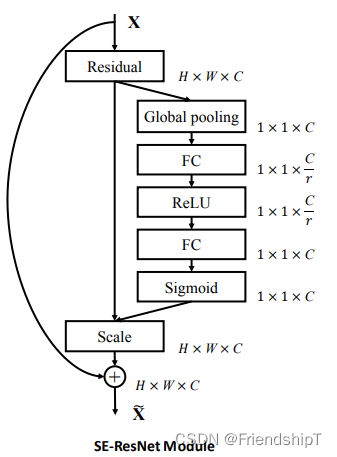

SE

- SE注意力机制是一种通道注意力机制,它是在SENet中提出的。SE模块是在channel维度上做attention或者gating操作,这种注意力机制让模型可以更加关注信息量最大的channel特征,而抑制那些不重要的channel特征。

- SE注意力机制的优点是可以让模型可以更加关注信息量最大的channel特征,而抑制那些不重要的channel特征,从而提升准确率。同时,SE注意力机制的计算量较小,可以在不增加太多计算量的情况下提升模型的性能。

- SE注意力机制的缺点是在一些特定场景下可能会出现过拟合的情况。

- 论文地址:https://arxiv.org/abs/1709.01507

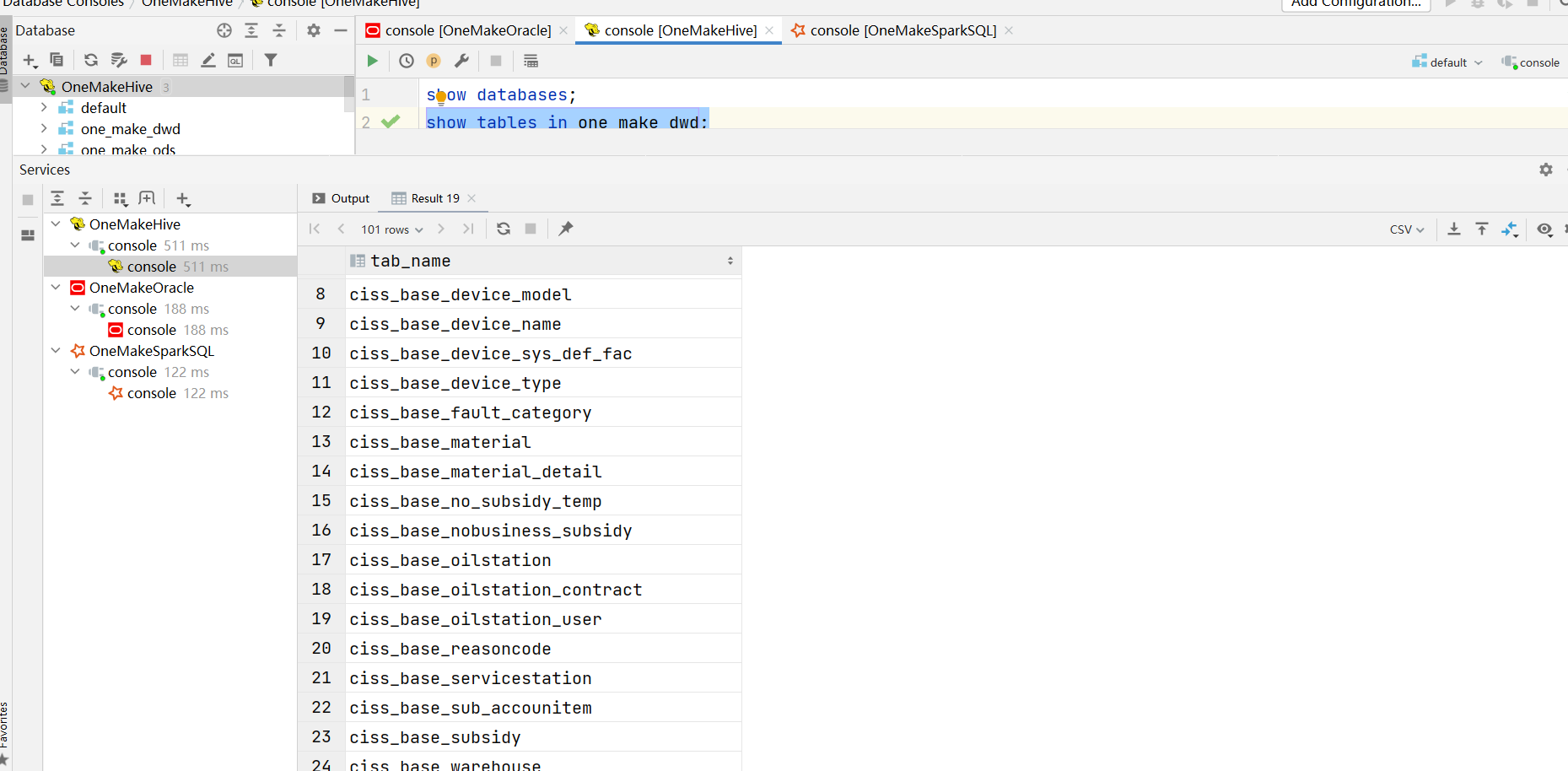

添加SE注意力机制到YOLOv5

- 免费获取完整代码:

https://download.csdn.net/download/FriendshipTang/87733773

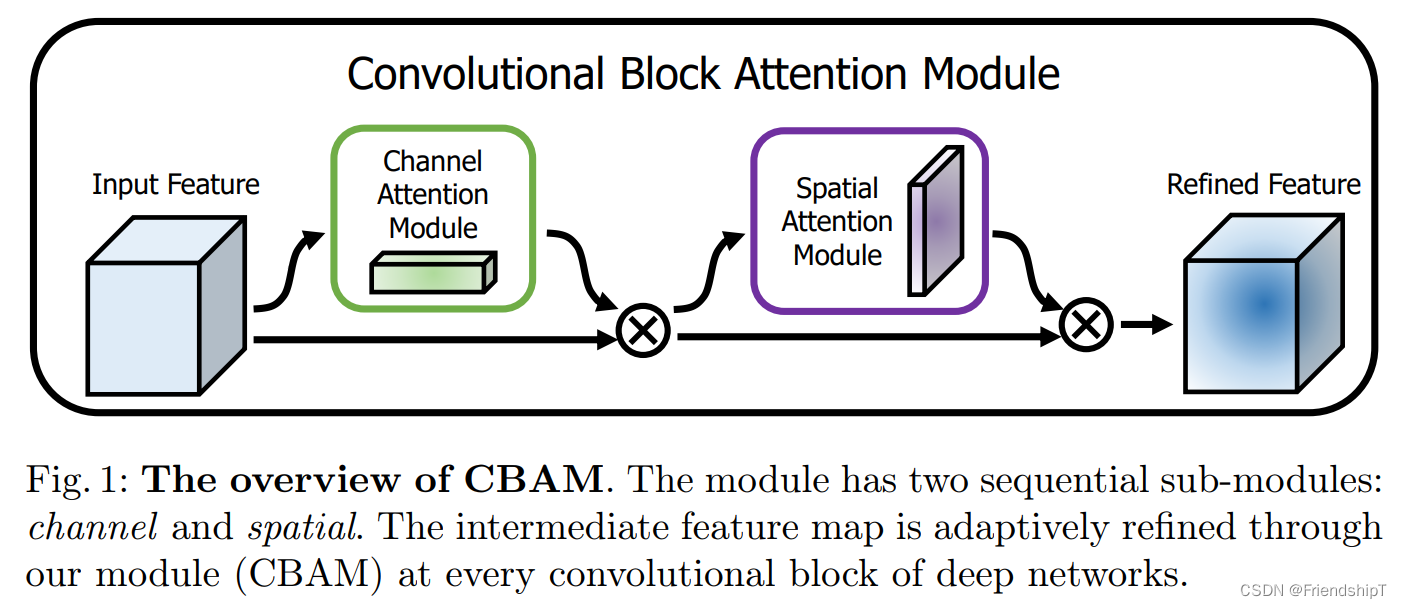

CBAM

- CBAM(Convolutional Block Attention Module)是一种结合了空间和通道的注意力机制模块,可以让模型更加关注信息量最大的channel特征,同时抑制那些不重要的channel特征,从而提升准确率。CBAM模块包含两个子模块:通道注意力模块和空间注意力模块。通道注意力模块用于对每个channel进行加权,而空间注意力模块则用于对每个空间位置进行加权。相比于SE注意力机制,CBAM可以在空间和通道两个维度上进行Attention,因此可以取得更好的效果。

- CBAM注意力机制的优点是可以在空间和通道两个维度上进行Attention,因此可以取得更好的效果。CBAM模块包含两个子模块:通道注意力模块和空间注意力模块。通道注意力模块用于对每个channel进行加权,而空间注意力模块则用于对每个空间位置进行加权。相比于SE注意力机制,CBAM可以在空间和通道两个维度上进行Attention,因此可以取得更好的效果。

- CBAM注意力机制的缺点是由于其需要计算通道和空间两个维度上的Attention,因此计算量较大,会增加模型的复杂度和训练时间。

- 论文地址:https://arxiv.org/abs/1807.06521

添加CBAM注意力机制到YOLOv5

- 免费获取完整代码:

https://download.csdn.net/download/FriendshipTang/87733822

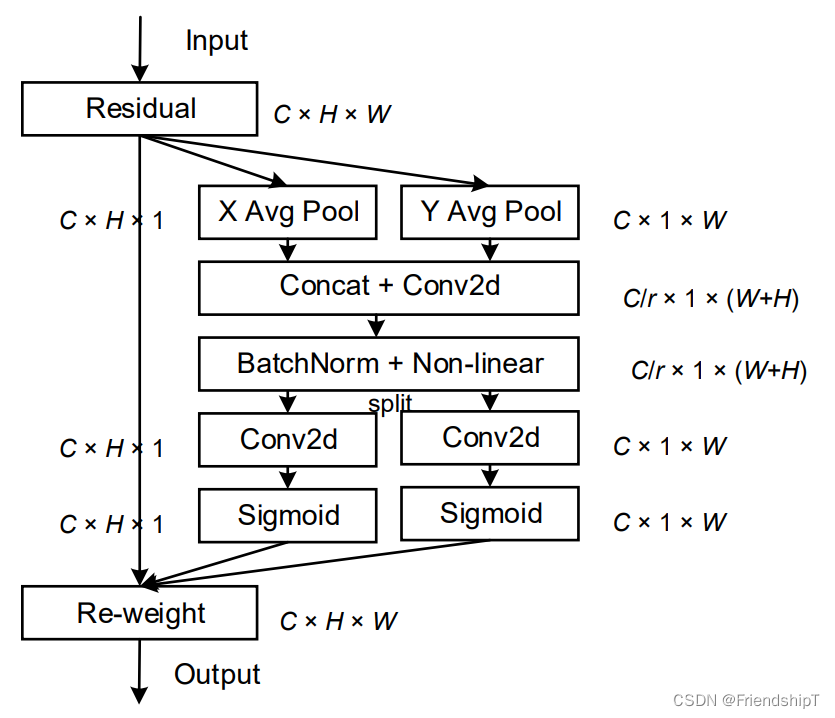

CoordAtt

- CoordAtt注意力机制是一种新的注意力机制,它是在通道注意力机制的基础上,将位置信息嵌入到通道注意力中提出的1。与通过2维全局池化将特征张量转换为单个特征向量的通道注意力不同,Coordinate Attention将通道注意力分解为两个1维特征编码过程,其中一个编码位置信息,另一个编码通道信息。

- Coordinate Attention的优点是它捕获了不仅跨通道的信息,还包含了direction-aware和position-sensitive的信息,这使得模型更准确地定位到并识别目标区域。

- 论文地址:https://arxiv.org/abs/2103.02907

添加CoordAtt注意力机制到YOLOv5

- 免费获取完整代码:

https://download.csdn.net/download/FriendshipTang/87733827

ECA

- ECA注意力模块是一种通道注意力模块,常常被应用于视觉模型中。它能对输入特征图进行通道特征加强,而且最终ECA模块输出,不改变输入特征图的大小。

- ECA注意力模块的优点是它能够提取通道间的依赖关系,提高CNN性能。

- 论文地址:https://arxiv.org/abs/1910.03151

添加ECA注意力机制到YOLOv5

- 免费获取完整代码:

https://download.csdn.net/download/FriendshipTang/87733835

参考

GitHub - ultralytics/yolov5: YOLOv5 🚀 in PyTorch > ONNX > CoreML > TFLite

【注意力机制】通道上的注意力:SENet论文笔记 - 知乎 (zhihu.com)

[1709.01507] Squeeze-and-Excitation Networks (arxiv.org)

GitHub - moskomule/senet.pytorch: PyTorch implementation of SENet

【注意力机制】CBAM详解(文末附代码)_姚路遥遥的博客-CSDN博客

[1807.06521] CBAM: Convolutional Block Attention Module (arxiv.org)

CVPR2021|| Coordinate Attention注意力机制_注意力机制加在什么位置_Fly-Pluche的博客-CSDN博客

[2103.02907] Coordinate Attention for Efficient Mobile Network Design (arxiv.org)

GitHub - houqb/CoordAttention: Code for our CVPR2021 paper coordinate attention

ECA(Efficient Channel Attention) 注意力机制 - 知乎 (zhihu.com)

[1910.03151] ECA-Net: Efficient Channel Attention for Deep Convolutional Neural Networks (arxiv.org)

YOLO算法改进系列_人工智能算法研究院的博客-CSDN博客

- 由于本人水平有限,难免出现错漏,敬请批评改正。

- 更多精彩内容,可点击进入YOLO系列专栏或我的个人主页查看

- YOLOv5:IoU、GIoU、DIoU、CIoU、EIoU

https://blog.csdn.net/FriendshipTang/article/details/129969044- YOLOv7训练自己的数据集(口罩检测)

https://blog.csdn.net/FriendshipTang/article/details/126513426- YOLOv8训练自己的数据集(足球检测)

https://blog.csdn.net/FriendshipTang/article/details/129035180