Python爬取数据的库——Scrapy

一、爬虫的基本原理 爬虫的基本原理就是模拟人的行为,使用指定的工具和方法访问网站,然后把网站上的内容抓取到本地来。

爬虫的基本步骤:

1、获取URL地址:

2、发送请求获取网页源码;

3、使用正则表达式提取信息;

4、保存数据。

二、爬虫的类型 爬虫分为两类:

1、基于规则的爬虫:

基于规则的爬虫是指爬虫开发者需要自己定义爬取规则,爬虫根据规则解析页面,抽取所需要的数据。

2、自动化爬虫:

自动化爬虫不需要爬虫开发者定义爬取规则,爬虫可以根据给定的URL地址自动发现目标网站的结构,并自动抽取所需要的数据。

三、Python爬虫框架——Scrapy

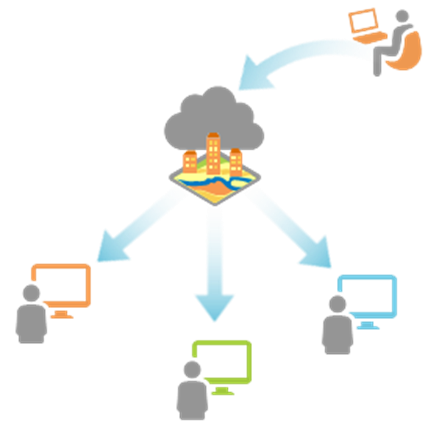

Scrapy是用于爬取网站数据的一个框架,可以自动发现目标网站的结构,并自动抽取所需要的数据。Scrapy框架的基本组件如下:

1、Spider:

Spider是爬虫的核心组件,负责从指定的URL地址开始爬取网页数据。爬虫开发者需要自己定义Spider类,并实现parse()方法。

2、Item:

Item是爬取到的数据的载体,爬虫开发者需要自己定义Item类,并定义相应的字段。

3、Pipeline:

Pipeline是爬虫数据处理组件,负责对爬取到的数据进行清洗、过滤和存储。爬虫开发者需要

顺便介绍一下我的另一篇专栏, 《100天精通Python - 快速入门到黑科技》专栏,是由 CSDN 内容合伙人丨全站排名 Top 4 的硬核博主 不吃西红柿 倾力打造。 基础知识篇以理论知识为主,旨在帮助没有语言基础的小伙伴,学习我整理成体系的精华知识,快速入门构建起知识框架;黑科技应用篇以实战为主,包括办公效率小工具、爬虫、数据分析、机器学习、计算机视觉、自然语言处理、数据可视化等等,让你会用一段简单的Python程序,自动化解决工作和生活中的问题,甚至成为红客。

🍅 订阅福利:原价299,限时1折订阅专栏进入千人全栈VIP答疑群,作者优先解答机会(代码指导/学习方法指引),群里大佬可以抱团取暖(大厂/外企内推机会)

🍅 订阅福利:简历指导、招聘内推、80G全栈学习视频、300本IT电子书:Python、Java、前端、大数据、数据库、算法、爬虫、数据分析、机器学习、面试题库等等

🍅 专栏地址: 点击《100天精通Python - 快速入门到黑科技》

![[江西专升本/信息技术]计算机网络基础](https://img-blog.csdnimg.cn/cd2297dde4804931b2d54cd7d243cefe.png)