目录

翻译:预算约束下营销效果优化的端到端框架

1介绍

2 .相关工作

2.1预算分配

2.2梯度估计

3我们的端到端框架

3.1符号

3.2两阶段范式

3.3 Marketing Goal as a Regularizer

3.4梯度估计

3.5训练

4实验结果

4.1数据集

4.2评价指标

4.3实现细节

4.4合成数据集的结果

4.5 CRITEO-UPLIFT v2实验结果

5结论

英文题目:An End-to-End Framework for Marketing Effectiveness Optimization under Budget Constraint

翻译:预算约束下营销效果优化的端到端框架

单位:快手

论文链接:https://export.arxiv.org/pdf/2302.04477v1.pdf

代码:暂无

摘要:在线平台通常会激励消费者提高用户参与度和平台收益。由于不同的消费者对激励的反应可能不同,个人层面的预算分配是营销活动中的一项重要任务。该领域的最新进展通常使用两阶段范式来解决预算分配问题:第一阶段使用因果推理算法估计个人层面的治疗效果,第二阶段使用整数规划技术来找到最优预算分配解决方案。由于这两个阶段的目标可能并不完全一致,这样的两阶段模式可能会损害整体营销效果。在本文中,我们提出了一个新的端到端框架来直接优化预算约束下的业务目标。我们的核心思想是构建一个正则化器来表示营销目标,并使用梯度估计技术对其进行有效优化。因此,获得的模型可以学习直接和精确地最大化营销目标。我们在离线和在线实验中广泛评估了我们提出的方法,实验结果表明我们的方法优于当前最先进的方法。我们提出的方法目前用于短视频平台上亿用户的营销预算分配,并取得了显著的业务目标改进。我们的代码将是公开的。

关键词:市场营销,因果学习,整数规划,神经网络,梯度估计

1介绍

向消费者提供奖励(如现金奖励、折扣、优惠券)是在线平台获取新用户、增加用户参与度、提高平台收益的有效途径[2,3,9,20,21,32,37,38,40,41]。例如,在淘宝[37]中提供优惠券以增加用户活跃度,在Booking[9]中提供促销以提高用户满意度,在快手[2]中使用现金奖励来刺激用户留存,在Uber[40]中使用促销来鼓励用户开始使用新产品。尽管有效,但这些营销活动可能会产生高成本,因此在实际场景中总预算通常是有限的。从在线平台的角度来看,营销活动的目标通常被描述为在特定的预算限制下最大化特定的业务目标(例如,用户留存率)。为此,为不同的用户分配适当的激励对于优化营销效果至关重要,因为不同的用户对激励的反应不同。这个预算分配问题具有重大的实际意义,并已进行了数十年的研究。

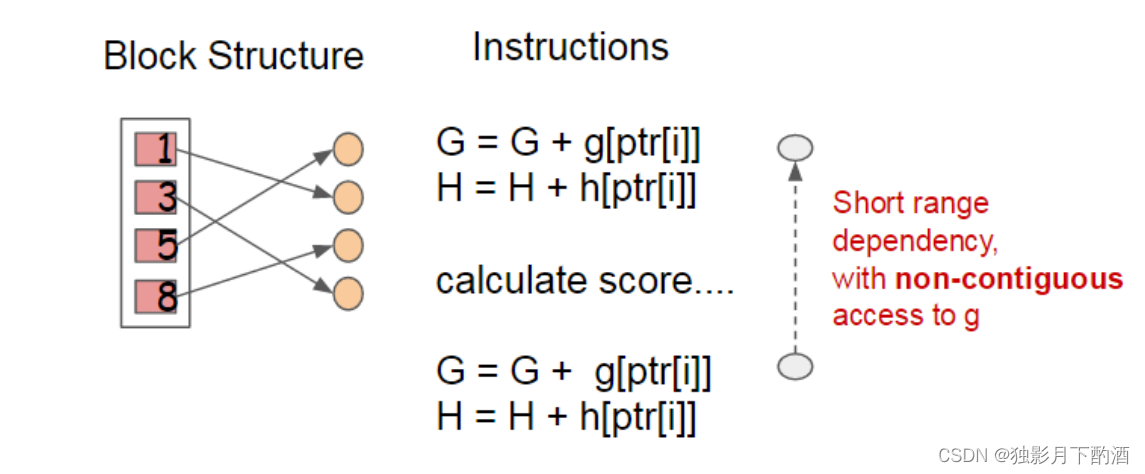

最近的许多进展使用两阶段范式来解决预算分配问题[2,3,32,38]:在第一阶段,使用因果推理技术估计个体层面的异质性治疗效果,然后将估计的效果作为系数输入到整数规划公式中以找到最优分配。然而,这两个阶段的目标是根本不同的,并且在实践中,我们观察到这些目标并不完全一致。例如,如果总预算非常低,那么有效的分配算法应该只将激励分配给对激励相当敏感的一小部分用户。在这种情况下,如果模型对所有用户平均具有更高的精度,但对这一小部分用户表现不佳,则改进的治疗效果预测器可能具有更差的营销效果。

在本文中,我们提出了一种新颖的端到端方法来直接和精确地优化预算约束下的营销效果。我们的核心思想是构建一个正则化器来表示营销目标,并使用梯度估计技术进一步优化它。具体而言,我们使用基于深度神经网络(dnn)的S-Learner[19]来预测不同用户的治疗效果。考虑到估计的治疗效果,我们进一步将预算分配问题表述为一个多选择背包问题(MCKP)[16],并利用预期结果度量法(EOM)建立一个无偏估计(记为?)营销目标(即在一定预算约束下的预期业务目标)。的吗?函数表示而市场营销的效果究竟是我们想要最大化的目标,因此我们要如何对待?并将其整合到s -学习者模型的训练目标中。然而,这样做仍然存在一个挑战:由于我们的建设过程?涉及使用拉格朗日乘法器求解一系列MCKPs,因此涉及许多不可微操作,现代机器学习库(如TensorFlow[1]和PyTorch[24])中的自动微分机制不会给出正确的梯度。我们解决这个问题的办法是治疗?作为黑盒函数,并利用梯度估计技术,如有限差分法或自然进化策略(NES)[34]来获得梯度。因此,正则化器可以有效地与s - leaner模型的原始学习目标进行联合优化。这个正则化器赋予S-Learner模型以一种原则性的方式直接从营销目标中学习并进一步最大化它的能力。我们提出的方法在离线模拟和在线实验中得到了广泛的评估。实验结果表明,与目前最先进的技术相比,我们提出的端到端培训框架可以实现更好的营销效果。我们进一步在一个大规模的短视频平台上部署了所提出的方法,向用户分配现金奖励,以激励他们创作更多的视频,在线a /B测试表明,在相同的预算下,我们的方法比基线方法明显多出至少1.24%的视频创作者,这是几个月来的巨大进步。目前,我们提出的方法服务于数以亿计的用户。

2 .相关工作

2.1预算分配

从一个共同的目标出发,提出了许多预算分配方法。早期的方法[10,39,40]通常在获得异质处理效果估计后启发式地选择用户的激励量。然而,缺乏明确的优化问题表述可能会使这些方法在最大化营销目标方面效果不佳。

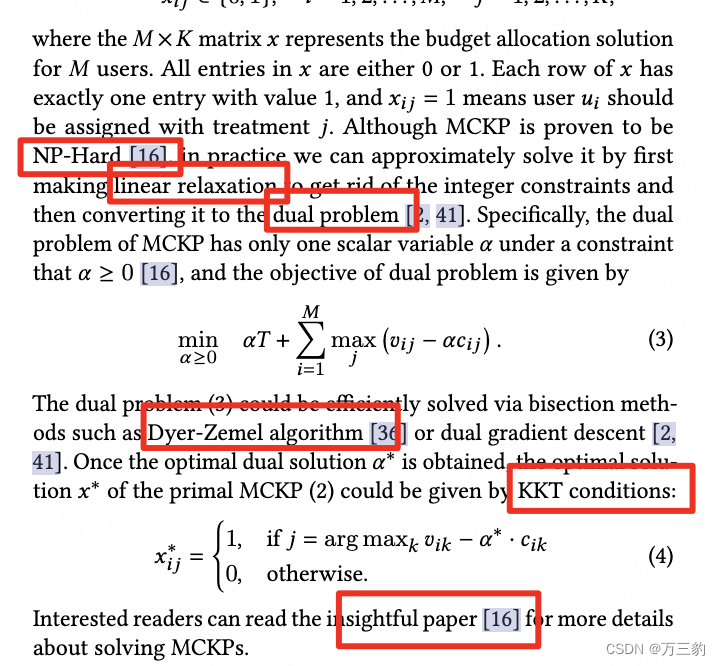

一种流行的预算分配方式是遵循两阶段范式[2,3,9,21,32,38]:在第一阶段使用隆升模型来预测处理效果,在第二阶段调用整数规划来找到最佳分配。如Zhao等人[38]提出使用logit响应模型[26]预测处理效果,然后通过寻根得到KKT条件下的最优配置。随后,Tu等人引入了各种高级估计器(包括因果树[4]、因果森林[33]和元学习器[19,29])来估计异质性效应。第二阶段也受到了很多研究的关注。Makhijani等人。为了更好的表达,[21]将营销目标制定为最小成本流网络优化问题。最近,Ai等人。[2], Albert和Goldenberg[3]使用MCKP表示离散情况下的预算分配问题,并基于拉格朗日对偶性开发了有效的求解方法。虽然有效,但由于这两个阶段的目标不一致,这两个阶段方法的解决方案可能不是最优的。

还提出了几种直接学习最优预算分配策略的方法[8,9,35,37,41,42]。Xiao等人[35],Zhang等人[37]开发了强化学习解决方案。基于约束马尔可夫决策过程直接学习最优策略。然而,在不利用因果结构的纯无模型黑盒方法中学习如此复杂的策略可能会导致样本效率低下。Du等人。bbbb10, Goldenberg等。[9],邹等人[42]提出在二元治疗设置中直接学习价值与成本的比值,可以先对得分较高的用户进行治疗。后来,当代研究[41]证明了[8,42]中提出的loss在loss收敛时不能达到正确的rank。此外,[9]中提出的方法仅适用于预算约束为货币ROI≥0的情况,这对于在线互联网平台上的许多营销活动来说不够灵活。Zhou等人将以决策为中心的学习思想扩展到多处理设置,并开发了一个损失函数来学习MCKP解的决策因素。然而,所提出的方法依赖于边际效用递减的假设,这在实践中往往不被严格遵守。

2.2梯度估计

估计黑盒函数的梯度已经被广泛研究了几十年,并广泛应用于强化学习[30]和对抗性攻击领域[11,13]。最简单的方法是有限差分策略,即根据定义计算梯度。有限差分策略可以给出精确的梯度,但如果黑盒函数的自变量具有高维数,则可能需要大量的计算。梯度估计的另一种方法是自然进化策略(NES)[34],它生成几个搜索方向来探测黑盒函数的局部几何,并根据采样的搜索方向估计梯度。NES通常比有限差分策略的计算效率更高,但估计的梯度是有噪声的。反向抽样[28]可以减少NES梯度估计的方差。在本文中,我们提出了基于有限差分和基于nes的梯度估计算法。

3我们的端到端框架

许多预算分配方法遵循两阶段范式,这可能导致性能下降,因为两个阶段的目标之间的不一致。我们认为将基于第二阶段的分配过程适当地纳入学习目标是有益的,这样模型可以直接学习最大化营销目标。在本节中,我们首先介绍主要的符号,然后简要分析两阶段范式,最后我们提出了我们的端到端训练框架。

3.1符号

3.2两阶段范式

3.2两阶段范式

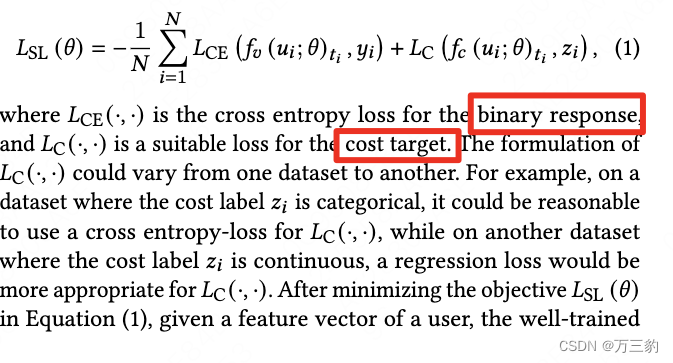

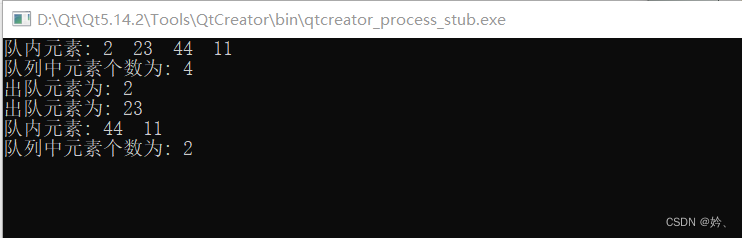

同时预测response,cost。

损失函数

3.3 Marketing Goal as a Regularizer

如第1节所述,我们端到端训练的核心思想是构建一个正则化器来表示营销目标(即在一定预算约束下的预期响应),并使用梯度估计技术对其进行有效优化。

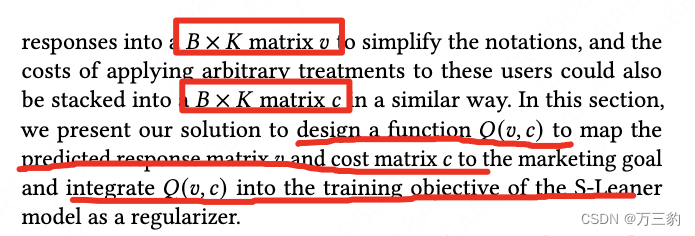

假设我们有一批?来自训练集B RCT用户(我们将批大小设置为 B = 10,000), S-Learner模型可以预测每个用户的反应,我们将叠加他们的预测。反应成?×?矩阵?为了简化符号,对这些用户应用任意处理的成本也可以堆叠到B × K矩阵v以类似的方式。为了简化符号,对这些用户应用任意处理的成本也可以堆叠到B ×K 矩阵?以类似的方式。

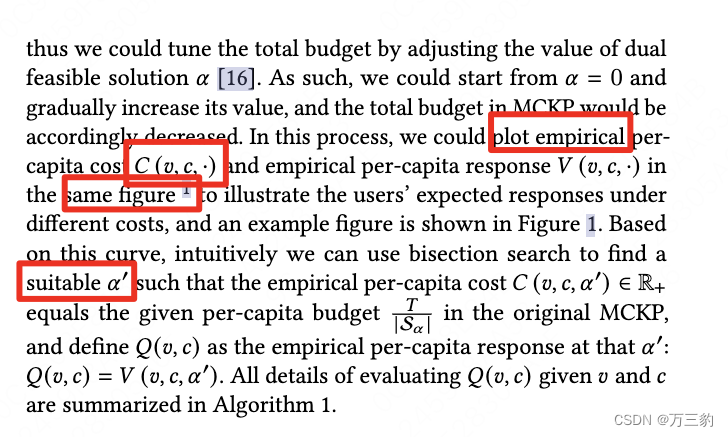

如前所述,得到的x最优的预算分配方案是用户在一定的预算约束下,我们可以通过调整对偶可行解的值来调整总预算。因此,我们可以从a = 0,并逐渐增大其值,则MCKP的总预算将相应减少。

3.4梯度估计

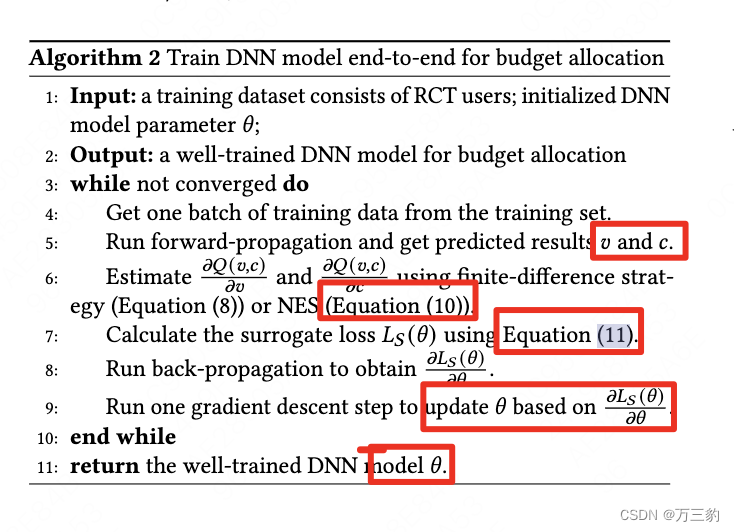

3.5训练

3.5训练

4实验结果

4.1数据集

合成数据集。为了详细说明我们想法的关键组成部分(即EOM和梯度估计),我们生成了一个由10,000个RCT用户组成的合成数据集。

CRITEO-UPLIFT v2[7]。这个公开可用的数据集是为评估隆起建模模型而设计的。该数据集包含从随机对照试验中收集的1390万个样本。每个样本有12个密集特征,一个二进制处理指标,两个二进制标签:访问和转换。在这个数据集中,处理被定义为用户是否被广告定位,如果用户在两周的测试期间访问/转换了广告商的网站,则标签被定义为积极的。为了评估不同的预算分配方法,我们遵循[41]并分别使用访问/转换标签作为成本/价值。我们将我们提出的方法的性能与最先进的CRITEO-UPLIFT v2进行比较,以证明我们方法的有效性。

KUAISHOU-PRODUCE-COIN。Produce Coin是一项常见的营销活动,旨在激励短视频创作者在快手上传更多短视频。在本次活动中,我们将为快手平台上的每一位短视频创作者提供一份珍贵的任务。具体来说,在每个任务中,如果创作者在24小时内上传视频,他/她将获得一定数量的硬币作为奖励。每个创造者都可以看到他/她可能获得的硬币数量,如果这个数字足够吸引人,创造者可能会完成任务。

4.2评价指标

我们使用以下评估指标来评估和比较不同方法的性能:

AUCC(成本曲线下面积),单位为b[8]。现有文献[2,8,41]常用AUCC来评价两种处理条件下抬升模型的排序性能。有兴趣的读者可以查看原始论文[8],了解更多关于AUCC评估过程的详细信息。在本文中,我们使用AUCC来比较不同方法在CRITEO-UPLIFT v2中的性能。

EOM(预期结果度量)。EOM或类似的度量标准在现有文献中也常用[2,41],以经验估计任意预算分配政策的预期结果(例如,人均反应或人均成本)。EOM可以对任何结果进行无偏估计,只要在RCT数据上给出预算分配解决方案,结果是可计算的。因此,EOM在实践中比AUCC更灵活。本文使用合成数据集和快手- produce - coin数据集中的EOM来评估不同的预算分配方法,EOM的技术细节已在3.3节的式(5)和式(6)中介绍。

4.3实现细节

不同数据集的实现细节如下:

4.4合成数据集的结果

4.5 CRITEO-UPLIFT v2实验结果

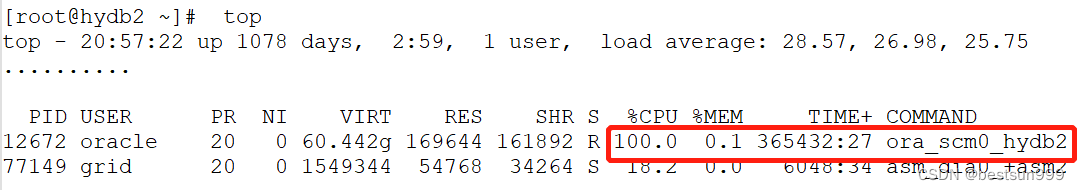

CRITEO-UPLIFT v2试验结果汇总如表1所示。OursFD和Ours-NES分别采用有限差分策略/ NES作为梯度估计量的方法。我们发现our - fd和our - nes在AUCC意义上都明显优于所有竞争方法。我们的- fd在20次运行中具有最高的AUCC方差,这种现象可能是部分的用NES梯度是有噪声的这一事实来解释。虽然our - fd的性能超过了our - nes,但在NVIDIA Tesla T4 GPU上,our - fd的运行时间多了4倍(our - fd 17.6小时,而our - nes 4.3小时),因为我们需要评估?函数多次调用。

5结论

本文研究了端到端培训框架在预算分配问题中的应用。我们将一定预算约束下的业务目标表述为一个黑箱正则化器,并开发了两种高效的梯度估计算法对其进行优化。对于这两种梯度估计算法,我们建议使用一个超参数来权衡计算复杂度和估计梯度的准确性。我们提出的方法应该赋予训练良好的DNN模型直接从营销目标中学习并进一步最大化的能力。在三个数据集上的大量实验表明,我们的方法在离线模拟和在线实验方面都具有优势。我们未来的工作将集中于减少梯度估计的方差,并将这种方法应用于更复杂的现实世界的营销场景。

![[HDU - 4578]Transformation(线段树+多重懒标记)](https://img-blog.csdnimg.cn/6b504b99066d4c7597b4e2d8b927a38e.png)