问:支持向量机仅可以用于处理二分类任务

答:错误。支持向量机可以用于处理多分类任务,通过使用一对多或一对一的方法,将多个类别分别与其他类别做二分类。也可以使用多类支持向量机算法,直接将多个类别一起纳入训练和分类过程中。此外,支持向量机还可以进行回归和异常检测等任务。

问:SVM的是带约束的优化问题,常用拉格朗日乘子法求解。

答:正确。SVM(Support Vector Machine)是一个带约束的二次优化问题,它的目标是在满足约束条件的情况下尽可能地提高分类的准确性。为了解决这种问题,SVM采用了拉格朗日乘子法,并引入拉格朗日乘子来将约束条件转化为目标函数中的等式约束。这种方法的优势在于可以通过求解拉格朗日对偶问题,将原问题转化为一个更容易求解的形式。因此,SVM可以有效地解决高维空间中线性与非线性分类问题。

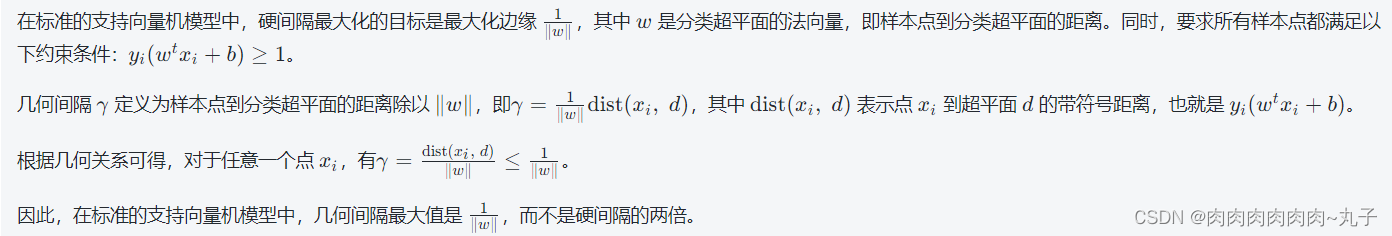

问:在标准的支持向量机模型中,几何间隔是硬间隔的两倍。

答:错误。在标准的支持向量机模型中,几何间隔是与函数间隔成正比例关系的,而不是硬间隔的两倍。

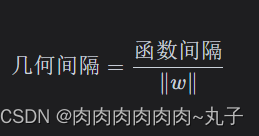

具体来说,几何间隔等于决策边界(即超平面)到最近的训练样本点的距离除以权重向量的范数。而函数间隔是样本点到超平面的距离乘以其类别标签,因此它的绝对值可能比几何间隔大。但是二者之间有以下关系:

其中 w 是超平面的权重向量。

因此,几何间隔和函数间隔都可以用来度量分类器的性能,但是几何间隔更具有通用性,因为它不受权重向量的缩放影响。同时,由于支持向量机的优化目标是最大化几何间隔,因此几何间隔在该模型中具有特殊的地位。

问:序列最小优化(SMO)算法是支持向量机的训练算法

答:正确。序列最小优化(smo)算法是支持向量机(svm)就算的一种训练算法。svm 是一种二分类模型,其目的是要在所有可能的分类情况中找到最佳的超平面。

SMO算法概述

序列最小优化(SMO)算法是一种用于支持向量机(SVM)训练的算法,其主要思想是将大问题分解为多个小问题,并通过二次规划来求解这些小问题,从而得到整个模型的解。

- SMO算法的核心是选择两个变量进行优化,这称为“两个变量二次优化”。

- SMO算法中,每次选择一个变量进行优化,而将其他变量保持不变。

- SMO算法使用了一个启发式方法来选择变量,称为“启发式选择变量”的方法。

- SMO算法在计算中使用了一些特殊的技巧,例如缓存和阈值,以提高算法的速度和效率。

- SMO算法的时间复杂度取决于样本集的大小,因此它通常适用于小样本问题。在处理大数据集时,通常需要使用其他的算法。

虽然SMO算法是一种经典的SVM算法,但它并不是唯一的SVM算法。其他的SVM算法包括梯度下降算法、坐标轴下降算法等,每种算法都有自己的优缺点和适用范围。

为了解决这个问题,svm 中需要找到一组特征权重和偏差,使得数据集上每一个类别都有支持向量,可以在分类器训练时用来帮助确定超平面。

smo 算法通过将优化极小化对偶问题转化为求解原始问题中的一系列子问题,从而高效地解决 svm 的训练问题。

smo 算法是 svm 训练过程的核心部分,可以使得 svm 模型的训练速度更快,并且能够处理大规模的数据集;是一种被广泛使用的支持向量机训练算法,可以有效地解决机器学习任务中二分类的问题。

问:采用线性核函数的支持向量机不能解决非线性分类问题。

答:错误。支持向量机(svm)是一种非常流行的分类算法,可以用于线性和非线性分类问题。具体而言,在svm中,我们使用所谓的核函数将输入数据映射到更高维度的特征空间中,并在该空间中构建一个超平面来分割不同类别的数据。

其中,线性核函数只能解决线性可分问题,而对于非线性分类问题,可以采用其他核函数(例如多项式核函数、径向基函数等)实现在高维空间中进行非线性分类。

因此,无论是线性问题还是非线性问题,svm在不同场景下都有着广泛的应用。

有关SVM的知识点请参考以下文章:

机器学习——SVM原理_肉肉肉肉肉肉~丸子的博客-CSDN博客

机器学习——所有非支持向量的拉格朗日乘子一定为0_肉肉肉肉肉肉~丸子的博客-CSDN博客

机器学习——核函数_肉肉肉肉肉肉~丸子的博客-CSDN博客

机器学习——支持向量机的训练_肉肉肉肉肉肉~丸子的博客-CSDN博客

机器学习——线性二分类器的最优超平面_肉肉肉肉肉肉~丸子的博客-CSDN博客

机器学习——结构风险最小化(SRM)_肉肉肉肉肉肉~丸子的博客-CSDN博客

![[2019.01.25]Android NDK Crash错误定位](https://img-blog.csdnimg.cn/0e6ca17a7cf54eb2b11b5eedf6626f27.png)