前言

本文来介绍下IJKPLAYER的音视频同步策略及方法。IJKPLAYER所支持的同步策略,源自FFPLAY,因此有以下3种:

- 音视同步视频:这是缺省的同步策略,以audio为主时钟-参考时钟,采取video同步audio的方式;

- 视频同步音频:这是较音频同步视频更为麻烦的同步策略,以video为主时钟-参考时钟,采取audio同步video的方法;

- 同步外部时钟:音视频均以外部时钟,做为参考时钟;

音频同步视频

这是IJKPLAYER所支持的缺省同步策略,以audio为主时钟-参考时钟,采取以video同步audio的方法进行。简单起见,此处不考虑不同serial的frame,下文仅讨论同1个serial的frame的音视频同步。

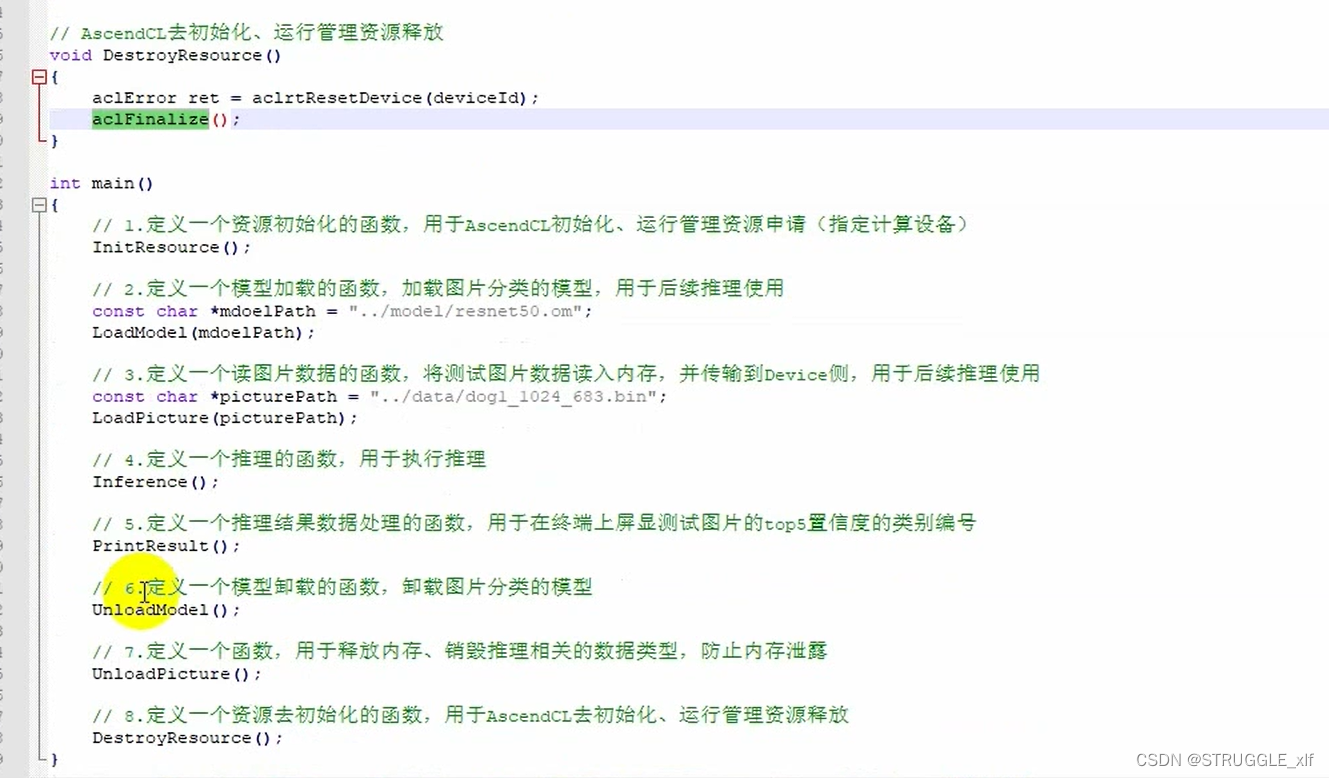

显示主流程

video_refresh_thread实现:

static int video_refresh_thread(void *arg)

{

FFPlayer *ffp = arg;

VideoState *is = ffp->is;

double remaining_time = 0.0;

while (!is->abort_request) {

if (remaining_time > 0.0)

av_usleep((uint)(uint64_t)(remaining_time * 1000000.0));

remaining_time = REFRESH_RATE;

if (ffp->cover_after_prepared && !ffp->first_video_frame_rendered) {

is->force_refresh = true;

}

#if ANDROID

if (is->paused) {

SDL_Delay(1000/24);

is->force_refresh = true;

}

#endif

if (is->show_mode != SHOW_MODE_NONE && (!is->paused || is->force_refresh))

video_refresh(ffp, &remaining_time);

}

if (ffp->vout)

SDL_VoutFreeContext(ffp->vout);

return 0;

}video_refresh方法保留显示、同步等主要逻辑:

/* called to display each frame */

static void video_refresh(FFPlayer *opaque, double *remaining_time)

{

FFPlayer *ffp = opaque;

VideoState *is = ffp->is;

double time;

Frame *sp, *sp2;

if (!is->paused && get_master_sync_type(is) == AV_SYNC_EXTERNAL_CLOCK && is->realtime)

check_external_clock_speed(is);

if (!ffp->display_disable && is->show_mode != SHOW_MODE_VIDEO && is->audio_st) {

time = av_gettime_relative() / 1000000.0;

if (is->force_refresh || is->last_vis_time + ffp->rdftspeed < time) {

video_display2(ffp);

is->last_vis_time = time;

}

*remaining_time = FFMIN(*remaining_time, is->last_vis_time + ffp->rdftspeed - time);

}

if (is->video_st) {

retry:

if (frame_queue_nb_remaining(&is->pictq) == 0) {

// nothing to do, no picture to display in the queue

} else {

double last_duration, duration, delay;

Frame *vp, *lastvp;

/* dequeue the picture */

lastvp = frame_queue_peek_last(&is->pictq);

vp = frame_queue_peek(&is->pictq);

if (vp->serial != is->videoq.serial) {

frame_queue_next(&is->pictq);

goto retry;

}

if (lastvp->serial != vp->serial)

is->frame_timer = av_gettime_relative() / 1000000.0;

if (is->paused && (ffp->first_video_frame_rendered || !ffp->cover_after_prepared))

goto display;

/* compute nominal last_duration */

last_duration = vp_duration(is, lastvp, vp);

delay = compute_target_delay(ffp, last_duration, is);

int64_t time_us = av_gettime_relative();

if (!is->audio_st)

ffp_clock_msg_notify_cycle(ffp, time_us / 1000);

time = time_us / 1000000.0;

if (isnan(is->frame_timer) || time < is->frame_timer)

is->frame_timer = time;

if (time < is->frame_timer + delay) {

*remaining_time = FFMIN(is->frame_timer + delay - time, *remaining_time);

goto display;

}

is->frame_timer += delay;

if (delay > 0 && time - is->frame_timer > AV_SYNC_THRESHOLD_MAX)

is->frame_timer = time;

SDL_LockMutex(is->pictq.mutex);

if (!isnan(vp->pts))

update_video_pts(is, vp->pts, vp->pos, vp->serial);

SDL_UnlockMutex(is->pictq.mutex);

if (frame_queue_nb_remaining(&is->pictq) > 1) {

Frame *nextvp = frame_queue_peek_next(&is->pictq);

duration = vp_duration(is, vp, nextvp);

if(!is->step && (ffp->framedrop > 0 || (ffp->framedrop && get_master_sync_type(is) != AV_SYNC_VIDEO_MASTER)) && time > is->frame_timer + duration) {

frame_queue_next(&is->pictq);

goto retry;

}

}

frame_queue_next(&is->pictq);

is->force_refresh = 1;

SDL_LockMutex(ffp->is->play_mutex);

if (is->step) {

is->step = 0;

if (!is->paused)

stream_update_pause_l(ffp);

}

SDL_UnlockMutex(ffp->is->play_mutex);

}

display:

/* display picture */

if (!ffp->display_disable && is->force_refresh && is->show_mode == SHOW_MODE_VIDEO && is->pictq.rindex_shown)

video_display2(ffp);

}

is->force_refresh = 0;

}同步

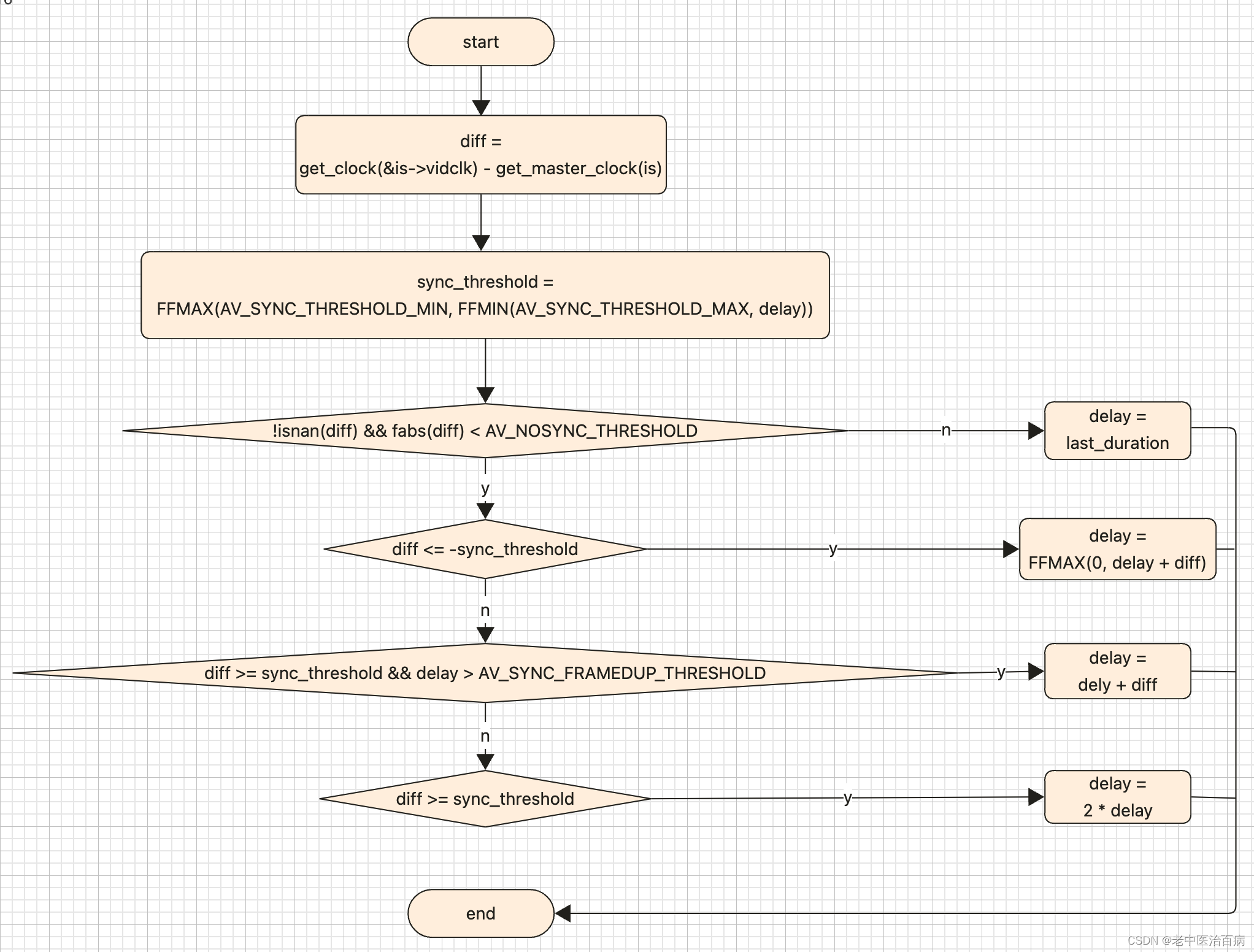

video同步到audio主时钟的具体实现,主要是在compute_target_delay方法里:

static double compute_target_delay(FFPlayer *ffp, double delay, VideoState *is)

{

double sync_threshold, diff = 0;

/* update delay to follow master synchronisation source */

if (get_master_sync_type(is) != AV_SYNC_VIDEO_MASTER) {

/* if video is slave, we try to correct big delays by

duplicating or deleting a frame */

diff = get_clock(&is->vidclk) - get_master_clock(is);

/* skip or repeat frame. We take into account the

delay to compute the threshold. I still don't know

if it is the best guess */

sync_threshold = FFMAX(AV_SYNC_THRESHOLD_MIN, FFMIN(AV_SYNC_THRESHOLD_MAX, delay));

/* -- by bbcallen: replace is->max_frame_duration with AV_NOSYNC_THRESHOLD */

if (!isnan(diff) && fabs(diff) < AV_NOSYNC_THRESHOLD) {

if (diff <= -sync_threshold)

delay = FFMAX(0, delay + diff);

else if (diff >= sync_threshold && delay > AV_SYNC_FRAMEDUP_THRESHOLD)

delay = delay + diff;

else if (diff >= sync_threshold)

delay = 2 * delay;

}

}

if (ffp) {

ffp->stat.avdelay = (float)delay;

ffp->stat.avdiff = (float)diff;

}

#ifdef FFP_SHOW_AUDIO_DELAY

av_log(NULL, AV_LOG_TRACE, "video: delay=%0.3f A-V=%f\n",

delay, -diff);

#endif

return delay;

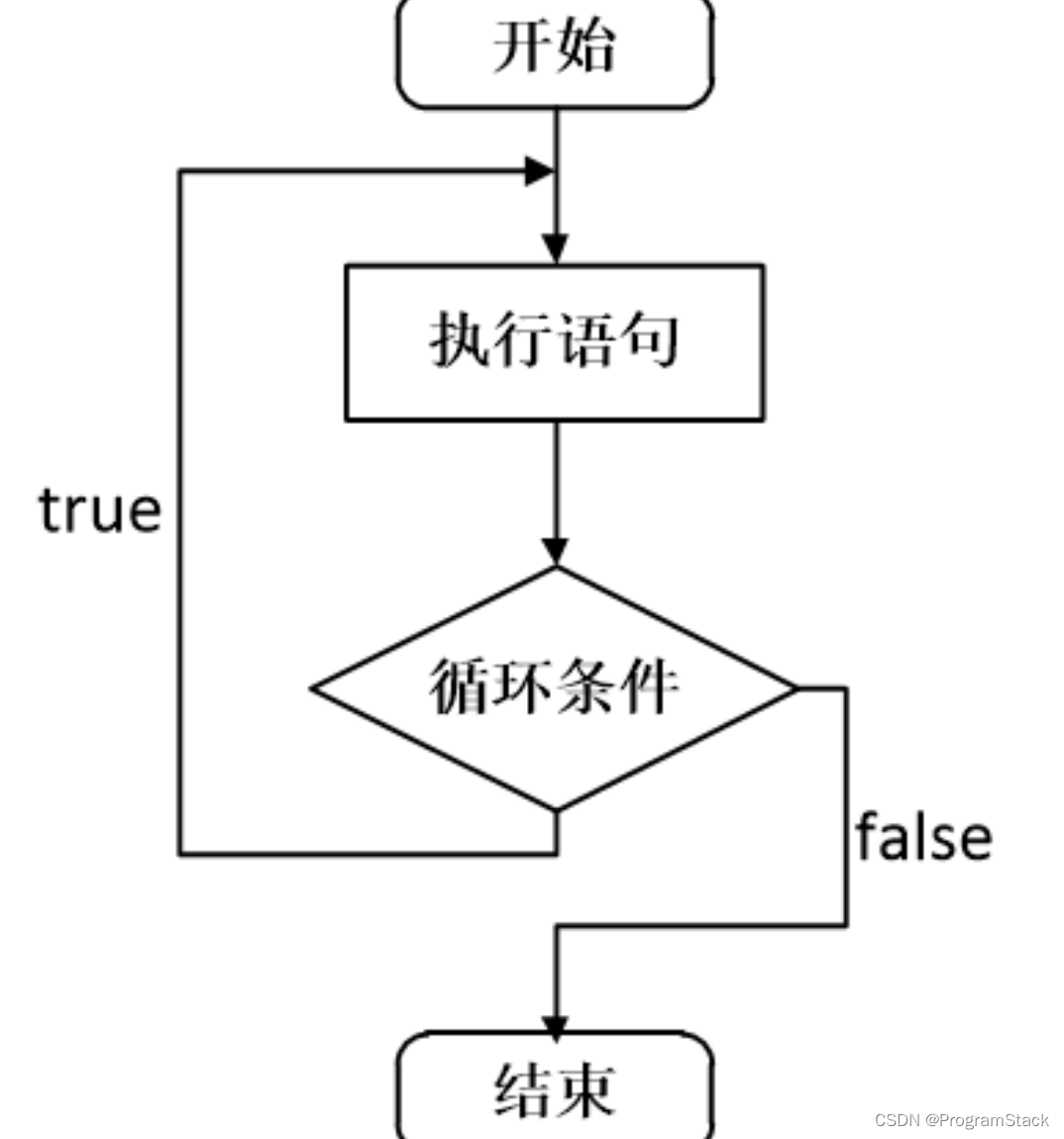

}归纳起来,大概流程如下:

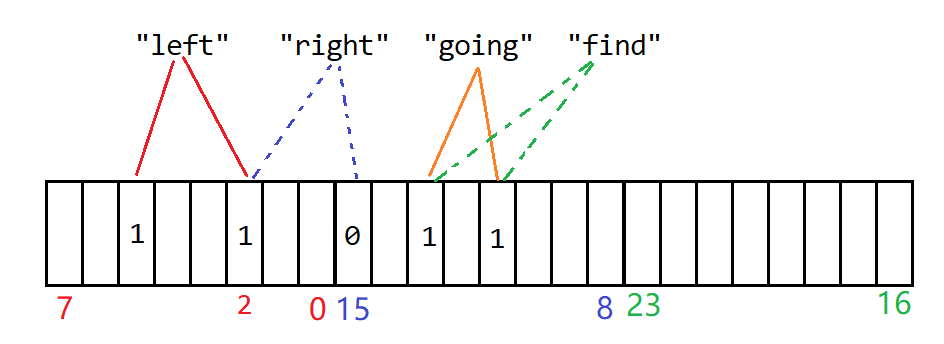

同步阈值

那么,video与audio的同步是绝对同步吗?其实不然,由于受网络抖动等因素影响,音视频同步永远是你追我赶的过程。以video同步到audio主时钟为例,video慢了则追audio,相反,则display上1帧video图像,以等待audio。工程实践中,video追audio的方式有2:

- video丢帧:通过丢弃video帧,来追audio;

- video变速播放:此处指video快速播放,来追赶audio;

同步的最小值、最大值和同步阈值定义:

/* no AV sync correction is done if below the minimum AV sync threshold */

#define AV_SYNC_THRESHOLD_MIN 0.04

/* AV sync correction is done if above the maximum AV sync threshold */

#define AV_SYNC_THRESHOLD_MAX 0.1

/* If a frame duration is longer than this, it will not be duplicated to compensate AV sync */

#define AV_SYNC_FRAMEDUP_THRESHOLD 0.15

/* no AV correction is done if too big error */

#define AV_NOSYNC_THRESHOLD 100.0音视频同步的阈值变量定义:

double sync_threshold = FFMAX(AV_SYNC_THRESHOLD_MIN, FFMIN(AV_SYNC_THRESHOLD_MAX, delay)); 由此可以看到,同步阈值的计算,其实是考虑到了delay值(video的last duration值)。总体来看,sync_threshold在[AV_SYNC_THRESHOLD_MIN, AV_SYNC_THRESHOLD_MAX] 之间,即[40,100]ms之间。

音视频步调在100ms内,IJKPLAYER认为其是同步的:

/* if video is slave, we try to correct big delays by

duplicating or deleting a frame */

diff = get_clock(&is->vidclk) - get_master_clock(is);

/* skip or repeat frame. We take into account the

delay to compute the threshold. I still don't know

if it is the best guess */

sync_threshold = FFMAX(AV_SYNC_THRESHOLD_MIN, FFMIN(AV_SYNC_THRESHOLD_MAX, delay));

/* -- by bbcallen: replace is->max_frame_duration with AV_NOSYNC_THRESHOLD */

if (!isnan(diff) && fabs(diff) < AV_NOSYNC_THRESHOLD) {

if (diff <= -sync_threshold)

delay = FFMAX(0, delay + diff);

else if (diff >= sync_threshold && delay > AV_SYNC_FRAMEDUP_THRESHOLD)

delay = delay + diff;

else if (diff >= sync_threshold)

delay = 2 * delay;

}视频同步音频

较之音频同步视频,此种同步策略,更为麻烦,待补充

同步外部时钟

后续补充

![[Gitops--4] OpenELB](https://img-blog.csdnimg.cn/a1bcdfda2a8543f8bbef2fe45e757520.png)