4月15日,华为云联合msup举办的“企业快成长大数据技术创新论坛北京站”圆满举办,100余位来自全国各地的大数据技术总监/技术经理/研发工程师共聚一堂,共探数据湖的架构演进,数据治理方法论及最佳经验实践。

首先由华为云大数据人工智能领域总裁尤鹏为大家致辞。他表示,为解决企业在AI落地时面临的挑战,华为云在“一切皆服务”的基础上不断夯实技术、平台、应用的能力,帮助降低AI应用门槛,让AI技术随取随用。

华为云大数据人工智能领域总裁 尤鹏

同时,华为提供了轻量化的数据治理的解决方案;也在做和最新NLP技术相结合的一款轻量化的BI产品;华为自研的DWS是基于生态OLAP组件来做的,可以方便、免运维、开箱即用得赋能给客户。

正如尤鹏所言:“华为云数智融合平台,通过数据治理生产线DataArts和AI开发生产线ModelArts融合的‘双引擎’,为企业与组织提供数据全链路解决方案,加速企业数智化转型。”

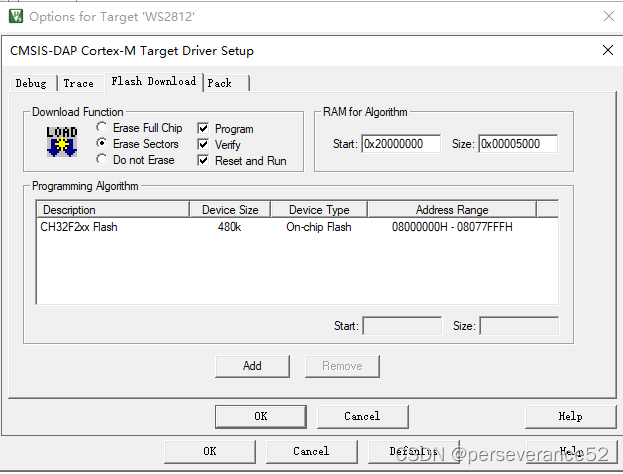

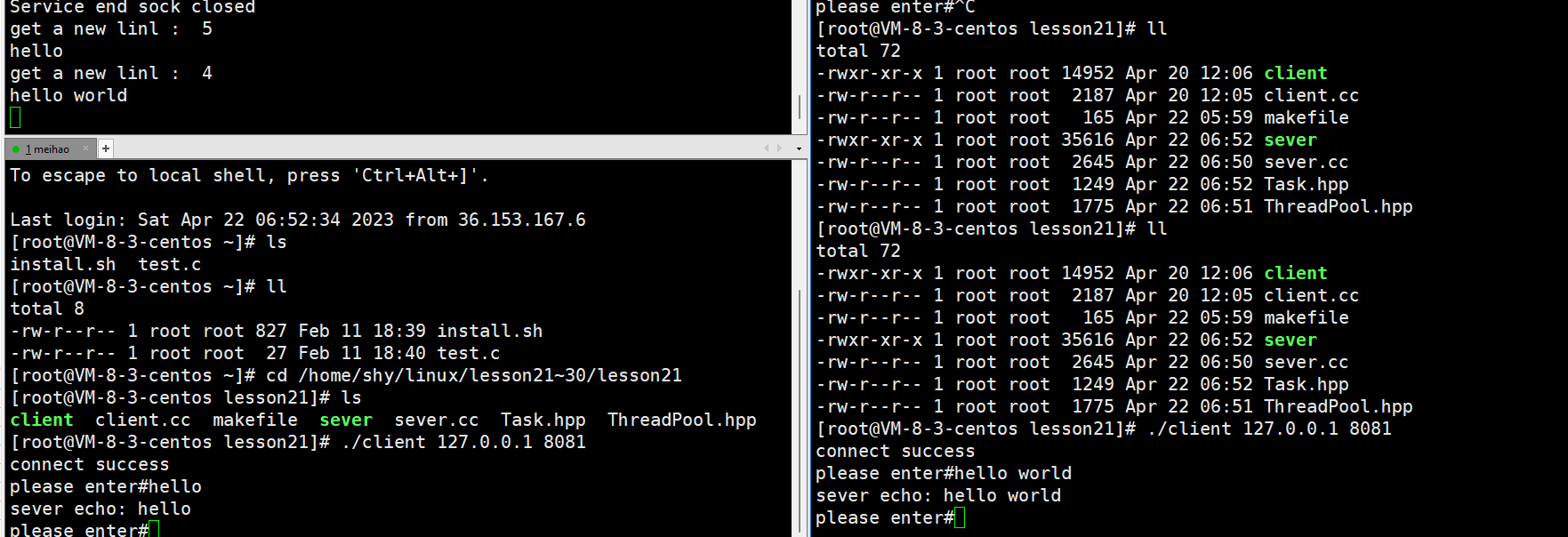

随后,华为云大数据技术专家王略为大家带来了《华为云湖仓一体现代数据栈解读》的干货分享。

华为云大数据技术专家 王略

华为内部目前在用湖仓一体架构,可以实现秒级业财控制、分钟及报表,还可以稳定支撑华为ERP业务。但许多企业在进行数据管理时,会面临一系列的挑战,这其中包括技术门槛高、投入成本大、数据治理难等三大问题。

针对这些挑战,王略为大家详细的讲述了DLI(Serverless多模计算服务,批、流、交互式一体,免运维、开箱即用)、DataArts Studio(一站式数据治理运营平台,AI驱动数据治理智能化,安全高效实现数据价值发掘)、CloudTable(全托管的Doris引擎,实时、简单、高效),他们共同构建了Serverless湖仓一体架构,且具备省心、轻量、可持续演进的特点。

最后,他通过云鲸智能的案例,为大家分享了华为云基于Serverless的数据湖在企业/行业的成功实践,希望这些落地实践可以帮助企业更好的支撑企业内部的数据分析和数据决策。

紧接着,Apache hudi Committer&Apache Druid Committer 张越为大家分享了《基于Hudi的Lakehouse Ingestion 性能优化探讨》的话题。

Apache hudi Committer&Apache Druid Committer 张越

张越从Hudi基本特性、Hudi Upsert 数据的过程、Hudi Ingestion的性能优化(RFC-53)、Early Conflict Detection 对Hudi Multi-Writer的优化(RFC-56)等四个方面进行了详述。

Apache Hudi是一个Data Lakes的开源方案,能够支持TB甚至PB量级的行级别更新。张越表示,如果在计算层能够保证records是唯一的,那么可以设置

hoodie.combine.before.upsert false 关闭Dedupe Stage,从而避免不必要的ReduceByKey 全局shuffle操作;同时,可以根据业务特点选择恰当的Index方式: BloomIndex、SimpleIndex、BucketIndex以及HBase Index等。

从Create Marker阶段到Merging && Writing Data Files再到RFC-53 && HUDI-5023 && HUDI-3923及Spark Streaming bulk_insert aggregated data into Lakehouse + clustering阶段的原理图及实施步骤,张越给大家做了详细的分享。

在工业生产过程中,随着数据量的不断增加,以及对于时效性要求不断提升,这种文件数据多写入湖的需求已经成为了一种刚需。在Hudi的世界里,关于如何支撑Multi-Writer以及Multi-Writer当下存在的问题,张越也为我们做了详细的解答,参会者纷纷表示受益匪浅。

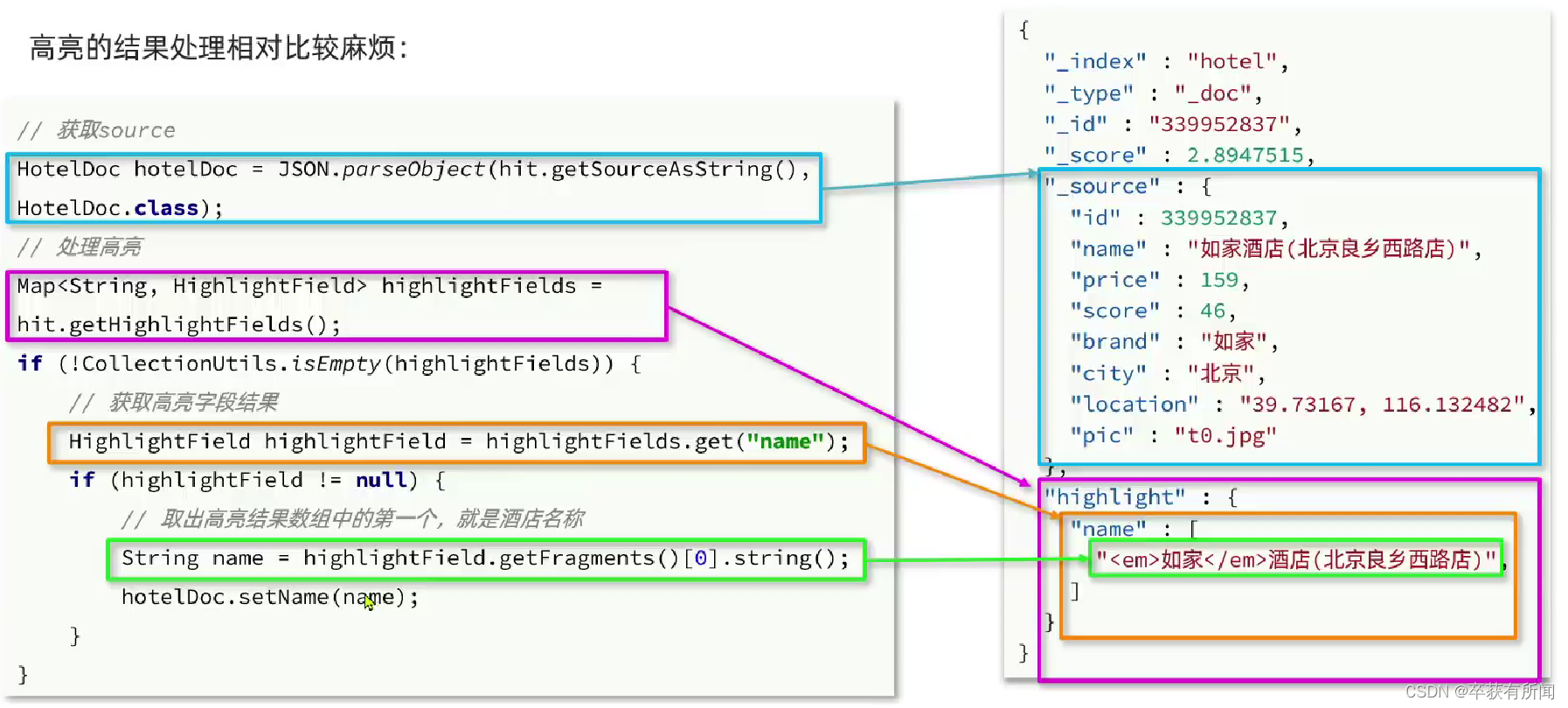

华为云DataArts Studio产品专家李品新为大家带来的《华为云DataArts Studio助力企业高效管数用数,发掘数据价值》精彩话题火爆整场。

华为云DataArts Studio产品专家 李品新

华为在做数据管理经过了两个阶段,第一是通过10多年的时间去把所有的业务数据做一个数字化,然后形成统一的清洁数据,支撑企业更好出各种各样的报表。这个阶段它主要目标是业务的数字化,第二是提升数据质量,所有数据都存在的情况下华为构建了统一的数据底座。这个数据底座上通过建立各种数据的连接,最终形了企业统一的数据地图,可以支撑企业快速数据分析。

为了实现数据治理的目标,华为提供有多种计算引擎,以及支撑。计算引擎包含Serverless化的DLI数据湖探索、MRS云原生数据湖、DWS云数据仓库、CSS云搜索和GES图计算等。

DataArts Studio是基于这些计算引擎之上做数据集成、数据开发、数据治理、数据服务全流程的各种工具支撑。它有如下特点:

• 具备全域全场景统一数据集成,一站式任务配置,全链路任务监控

• 全场景数据集成,全量数据、增量数据、实时数据一键集成

• 一站式开发+上线+运维,统一开发环境提升数据开发效率;批量作业、实时作业、AI作业开发调试,多样作业统一编排调度

• No Code数据分析和探索,Auto-ETL大幅降低数据分析门槛;还可以基线运维,围绕核心作业链路高效运维,保障关键任务及时完成

• 两层目录构建企业级数据资产体系,数据地图解决用数最后一公里问题

• 全局数据地图,让用户更好的查找、理解和使用数据资产,高效用数

• 数据资产生命周期管理,降低数据使用成本

• 统一策略配置,主动权限申请,多种手段保护数据资产安全

• 安全与效率兼顾,开发与生产环境隔离的两种实践,硬隔离与软隔离

• AI4Data驱动全流程自动化、智能化,提升数据治理效率

分享的最后,李品新表示,通过自动化的手段,华为整个数据处理过程中效率提高特别多,整个华为云对于数据治理的方案,除了提供产品,还提供了实施的能力,我们可以基于华为产品提供的能力进行一些咨询规划,将整个数据治理落地下去。

作业帮中台产研中心数据仓库技术负责人严晓炜为大家带来了《作业帮数据治理体系的思考与实践》的主题分享。

作业帮中台产研中心数据仓库技术负责人 严晓炜

随着业务的高速发展以及数据分析体系的日益完善,数据成为业务日常运作中重要的指南针和风向标;另一方面,数据和指标的日益膨胀,导致数据质量、数据易用性、存储成本等方面的问题层出不穷。如何能够最大限度发挥数据的价值,更加合理的使用计算存储资源,成为我们共同面临的新挑战。

基于这些问题,严晓炜从数据生产环节的指标和数据模型的构建、元数据管理和血缘分析、数据质量和数据安全、以及配套平台的建设等方面,详细阐述了作业帮整套数据治理解决方案和落地实施的过程,如何覆盖数据全生命周期,做到数据准确易用,成本透明可控。同时,结合作业帮业务的战略转型,从野蛮生长到精细化治理,他总结出了数据治理能够成功的4个基本关键点:

1、数据建设标准和规范落地是数据治理的基础,制定一套通用完善的数据建模标准和开发规范并推广业务数仓研发使用是后续数据治理的前提条件

2、数据的准确性、稳定性和时效性是数据治理的核心,通过建设数据质量管理平台等数据治理工具,为业务提供稳定可信赖的数据服务

3、数据ROI评估是数据治理的主要抓手,通过打通数据生产全链路,客观评估数据价值,自动识别冗余数据和无效任务,为后续的计算、存储资源治理提供依据,从而抑制数据成本的无序增长

4、建立数据开放共享机制是最大化数据价值的重要手段,在保障数据安全可用的前提下,降低数据获取门槛、增强数据易用性从而充分发挥数据的价值。

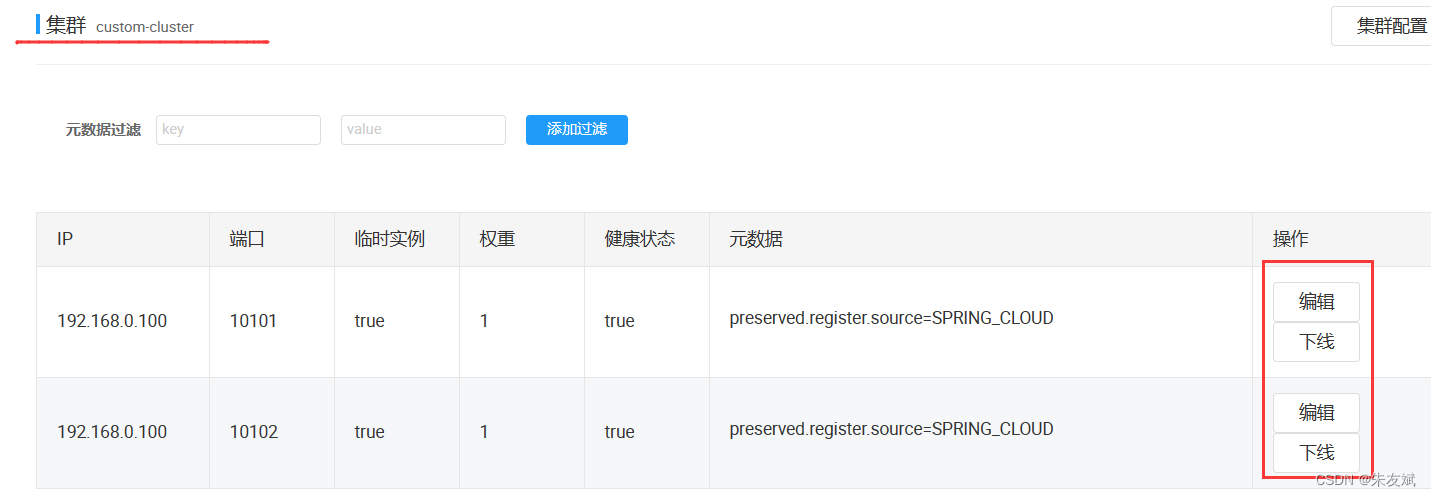

最后,中软国际数据治理高级架构师单晓明分享了《中软数据治理交付,构筑高效数据管理和客户价值共赢》话题,话题主要围绕中软国际公司介绍、数据治理解决方案、数据治理全流程、数据治理企业价值四部分展开的。

中软国际数据治理高级架构师 单晓明

在给企业做数据治理项目交付的过程中,中软发现有一些问题(数据管理组织方面、数据标准方面、数据质量方面、数据安全方面、生命周期管理方面),基于这些问题,他们首先会与企业达成一致的是共同的愿景,即:数据是作为企业战略的核心资产,其次会与企业沟通中软的使命、目标、以及解决方案。

基于整个数据治理的整个生命周期,从元数据开始到数据标准,数据质量,再到数据集成,帮助企业最终形成一个数据资产,去提升自身的价值。

关于数据治理流程,单晓明表示,通过大量的调研后,我们总结出了数据治理的九个阶段,在这个基础上,中软国际有专门的行业级专家,帮企业做一个大的梳理调研,看企业有哪些数据,这些数据最终能达到什么样的效果。同时,他还为大家分享了帮助电影院企业数据治理的例子以及治理过程中实施的具体流程。在这过程中,中软用了华为的DataArts Studio,帮助客户做了整套数据治理的架构设计、业务流程、逻辑关系、接口梳理、主题设计、标准设计、逻辑分层,最终帮助客户实现了自动对账和第三方渠道自动对账,收入核算、收入结算自动化的动作。

单晓明还为我们分享了多个数据治理项目的落地案例及解决方案,数据治理聚焦企业价值实现,实现IT生产力的提升和价值的最大化。

本次论坛在热烈的讨论和意犹未尽中落下帷幕。大数据正在推动中国经济实现高质量发展,并深刻影响人民生活和进步,华为云将持续秉承“一切皆服务”战略,不断夯实技术、平台、应用的能力,帮助降低AI应用门槛,让AI技术随取随用。华为云也将联手更多生态伙伴,共建更多优质解决方案,助力千行百业云上创新。