Python爬虫基础-如何获取网页源代码

网络爬虫(Web Crawler),又称网页蜘蛛(Web Spider),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。爬虫程序根据一组特定的规则自动的访问网站,然后抓取网页上的内容,进行下一步的处理。

爬虫通常遵循网页的链接来移动,所以爬虫也叫做网页蜘蛛。爬虫的目的一般有两个:一是为了收集信息,二是为了执行网页测试。

网页源代码(HTML)是网页的结构化数据,是网页的基本组成部分。网页源代码是指网页正文部分的代码。

网页源代码的格式一般有两种:

-

HTML

-

XHTML

HTML是网页的基本结构,包括文本、图像、链接等内容。

XHTML是HTML的扩展,它是一种严格的、结构化的标记语言。XHTML是XML的应用,所以它具有良好的可扩展性。

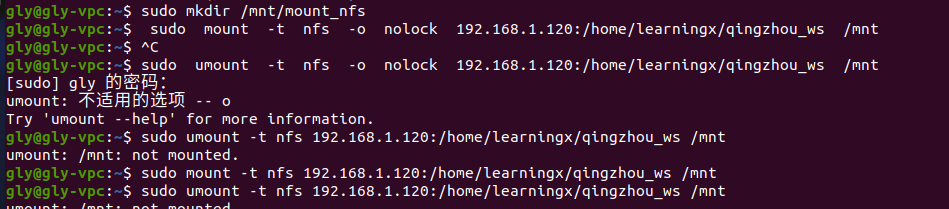

爬虫程序可以通过浏览器的开发者工具来查看网页的源代码。

在Chrome浏览器中,可以按F12键打开开发者工具,在开发者工具中选择“检查”工具来查看网页的源代码。

如果要爬取网页的源代码,可以使用Python的urllib库。

urllib提供了一系列用于操作URL的功能。

urllib.request库提供了一系列用于处理URL请求的功能。

urllib.error库提供了一系列用于处理URL错误的功能。

urllib.parse库提供了一系列用于解析URL的功能。

顺便介绍一下我的另一篇专栏, 《100天精通Python - 快速入门到黑科技》专栏,是由 CSDN 内容合伙人丨全站排名 Top 4 的硬核博主 不吃西红柿 倾力打造。 基础知识篇以理论知识为主,旨在帮助没有语言基础的小伙伴,学习我整理成体系的精华知识,快速入门构建起知识框架;黑科技应用篇以实战为主,包括办公效率小工具、爬虫、数据分析、机器学习、计算机视觉、自然语言处理、数据可视化等等,让你会用一段简单的Python程序,自动化解决工作和生活中的问题,甚至成为红客。

🍅 订阅福利:原价299,限时1折订阅专栏进入千人全栈VIP答疑群,作者优先解答机会(代码指导/学习方法指引),群里大佬可以抱团取暖(大厂/外企内推机会)

🍅 订阅福利:简历指导、招聘内推、80G全栈学习视频、300本IT电子书:Python、Java、前端、大数据、数据库、算法、爬虫、数据分析、机器学习、面试题库等等

🍅 专栏地址: 点击《100天精通Python - 快速入门到黑科技》