计算机视觉领域三大顶会之一的 CVPR 今年已经开奖啦。

今年的 CVPR 将于六月在加拿大温哥华举办,和往年一样,字节跳动技术团队的同学们收获了不少中选论文,覆盖文本生成图像、语义分割、目标检测、自监督学习等多个领域,其中不少成果在所属领域达到了 SOTA(当前最高水平)。

一起来看看这些成果吧~

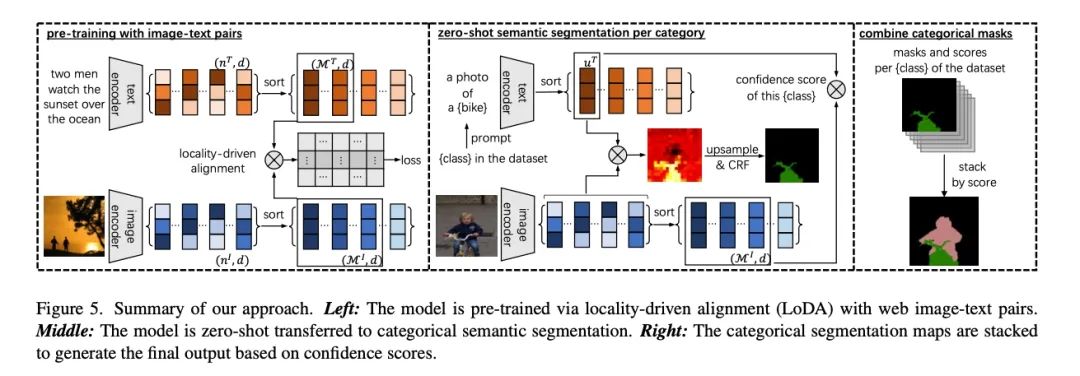

一个简洁的文本监督语义分割框架

A Simple Framework for Text-Supervised Semantic Segmentation

这项工作由字节跳动商业化技术团队与上海交通大学、早稻田大学合作完成。

文本监督语义分割是一个新颖的研究课题,它可以通过图像-文本对比学习的方式获得语义分割结果。然而,该领域之前的方法使用了专门设计的网络结构(而非通用的主干网络)。

本文表明了最基本的图文预训练模型 CLIP 本身就具有文本监督语义分割能力。首先,我们揭示了原版 CLIP 模型在定位和分割上的缺失,因为它的优化是由密集对齐的视觉和语言特征驱动的。其次,我们提出局部对齐(LoDA)的学习方式来解决这个问题,让 CLIP 的优化由稀疏的局部表示进行驱动。最后,我们提出了一个简单的分割框架(SimSeg)。LoDA 和 SimSeg 共同改进了 CLIP,从而得到精细准确的语义分割结果。

我们的方法在 PASCAL VOC 2012、PASCAL Context 和 COCO 数据集上的表现明显优于之前最先进的方法。

Project page:

github.com/muyangyi/SimSeg

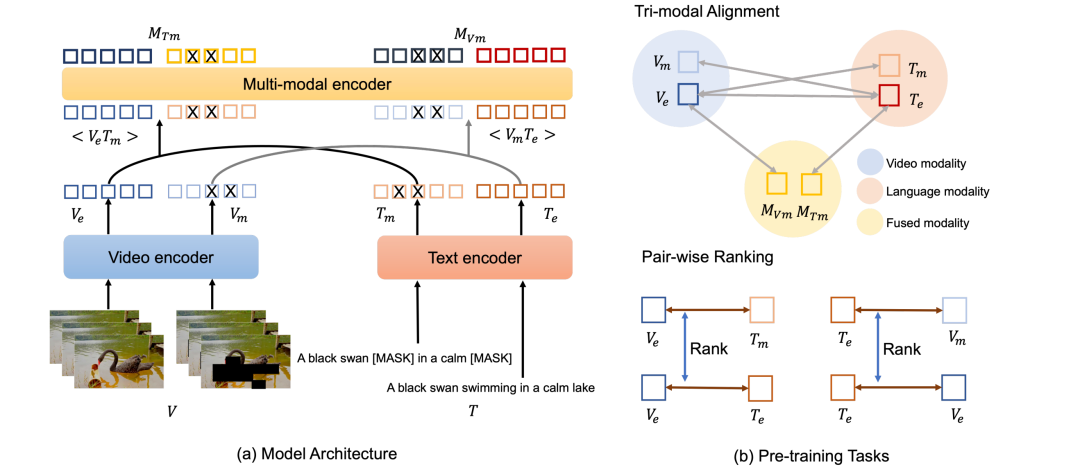

Clover: 统一的视频-文本对齐及融合预训练模型

Clover: Towards A Unified Video-Language Alignment and Fusion Model

这项工作由字节跳动智能创作团队与厦门大学合作共同完成。

适用于多种视频理解下游任务(如文本检索视频、视频问答等)的视频-文本预训练模型是一个重要研究问题。近期的主要研究工作都采用单模态特征编码器上堆叠一个跨模态特征编码模块的框架,并通过对比式预训练任务进行模型训练。这些方案具有较好的通用性,然而,作者研究发现这些模型不能同时较好地对齐各模态特征且对跨模态特征较好地融合。

因此,作者团队提出了 Clover 视频文本预训练方案来进行优化。沿用单模态特征编码器+跨模态特征编码模块的框架,本文在 Clover 中引入了一种三模态对齐的预训练任务,即将视频模态,文本模态以及视频文本融合模态在特征空间进行对齐。作者借助对训练样本的语义 masking 策略来增强三模态对齐训练的效果,同时引入了 pair-wise ranking loss 来辅助更精细的 pair-wise 特征对齐。此外,Masking Language Modeling 的训练思想被用于对跨模态特征融合模块的训练。

通过一系列视频理解下游任务上的效果评估,Clover 视频-文本预训练模型在 DiDeMo、MSRVTT 和 LSMDC 三个文本-视频检索任务上取得了 zero-shot 及 finetune performance 的最佳表现;在 8 个主流的视频问答 benchmark 上也达到了新的 state-of-the-art。

arXiv:

https://arxiv.org/pdf/2207.07885.pdf

Github:

https://github.com/LeeYN-43/Clover

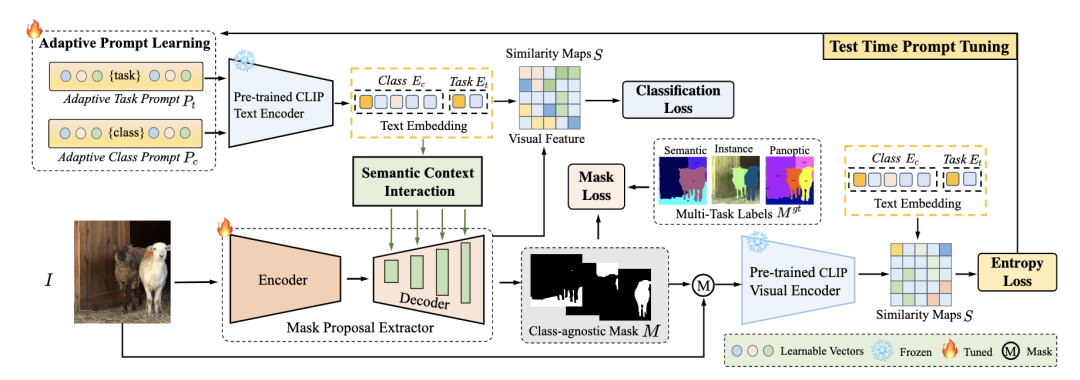

FreeSeg:统一、通用、开域的图像分割

FreeSeg: Unified, Universal and Open-Vocabulary Image Segmentation

这篇工作由字节跳动智能创作团队和中科院自动化所共同完成。

最近,开域图像分割可以实现任意类别的基于文本的描述的分割,将分割系统推广到更通用的应用场景。然而,现有的方法致力于为特定的分割任务设计专门的架构或参数。这些定制的设计范式导致各种分割任务之间的碎片化,从而阻碍了分割模型的一致性。

因此,在本文中,作者团队提出了通用框架 FreeSeg,用于实现统一、通用、开域的图像分割。FreeSeg 通过 One-Shot Learning 优化了一个 All-in-One 网络,并采用相同的架构和参数在推理过程中无缝处理不同的分割任务,包括语义,实例和全景分割。

此外,自适应提示学习有助于统一模型捕获任务感知和类别敏感概念,提高了多任务和多种场景中的模型鲁棒性。

在 COCO、ADE 等数据集上的广泛实验结果表明,FreeSeg 在三个开域分割任务的性能和泛化方面实现了新的最先进的结果。

arXiv:

https://arxiv.org/abs/2303.17225

project page:

https://FreeSeg.github.io

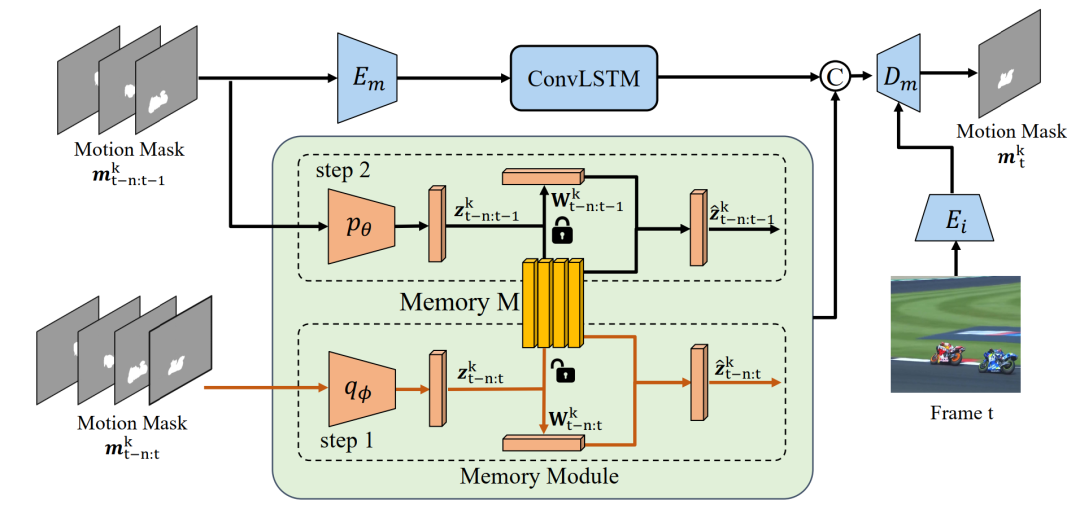

InstMove:以目标为中心的视频分割的实例运动

InstMove: Instance Motion for Object-centric Video Segmentation

这篇工作由字节跳动商业化技术团队与约翰霍普金斯大学、华中科技大学合作完成。

这篇论文主要研究如何在以物体为中心的视频分割任务(包括 VIS、VOS、MOTS)中使用物体运动信息。

现有的视频分割算法通常依赖目标的外观特征进行跟踪和分割,对于被遮挡或快速移动的物体十分敏感。物体的运动信息可用于解决这个问题,但之前基于光流的运动模型在物体遮挡或快速移动时表现不佳,而常用于 MOT 任务中的恒速或卡尔曼滤波模型过于简化了物体的运动,忽略了物体的形状和形变信息。

为此,作者提出了使用 InstMove,一个基于 memory bank 的实例级别(instance-level)运动预测模型来预测目标对象的位置和形状。这个运动预测模型可以直接插入大部分实例级别的视频分割任务,帮助已有视频分割模型获得更好的表现,尤其是在遮挡和快速运动的场景下。

实验证明,在 VIS、VOS、MOTS 三个下游视频分割任务的五个数据集上,将 InstMove 插入到现有 SOTA 模型可以进一步带来 1~5 个点的提升。

arXiv:

https://arxiv.org/abs/2303.08132

code:

https://github.com/wjf5203/VNext

文本驱动的开放词汇三维场景理解

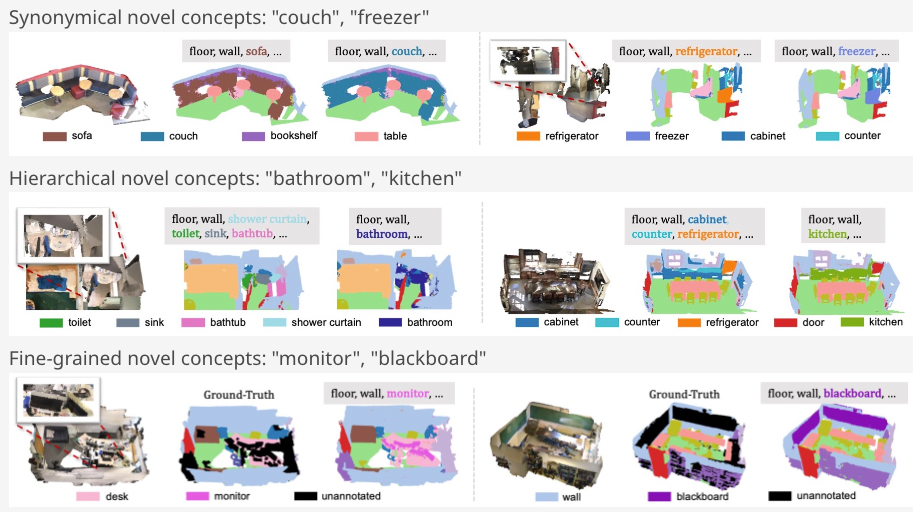

Language-driven Open-Vocabulary 3D Scene Understanding

这篇工作由字节跳动商业化技术团队与香港大学 CVMI Lab 合作完成。

开放词汇三维场景理解旨在识别未标注的新颖类别。目前 2D 开放词汇检测已经有成功的方法,但是他们都依赖爬取互联网上海量成对的图片和文字进行训练,或者利用已有的 2D 大模型。然而成对的 3D 数据和自然语言并不能直接从互联网上免费获取,需要昂贵的人工标注,从而也难以训练大模型。

为解决该问题,作者团队提出了一种结合点云和自然语言的新范式PLA (Point-Language Assocation),通过图片提取 2D 多模态大模型的知识并赋予 3D 点云,让 3D 模型也能够理解自然语言并识别数据集标注以外的类别。PLA 首先通过用 3D 点云对应的 2D 图像作为 2D 多模态大模型的输入,抽取对于图像的语言描述,然后利用图片和点云之间的投影关系,将图片的描述关联到 3D 点云。特别的,为了提供对于 3D 点云不同粒度的语言描述,作者团队提出了场景级,视角级和实例级三种多粒度的 3D 点云-自然语言关联的方式。

PLA 在开放词汇三维语义分割和实例分割任务上大幅度超过以前的基线方法,显著提升了已有模型在未标注类别的语义理解和定位能力,促进达到开放世界检测的目的,分享来自多模态大模型领域的进展。

arXiv:

https://arxiv.org/pdf/2211.16312.pdf

code:

https://github.com/CVMI-Lab/PLA

project page:

https://dingry.github.io/projects/PLA.html

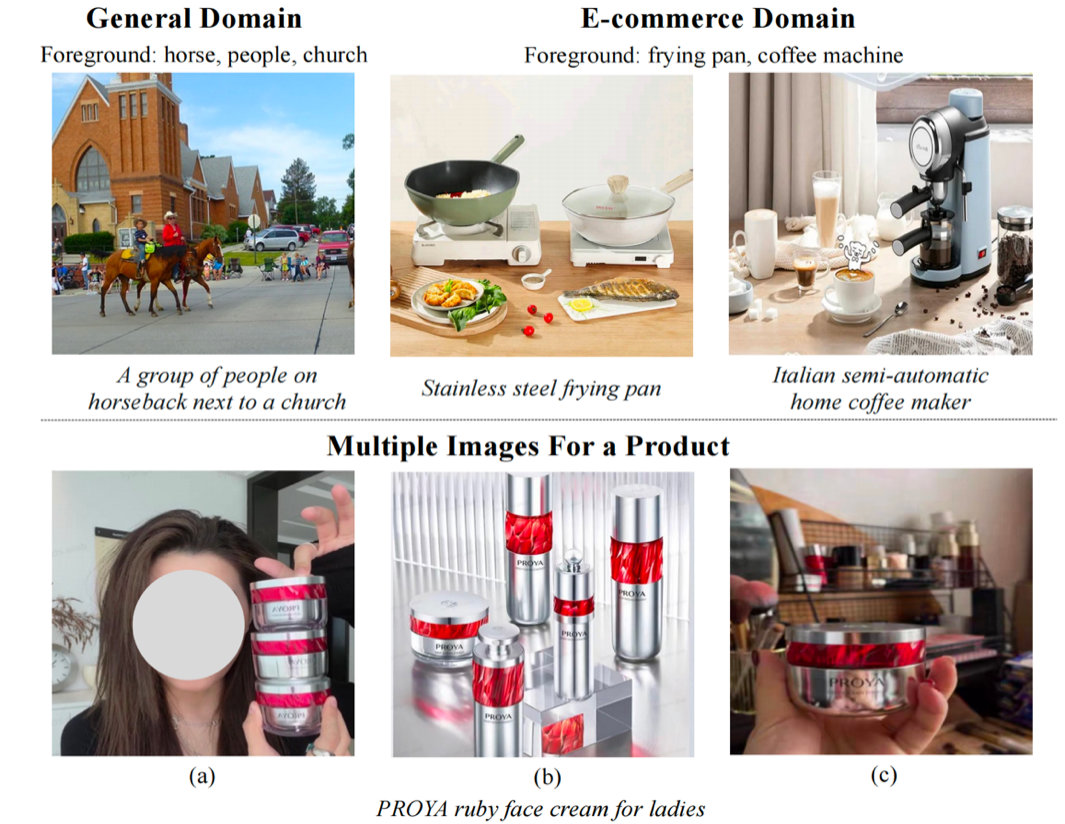

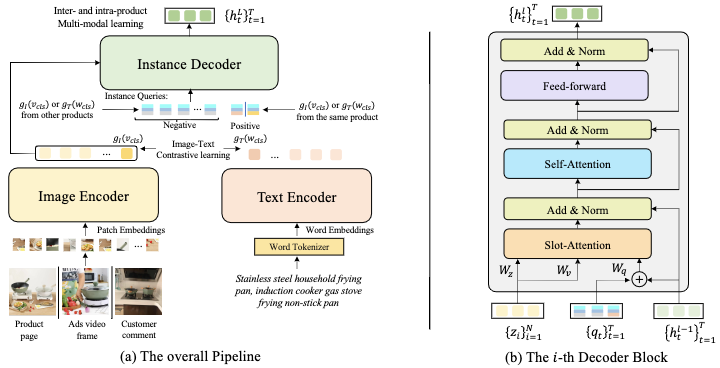

面向商品实体级表示的多模态预训练方法

Learning Instance-Level Representation for Large-Scale Multi-Modal Pretraining in E-commerce

这篇工作由字节跳动商业化技术团队与北京大学合作完成。

文章提出了一种旨在学习商品实体级表示(Instance-Level Representation)的多模态模型ECLIP,在电商领域的诸多下游任务中性能超过了传统的多模态学习方法。

目前在自然图像中的视觉语言学习中,已经出现类似 CLIP 这样的基础模型。其基于大规模的图像-文本对来学习一个通用多模态表示,从而在不同的视觉语言任务中取得了显著的进步。但是,我们却不能直接在电子商务领域中使用这些模型。下图显示了自然图像和电商领域的商品图片的不同特性:

对于自然图像,通常其大多数像素与文本的语义内容相关。然而,在电子商务领域中,这种相关性并不明显。例如,“煎锅”或“咖啡机”只占整个图像的一小部分, 图像中的前景物体是由它所附带的文本指定的。因此,要为商品图片学习到一个比较鲁棒和通用的表示,我们必须使得模型能够根据商品的文本描述,定位到特定的图像区域(商品实例)上。

因此,本文提出了 ECLIP,其引入了一个 instance decoder 结构来提取图像中和商品实体相关的表示。Decoder 中包含了由用户指定的 instance query,用于寻找一张图片中和 query 关联的 prompt 内容相关的商品实体。

另外,作者团队注意到在电商领域中,一个商品的图片通常来自不同的源头。例如商品详情页、商品广告视频,以及买家的评论等等。这些图片因相机视角或场景的变化而有所不同,但是他们都包含相同的商品实例。本文据此设计了 inter-product 和 intra-product learning 两个特殊的预训练代理任务。

通过在 100M 的电商数据中进行预训练,ECLIP 在多个电商下游任务中超过了传统的多模态学习方法。

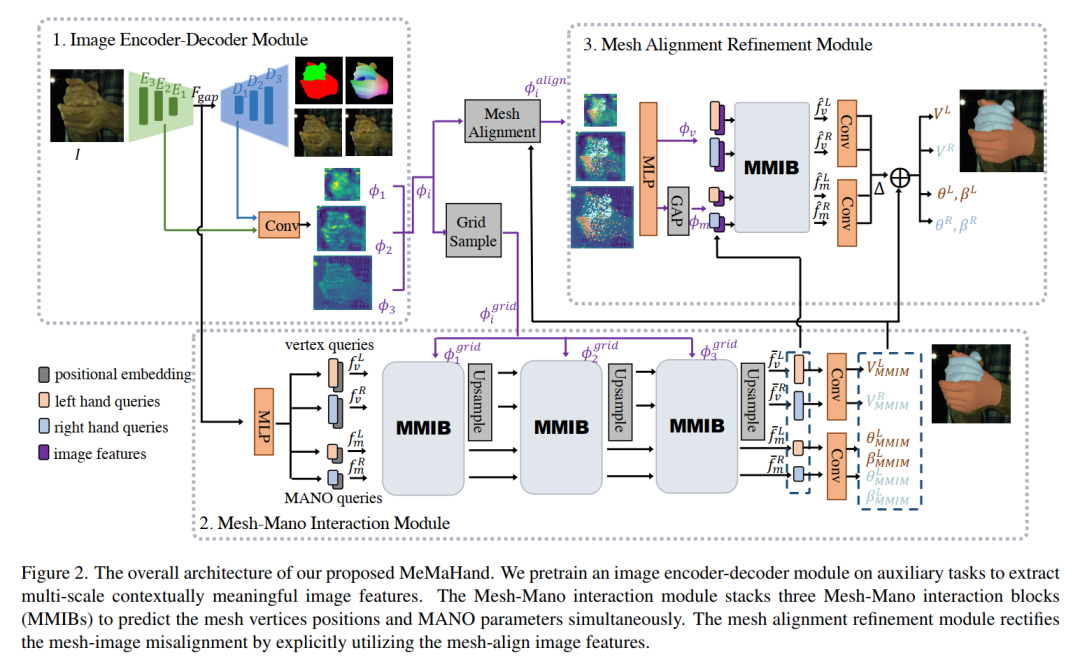

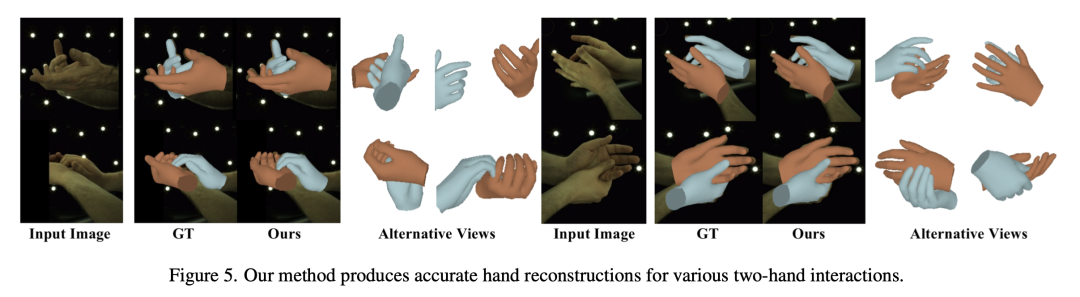

基于 Mano 参数和 Mesh 交互的单图像双手 3D 重建

MeMaHand: Exploiting Mesh-Mano Interaction for Single Image Two-Hand Reconstruction

本篇论文由字节跳动智能创作团队独立完成,文章提出了一种包含手部参数和非参数交互的双手重建网络结构,在双手数据集上达到了 SOTA 效果。

针对手重建任务提出的现有方法通常参数化通用 3D 手模型或直接预测手部顶点位置。由手形状和旋转姿势组成的 MANO 参数表示更稳定,而非参数方法可以预测更准确的顶点位置。

在本文中,我们同时从单个 RGB 图像重建手部定点并估计两只手的 MANO 参数,以充分利用两种手表示的优点。为了实现这一目标,我们提出了新颖的 Mesh-Mano 交互块 (MMIB),它将顶点位置和 MANO 参数作为两种查询标记。

MMIB 由一个用于聚合局部信息的图卷积残差块和两个具有远程依赖关系建模能力的 Transformer 编码器组成。Transformer 编码器配备了不同的非对称注意力掩码,分别对两只手内部和它们之间进行注意力建模。此外,我们引入了网格对齐修正模块以进一步增强手部网格与图像之间的对齐。

在 InterHand2.6M 数据基准上进行的大量实验证明了我们的方法能达到 SOTA 效果。

arXiv:

http://arxiv.org/abs/2303.15718

基于元学习的对未见组合健壮的参考图片目标分割框架

Meta Compositional Referring Expression Segmentation

这篇工作由字节跳动商业化技术团队与新加坡科技与设计大学合作完成。

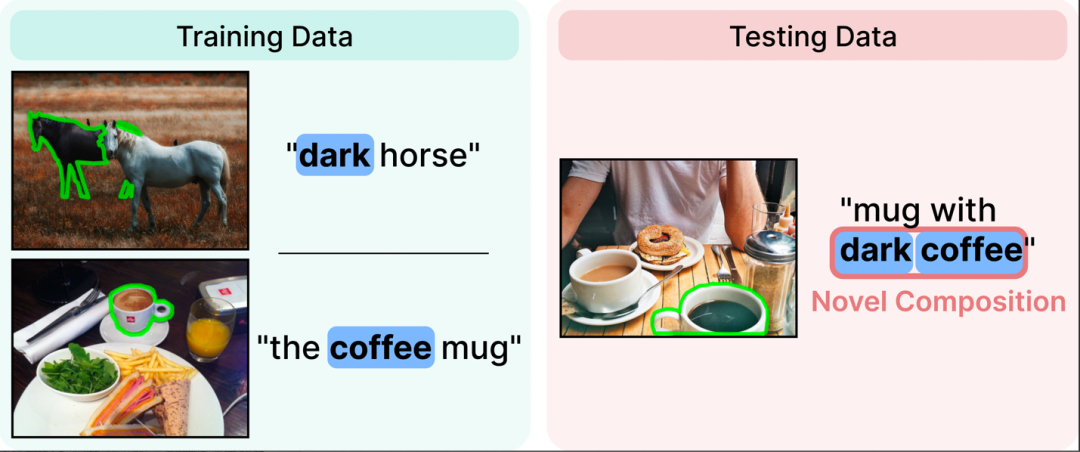

文章提出了在参考图片目标分割(Referring Expression Segmentation, RES) 领域关于提升模型对语言元素可组合性(Language Compositionality)健壮性的解决方案。

参考图片目标分割这个任务是指在给定图片中根据文字表述预测出对应物体的 mask. 尽管这个任务已经有不少的工作, 但目前的工作都没有关注语言元素可组合性这个问题。这个问题指的是模型在训练集中见过原子的语言元素,没有见过对应的组合,在测试集遇到这种未见组合无法准确理解的问题。

如下图中的例子所示,模型在在训练集中见过 dark 和 coffee 这两个单词,但没见过 dark coffee 这个组合。当模型在测试时遇到这个组合,出现无法理解的情况,从而预测失败。

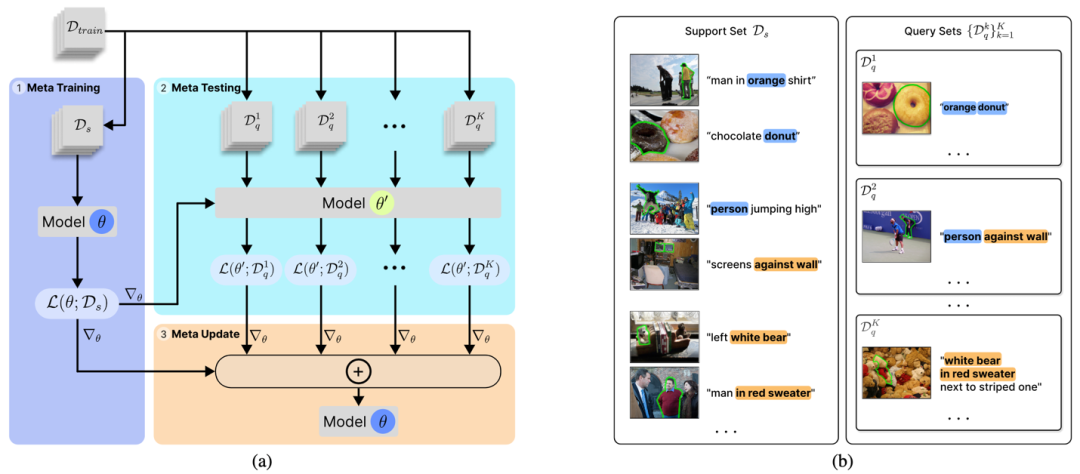

因此在这项工作中,为了提升模型对这种未见组合的表现,作者团队从元学习的角度提出了一个新颖的框架, 这个框架只改变模型的训练方式,因此可以无缝的和现有模型结合起来去提升他们的表现。

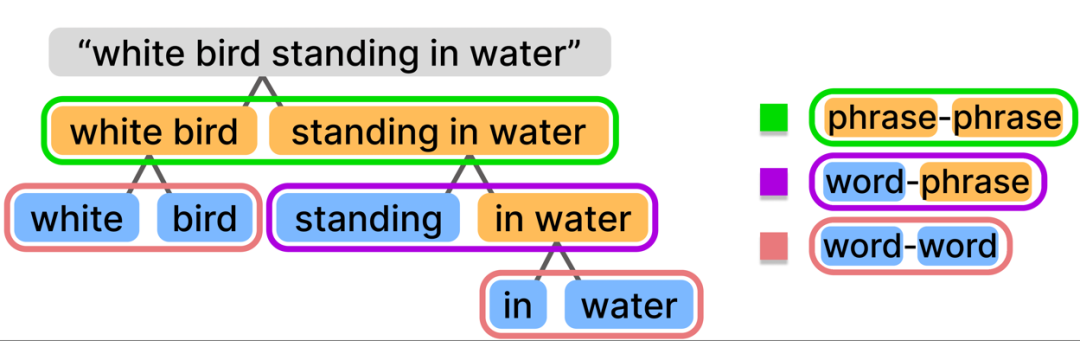

首先作者分析了这个任务中现有文字表达主要的三种组合方式,即单词与单词的组合,单词与词组的组合,词组与词组的组合,可见下图中的例子。

为了提升模型对这三种未见组合的表现,作者的框架做了如下设计:

先将训练集分成四个部分,其中一个子集是随机划分的。根据这个子集,使得剩下三个子集中,每个子集对应于随机划分的子集都含有一种未见的组合方式。将模型在随机划分的子集上先做训练, 然后在剩下三个子集上做测试,根据测试结果去更新模型,使得模型去学习泛化的知识,从而能够更好的处理的未见的语言组合。

通过这样改变模型的训练方式,作者团队有效的提升了模型对未见组合的表现,并且在现有的数据集上取得了显著的提升。

可驱动的 3D 头像生成

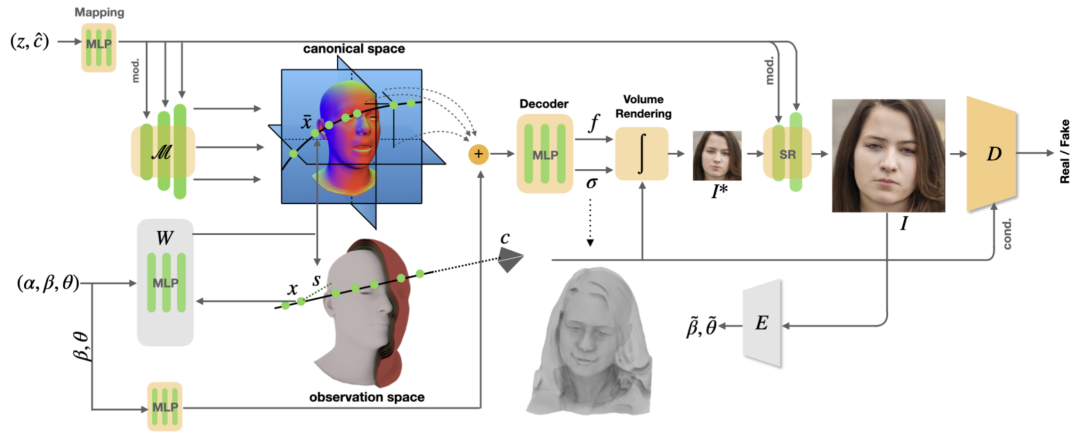

OmniAvatar: Geometry-Guided Controllable 3D Head Synthesis

这篇工作由字节跳动智能创作团队和新加坡国立大学合作完成。

这篇工作提出了一个全新的几何引导的 3D 头像合成模型 OmniAvatar。我们的网络训练只需要单视角图片就可以合成多样的外观以及丰富可信的动态细节,在保持人物一致的同时,自由控制渲染角度,头型,表情以及脖子和下巴的角度。

为了达到这样的解偶控制,我们首先基于参数化的 3D 人头模型 FLAME,定义了一个隐式的带语义的符号距离函数(SDF, signed distance function)。这个函数建立了观察空间和正则空间的可微分的 3D 点到点映射。由此我们可先利用 3D GAN(EG3D)的模型框架,在正则空间下生成符合预定义表情和头型的 3D 人头几何和外观,然后再基于我们的隐式映射函数形变到观察空间下,生成目标表情和头型。为提高控制的准确度,我们训练网络的时候要求生成的几何和底层的 FLAME SDF 尽量接近,同时生成图像里预测出来的表情系数需要符合我们输入的目标表情参数。在此基础上,我们还提出了基于表情的动态细节合成,进一步提升了动画的逼真度。

我们的模型定性和定量都超越了先前的 2D/3D 可控图像生成网络,不仅可以生成大量逼真的 3D 头像动画,也支持从单视角图像或者视频里重建可驱动的个性化 3D 头像。

arxiv:

http://arxiv.org/abs/2303.15539

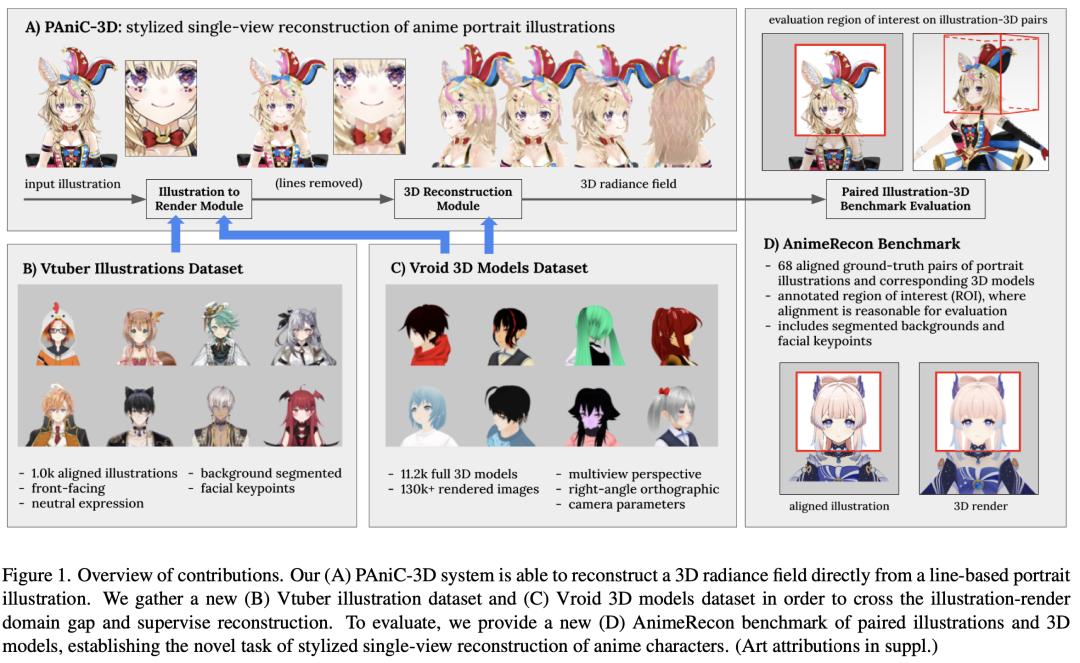

360 卡通角色生成

PAniC-3D: Stylized Single-view 3D Reconstruction from Portraits of Anime Characters

这篇工作由字节跳动智能创作团队和马里兰大学合作完成。

传统的 3D 人像重建工作通常只适用于真人的图片,而在动漫角色的 3D 重建方向的探索较少。在这篇文章中,研究者们探索了第一个基于 3D GAN 的 2D-3D 动漫角色重建模型。作者们贡献了两个卡通角色训练集(1) Vtuber Illustrations Dataset和(2) Vroid 3D Models Dataset。

第一个数据集用于训练 image translation 模型做 2D 卡通到 3D 动漫渲染风格的转换。由于卡通草稿图与 3D 渲染图存在风格上的不一致(例如草稿图中存在描边),作者们发现这一风格转换的步骤是后续的 3D 重建所必要的。

第二个数据集用于训练一个渲染图到 3D 模型的重建模型。该重建模型为一个条件 3D GAN (基于 EG3D)。其输入为一张正面的渲染图,输出则为一个 feature volume grid(和 PanoHead 相同的自研 tri-grid 表征)。

arXiv:

https://arxiv.org/abs/2303.14587

code:

https://github.com/ShuhongChen/panic3d-anime-reconstruction

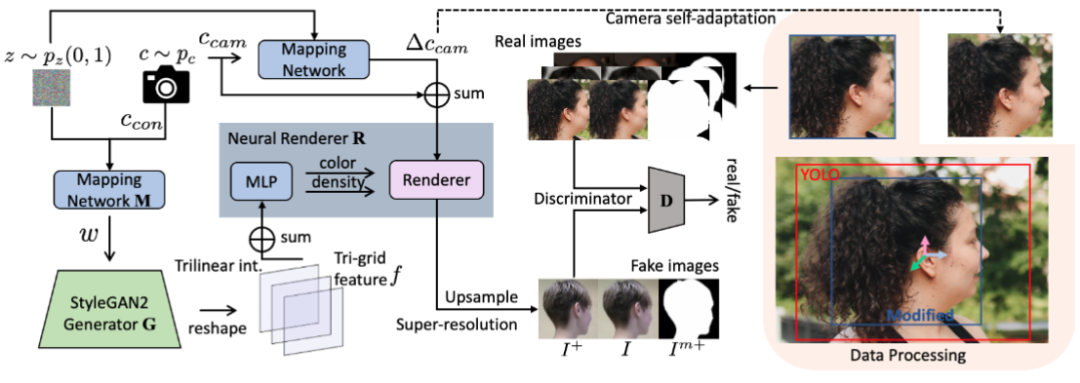

3D 全头 360 度图像合成

PanoHead: Geometry-Aware 3D Full-Head Synthesis in 360◦

这篇工作由字节跳动智能创作团队和威斯康辛麦迪逊大学合作完成。

3D GAN 网络可以合成高质量的人物头像,同时可以控制视角保持人物的一致性。但先前的 3D GAN 通常只能生成前脸,并且无法在大角度渲染下保持头像一致性。

这篇工作提出了 PanoHead, 首次实现了能 360 度全角度合成人头的 3D GAN 网络。我们的网络训练只需要单视角图片就可以合成多样的外观(比如波浪发,爆炸头)以及 3D 全头几何,同时保持360度的渲染一致性。为此,我们在之前的 3D GAN (EG3D)框架的基础上,提出了 3 个创新性的拓展。

首先,我们对训练图像集补充了大角度包括后脑勺的图像,同时提出了自适应的图像对齐(image alignment)模块,使得大角度图片在无法有效检测出人脸关键点的情况下也能和前脸图像对齐用于 GAN 网络训练。其次,我们提出了 tri-grid 的空间表示,比先前的 tri-plane 更能有效的对前脸和后脑特征解耦。最后我们还对训练图像进行了前景分割,并训练网络让其能够合成 RGB 图像的同时生成前景的分割。

PanoHead 支持任意角度渲染,并且也能从一张单视角图片中重建出 3D 全头,包括它的几何以及外观。

arxiv:

https://arxiv.org/abs/2303.13071

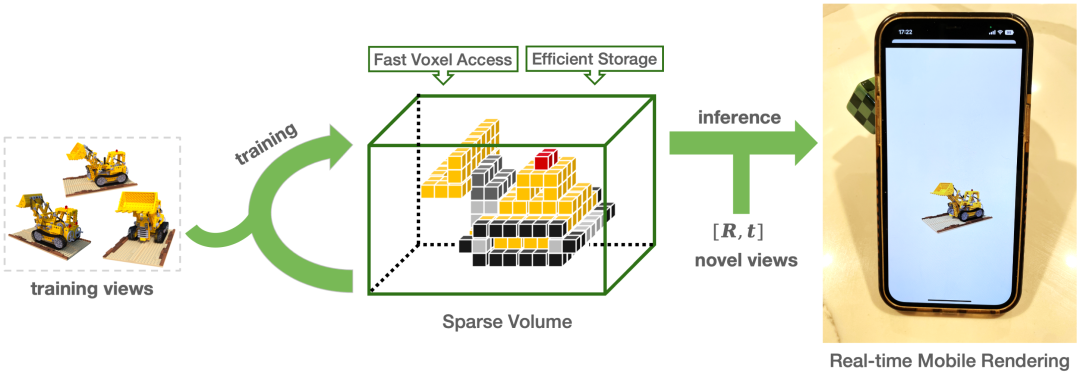

PlenVDB:一种用于快速训练和渲染的、内存高效的基于 VDB 的辐射场

PlenVDB: A Memory Efficient VDB-Based Radiance Fields for Fast Training and Rendering

这篇工作由字节跳动智能创作团队与上海交通大学合作完成。

论文提出了一种新的神经辐射场表示方法,利用了 VDB 这种分层稀疏体数据结构,以加速 NeRF 模型的训练和推断过程。VDB 是一种兼具稀疏和密集体积优点的数据结构,既可以紧凑地表示数据,又可以高效地访问随机和空间相关数据,因此非常适合用于 NeRF 模型的数据插值和射线投射。

Plenoptic VDB(PlenVDB),采用一种新颖的训练策略,可以直接从一组已知姿态的图像中学习 VDB 数据结构,并在实时渲染中使用。

实验结果表明,相较于之前的方法,PlenVDB 方法具有更高的效率和更好的效果。

首先,它在训练过程中收敛速度更快;其次,它提供了更紧凑的 NeRF 数据呈现格式;最后,它可以在普通的图形硬件上更加高效地进行渲染。PlenVDB 在移动端也能实时渲染,在 iPhone12 手机上达到了对于输出 1280x720 分辨率的画面每秒 30 帧的速率。

Project page:

https://plenvdb.github.io/

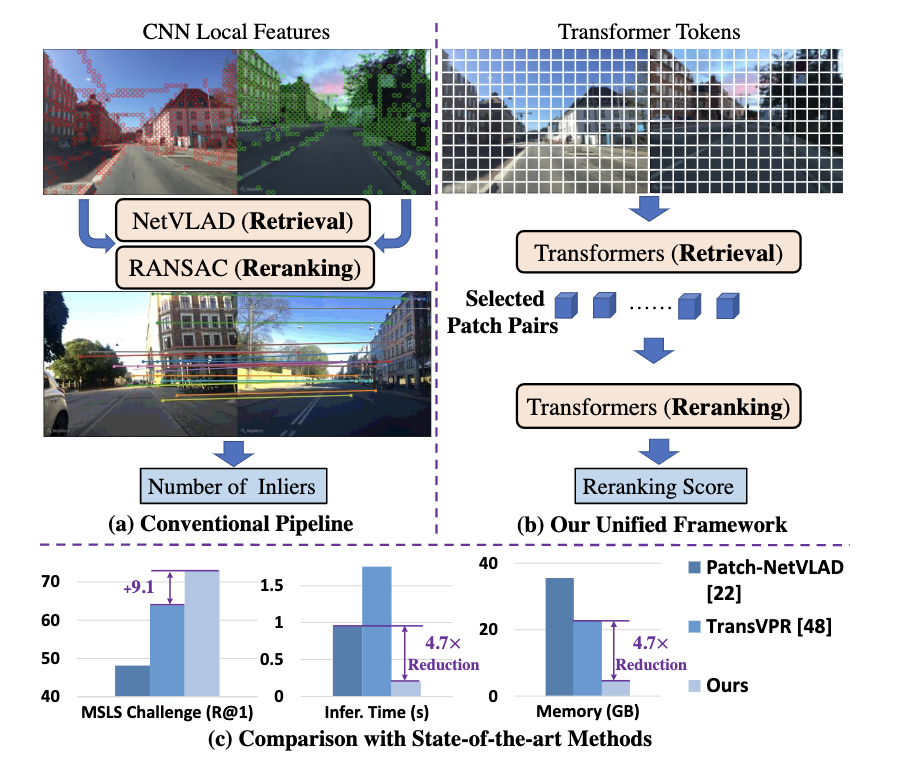

用于地点识别的统一检索和重排序Transformer

R2Former: Unified Retrieval and Reranking Transformer for Place Recognition

这篇工作由字节跳动智能创作团队和中佛罗里达大学合作完成。

视觉位置识别(VPR)通过将查询图像与参考数据库中的图像进行匹配来估计查询图像的位置。传统方法一般采用聚合 CNN 特征进行全局检索,并采用基于 RANSAC 的几何验证进行重新排序。然而,RANSAC 只考虑几何信息,但忽略了其他可能对重新排序有用的信息,例如局部特征相关性和注意力值。

在本文中,我们提出了一个统一的位置识别框架,该框架使用一种新颖的转换器模型处理检索和重新排序,名为 R2Former。所提出的重新排序模块考虑了特征相关性、注意力值和 xy 坐标,并学习确定图像对是否来自同一位置。整个方法是端到端可训练的,单独的重新排序模块也可以作为通用组件在其他 CNN 或 Transformer 主干上采用。

值得注意的是,R2Former 在主要 VPR 数据集上取得了显著优于最先进的方法的精确度和更少的推理时间与内存消耗。目前在 MSLS 挑战集上排名第一,并可以作为现实世界大规模应用的简单而强大的解决方案。实验还表明,视觉 Transformer 的 token 拥有与 CNN 局部特征相似的局部信息,有时在图像局部匹配上会优于 CNN 局部特征。

arXiv:

https://arxiv.org/pdf/2304.03410.pdf

粒度对齐的多模态模型训练

Revisiting Multimodal Representation in Contrastive Learning: From Patch and Token Embeddings to Finite Discrete Tokens

这篇工作由字节跳动智能创作团队和罗格斯大学合作完成。

传统方法在训练图片-文本模型时分别从视觉和文本 transformer 提取特征,再通过损失函数对齐两种模态的语义。然而视觉和文本信息本质上的信息粒度和尺度不同会造成学习的困难。本篇论文提出了利用共享的离散 token (Finite Discrete Tokens, FDT) 来作为统一粒度的多模态表征,从而加强图片-文本模型的语义对齐。对比 VQ 等传统方法,整个 FDT 模型是端到端可训练的,单模态 transformer 学习到的特征可通过 FDT 及交叉注意力机制得到更好的对齐,同时 FDT 从损失函数中学到好的语义信息表达。我们在图像分类和图文检索的多个数据集的实验表明,FDT 可以改进传统多模态方法(CLIP, DeCLIP)的语义对齐问题,并得到更加精确的可视化结果。

arXiv:

https://arxiv.org/abs/2303.14865

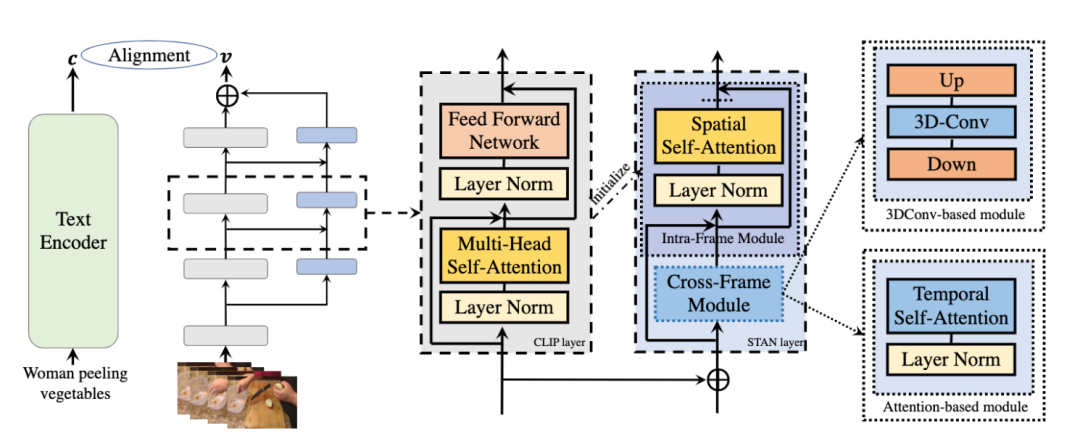

STAN:CLIP 图文预训练模型知识中的时序建模

Revisiting Temporal Modeling for CLIP-based Image-to-Video Knowledge Transferring

这项工作由字节跳动智能创作团队和北京大学团队共同完成。

以 CLIP 为代表的图像-文本预训练模型得益于从大规模图像-文本数据对中所学习到的图文多模态通用知识,在各类图像视觉任务中都取得了优越的性能。这些宝贵的跨模态知识是能够迁移至视频-文本领域的,并对于提升视频领域的视觉表征学习有着极大的潜在价值。为了实现图文模型的迁移,如何赋予图文模型在处理视频数据时所需的时空建模能力是其中关键的一环。

通过对过往图文模型迁移算法中时空建模方法的回顾和研究,本工作提出了一种新的旁枝结构并以此为基础构建了时空辅助网络(STAN)用于强化 CLIP 模型的时空建模能力。这种时空建模机制在不破坏图文预训练模型的高层语义知识的情况下同时利用好模型的低层视觉模式知识,从而在高层语义主导任务(如检索)和低级视觉模式主导任务(如识别)上均取得了显著的性能增益。

通过一系列视频理解下游任务上的效果评估,此方法在 DiDeMo、MSRVTT 和 LSMDC 三个文本-视频检索任务上的 finetune performance 取得了同等模型规模下最佳的性能表现;并在 Kinetics-400 和 Something-Something-v2 两个视频行为识别 benchmark 上也达到了新的 state-of-the-art.

arXiv:

https://arxiv.org/pdf/2301.11116.pdf

Github:

https://github.com/farewellthree/STAN

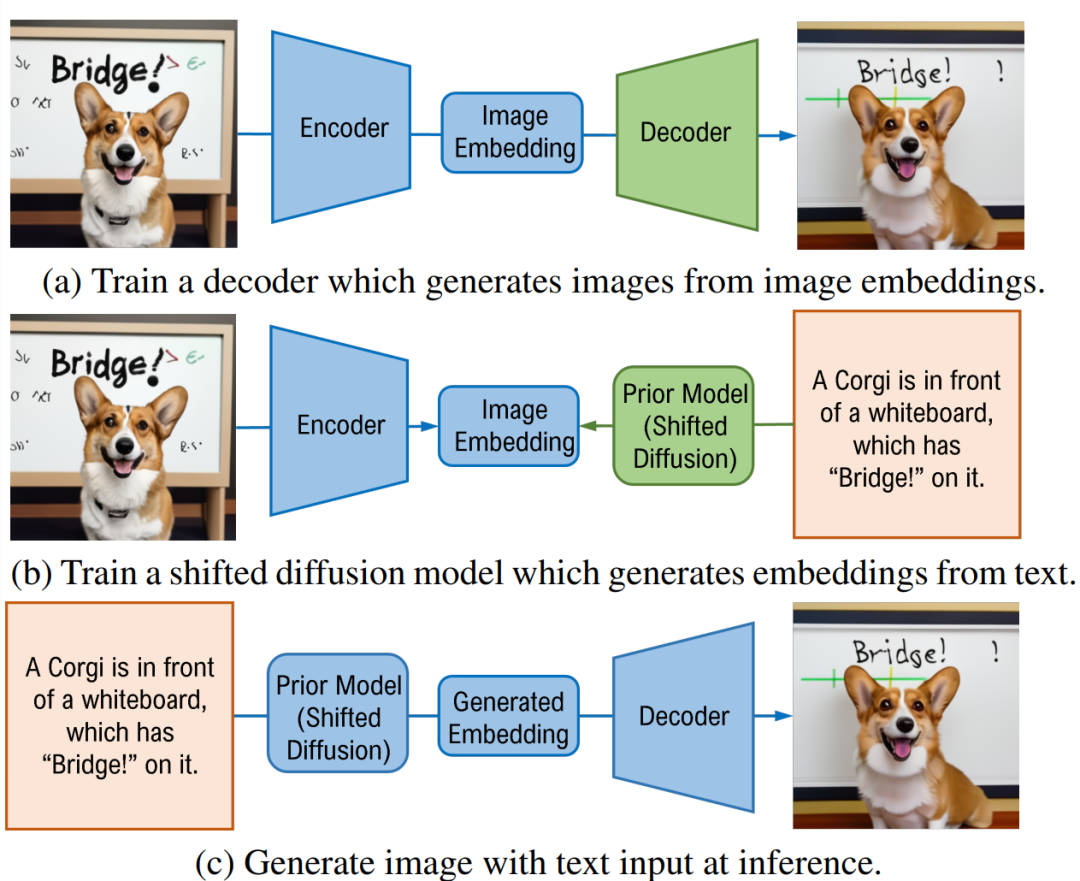

偏移扩散模型在文本生成图像的应用

Shifted Diffusion for Text-to-image Generation

本篇论文由字节跳动智能创作团队和纽约州立大学布法罗分校共同完成。文章提出了偏移扩散模型(Shifted Diffusion)并探讨了其在文本生成图像(Text-to-image Generation)任务上的应用。

本篇论文提出了一个全新的扩散模型,能够从文本数据推断与文本配对的、未知图像的嵌入特征(Image Embedding)。和此前的工作(DALL-E 2)相比,本文提出的偏移扩散模型从多模态预训练模型CLIP的模态差异(Modality Gap)出发,能够更有效率地生成更高质量的图像嵌入特征。当将生成的嵌入特征应用在下游的文本生成图像模型上时,我们能够得到图片质量以及准确性上的提升。

除此之外,利用偏移扩散模型,作者提出了在缺少文本数据的情况下训练或微调文字生成图像模型的新方法。和需要文本-图像配对数据集的方法不同,本文的方法可以在只有下游图像数据的情况下训练或微调文字生成图像模型。利用预训练的偏移扩散模型,我们能够节省构造下游高质量数据集的时间和金钱成本。作者在实验中取得了相同条件下最优的结果,大幅超越了先前的工作(LAFITE)。

arxiv:

https://arxiv.org/abs/2211.15388

github:

https://github.com/drboog/Shifted_Diffusion

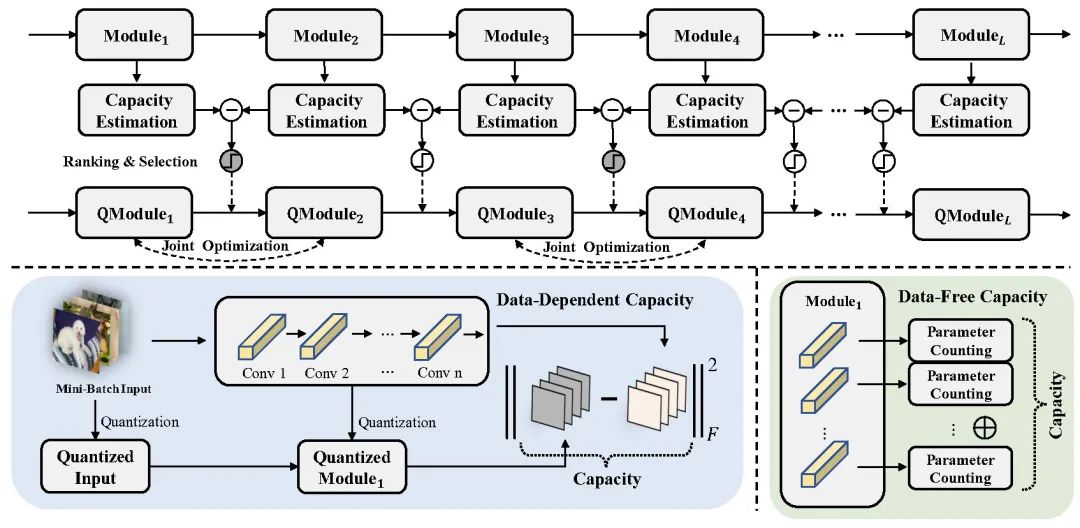

从理论角度解决后训练量化的振荡问题

Solving Oscillation Problem in Post-Training Quantization Through a Theoretical Perspective

这篇工作由字节跳动智能创作团队和厦门大学共同完成。

这篇论文首次发现了以往后训练量化算法中一致存在的振荡问题。论文通过一系列理论分析发现这种震荡现象与相邻模块能力的差异有关。作者随机采样了大量重构方案,通过 PTQ 算法得到重构方案精度并且观察到震荡程度与后训练量化精度呈相关关系。

作者提出了混合重构粒度算法 MRECG。通过估计相邻模块的能力差异,排序并选择 Top-k 差异较大的邻接模块在量化过程中进行联合优化来抹平这种振荡。此外,作者在有数据和无数据两种场景分别提供了基于 loss 和基于 ModCap 指标的两种模块能力估计方式。

在抹平震荡的同时,MRECG 在不同模型广泛的比特配置下取得了后训练量化的 SOTA 性能。特别的,在小模型或低比特的配置下,重构损失震荡的更加剧烈。与此同时,作者团队的算法在抹平这种振荡的同时带来了明显的精度收益(3-6% 精度提升)。

arXiv:

https://arxiv.org/abs/2303.11906

code:

https://github.com/bytedance/MRECG

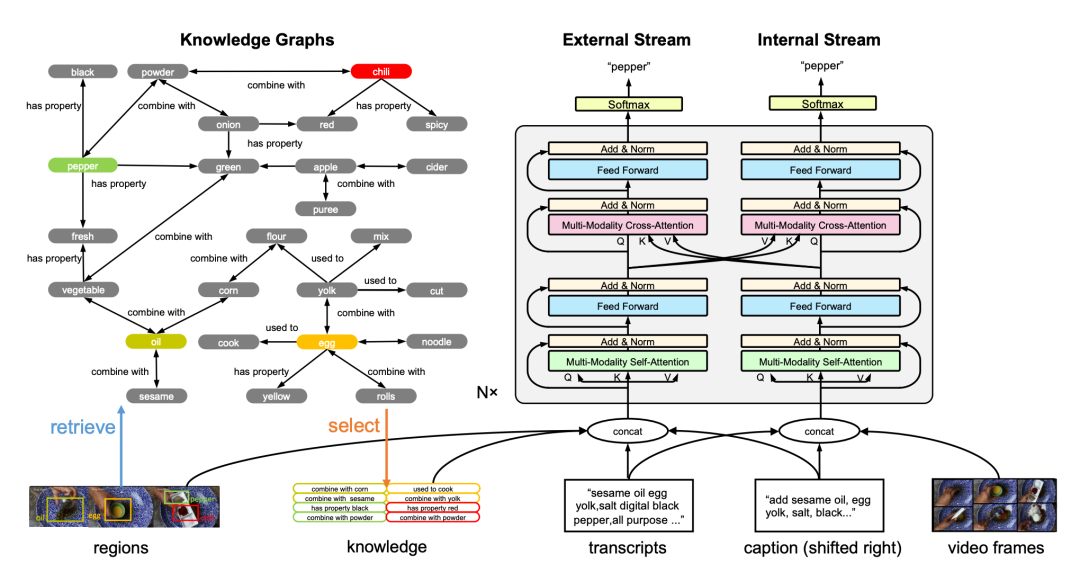

用文本信息和知识图谱来辅助 Transformer 做视频描述任务

Text with Knowledge Graph Augmented Transformer for Video Captioning

这篇工作由字节跳动和中科院合作完成。

视频描述任务的目的是用自然语言来描述视频内容。虽然近年来该任务进展显著,然而因为长尾词等难题,在现实世界的应用中仍有很大的提高空间。

在这篇工作中我们提出了 TextKG,它是利用文本信息和知识图谱来扩充 transformer 以用于视频描述的方法。TextKG 是一个由外部流和内部流组成的双流 transformer。外部流为额外的知识(例如预先构建的知识图谱等)和视频内部信息(例如显著物体区域、语音台词、视频描述)之间的交互做了建模,用于抽取额外的知识来缓解长尾词难题。而内部流用于利用视频的多模态信息(例如视频的外观、语音台词、视频描述等)来确保最终描述结果的质量。此外两个流之间还用交叉关注机制来共享信息。通过这种方式,两个流可以互相帮助以获得更准确的结果。

我们在四个视频描述数据集上进行的大量实验表明,本篇工作所提出的 TextKG 性能优于 SOTA,特别是在 YouCook2 数据集上将 CIDEr 分数提高了 18.7%。

arXiv:

https://arxiv.org/pdf/2303.12423.pdf

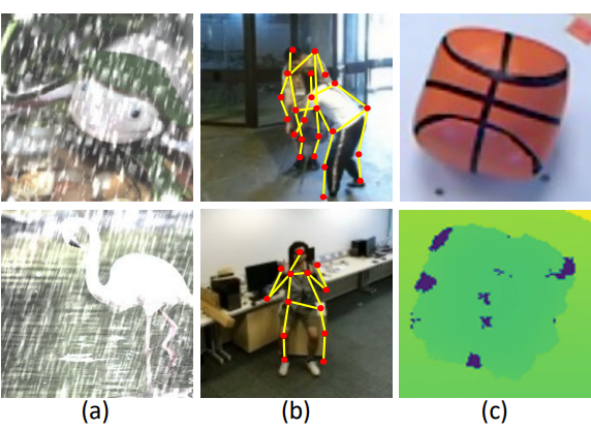

基于强化 Token 的自注意力网络的鲁棒自监督预训练

Token Boosting for Robust Self-Supervised Visual Transformer Pre-training

这篇工作由字节跳动商业化技术团队与新加坡科技与设计大学合作完成。

文章提出了在一种通过增强自注意力网络(Transformer)中 Token 表征能力从而使得自注意力网络在预训练的过程中可以有效的对抗输入数据的噪声, 从而提升在下游任务中自注意力网络的表现。

近些年来,基于自监督训练的自注意力网络(Transformer)在很多领域取得了很好的表现,这得益于大量标记数据的预训练。自注意力网络通过自监督学习,重构被掩码的(masking)部分,使得自身可以提取具备丰富语义信息的特征。然而在现实世界的应用场景中,自注意力网络的输入数据往往包含各种类型的噪声(如下图所示),进而导致输入数据的不可靠,影响自监督预训练的效果。

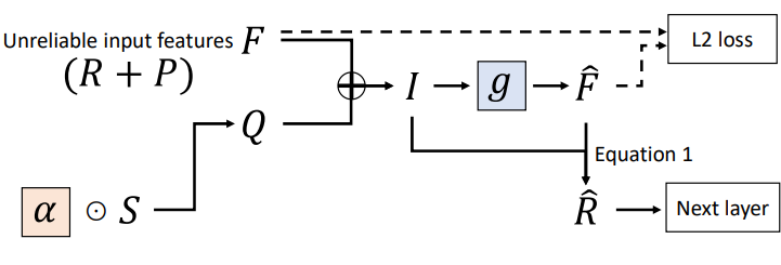

因此在本文中,作者团队提出通过强化自注意力网络中 Token 的表征能力,使得自注意力网络在面对不可靠的噪声输入数据时仍然能够自动适应,学习到更为鲁棒的特征。值得注意的是,在自监督预训练的过程中,我们无需利用无噪声的数据来指导网络的学习。通过理论推导我们得出结论,在仅依靠噪声数据的情况下,我们的方法依然可以提取相对鲁棒的特征,从而提升自注意力网络在噪声数据上的表现。

在本文中,作者为自注意力网络提出了 Token 强化模块 TBM(Token Boosting Module)。该模块由一个小型的自编码器网络 g 以及可学习参数 α 构成,可以将之放置在任意自注意力网络模块后。该自编码器网络的输入特征由两部分 F、Q 构成。F 表示前级网络输出的含噪特征,Q 表示可控噪声(由 α 调节),两者相加构成输入特征。输入特征 I 送入自编码器网络 g 进行重构,得到的重构特征 F^ 经由公式(1)的计算得到模块输出 R^ 并送入自注意力网络的下一层。作者在文中进行了相应的理论推导得出结论,经过 TBM 的处理,模块的输出特征在保留表征能力的基础上具备了对噪声输入的鲁棒性,并进行了详尽的实验验证。

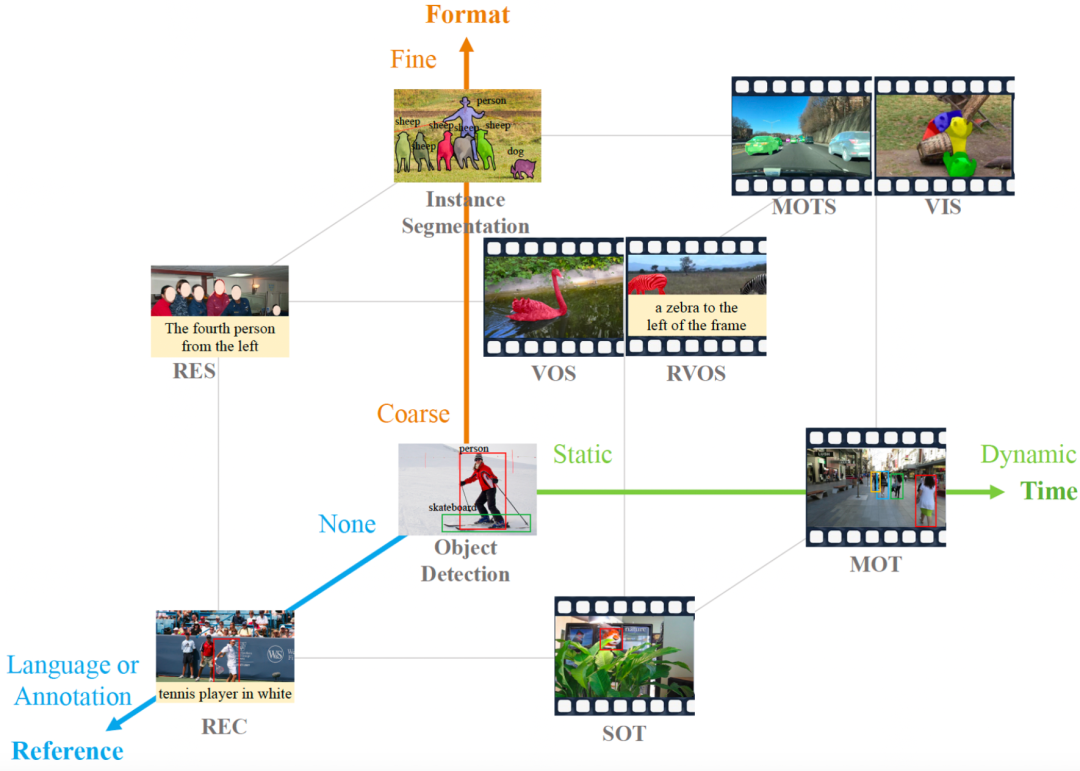

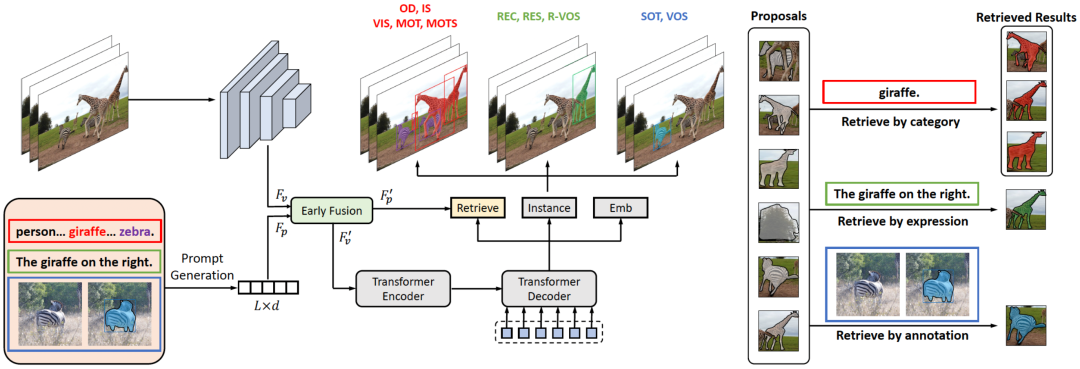

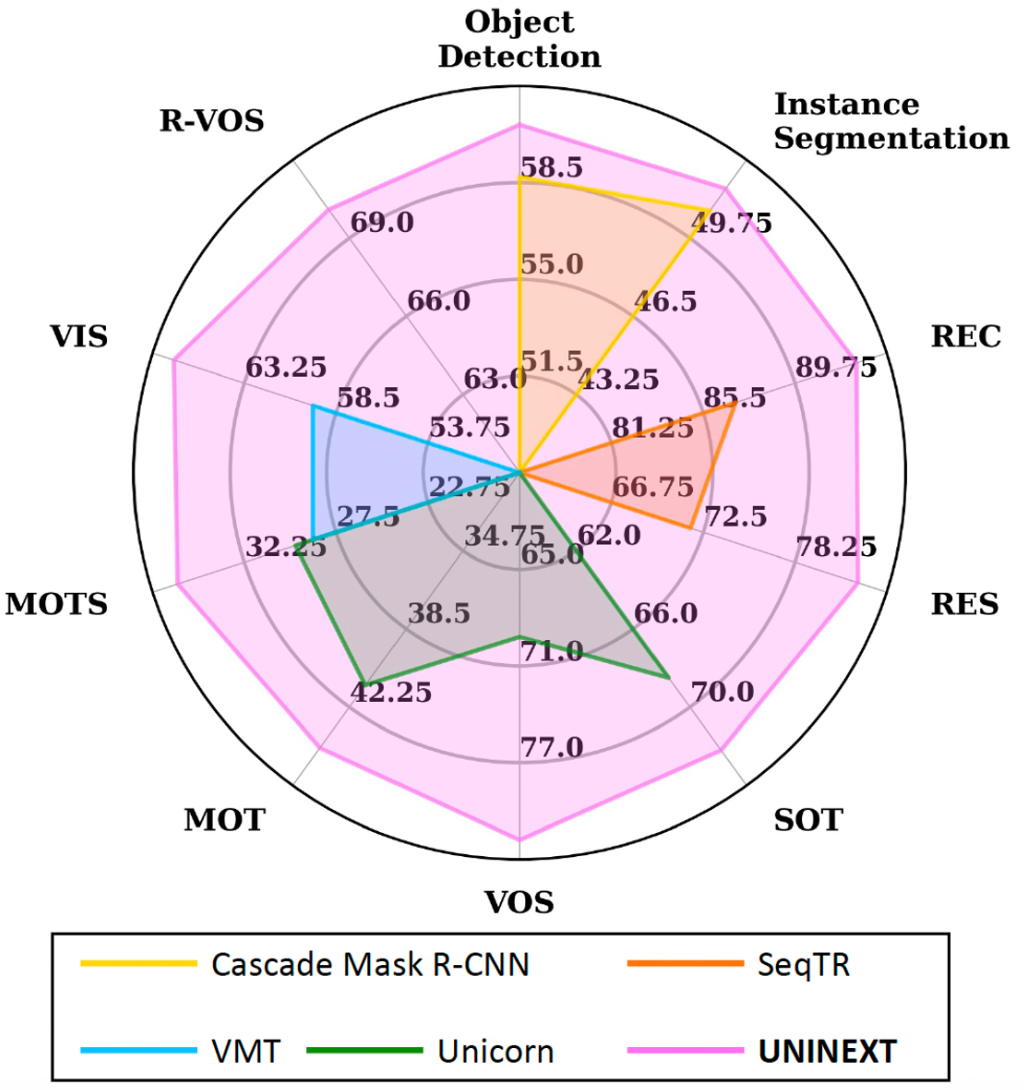

UNINEXT: 基于目标检测和检索的统一实例感知框架

Universal Instance Perception as Object Discovery and Retrieval

这篇工作由字节跳动商业化技术团队与大连理工大学、香港大学合作完成。

文章将 10 项常见的实例感知任务统一成了一种提示词引导的物体发现与检索范式,并训练了一个统一模型在来自 10 项任务的 20 个富有挑战性的数据集上取得了优异的性能。

常见的 10 项实例感知任务本质上都是要找到具有特定属性的实例。然而,当前大多数实例感知方法都是为单一或者部分子任务设计,并且只在特定任务的数据上训练的。这一分裂的设计理念带来了以下缺点:

(1)不同任务上学习到的知识难以共享,导致学习到的表征的泛化能力不足且参数冗余

(2)忽视了不同任务之间相互帮助的可能性。

本文中,作者团队提出了 UNINEXT:下一代通用实例感知模型。UNINEXT 将 10 项实例感知任务统一成了一种提示词引导的物体发现与检索范式。具体来说,在提示词的引导下,UNINEXT 首先发现 N 个物体,之后根据实例-提示匹配度分数检索出最终的实例预测结果。基于这一统一的建模方式,通过改变输入的提示词(例如类别名称,语言描述,物体标注),UNINEXT 即可灵活地感知不同属性的实例。

基于这一统一的模型结构,UNINEXT 可以从来自 10 项任务的大量数据中学习通用的物体表示,并用一个模型一套参数同时解决 10 项实例感知任务。大量的实验表明,UNINEXT 在 20 个富有挑战性的数据集上取得了优异的性能。

arXiv:

https://arxiv.org/abs/2303.06674

code:

https://github.com/MasterBin-IIAU/UNINEXT

![[ROC-RK3568-PC] [Firefly-Android] 10min带你了解Camera的使用](https://img-blog.csdnimg.cn/bab327e98da44a5d9f771d59909d698d.png)