目录

目录

一.安装包准备:

二.解压安装:

先将该安装包放入到/opt/install目录:

解压该文件到soft目录中:

改名,方便后续使用:

三修改其中配置和配置环境变量:

3.1 修改/opt/soft/kafka212/config/server.properties文件:

3.2 对其中进行配置(set nu之后修改,前面数字表示的行数):

创建一下data目录:

写入myid:

3.3 修改/etc/profile环境变量

更新后记得soure一下环境变量

四.启动kafka测试:

4.1 启动zkServer服务

4.2 启动命令:

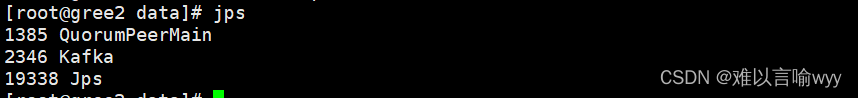

查看启动的线程:jps

4.3关闭命令:

五.kafka基本使用命令:

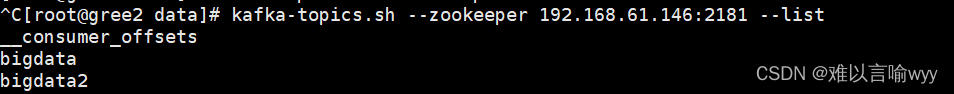

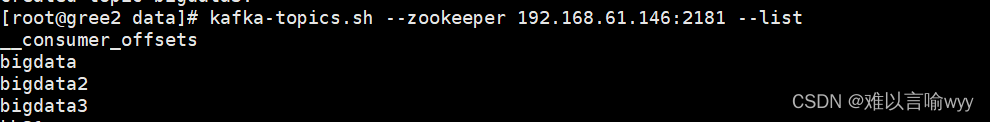

查看消息队列:

创建消息队列:

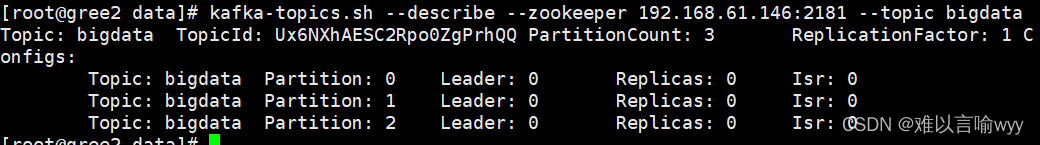

编辑 查看队列详情:

生产消息:

消费消息:

查询指定对列消息数量

一.安装包准备:

链接:https://pan.baidu.com/s/1z-rDoGbfVhY5mclgUItlPA?pwd=v0af

提取码:v0af

--来自百度网盘超级会员V5的分享

二.解压安装:

先将该安装包放入到/opt/install目录:

解压该文件到soft目录中:

tar zxf kafka_2.12-2.8.0.tgz -C /opt/soft/

改名,方便后续使用:

mv kafka_2.12-2.8.0/ kafka212

三修改其中配置和配置环境变量:

3.1 修改/opt/soft/kafka212/config/server.properties文件:

vim ./server.properties

3.2 对其中进行配置(set nu之后修改,前面数字表示的行数):

21 broker.id=0

36 advertised.listeners=PLAINTEXT://192.168.61.146:9092

60 log.dirs=/opt/soft/kafka212/data 消息存放目录

103 log.retention.hours=1680 消息存放时间小时

123 zookeeper.connect=192.168.61.146:2181 连接zookeeper

137 delete.topic.enable=true 设置可以对topic删除,默认不能删除

创建一下data目录:

mkdir /opt/soft/kafka212/data

写入myid:

echo "0">/opt/soft/kafka212/data/myid

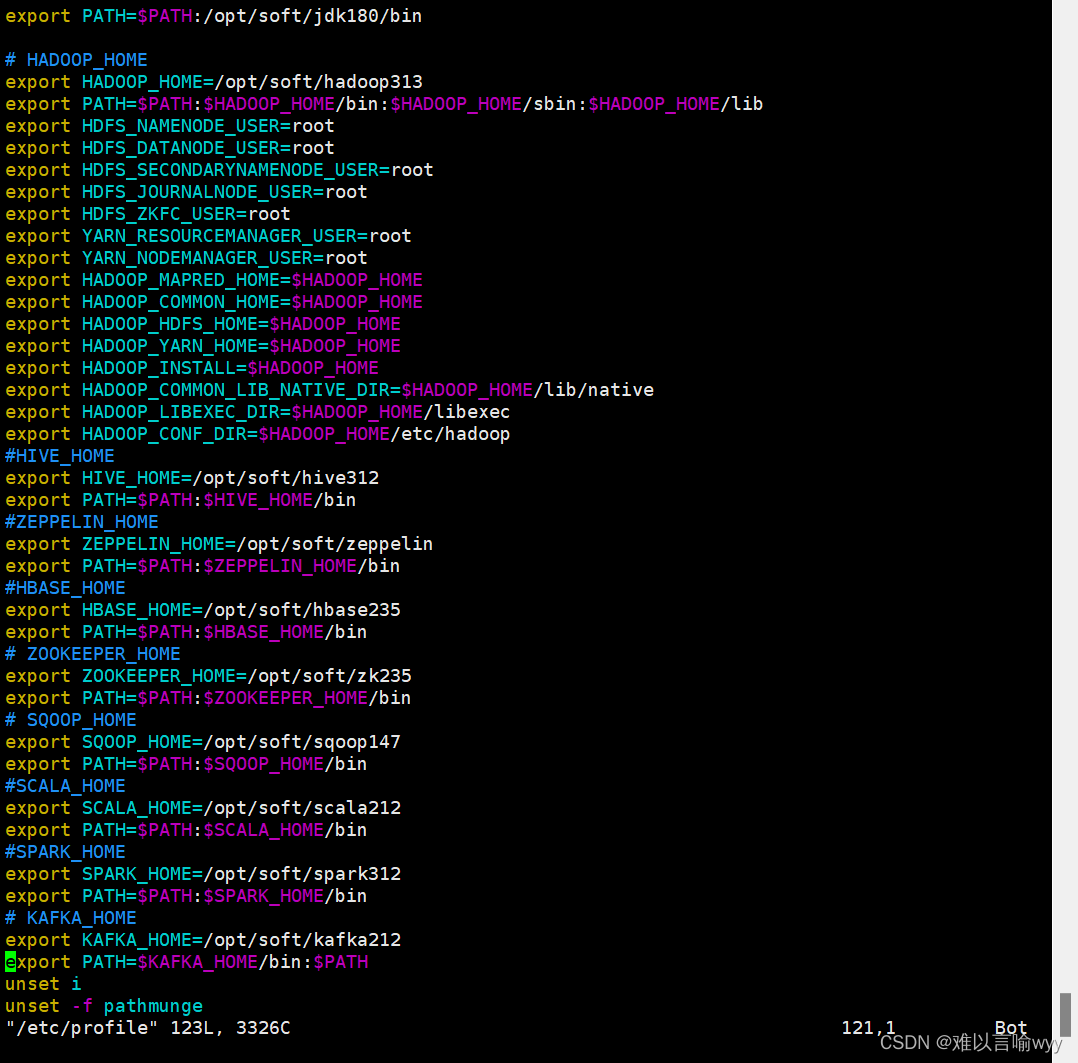

3.3 修改/etc/profile环境变量

# KAFKA_HOME

export KAFKA_HOME=/opt/soft/kafka212

export PATH=$KAFKA_HOME/bin:$PATH

更新后记得soure一下环境变量

source /etc/profile

四.启动kafka测试:

4.1 启动zkServer服务

zkServer.sh start

zkServer.sh status

4.2 启动命令:

kafka-server-start.sh /opt/soft/kafka212/config/server.properties //该命令会使kafka占用一个虚拟机的线程

kafka-server-start.sh -daemon /opt/soft/kafka212/config/server.properties

nohup kafka-server-start.sh /opt/soft/kafka212/config/server.properties & //后台启动kafka,不会占用线程

查看启动的线程:jps

4.3关闭命令:

kafka-server-stop.sh

五.kafka基本使用命令:

查看消息队列:

kafka-topics.sh --zookeeper 192.168.61.146:2181 --list

创建消息队列:

kafka-topics.sh --create --zookeeper 192.168.61.146:2181 --topic kb21 --partitions 1 --replication-factor 1 //可修改副本和副本

查看队列详情:

查看队列详情:

kafka-topics.sh --describe --zookeeper 192.168.61.146:2181 --topic bigdata

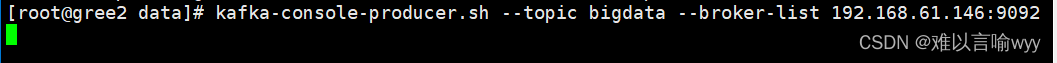

生产消息:

kafka-console-producer.sh --topic bigdata --broker-list 192.168.61.146:9092

消费消息:

kafka-console-consumer.sh --bootstrap-server 192.168.61.146:9092 --topic bigdata

//开启之后可以同步生产消息的输入

kafka-console-consumer.sh --bootstrap-server 192.168.61.146:9092 --topic bigdata --from-beginning//可以查看存入kafka里面的所有数据

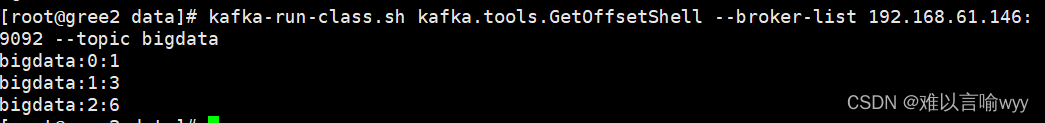

查询指定对列消息数量:

kafka-run-class.sh kafka.tools.GetOffsetShell --broker-list 192.168.61.146:9092 --topic bigdata