wei集群安装结果说明

| 实例 | 配置 | 安装软件 | 安装账号 |

| hadoop1 | 2C4G 磁盘:50G 云服务器 | elasticsearch kibana | rd |

| hadoop2 | 2C4G 磁盘:50G 云服务器 | elasticsearch | rd |

| hadoop3 | 2C4G 磁盘:50G 云服务器 | elasticsearch | rd |

整个安装过程使用的账号:root、rd(自己新建的账号)

安装包下载:

下载包中包含es filebeat kibana ik等相关软件

链接:百度网盘 请输入提取码

提取码:75cT

安装基础软件

- 安装jdk,并且配置环境变量,可参考:JDK下载安装-Linux-2022年05月03日_jdk下载linux_消逝的bug的博客-CSDN博客

- 新建普通账号,因为es不允许使用root账号,可参考:Linux账号普通账号新建与授权_消逝的bug的博客-CSDN博客

- 配置免密登录,可参考:Linux免密登录_linux的免密登录_消逝的bug的博客-CSDN博客

一、修改Linux文件描述符

1.1 激活limits模块

切换到root账号:sudo -i

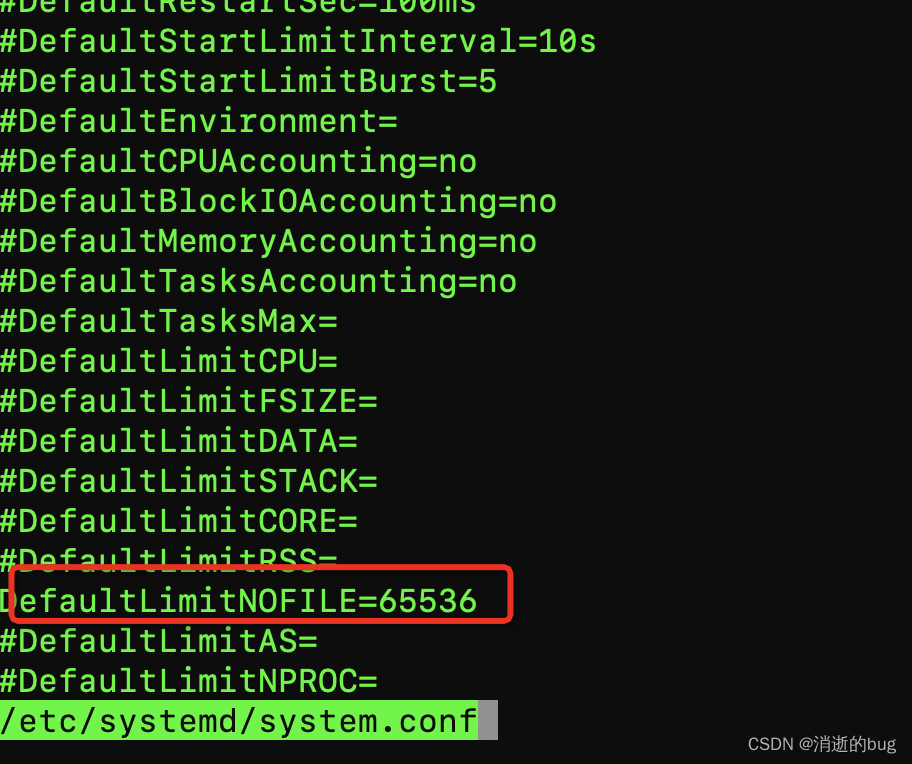

编辑:vi /etc/systemd/system.conf

找到#DefaultLimitNOFILE=,删除#(即取消注释)并设置DefaultLimitNOFILE=65536

1.2 修改limits.conf

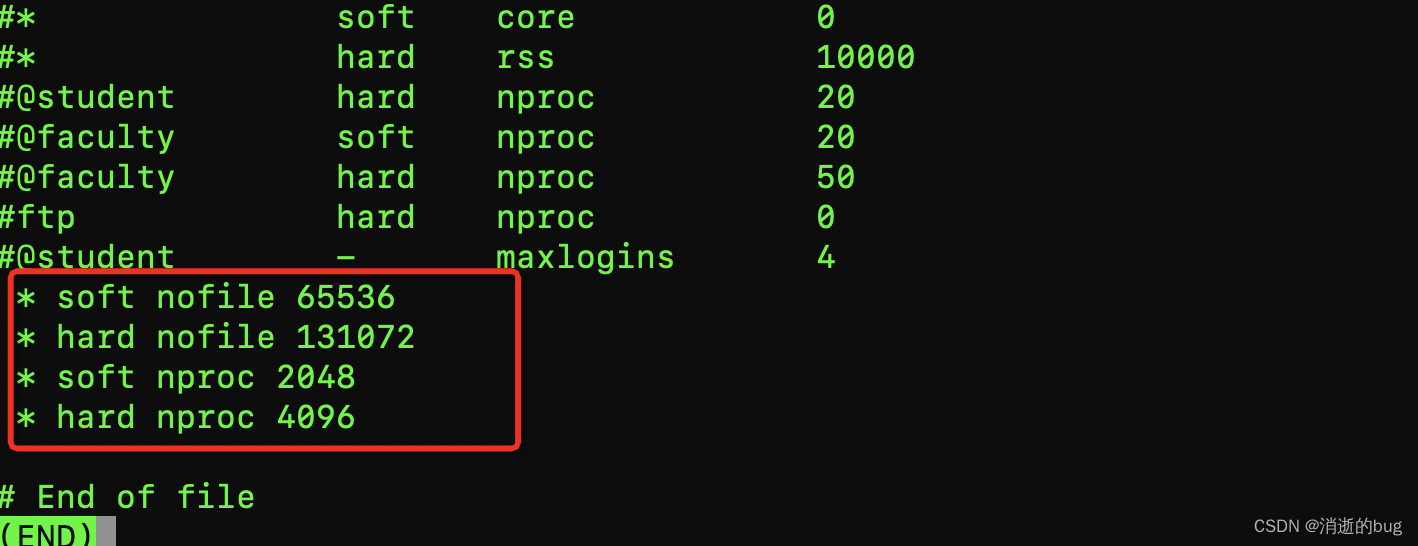

切换到root账户:sudo -i

vi /etc/security/limits.conf

在文件的最后追加:

* soft nofile 65536

* hard nofile 131072

* soft nproc 2048

* hard nproc 4096

注意:前面需要带着*

注:第二步我不是很确定是否需要配置,因为我是先配置的第二步,因为无法解决问题,后来又配置的第一步内容;

为保证可以生效,我执行了重启服务;

二、配置并分发es

当前步骤切换至非root账号;

根据我提供的es安装包下载至自己的服务器:elasticsearch-7.6.1-linux-x86_64.tar

解压:

cd /home/rd/soft

解压:

tar -zxvf kibana-7.6.1-linux-x86_64.tar.gz

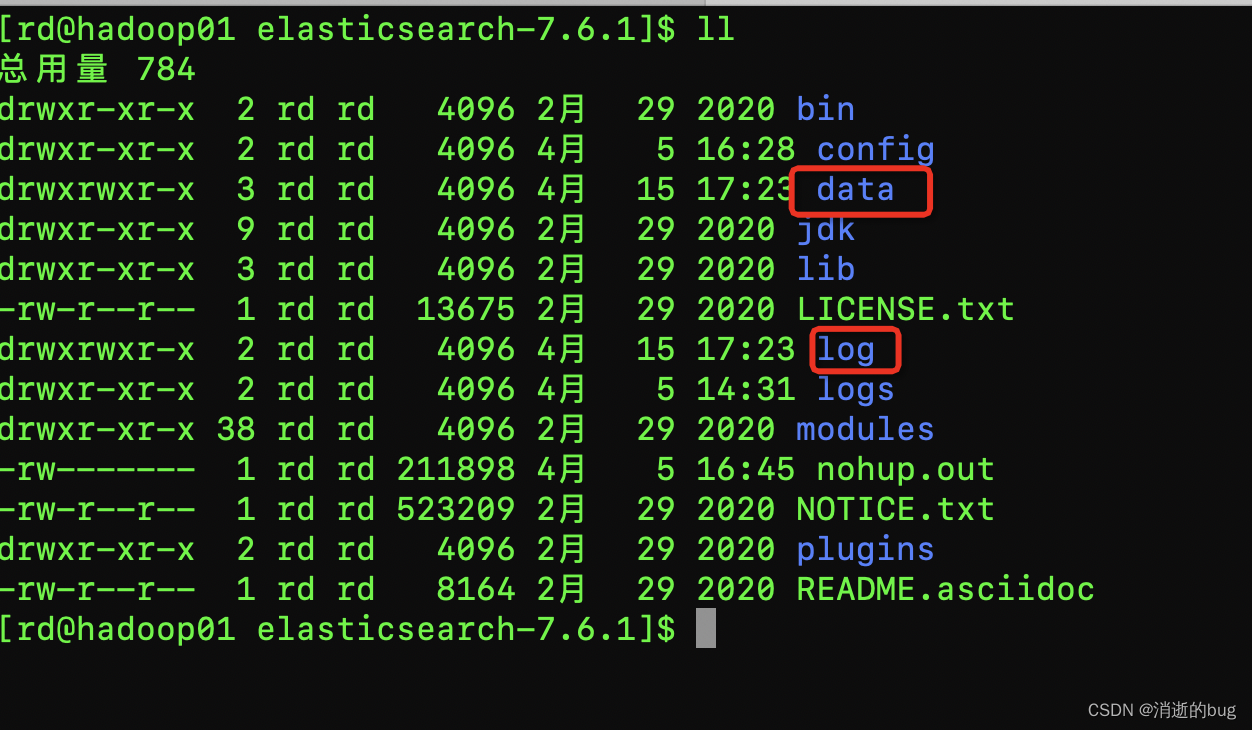

进入es目录:cd /home/rd/soft/elasticsearch-7.6.1新建目录:

cd /home/rd/soft/elasticsearch-7.6.1

新建data目录:mkdir data

新建log目录:mkdir log

2.1配置es

机器配置:由于 elasticsearch 默认分配 jvm空间大小为2g,修改 jvm空间,如果Linux服务器本来配置就很高,可以不用修改。

cd /home/rd/soft/elasticsearch-7.6.1/config

vi elasticsearch.yml# 集群名称:相同名称属于同一个集群

cluster.name: es-rd

# 节点名称:我配置了node1 node2 node3三台机器,每台机器的node.name不一样

node.name: node1

# 数据目录

path.data: /home/rd/soft/elasticsearch-7.6.1/data

# 日志目录

path.logs: /home/rd/soft/elasticsearch-7.6.1/log

# Set the bind address to a specific IP (IPv4 or IPv6):

# 配置为0.0.0.0 可以允许所有ip访问当前服务

network.host: 0.0.0.0

# es机器的访问端口

http.port: 9200

# 当前集群的实例对应的全部机器ip,不确定是否可以使用域名

discovery.seed_hosts: ["192.168.1.18","192.168.1.248","192.168.1.137"]

# 指定集群中全部有资格成为主节点的node名称

cluster.initial_master_nodes: ["node1","node2","node3"]2.2分发至全部机器

因为3台机器都需要类似的es配置,我先将安装包复制到其他机器上,然后再当已经配置完整的配置传输至其他机器,然后再定制化修改内容

传输es压缩包

scp /home/rd/soft/elasticsearch-7.6.1-linux-x86_64.tar.gz hadoop02:/home/rd/soft

传输配置文件

scp /home/rd/soft/elasticsearch-7.6.1/config/elasticsearch.yml hadoop02:/home/rd/soft/elasticsearch-7.6.1/config2.3 启动es

后台进程启动es:

nohup /home/rd/soft/elasticsearch-7.6.1/bin/elasticsearch &访问:

访问:http://hadoop01:9200/

响应:

{

"name" : "node1",

"cluster_name" : "es-rd",

"cluster_uuid" : "66VN20lxS0-WETsp-AfcZQ",

"version" : {

"number" : "7.6.1",

"build_flavor" : "default",

"build_type" : "tar",

"build_hash" : "aa751e09be0a5072e8570670309b1f12348f023b",

"build_date" : "2020-02-29T00:15:25.529771Z",

"build_snapshot" : false,

"lucene_version" : "8.4.0",

"minimum_wire_compatibility_version" : "6.8.0",

"minimum_index_compatibility_version" : "6.0.0-beta1"

},

"tagline" : "You Know, for Search"

}三、安装kibana

根据我提供的下载包,找到kibana,修改配置、启动

3.1 创建日志目录

mkdir /home/rd/soft/kibana-7.6.1-linux-x86_64/logs3.2 修改配置

#修改配置文件

/home/rd/soft/kibana-7.6.1-linux-x86_64/config/kibana.yml

# kibana访问的端口

server.port: 5601

# 允许访问的外部ip,0.0.0.0允许全部ip

server.host: "0.0.0.0"

# es集群的地址

elasticsearch.hosts: ["http://hadoop01:9200"]

# kibana日志路径

logging.dest: /home/rd/soft/kibana-7.6.1-linux-x86_64/logs/kibana.log

# 访问es账户密码

elasticsearch.username: "kibana"

elasticsearch.password: "pass"

# 据说是汉化的

i18n.locale: "zh-CN"

3.3 启动kibana

nohup /home/rd/soft/kibana-7.6.1-linux-x86_64/bin/kibana &四、安装分词器-ik

从安装包中下载ik,在es的安装目录下的plugins下创建ik目录,然后将ik复制到ik目录下

cp /home/rd/soft/essoft/ik/elasticsearch-analysis-ik-7.6.1.zip /home/rd/soft/elasticsearch-7.6.1/plugins/ik

cd /home/rd/soft/elasticsearch-7.6.1/plugins/ik

解压:

unzip elasticsearch-analysis-ik-7.6.1.zip安装ik之后,重启elastic就可以正常使用了;