文章目录

- Spark Yarn 运行环境搭建

- 1、解压缩文件

- 2、修改配置环境文件

- 3、配置历史服务器

Spark Yarn 运行环境搭建

1、解压缩文件

将spark3.2.3的压缩包上传到 linux /opt/software 目录下

输入命令: tar -zxvf spark-3.2.3-bin-hadoop3.2-scala2.13.tgz -C /opt/ 解压到opt目录下

输入命令: mv spark-3.2.3-bin-hadoop3.2-scala2.13/ spark 改名为spark

2、修改配置环境文件

1、修改 hadoop 配置文件/opt/hadoop/etc/hadoop/yarn-site.xml, 并分发

输入命令:vim /opt/hadoop-3.1.3/etc/hadoop/yarn-site.xml

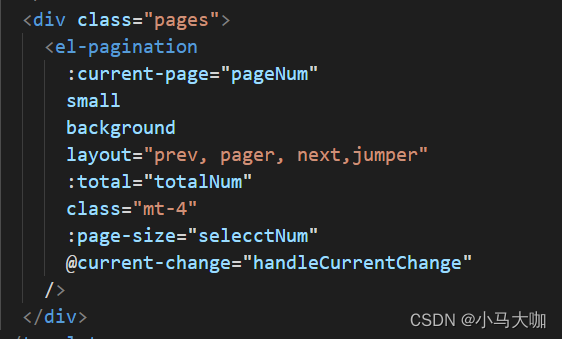

2、修改 conf/spark-env.sh,添加 JAVA_HOME 和YARN_CONF_DIR 配置

输入命令:mv spark-env.sh.template spark-env.sh 把这个文件后缀名改一下

输入命令: vim spark-env.sh 添加下面的配置

3、启动 HDFS 以及 YARN 集群

3、配置历史服务器

1、修改 spark-defaults.conf.template 文件名为 spark-defaults.conf

输入命令:mv spark-defaults.conf.template spark-defaults.conf

2、修改 spark-default.conf 文件,配置日志存储路径

输入命令: vim spark-defaults.conf 添加以下配置

注意:需要启动 hadoop 集群,HDFS 上的目录需要提前存在。

3、修改 spark-env.sh 文件, 添加日志配置

export SPARK_HISTORY_OPTS="

-Dspark.history.ui.port=18080

-Dspark.history.fs.logDirectory=hdfs://hadoop102:9870/directory

-Dspark.history.retainedApplications=30"

参数说明:

⚫参数 1 含义:WEB UI 访问的端口号为 18080

⚫参数 2 含义:指定历史服务器日志存储路径

⚫参数 3 含义:指定保存Application 历史记录的个数,如果超过这个值,旧的应用程序信息将被删除,这个是内存中的应用数,而不是页面上显示的应用数。

4、修改 spark-defaults.conf

输入命令: vim spark-defaults.conf 添加以下配置

spark.yarn.historyServer.address=hadoop102:18080

spark.history.ui.port=18080

5、启动历史服务

输入命令: /opt/spark/sbin/start-history-server.sh