【NLP相关】XLNET原理以及案例

XLNET模型是自然语言处理领域中最近新兴的模型之一,其创新之处在于引入了Transformer XL机制,进一步扩展了Transformer模型的能力。在本文中,我们将介绍XLNET模型的基本原理,其提出和发展的历程,以及关于XLNET的应用和研究进展。

1. Transformer XL机制

在介绍XLNET模型的基本原理之前,我们首先需要了解一下Transformer XL机制。Transformer XL是Transformer模型的扩展版本,其中引入了一种称为“相对位置编码”的机制,以解决Transformer模型中存在的位置信息限制问题。

在传统的Transformer模型中,输入序列的位置信息只能通过固定的位置编码进行表示。这种方式存在两个问题:一是无法表示较长的序列,因为固定的位置编码无法区分不同位置的单词;二是无法捕捉序列中不同单词之间的关系。

相对位置编码机制则通过动态地对输入序列的相对位置进行编码,解决了上述问题。具体来说,相对位置编码机制将序列中任意两个单词之间的相对位置表示为一个向量,从而捕捉到单词之间的关系。

2. XLNET原理

XLNET模型是由CMU和谷歌公司联合提出的。该模型的创新之处在于,它将Transformer XL机制与自回归和非自回归两种语言模型相结合,进一步扩展了Transformer模型的能力。

XLNET模型包括两个部分:自回归部分和非自回归部分。自回归部分采用了Transformer XL机制,并且在每个时间步骤中都采样一个单词作为输出。非自回归部分则是对整个序列进行建模,不需要按时间步骤进行采样。

XLNET模型的关键在于如何将自回归和非自回归两种模型相结合。具体来说,XLNET模型使用了一个permutation-based语言模型,通过随机采样的方式对序列进行重组,并在每个重组序列上训练模型。这种方法能够让模型学习到更加全面的上下文信息,进一步提高了模型的性能。

3. 案例展示

在这个案例中,我们将使用XLNET模型对一个文本分类任务进行建模。具体来说,我们将使用IMDB电影评论数据集,该数据集包括50,000条电影评论,其中25,000条用于训练,25,000条用于测试。

首先,我们需要下载IMDB数据集,可以使用以下命令进行下载:

wget https://ai.stanford.edu/~amaas/data/sentiment/aclImdb_v1.tar.gz

tar -xf aclImdb_v1.tar.gz

然后,我们需要使用XLNET模型对数据集进行建模。在这个案例中,我们使用Hugging Face的Transformers库来实现XLNET模型。具体来说,我们将使用预训练的XLNET模型作为特征提取器,并在顶部添加一个全连接层作为分类器。

以下是使用XLNET模型进行文本分类的代码:

import torch

from transformers import XLNetTokenizer, XLNetForSequenceClassification

from transformers import AdamW

# Load XLNET tokenizer and model

tokenizer = XLNetTokenizer.from_pretrained('xlnet-base-cased')

model = XLNetForSequenceClassification.from_pretrained('xlnet-base-cased')

# Load data

train_texts = [open('aclImdb/train/pos/'+f, 'r').read() for f in os.listdir('aclImdb/train/pos/')] + \

[open('aclImdb/train/neg/'+f, 'r').read() for f in os.listdir('aclImdb/train/neg/')]

train_labels = [1] * 12500 + [0] * 12500

test_texts = [open('aclImdb/test/pos/'+f, 'r').read() for f in os.listdir('aclImdb/test/pos/')] + \

[open('aclImdb/test/neg/'+f, 'r').read() for f in os.listdir('aclImdb/test/neg/')]

test_labels = [1] * 12500 + [0] * 12500

# Tokenize data

train_encodings = tokenizer(train_texts, truncation=True, padding=True)

test_encodings = tokenizer(test_texts, truncation=True,padding=True)

#Convert data to PyTorch tensors

train_dataset = torch.utils.data.TensorDataset(torch.tensor(train_encodings['input_ids']),torch.tensor(train_encodings['attention_mask']),torch.tensor(train_labels))

test_dataset = torch.utils.data.TensorDataset(torch.tensor(test_encodings['input_ids']),torch.tensor(test_encodings['attention_mask']),torch.tensor(test_labels))

# Train model

device = torch.device('cuda') if torch.cuda.is_available() else torch.device('cpu')

model.to(device)

model.train()

optimizer = AdamW(model.parameters(), lr=5e-5)

train_loader = torch.utils.data.DataLoader(train_dataset, batch_size=8, shuffle=True)

for epoch in range(3):

for batch in train_loader:

optimizer.zero_grad()

input_ids = batch[0].to(device)

attention_mask = batch[1].to(device)

labels = batch[2].to(device)

outputs = model(input_ids=input_ids, attention_mask=attention_mask, labels=labels)

loss = outputs.loss

loss.backward()

optimizer.step()

# Test model

model.eval()

test_loader = torch.utils.data.DataLoader(test_dataset, batch_size=8, shuffle=False)

with torch.no_grad():

num_correct = 0

for batch in test_loader:

input_ids = batch[0].to(device)

attention_mask = batch[1].to(device)

labels = batch[2].to(device)

outputs = model(input_ids=input_ids, attention_mask=attention_mask, labels=labels)

logits = outputs.logits

predictions = torch.argmax(logits, dim=1)

num_correct += torch.sum(predictions == labels)

accuracy = num_correct / len(test_dataset)

print('Accuracy:', accuracy.item())

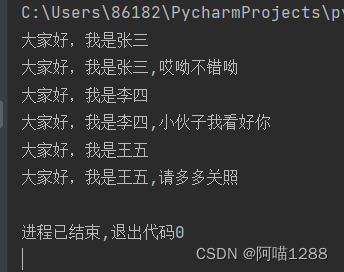

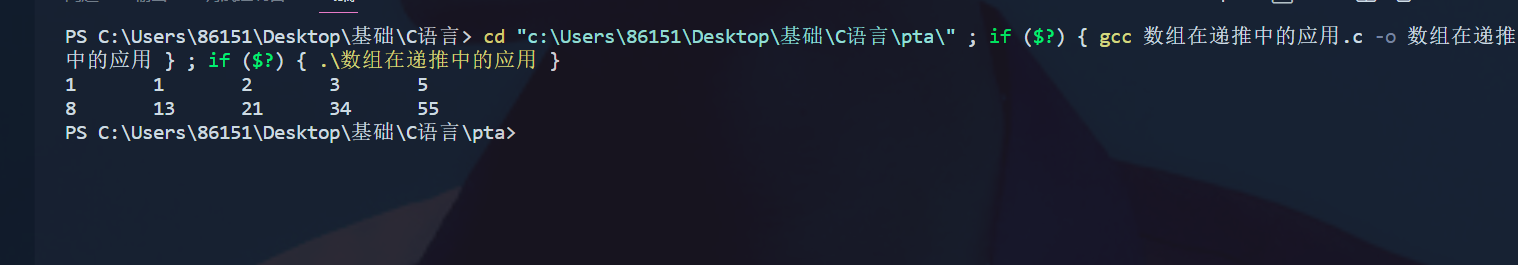

在上面的代码中,我们首先使用XLNET的tokenizer将原始文本转换为XLNET模型所需的输入格式,然后将数据转换为PyTorch张量并加载到数据集中。接下来,我们使用AdamW优化器训练模型,训练完模型后,我们使用模型对测试集进行预测并计算准确率。