【论文速递】EMNLP 2020 - 将事件抽取作为机器阅读理解任务

【论文原文】:Event Extraction as Machine Reading Comprehension

【作者信息】:Jian Liu and Yubo Chen and Kang Liu and Wei Bi and Xiaojiang Liu

论文:https://aclanthology.org/2020.emnlp-main.128.pdf

代码:https://github.com/jianliu-ml/EEasMRC

博主关键词:阅读理解、事件抽取、零样本事件抽取

推荐论文:http://t.csdn.cn/LiC7P、http://t.csdn.cn/S4H6X

摘要

事件抽取(Event extraction, EE)是一项重要的信息抽取任务,旨在抽取文本中的事件信息。以前的EE方法通常将其建模为分类任务,这些任务需要大量数据,并且存在数据稀缺问题。在本文中,我们提出了一种新的EE学习范式,将其明确地转换为机器阅读理解问题(MRC)。我们的方法包括一个无监督的问题生成过程,它可以将事件模式转换为一组自然问题,然后是一个基于BERT的问题回答过程,以检索作为EE结果的答案。这种学习范式使我们能够通过在MRC中引入复杂的模型来加强EE的推理过程,并通过在MRC中引入大规模的数据集来缓解数据稀缺问题。实证结果表明:i)我们的方法比以前的方法获得了最先进的性能。ii)我们的模型在数据稀缺的情况下表现出色,例如,在只有1%的数据抽取事件论元得到49.8%F1,而之前的方法为2.2%的F1。iii)我们的模型也适用于零样本场景,在不使用任何EE训练数据的情况下,在两个数据集上实现了37.0%和16%的F1。

1、简介

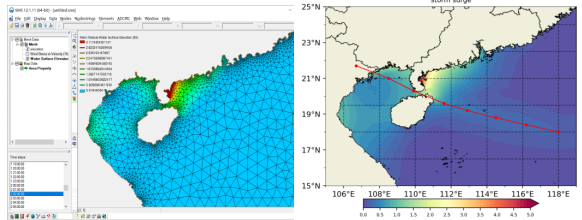

事件抽取(Event extraction, EE)是一项重要的信息抽取任务,旨在抽取文本中的事件信息。例如,在句子S1中(如图1 (a)所示),EE系统应该识别攻击(Attack)事件,该事件由一个事件触发词 stabbed 表示,该事件触发词带有四个事件论元——Sunday (Role=Time)、一个 protester(Role=Attacker)、一个officer(Role=Target)和一个paper cutter(Role=Instrument)。EE被证明有利于广泛的应用,包括知识库增强,文档摘要、问题回答(Berant et al, 2014)等。

在目前的研究中,EE主要被表述为一个分类问题,旨在定位和分类每个事件触发词/论元(Ahn, 2006;Li等,2013;Chen等,2015;Nguyen等人,2016)。尽管有很多进步,但基于分类的方法是数据饥饿的,需要大量的训练数据来确保良好的性能(Chen et al, 2017;Li等,2013;Liu等,2018a)。此外,这种方法通常不能处理训练期间从未遇到的新事件类型(Huang et al, 2018)。

在本研究中,我们引入了一种新的EE学习范式,为同时解决上述问题提供了思路。我们的主要动机是,从本质上讲,EE可以被视为机器阅读理解(MRC)问题(Hermann等人,2015;Chen et al, 2016)涉及文本理解和匹配,旨在发现文本中特定事件的信息。例如,在S1中,对Instrument角色填充符的抽取在语义上等价于以下问答过程(如图1 (b)所示):

Q1:What Instrument did the protester use to stab the officer? A1: a paper cutter.

这意味着解决EE的新方法,这有两个主要优势:首先,通过将EE作为MRC,我们可以利用MRC的最新进展(例如,BERT (Devlin et al, 2019))来增强EE任务,这可能会极大地加强模型中的推理过程。其次,我们可以直接利用丰富的MRC数据集来提高EE,这可能会缓解数据稀缺问题(这被称为跨域数据增强)。第二个优势也为零样本EE打开了一扇门:对于不可见的事件类型,我们可以列出定义其模式的问题,并使用MRC模型来检索作为EE结果的答案,而不是预先为它们获取训练数据。

为了连接MRC和EE,关键的挑战在于生成描述事件方案的相关问题(例如,为Instrument生成Q1)。请注意,我们不能采用有监督的问题生成方法(Duan等人,2017;袁等,2017;Elsahar等人,2018),因为缺乏对齐的问题-事件对。以往连接MRC和其他任务的工作通常采用人工设计的模板(Levy et al, 2017;FitzGerald et al, 2018;Li et al, 2019b,a;Gao等,2019;Wu等人,2019)。例如,在QA-SRL (FitzGerald et al, 2018)中,谓词pbulish的问题始终是“Who published something?”,不管上下文如何。这样的问题可能不足以指示MRC模型找到答案。

我们通过提出一个无监督的问题生成过程来克服上述挑战,该过程可以生成既相关又依赖于上下文的问题。具体来说,在我们的方法中,我们假设每个问题可以分解为两个部分,分别反映查询主题和上下文相关的信息。例如,Q1可以分解为“What instrument”和“did the protester use to stab the officer?”为了生成查询主题表达式,我们设计了一种基于模板的生成方法,结合角色分类和疑问词实现。为了生成更具挑战性的上下文依赖表达式,我们将其制定为无监督翻译任务(Lample等人,2018b)(或风格转移(Prabhumoye等人,2018)),它基于领域内去噪自动编码(Vincent等人,2008)和跨域反向翻译(Sennrich等人,2016)将描述性语句转换为问题风格表达式。请注意,训练过程只需要大量的描述性陈述和未对齐的问题式陈述。最后,在生成问题后,我们构建一个基于BERT的MRC模型(Devlin et al, 2019)来回答每个问题,并将所有答案综合为EE的结果。

为了评估我们的方法,我们在基准EE数据集上进行了大量的实验,实验结果证明了我们方法的有效性。具体来说,1)在标准评估中,我们的方法达到了最先进的性能,并优于之前的EE方法(§4.2)。2)在低数据的情况下,我们的方法展示了有希望的结果,例如,在使用1%的训练数据实现了49.8%的F1,而之前的EE方法仅为2.2%F1(§4.3)。3)我们的方法也适用于零样本场景,在不使用任何EE训练数据的情况下,在两个数据集上实现了37.0%和16.6%的F1(§4.4)。

我们的贡献如下:

- 我们研究了EE的一个新范式,通过明确地将其框定为MRC问题。我们表明,这种新的范式可以通过利用MRC领域的模型和数据来提高情感表达。我们的工作可能会鼓励更多研究MRC迁移学习的工作,以促进信息抽取。

- 我们提出了一种无监督的问题生成方法来连接MRC和EE。与以往使用模板生成问题的工作相比,我们的方法可以生成既与主题相关又与上下文相关的问题,从而更好地指导MRC模型进行问题回答。

- 我们报告基准EE数据集的最新性能。我们的方法在处理低数据和零样本场景时也显示了有希望的结果。

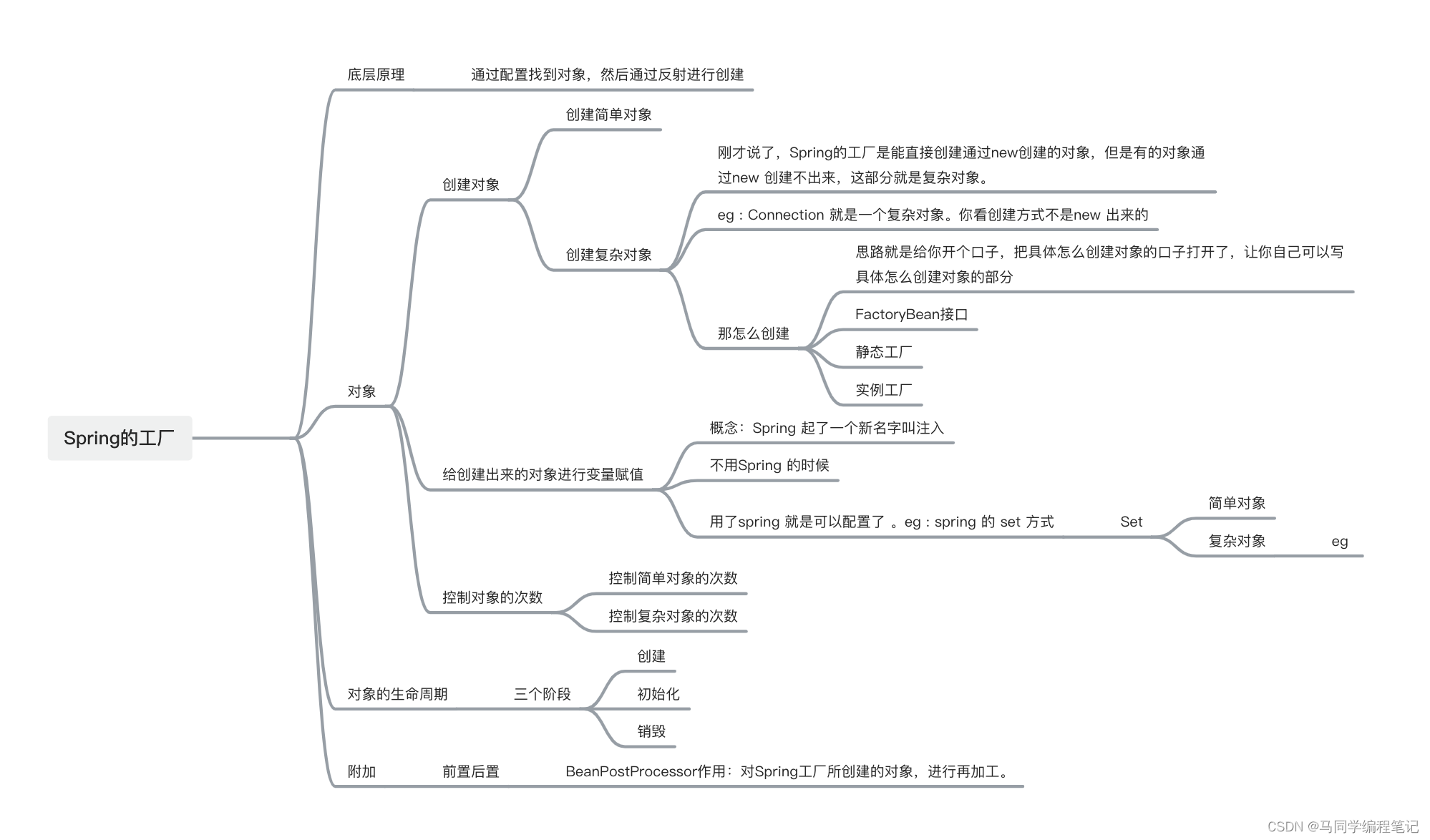

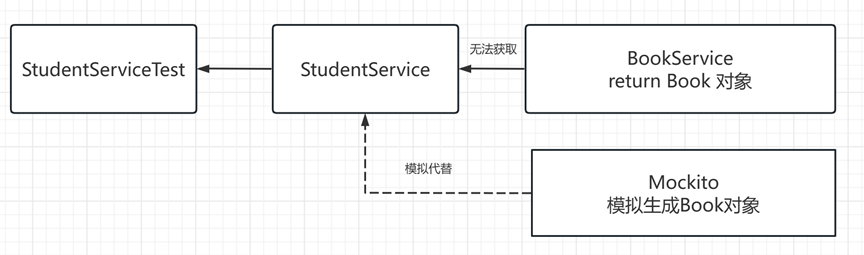

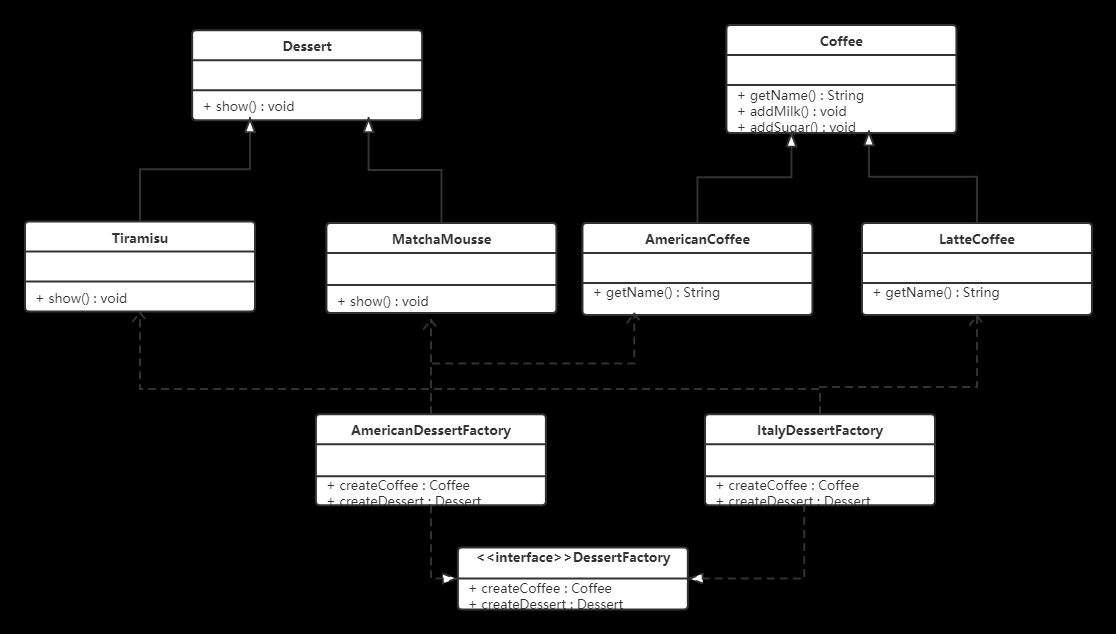

2、模型

我们的方法由RCEE(Reading Comprehension for Event Extraction)表示,如图2所示。具体来说,给定一个句子 S 1 S_1 S1, RCEE在接收到一个特殊查询“[Event]”时,首先确定一个事件触发词“stabbed”及其事件类型“Attack”。其次,RCEE为攻击事件模式对应的每个语义角色生成一个问题。第三,RCEE建立MRC模型,作为事件论元抽取来回答每个问题。最后,RCEE将所有答案综合为EE的最终结果。

RCEE的技术细节如下。在图中,我们将一个句子表示为 c = { c 1 , … , c n } c = \{c_1,\ldots,c_n\} c={c1,…,cn},并将图构造为事件触发词抽取、无监督问题生成、事件论元抽取和RCEE的训练过程。

3、实验结果

在标准评估中,我们考虑两种设置:1)已知实体,这是以前许多方法考虑的,2)未知实体,这是一个更现实的设置。

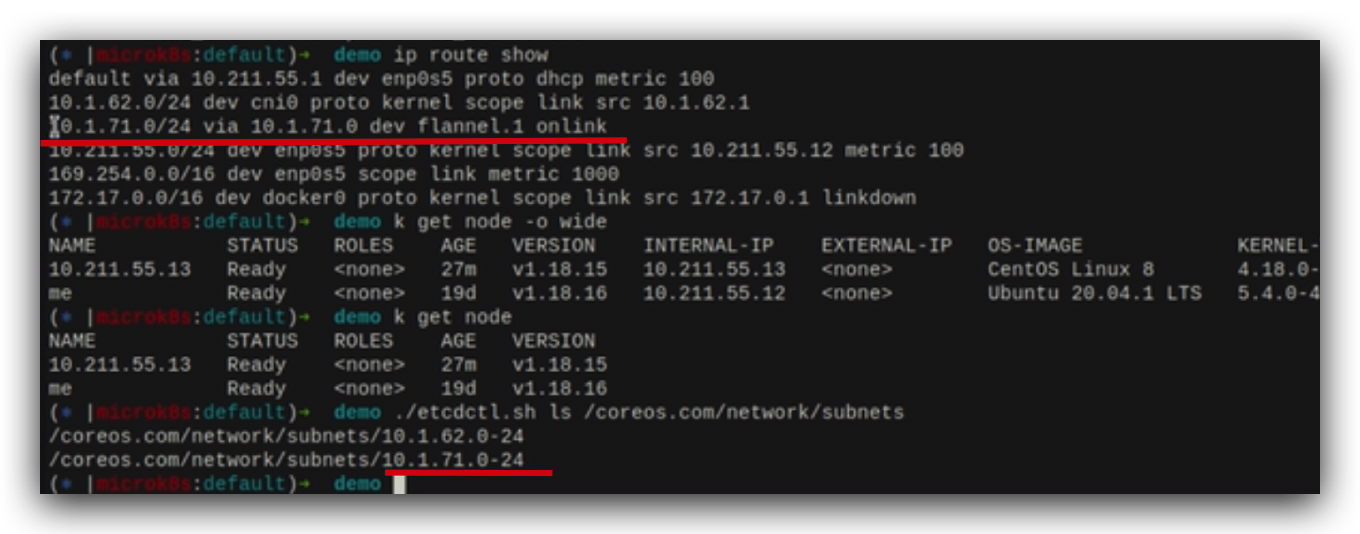

已知实体的结果。表2给出了已知实体的触发词(Trigger Ex.)和论元抽取(argument Ex.)的结果。我们还报告了使用oracle触发词抽取论元的结果(论元Ex.(O)),以排除触发词抽取结果中潜在的错误传播。从结果来看,1)RCEE ER获得了最先进的性能,超过所有基线的相当大的幅度(触发词抽取+0.6%;论元抽取+3.6% (5.4%))。2)尤其在论元抽取方面,RCEE_ER优于同样使用BERT表示的BERTEE(也使用BERT表示)5%以上,这表明改进主要来自于问题的重新表述,而不是引入BERT表示。3) RCEE_ER的高召回率表明它可以比基线预测更多的例子,这可能意味着RCEE_ER可以处理基线模型失败的困难情况。

未知实体的结果。表3给出了未知实体的结果。在此设置中,基于分类的方法需要首先识别实体,因此我们为它们实现了基于BERT的方法。还比较了不需要实体信息的联合EE方法。我们使用RCEE进行比较,其中不包括实体细化。从结果来看,RCEE仍然表现出最好的性能-它击败了基于分类的方法(F1中超过9.3%)和联合模型(超过6.0%)。通过检查∆F1,我们注意到RCEE对golden实体的依赖相对较少(在没有golden实体的F1中为-4.3%),但基于分类的方法严重依赖golden实体,在有预测实体的F1中下降超过8%。

数据稀缺场景的结果:图4比较了数据稀缺场景下的模型和BERTEE,表4给出了极低数据场景下的结果(≤20%的训练数据)。从结果来看,我们的模型表现出了优越的性能,例如,相比之下,只用1%的EE训练数据就获得了49.8%的F1,而BERTEE只有2.2%的F1。我们注意到改进来自两个方面:1)数据增强(DA)。例如,根据表4,在1%和5%数据的实验中,DA对RCEE_ER提高了+47.6%和+33.4%。2)答案生成算法。注意在低数据情况下,没有DA的RCEE_ER仍然始终优于BERTEE。这表明该算法比分类方法数据效率高。原因可能是,我们的方法中的答案生成算法是基于位置的,这对于看不见的单词可能是稳健的。而以往EE方法的分类方法大多基于单词,需要更多的标注数据。

零样本案例下的效果:表5显示了zero-shot EE的结果,其中EE数据完全禁止进行训练(仅使用DA进行模型预训练)。为了增加结果的说服力,我们采用了另一个数据集,FrameNet (Baker, 2014)(其中帧被视为元事件类型)进行评估。从结果来看:在没有任何EE数据的情况下,我们的模型在ACE和FrameNet上F1分别达到了37%和16.6%。这说明了我们的模型处理不可见类型的有效性。

![[Android Studio] Android Studio生成数字证书,为应用签名](https://img-blog.csdnimg.cn/24b696d76d374a9992017e1625389592.gif)