文章目录

- 多master(高可用)介绍

- 高可用集群使用技术介绍

- 搭建高可用k8s集群步骤

- 1. 准备环境-系统初始化

- 2. 在所有master节点上部署keepalived

- 3.1 安装相关包

- 3.2 配置master节点

- 3.3 部署haproxy

- 错误解决

- 3. 所有节点安装Docker/kubeadm/kubelet

- 4. 部署Kubernetes Master

- 4.1 创建kubreadm配置文件

- *初始化节点*

- 4.2 在master1节点执行

- 5. 安装集群网络

- 6. master2、master3节点加入集群

- 6.1 复制密钥及相关文件

- 6.2 master2和master3加入到集群

- 7. 加入Kubernetes Node

- 报错解决

- 8. 测试kubernetes集群

- 9. 模拟

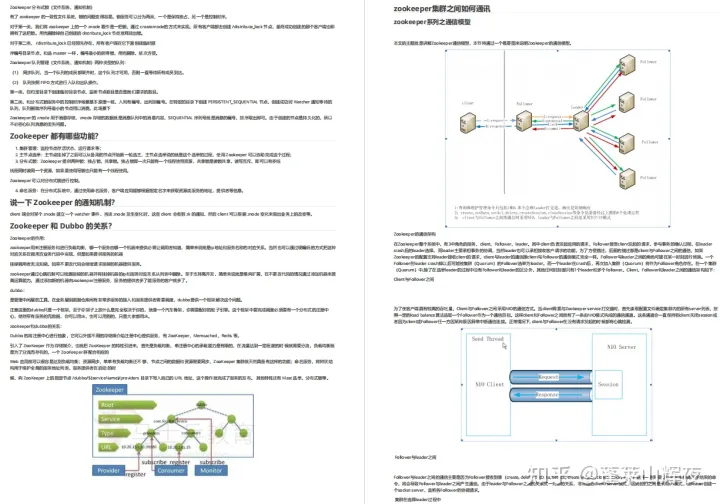

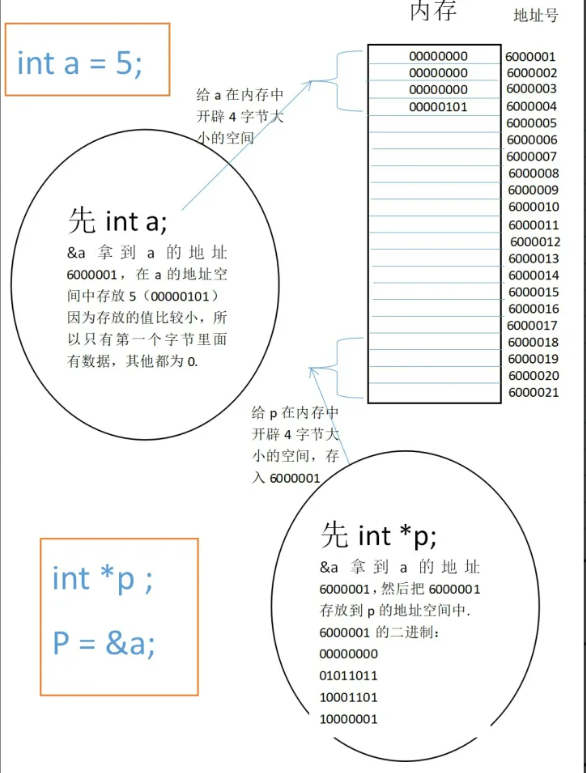

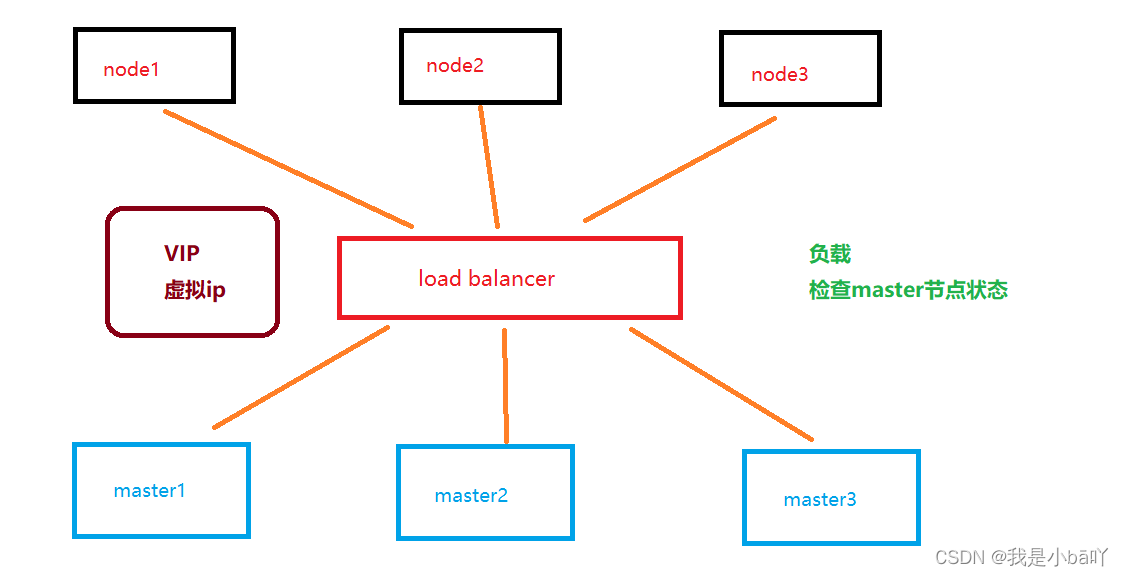

多master(高可用)介绍

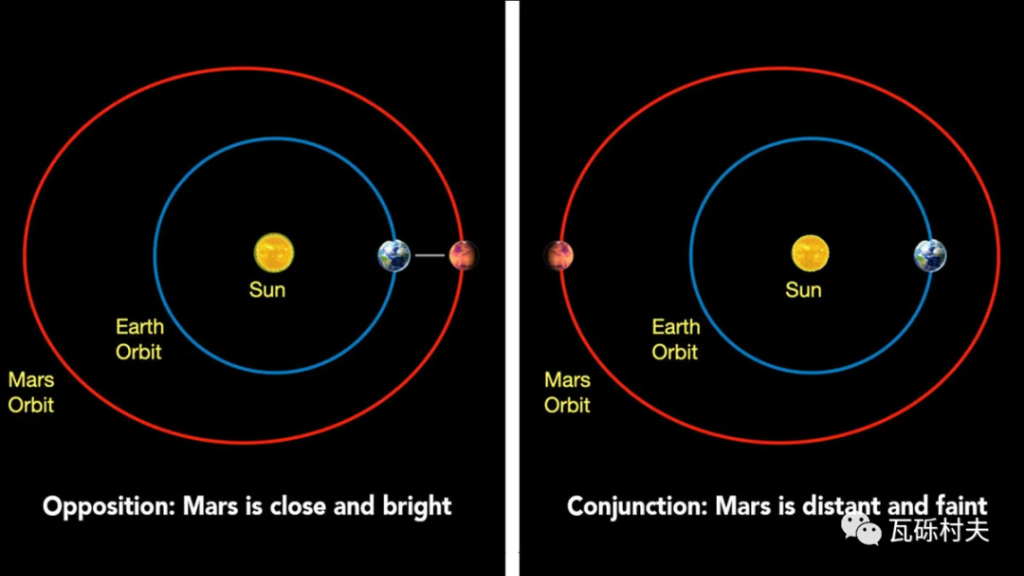

假设现在有3个node节点和3个master节点,node1到底是连到master1还是连到master2还是master3,需要有人来分配,这个中间人就是load balancer,load balancer起到两个作用,一是负载。二是检查master状态,如果master1异常,就会使node连到master2上,如果master1正常,则正常提供服务。由于节点之间互相访问是通过IP连接,这里也是一样的,只不过是通过VIP(虚拟ip)连接。

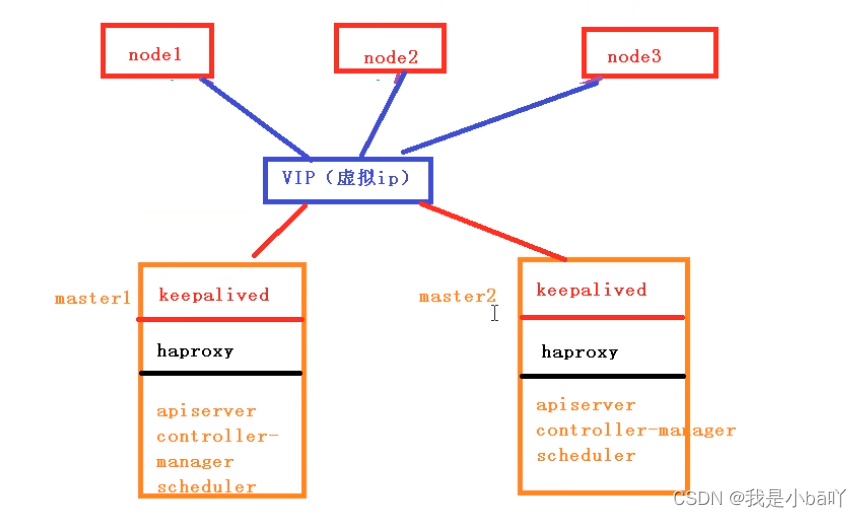

高可用集群使用技术介绍

keepalived:检查master状态,是否正常运行;配置虚拟IP。

haproxy:负载均衡服务器,起到负载作用。

master具体组件:apiserver, controller-manager, scheduler。

搭建高可用k8s集群步骤

前提条件:

①固定四台主机IP,参考文章固定虚拟机IP

②可连外网

| 主机 | IP |

|---|---|

| master1 | 192.168.2.200 |

| master2 | 192.168.2.201 |

| master3 | 192.168.2.204 |

| node1 | 192.168.2.202 |

| 虚拟IP | 192.168.2.203 |

我们以3台master,1台node为例,首先准备好4台服务器,分别在四台服务器上做操作。

1. 准备环境-系统初始化

# 关闭防火墙

systemctl stop fierwalld #临时关闭

systemctl disable fierwalld #永久关闭

# 关闭selinux

sed -i 's/enforcing/disabled/' /etc/selinux/config # 永久

setenforce 0 # 临时

# 关闭swap分区

swapoff -a #临时

sed -ri 's/.*swap.*/#&/' /etc/fstab #永久

# 根据规划设置主机名

hostnamectl set-hostname <hostname>

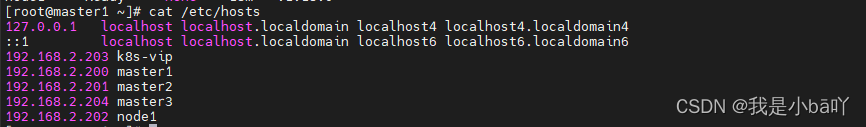

# 在master中添加hosts,每一个master都要执行

cat >> /etc/hosts << EOF

192.168.2.203 k8s-vip

192.168.2.200 master1

192.168.2.201 master2

192.168.2.202 node1

EOF

# 将桥接的 IPv4 流量传递到 iptables 的链

cat > /etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sysctl --system # 生效

# 时间同步

yum install ntpdate -y

ntpdate time.windows.com

2. 在所有master节点上部署keepalived

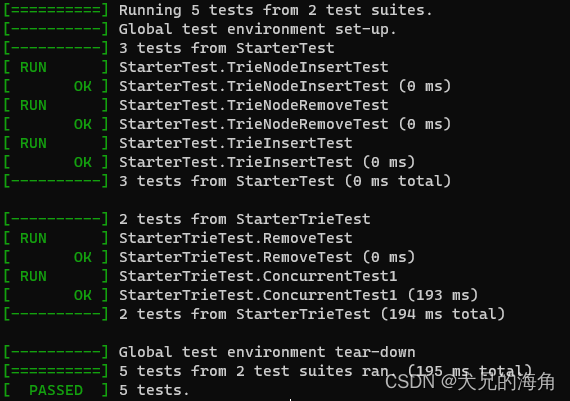

3.1 安装相关包

# 安装相关工具

yum install -y conntrack-tools libseccomp libtool-ltdl

# 安装keepalived

yum install -y keepalived

3.2 配置master节点

- master1节点配置:

cat > /etc/keepalived/keepalived.conf <<EOF

! Configuration File for keepalived

global_defs {

router_id k8s

}

vrrp_script check_haproxy {

script "killall -0 haproxy"

interval 3

weight -2

fall 10

rise 2

}

vrrp_instance VI_1 {

state MASTER

interface ens33 # ens33 为网卡名称

virtual_router_id 51

priority 250

advert_int 1

authentication {

auth_type PASS

auth_pass ceb1b3ec013d66163d6ab

}

virtual_ipaddress {

192.168.2.203 # 虚拟ip

}

track_script {

check_haproxy

}

}

EOF

- master2、master3节点配置

cat > /etc/keepalived/keepalived.conf <<EOF

! Configuration File for keepalived

global_defs {

router_id k8s

}

vrrp_script check_haproxy {

script "killall -0 haproxy"

interval 3

weight -2

fall 10

rise 2

}

vrrp_instance VI_1 {

state BACKUP

interface ens33 # ens33 为网卡名称

virtual_router_id 51

priority 200

advert_int 1

authentication {

auth_type PASS

auth_pass ceb1b3ec013d66163d6ab

}

virtual_ipaddress {

192.168.2.203 # 虚拟ip

}

track_script {

check_haproxy

}

}

EOF

- 启动和检查

三台master节点都执行

# 启动keepalived

systemctl start keepalived.service

# 设置开机启动

systemctl enable keepalived.service

# 查看启动状态

systemctl status keepalived.service

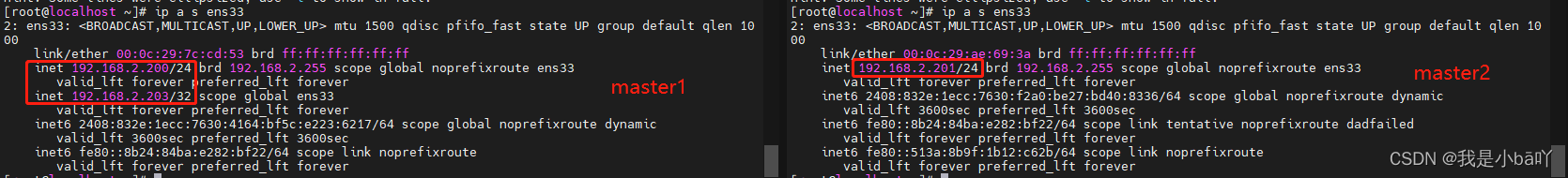

启动后查看master的网卡信息。由于虚拟IP配到了master1上,执行后,master1节点上会多出一个IP,即为虚拟IP;master2和master3上没有,挂上master1后才会出现。

ip a s ens33

3.3 部署haproxy

- 在3个master节点安装 haproxy

# 安装haproxy

yum install -y haproxy

- 配置

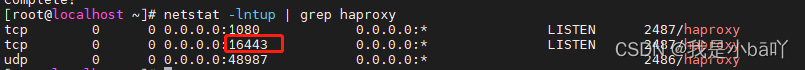

3台master节点的配置均相同,配置中声明了后端代理的3个master节点服务器,指定了haproxy运行的端口为16443等,因此16443端口为集群的入口

cat > /etc/haproxy/haproxy.cfg << EOF

#---------------------------------------------------------------------

# Global settings

#---------------------------------------------------------------------

global

# to have these messages end up in /var/log/haproxy.log you will

# need to:

# 1) configure syslog to accept network log events. This is done

# by adding the '-r' option to the SYSLOGD_OPTIONS in

# /etc/sysconfig/syslog

# 2) configure local2 events to go to the /var/log/haproxy.log

# file. A line like the following can be added to

# /etc/sysconfig/syslog

#

# local2.* /var/log/haproxy.log

#

log 127.0.0.1 local2

chroot /var/lib/haproxy

pidfile /var/run/haproxy.pid

maxconn 4000

user haproxy

group haproxy

daemon

# turn on stats unix socket

stats socket /var/lib/haproxy/stats

#---------------------------------------------------------------------

# common defaults that all the 'listen' and 'backend' sections will

# use if not designated in their block

#---------------------------------------------------------------------

defaults

mode http

log global

option httplog

option dontlognull

option http-server-close

option forwardfor except 127.0.0.0/8

option redispatch

retries 3

timeout http-request 10s

timeout queue 1m

timeout connect 10s

timeout client 1m

timeout server 1m

timeout http-keep-alive 10s

timeout check 10s

maxconn 3000

#---------------------------------------------------------------------

# kubernetes apiserver frontend which proxys to the backends

#---------------------------------------------------------------------

frontend kubernetes-apiserver

mode tcp

bind *:16443 #默认监听端口16443

option tcplog

default_backend kubernetes-apiserver

#---------------------------------------------------------------------

# round robin balancing between the various backends

#---------------------------------------------------------------------

backend kubernetes-apiserver

mode tcp

balance roundrobin

server master01.k8s.io 192.168.2.200:16443 check # 修改IP

server master02.k8s.io 192.168.2.201:16443 check # 修改IP

server master03.k8s.io 192.168.2.204:16443 check # 修改IP

#---------------------------------------------------------------------

# collection haproxy statistics message

#---------------------------------------------------------------------

listen stats

bind *:1080

stats auth admin:awesomePassword

stats refresh 5s

stats realm HAProxy\ Statistics

stats uri /admin?stats

EOF

- 启动和检查

两台master都启动

# 启动 haproxy

systemctl start haproxy

# 设置开启自启

systemctl enable haproxy

# 查看启动状态

systemctl status haproxy

启动后,检查端口,查看对应的端口是否包含 16443

netstat -tunlp | grep haproxy

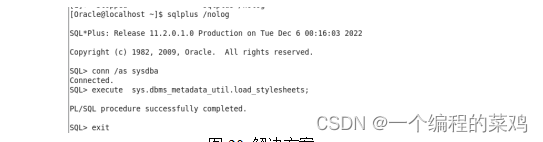

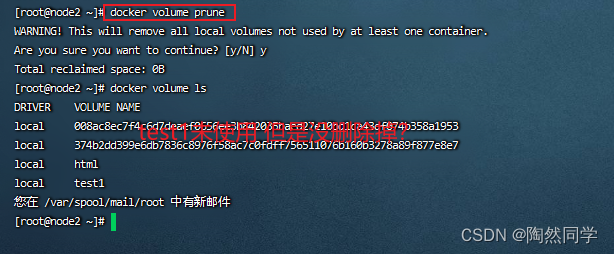

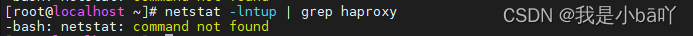

错误解决

报错:

针对这个问题出现的原因,就是Linux缺少对应的包,使用命令安装即可: yum install -y net-tools。再次执行netstat命令即可。

3. 所有节点安装Docker/kubeadm/kubelet

所有节点安装Docker/kubeadm/kubelet ,Kubernetes默认CRI(容器运行时)为Docker,因此先安装Docker。

- 安装之前确保没有其他dockers版本,如果有,需要删除干净后再安装,卸载方式可以参考这篇文章卸载docker。

- 安装Docker,所有master+node都要安装

# 下载镜像

wget https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo -O /etc/yum.repos.d/docker-ce.repo

# 安装docker

yum -y install docker-ce-18.06.1.ce-3.el7

# 开机自启动并且启动docker

systemctl enable docker && systemctl start docker

# 查看docker状态

systemctl status docker

# 查看docker版本

docker --version

# 设置仓库地址

cat > /etc/docker/daemon.json << EOF

{

"registry-mirrors": ["https://b9pmyelo.mirror.aliyuncs.com"]

}

EOF

# 重启docker

systemctl restart docker

- 添加阿里云yum源,所有节点(master+node)

cat >/etc/yum.repos.d/docker.repo<<EOF

[docker-ce-edge]

name=Docker CE Edge - \$basearch

baseurl=https://mirrors.aliyun.com/docker-ce/linux/centos/7/\$basearch/edge

enabled=1

gpgcheck=1

gpgkey=https://mirrors.aliyun.com/docker-ce/linux/centos/gpg

EOF

# 重启docker

systemctl restart docker

- 添加kubernetes软件源

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

- 安装kubeadm,kubectl,kubelet

由于版本更新频繁,这里指定版本号部署:

# 安装kubelet、kubeadm、kubectl,同时指定版本

yum install -y kubelet-1.18.0 kubeadm-1.18.0 kubectl-1.18.0

# 设置开机启动

systemctl enable kubelet

4. 部署Kubernetes Master

4.1 创建kubreadm配置文件

在具有vip的master上进行初始化操作,这里为master1

# 创建文件夹

mkdir /usr/local/kubernetes/manifests -p

# 到manifests目录

cd /usr/local/kubernetes/manifests/

# 新建yaml文件

vim kubeadm-config.yaml

下面内容修改IP 后复制进去

apiServer:

certSANs:

- master1

- master2

- master3

- k8s-vip #虚拟IP的名字,需和/etc/hosts里一致

- 192.168.2.203 # 虚拟IP

- 192.168.2.200 # master1

- 192.168.2.201 # master2

- 192.168.2.204 # master3

- 127.0.0.1

extraArgs:

authorization-mode: Node,RBAC

timeoutForControlPlane: 4m0s

apiVersion: kubeadm.k8s.io/v1beta1

certificatesDir: /etc/kubernetes/pki

clusterName: kubernetes

controlPlaneEndpoint: "k8s-vip:16443" #虚拟IP:16443

controllerManager: {}

dns:

type: CoreDNS

etcd:

local:

dataDir: /var/lib/etcd

imageRepository: registry.aliyuncs.com/google_containers

kind: ClusterConfiguration

kubernetesVersion: v1.18.0

networking:

dnsDomain: cluster.local

podSubnet: 10.244.0.0/16

serviceSubnet: 10.1.0.0/16

scheduler: {}

初始化节点

如果上面的yaml文件已经执行过一次,再次执行就会报错,这时,就需要将集群初始化。

步骤:

# 1. 还原由 kubeadm init 或 kubeadm join 所做的更改

kubeadm reset -f

# 2. 删除相关文件

rm -rf /etc/kubernetes/*

rm -rf /var/lib/etcd/*

然后再次执行yaml文件

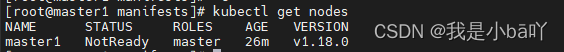

4.2 在master1节点执行

kubeadm init --config kubeadm-config.yaml

执行完成后,就会在拉取镜像【需要等待…】

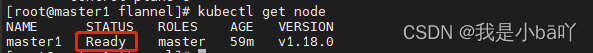

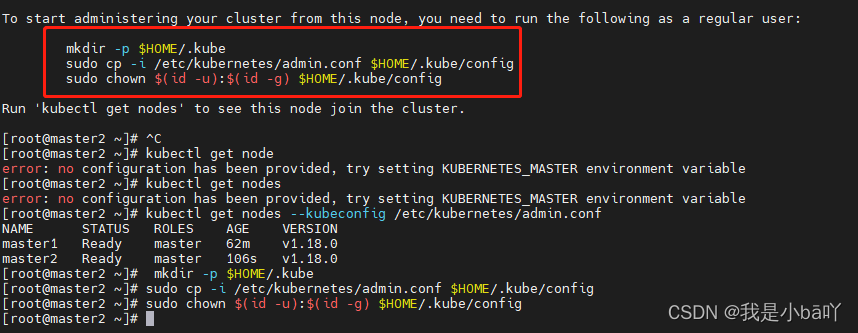

按照提示配置环境变量,使用kubectl工具

# 执行下方命令

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

# 查看节点

kubectl get nodes

# 查看pod

kubectl get pods -n kube-system

由于没有安装网络插件,所以会有pending状态,无妨,继续往下执行就好了。

按照提示保存以下内容,一会要使用

kubeadm join k8s-vip:16443 --token ivcq40.a1bb605g6df4xhdw \

--discovery-token-ca-cert-hash sha256:b65dcb57a2934439562ae138f552942600296edc04cdefb7da93031cf23c9a08 \

--control-plane

–control-plane : 只有在添加master节点的时候才有

# 查看集群健康状态

kubectl get cs

# 查看pod

kubectl get pods -n kube-system

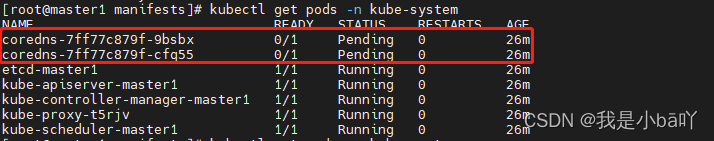

5. 安装集群网络

从官方地址获取到flannel的yaml,在master1上执行

# 创建文件夹

mkdir flannel

cd flannel

# 下载yaml文件

wget -c https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

安装flannel网络

kubectl apply -f kube-flannel.yml

检查,都已经running,且master已经ready

kubectl get pods -n kube-system

6. master2、master3节点加入集群

6.1 复制密钥及相关文件

从master1复制密钥及相关文件到master2

## master1中执行,修改IP,分别改为master2/3的IP执行2遍

# ssh root@192.168.2.201 mkdir -p /etc/kubernetes/pki/etcd # 修改IP;master2\master3的IP,用master1连接master2\master3;输入密码

# scp /etc/kubernetes/admin.conf root@192.168.2.201:/etc/kubernetes

# scp /etc/kubernetes/pki/{ca.*,sa.*,front-proxy-ca.*} root@192.168.2.201:/etc/kubernetes/pki

# scp /etc/kubernetes/pki/etcd/ca.* root@192.168.2.201:/etc/kubernetes/pki/etcd

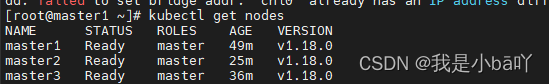

6.2 master2和master3加入到集群

在master2、master3上执行在master1上init后输出的join命令,需要带上参数–control-plane表示把master控制节点加入集群。

# master2上执行

kubeadm join k8s-vip:16443 --token ivcq40.a1bb605g6df4xhdw \

--discovery-token-ca-cert-hash sha256:b65dcb57a2934439562ae138f552942600296edc04cdefb7da93031cf23c9a08 \

--control-plane

按照提示执行输出的3行命令

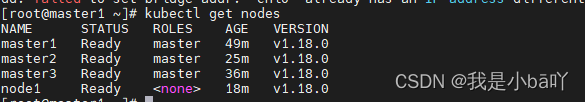

检查状态

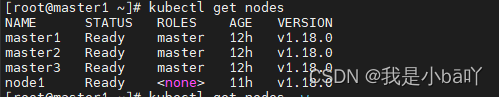

kubectl get nodes

kubectl get pods --all-namespaces

7. 加入Kubernetes Node

向集群添加新节点,执行在kubeadm init输出的kubeadm join命令,不加参数–control-plane

# 在node1上执行

kubeadm join k8s-vip:16443 --token ivcq40.a1bb605g6df4xhdw \

--discovery-token-ca-cert-hash sha256:b65dcb57a2934439562ae138f552942600296edc04cdefb7da93031cf23c9a08

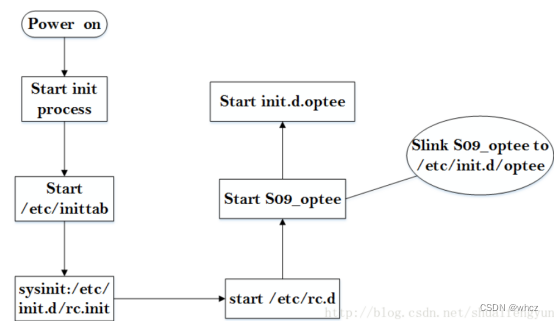

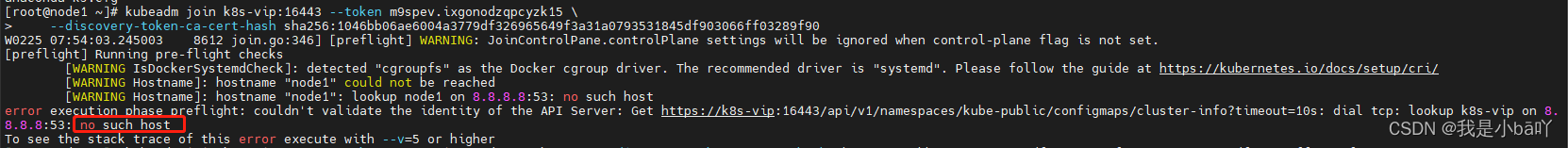

报错解决

执行命令后,报错no such host,如下:

这时候,需要将node1节点里的hosts表里的内容保持与master节点一致,再次执行就可以了。

集群网络重新安装,因为添加了新的node节点

# 在master1节点上执行

kubectl apply -f flannel/kube-flannel.yml

检查状态

kubectl get nodes

kubectl get pods --all-namespaces

8. 测试kubernetes集群

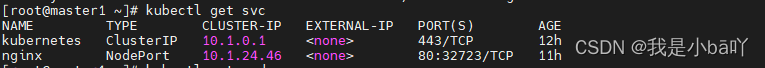

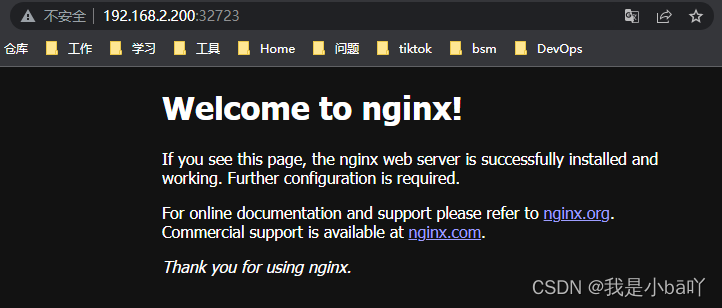

在Kubernetes集群中创建一个pod,验证是否正常运行:

# 创建nginx deployment

kubectl create deployment nginx --image=nginx

# 暴露端口

kubectl expose deployment nginx --port=80 --target-port=80 --type=NodePort

# 查看状态

kubectl get pod,svc

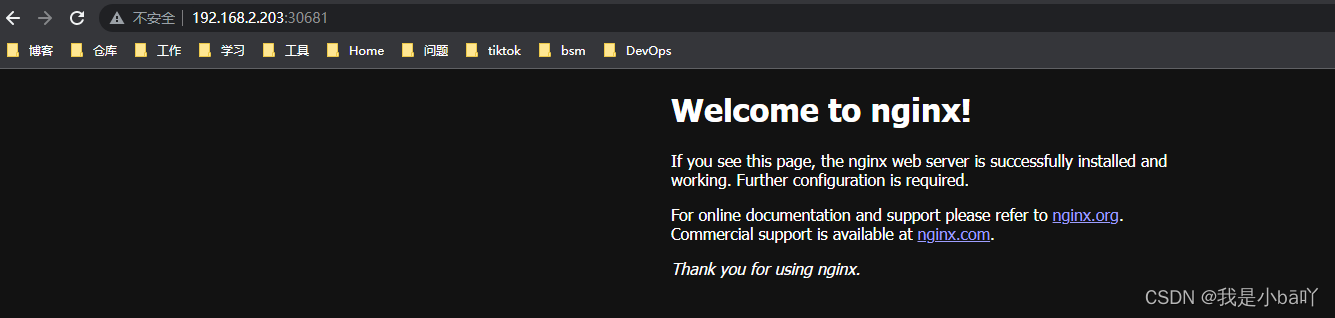

然后通过任何一个master或node节点或者虚拟IP加上端口号,都能够访问nginx页面;如果想要通过域名访问服务,可以参考这篇文章

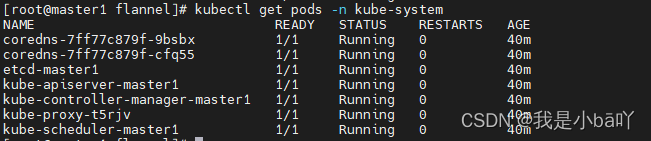

9. 模拟

我们现在有3个master节点,1个node节点,经过上述测试,发现集群可以正常访问nginx服务,因为三台master在正常运行,我们现在模拟挂掉一台master,让另外2台master正常运行,看一下会有什么效果:

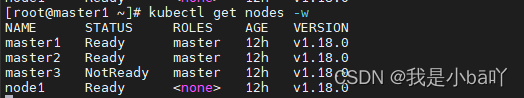

- 首先,先查看集群是否正常,执行

kubectl get nodes命令,发现各个节点都处于ready状态

- 我们现在把master3这台服务器关掉,再看集群状态,关掉一会之后,发现master3节点状态变成了NotReady。

我们再使用其他节点的IP加上端口号访问nginx试一下,发现可以正常访问;如果使用master3节点的IP加端口号就无法访问nginx,是因为master3服务器已经关闭。

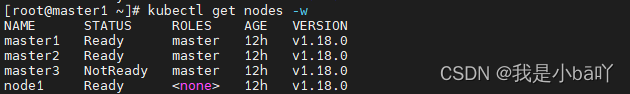

- 到现在为止,我们有2台正在运行的master,现在我们再关闭一台master,把master2也关掉,只留一台master,试一下会怎么样?

关闭前的状态:

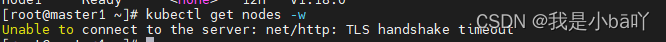

关闭后再次执行kubectl get nodes命令,发现报错了,显示无法连接到服务器。

虽然这时候在访问nginx还是可以正常访问,但是此时的集群已经坏掉了。

所以,如果有3个master节点,必须要保证2个正常运行;如果有5个master,必须保证3个正常运行。假设有N个master节点,必须保证有(N+1)/2个节点正常运行,才能保证集群正常。