【论文速递】ACL 2021-CLEVE: 事件抽取的对比预训练

【论文原文】:CLEVE: Contrastive Pre-training for Event Extraction

【作者信息】:Wang, Ziqi and Wang, Xiaozhi and Han, Xu and Lin, Yankai and Hou, Lei and Liu, Zhiyuan and Li, Peng and Li, Juanzi and Zhou, Jie

论文:https://arxiv.org/pdf/2105.14485.pdf

代码:https://github.com/THU-KEG/CLEVE

博主关键词:AMR,自监督学习,预训练,图神经网络

推荐论文:AMR-IE:http://t.csdn.cn/Vk6VP、TSAR:http://t.csdn.cn/wXEAc

摘要

事件抽取(EE)通过微调从预训练的语言模型(PLMs)中受益匪浅。然而,现有的预训练方法没有涉及事件特征的建模,导致所开发的EE模型不能充分利用大规模无监督数据。为此,我们提出了CLEVE,一个用于EE的对比预训练框架,以更好地从自动解析器(例如AMR)去获得的大型无监督数据及其语义结构中学习事件知识。CLEVE分别包含一个学习事件语义的文本编码器和一个学习事件结构的图编码器。具体来说,文本编码器通过自监督对比学习来学习事件语义表示,使同一事件中的单词比不相关的单词表示得更近;图编码器通过对已解析的事件相关语义结构进行图对比预训练来学习事件结构表示。然后,这两种互补的表示形式一起工作以改进传统的监督EE和无监督的“自由(liberal)”EE,后者需要在没有任何标注数据的情况下联合抽取事件和发现事件模式。在ACE 2005和MAVEN数据集上的实验表明,CLEVE取得了显著的改进,特别是在具有挑战性的无监督环境中。

1、简介

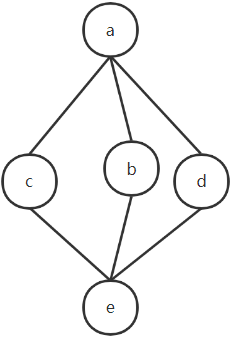

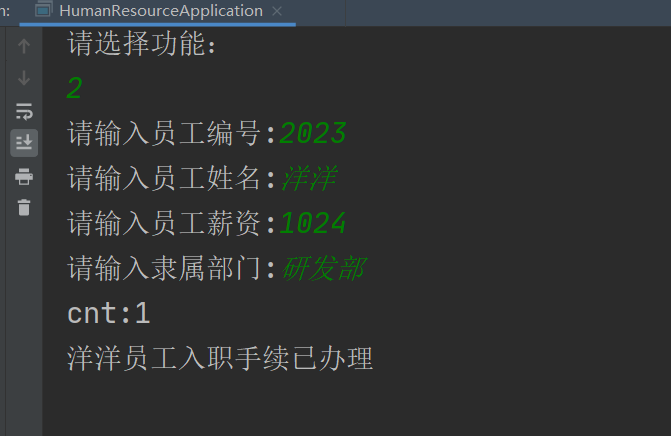

事件抽取(Event extraction, EE)是一项长期存在的重要信息抽取任务,旨在从非结构化文本中抽取事件结构。如图1所示,它包含事件检测任务,用于识别事件触发词(单词“攻击(attack)”)和分类事件类型(攻击(Attack)),以及事件论元抽取任务,以识别作为事件论元的实体(“今天(today)”和“内坦亚(Netanya)”),并对其论元角色(时间-内部(Time-within)和地点(Place))进行分类(Ahn, 2006)。通过明确地捕获文本中的事件结构,EE可以受益于各种下游任务,如信息检索(Glavas和Snajder, 2014)和知识库人口(Ji和Grishman, 2011)。

现有的EE方法主要遵循监督学习范式来训练高级神经网络(Chen et al, 2015;Nguyen等人,2016;Nguyen和Grishman, 2018),使用人工标注数据集和预定义的事件模式。这些方法在许多公共基准测试中工作良好,如ACE 2005 (Walker et al, 2006)和TAC KBP (Ellis et al, 2016),但它们仍然受到数据稀缺和有限的泛化性的影响。由于标注事件数据和定义事件模式特别昂贵且耗费大量人力,因此现有的EE数据集通常只包含数千个实例,覆盖有限的事件类型。因此,它们不足以训练大型神经模型(Wang et al, 2020)和开发可以推广到不断出现的新事件类型的方法(Huang和Ji, 2020)。

受到最近用于NLP任务的预训练语言模型(PLMs)成功的启发,一些开创性工作(Wang et al, 2019a;Wadden等人,2019)试图对EE的一般PLMs(例如BERT (Devlin等人,2019))进行微调。得益于从大规模无监督数据中学习到的强大的通用语言理解能力,这些基于PLM的方法在各种公共基准测试中取得了最先进的表现。

虽然利用无监督数据进行预训练已逐渐成为EE和NLP界的共识,但仍缺乏面向事件建模的预训练方法,以充分利用大规模无监督数据中丰富的事件知识。这里的关键挑战是找到合理的自我监督信号(Chen等人,2017;Wang等人,2019a)为事件的不同语义和复杂结构。幸运的是,之前的工作(Aguilar et al, 2014;Huang等人,2016)提出句子语义结构,如抽象语义表示(AMR) (Banarescu等人,2013),包含广泛和多样的语义和结构信息与事件有关。如图1所示,解析的AMR结构不仅包括带标注的事件(攻击(Attack)),还包括ACE 2005模式中未定义的事件(报告(Report))。

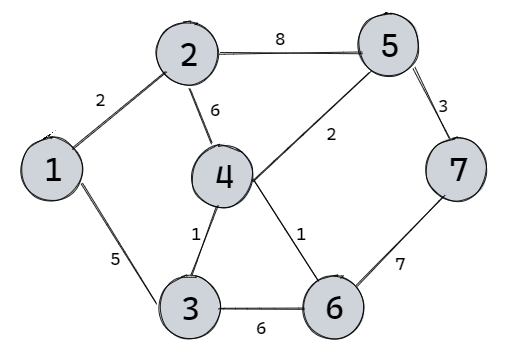

考虑到大规模无监督数据的AMR结构可以很容易地通过自动解析器获得(Wang et al, 2015),我们提出了CLEVE,一种面向事件的对比预训练框架,利用AMR结构构建自我监督信号。CLEVE由两个组件组成,包括学习事件语义的文本编码器和学习事件结构信息的图形编码器。具体而言,为了学习有效的事件语义表示,我们使用PLM作为文本编码器,并鼓励在AMR结构中由ARG、时间、位置边连接的词对的表示在语义空间中比其他不相关的词更接近,因为这些词对通常指的是相同事件的触发词论元对(如图1所示)(Huang et al, 2016)。这是通过对比学习来完成的,将连接的单词对作为积极样本,不相关的单词作为消极样本。此外,考虑到事件结构也有助于抽取事件(Lai et al, 2020)和推广到新的事件模式(Huang et al, 2018),我们需要学习可转移的事件结构表示。因此,我们进一步引入图神经网络(GNN)作为图编码器,将AMR结构编码为结构表示。以AMR子图识别为目标,在大型无监督语料库的AMR结构上对图编码器进行对比预训练。

通过对下游EE数据集上的两个预训练模型进行微调,并联合使用这两种表示,CLEVE相对于传统的监督EE受益于数据稀缺。同时,预训练的表示也可以直接帮助抽取事件并发现新的事件模式,无需任何已知的事件模式或标注实例,从而具有更好的泛化性。这是一个具有挑战性的无监督设置,名为“自由事件抽取”(Huang et al, 2016)。在广泛使用的ACE 2005和大型MAVEN数据集上的实验表明,CLEVE在这两种设置下都可以实现显著的改进。

2、方法

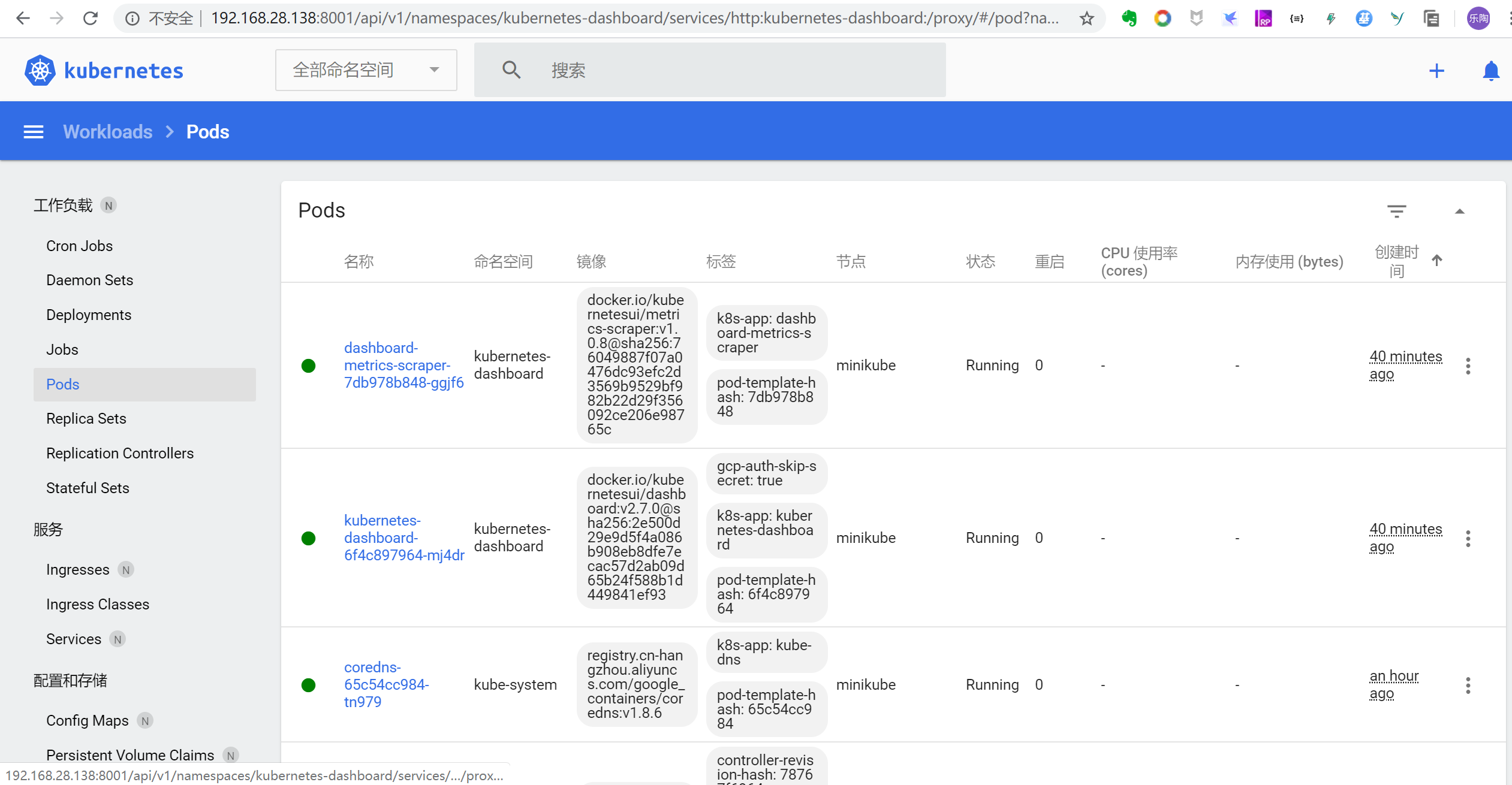

整个CLEVE框架如图2所示。如图2所示,我们的对比预训练框架CLEVE由两个部分组成:事件语义预训练和事件结构预训练,分别在章节3.2和章节3.3中介绍。在本节开始时,我们首先介绍3.1节中所需的预处理,包括AMR解析以及如何修改已解析的AMR结构以进行预训练。

3、实验结果

评估结果:评价结果如表1和表2所示。我们可以观察到:(1)在ACE 2005和MAVEN上,CLEVE对其基本模型RoBERTa都有了显著的改进。ED on ACE 2005、EAE on ACE 2005和ED on MAVEN的t检验p值分别为4×10−8、2×10−8和6 ×10−4。它也优于或达到与其他baseline的水平,包括那些使用依赖解析信息(dbRNN, GatedGCN, SemSynGTN和MOGANED)。这证明了我们提出的对比预训练方法和AMR语义结构的有效性。值得注意的是,RCEE ER在EAE中优于我们的方法,因为它的特殊优势是将EE重新定义为MRC任务,以利用复杂的MRC方法和大量标注的外部MRC数据。考虑到我们的方法本质上是一种学习更好的面向事件表示的预训练方法,CLEVE和RCEE ER自然可以一起工作来进一步提高EE。(2)消融研究(比较CLEVE及其w/o语义或结构表示变体)表明,事件语义预训练和事件结构预训练对我们的方法都是必不可少的。(3)对比CLEVE及其在ACE (golden)和ACE (AMR)上的变体,可以看出AMR解析与正确标注相比不可避免地会带来数据噪声,从而导致性能下降。然而,这种差距可以很容易地通过引入大量无监督数据和预训练来弥补。

全文阅读