RNN模型图解

- 引用

- RNN模型

- GRU

- LSTM

- 深度RNN

- 双向循环神经网络

引用

动手学深度学习v2–李沐

LSTM长短期记忆网络3D模型–B站up梗直哥丶

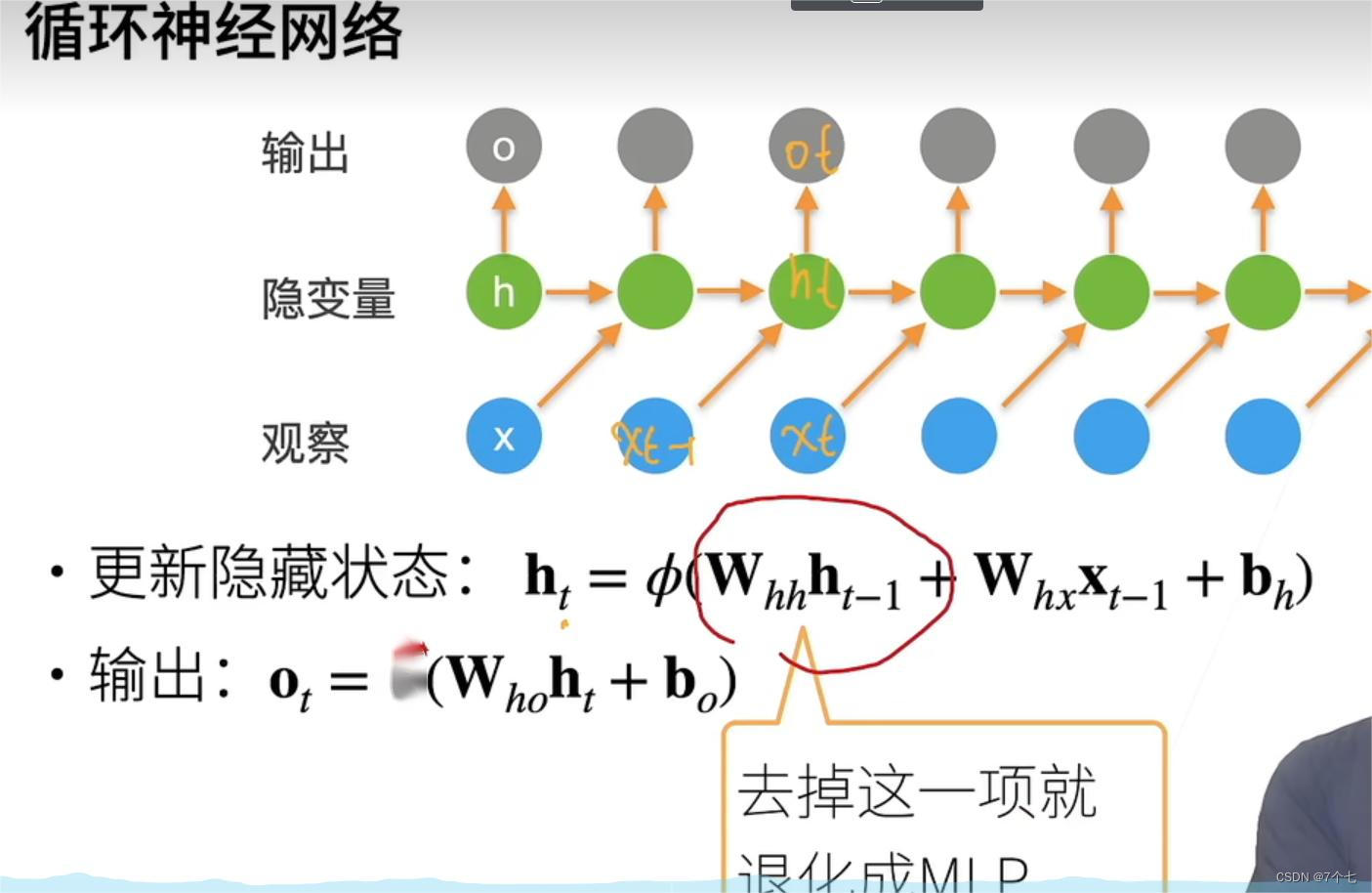

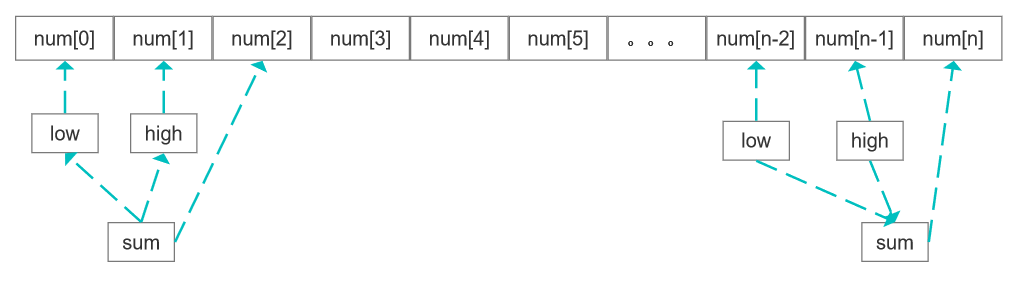

RNN模型

加入了一个隐变量(状态),隐变量由上个隐变量和上一个输入而更新,这样模型就可以达到具有短期记忆的效果。

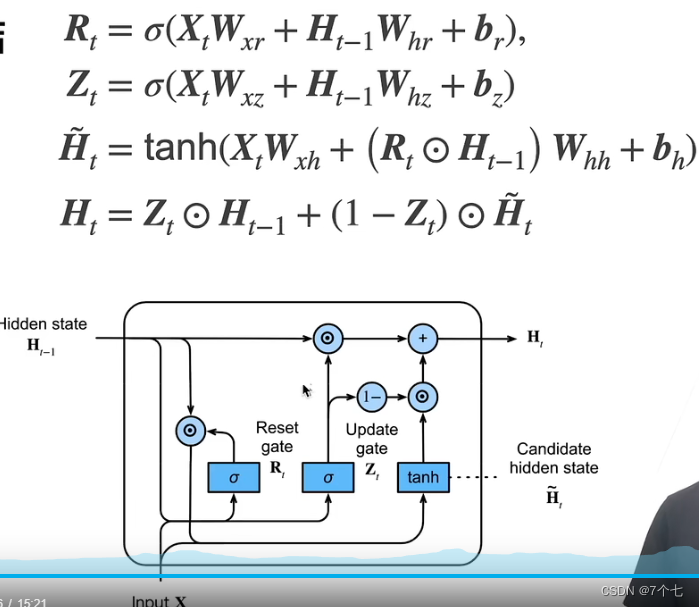

GRU

在RNN基础模型的基础上增加了2个门,能关注的机制(更新门Update gate),能遗忘的机制(遗忘门 Reset gate)

比如对于过去的记忆,Rt门控制了对于过去记忆保存的多少,成为候选状态

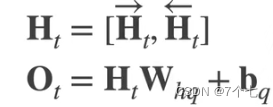

H

~

\widetilde{H}

H

t

Zt门控制了选用候选状态

H

~

\widetilde{H}

H

t的程度。

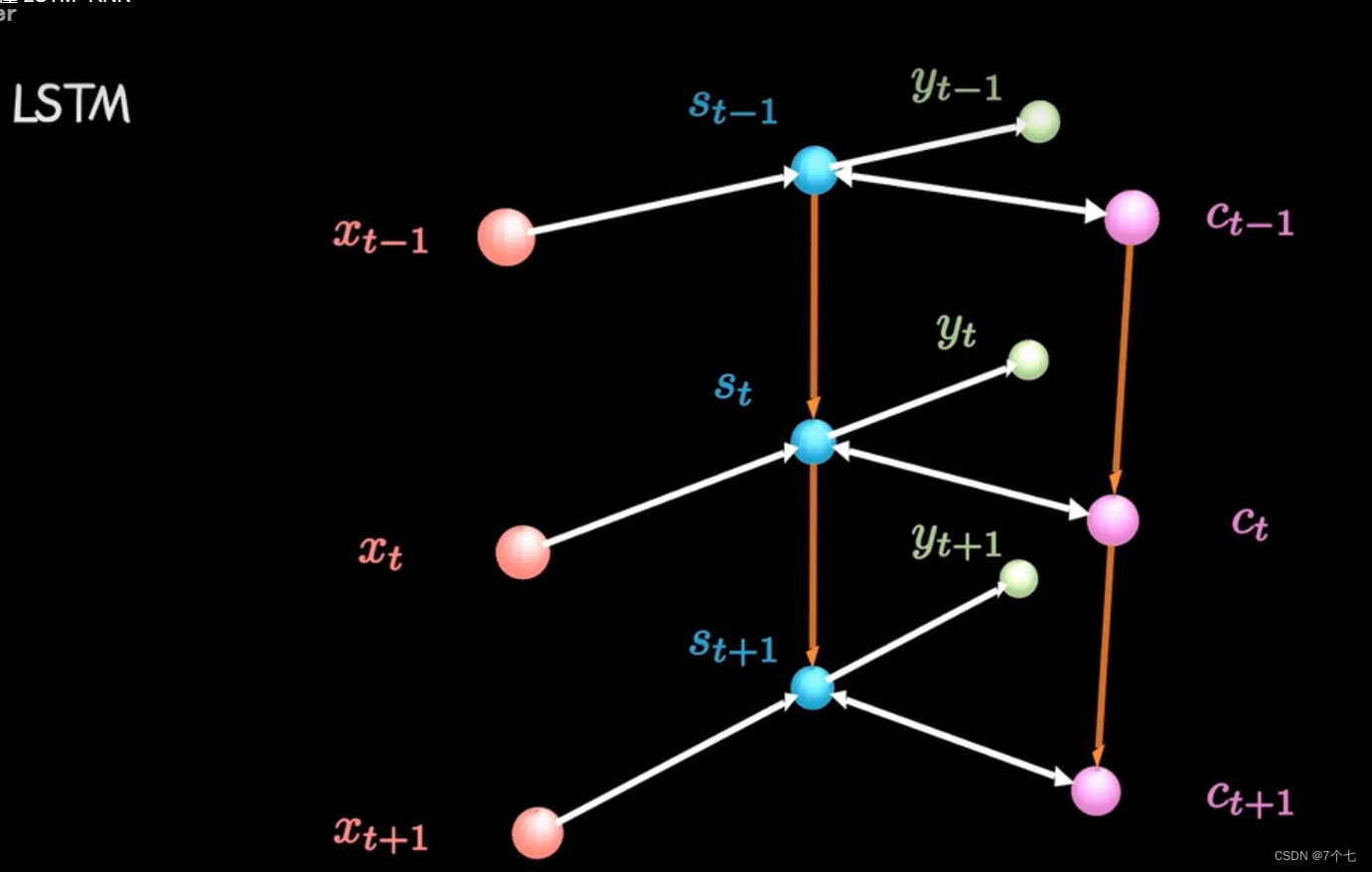

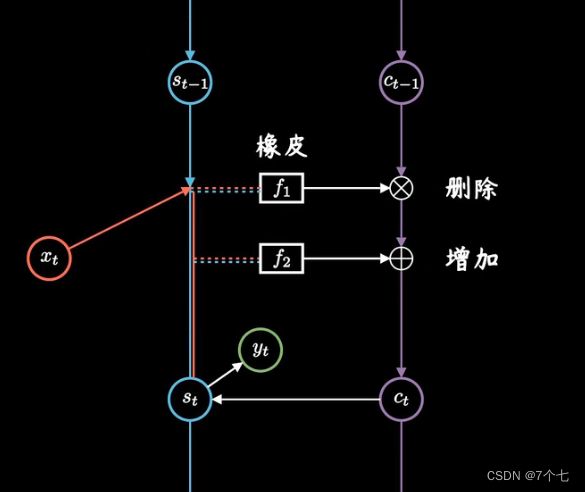

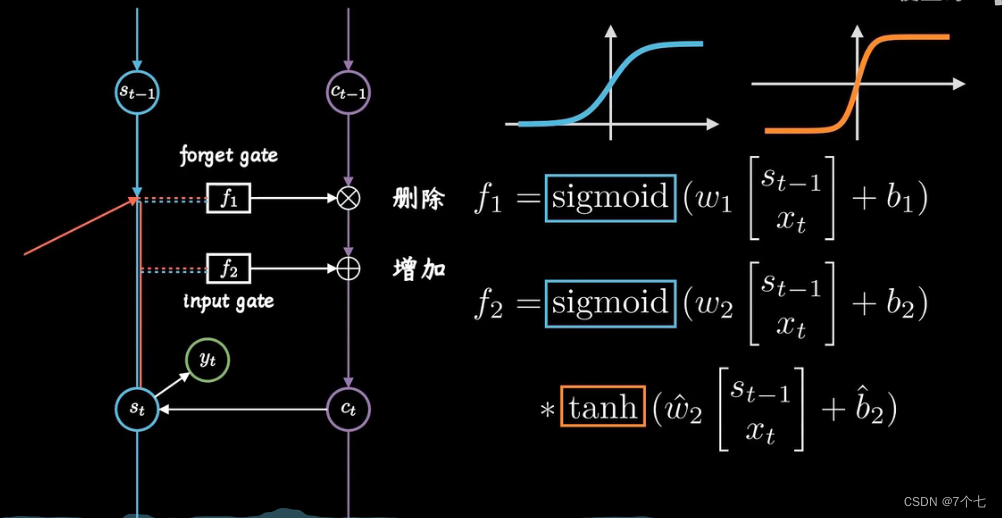

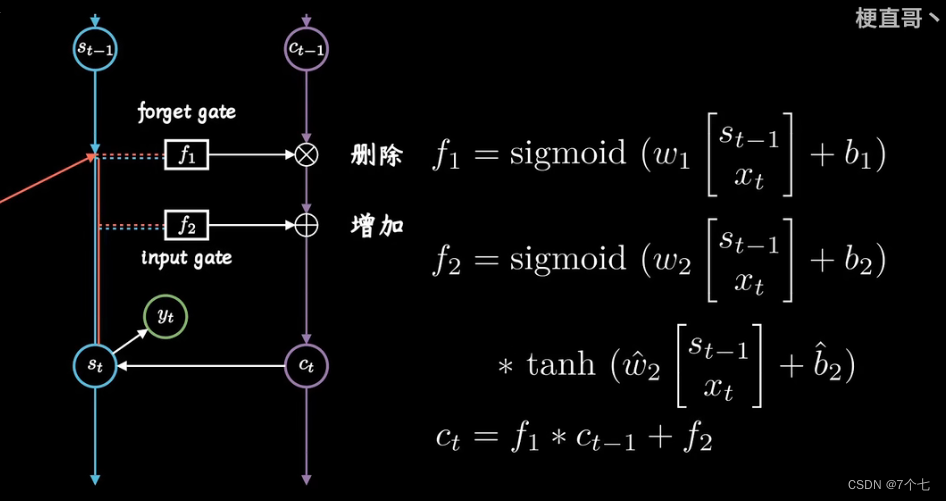

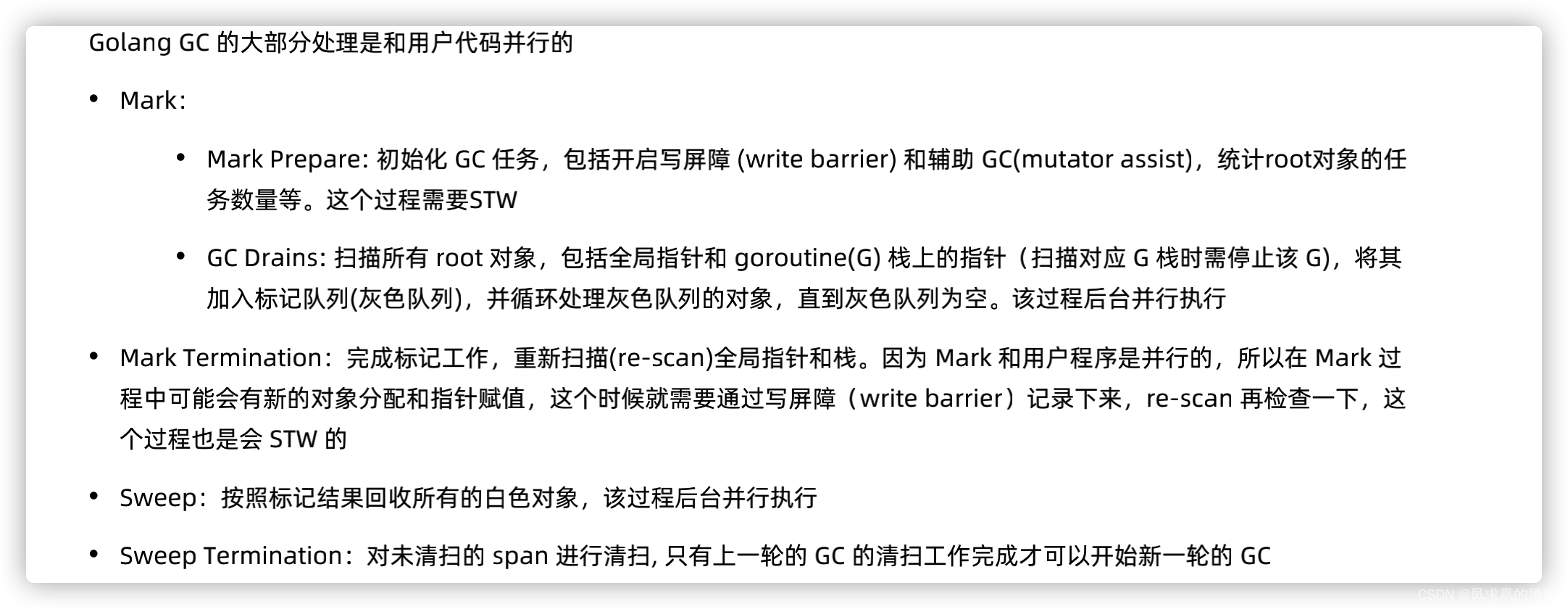

LSTM

和RNN相比,加入了新的时间链Ct(long term memory),可以形象的比喻为日记本,日记本有删除和增加操作:

根据此时的Xt和传过来上次的St-1对日记进行修改,再根据Xt和传过来上次的St-1增加。这样完成Ct的更新

更新后的Ct会和St-1、Xt对St进行更新

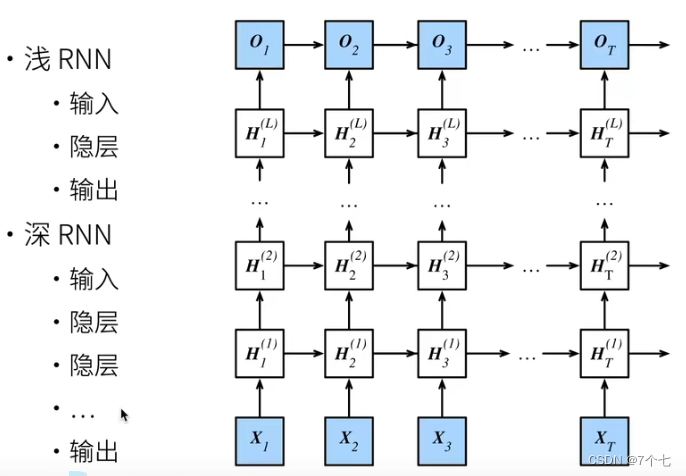

深度RNN

深度RNN就是增加隐藏层层数

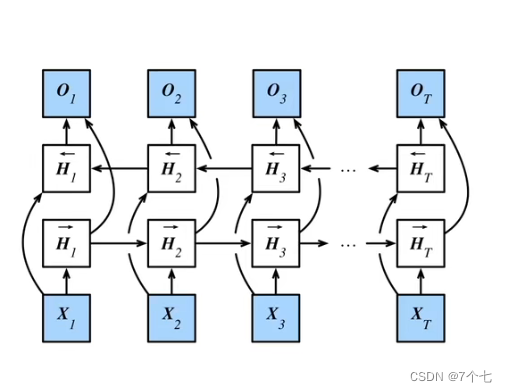

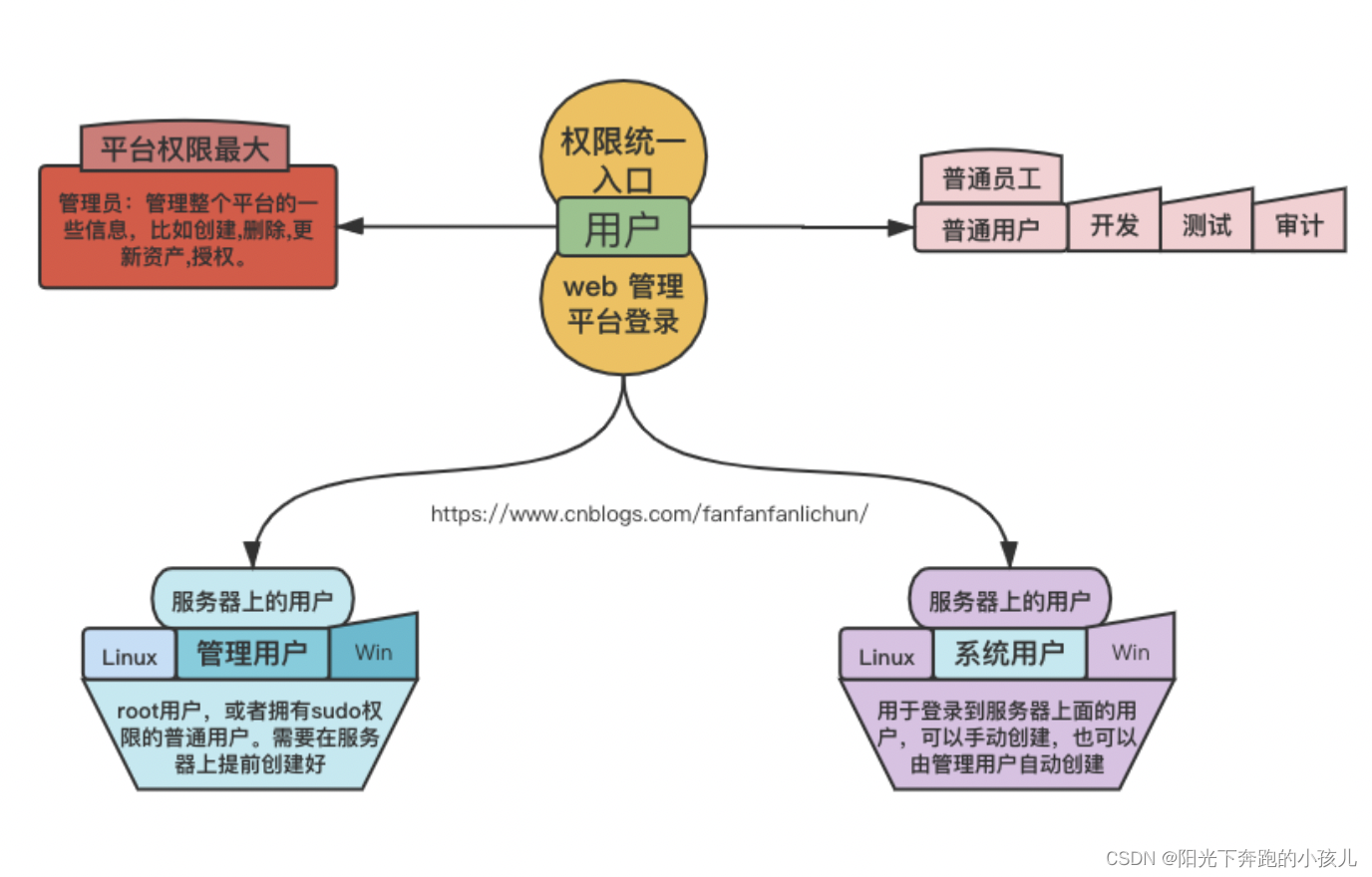

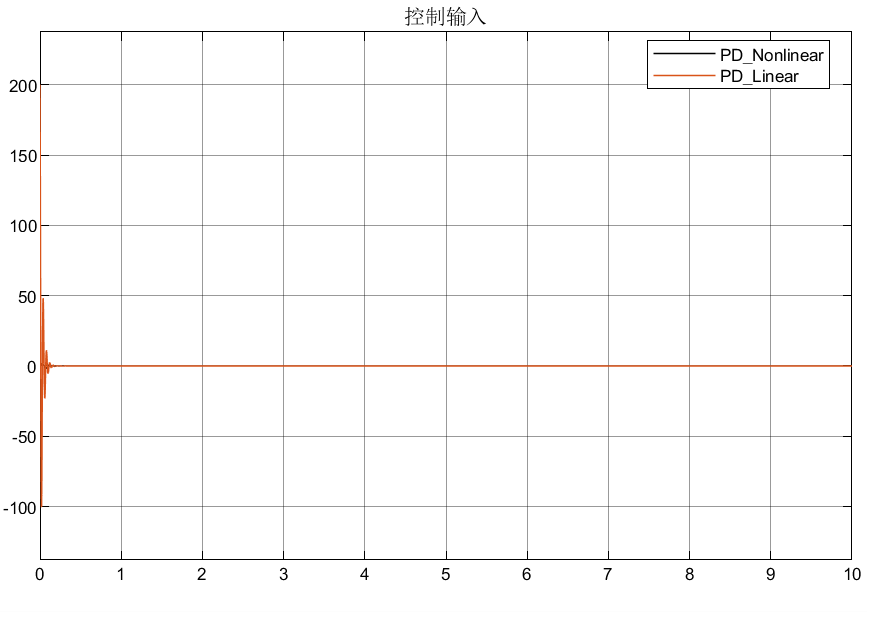

双向循环神经网络

双向循环神经网络实现大概思路 将输入数据正序输入得到output1,再将输入数据逆置换输入得到output2,再合并起来丢到最后一层。显然双向循环神经网络通常用来抽取特征、填空,而不能用于预测未来。

![[JAVA安全]Spring Messaging之CVE-2018-1270](https://img-blog.csdnimg.cn/8e9071123b5d41f1aa16ecef659275fc.png)