7.1集群间数据拷贝

- scp实现两个远程主机之间的文件复制

scp -r hello.txt root@hadoop103:/root/hello.txt // 推 push

scp -r root@hadoop103:/root/hello.txt hello.txt // 拉 pull

scp -r root@hadoop103:/root/hello.txt root@hadoop104:/root //是通过本地主机中转实现两个远程主机的文件复制;如果在两个远程主机之间ssh没有配置的情况下可以使用该方式。

- 采用distcp命令实现两个Hadoop集群之间的递归数据复制

[root@hdp101 hadoop-2.7.7]# bin/hadoop distcp hdfs://haoop102:9000/root/hello.txt hdfs://hadoop103:9000/root/hello.txt

7.2 小文件存档

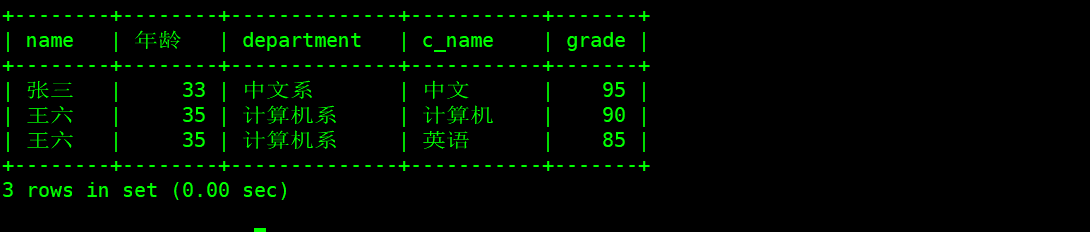

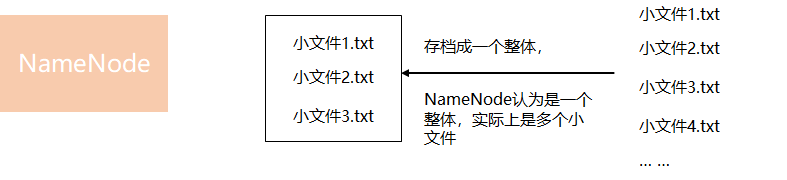

1、HDFS存储小文件弊端

每个文件均按块存储,每个块的元数据存储在NameNode的内存中,因此HDFS存储小文件会非常低效。因为大量的小文件会耗尽NameNode中的大部分内存。但注意,存储小文件所需要的磁盘容量和数据块的大小无关。例如,一个1MB的文件设置为128MB的块存储,实际使用的是1MB的磁盘空间,而不是128MB。

2、解决存储小文件办法之一

HDFS存档文件或HAR文件,是一个更高效的文件存档工具,它将文件存入HDFS块,在减少NameNode内存使用的同时,允许对文件进行透明的访问。实际上,HDFS存档文件对内还是一个一个独立文件,对NameNode而言却是一个整体,减少NameNode的内存。

3、基本命令

# 归档文件

hadoop archive -archiveName input.har -p input路径 output路径

# 查看归档

hadoop fs -lsr

# 解归档文件

hadoop fs -cp har:///user/test/input/input.har/* /user/test

4、案例实操

(1)需要启动YARN进程

[root@hdp101 hadoop-2.7.7]# start-yarn.sh

(2)归档文件

把/root/input目录里面的所有文件归档成一个叫input.har的归档文件,并把归档后文件存储到/root/output路径下。

[root@hdp101 hadoop-2.7.7]# bin/hadoop archive -archiveName input.har –p /root/input /root/output

(3)查看归档

[root@hdp101 hadoop-2.7.7]# hadoop fs -lsr /root/output/input.har

[root@hdp101 hadoop-2.7.7]# hadoop fs -lsr har:///root/output/input.har

(4)解归档文件

[root@hdp101 hadoop-2.7.7]# hadoop fs -cp har:/// user/atguigu/output/input.har/* /root

7.3回收站

开启回收站功能,可以将删除的文件在不超时的情况下,恢复原数据,起到防止误删除、备份等作用。

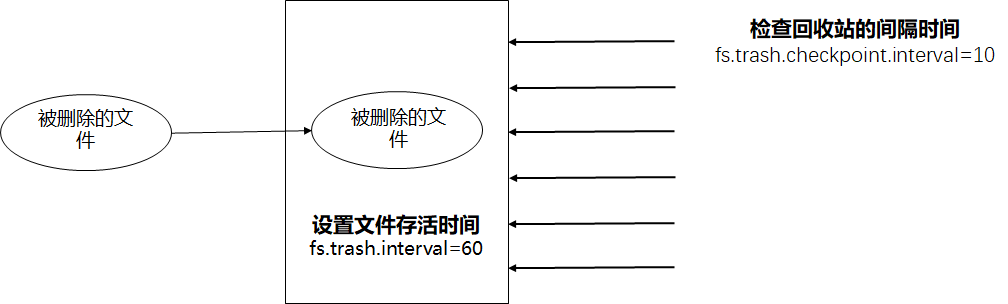

一、回收站参数设置及工作机制

1、默认值fs.trash.interval=0,0表示禁用回收站;其他值表示设置文件的存货时间。

2、默认值fs.trash.checkpoint.interval=0,检查回收站的间隔时间。如果该值为0,则该值设置和fs.trash.interval的参数值相等

3、要求fs.trash.checkpoint.interval ≤fs.trash.interval

二、回收站机制

三、实际操作

1、启用回收站

修改core-site.xml,配置垃圾回收时间为1分钟。

<property>

<name>fs.trash.interval</name>

<value>1</value>

</property>

2、查看回收站

回收站在集群中的路径:/root/.Trash/….

3、修改访问垃圾回收站用户名称

进入垃圾回收站用户名称,默认是dr.who,修改为atguigu用户

4、通过程序删除的文件不会经过回收站,需要调用moveToTrash()才进入回收站

Trash trash = New Trash(conf);

trash.moveToTrash(path);

5、恢复回收站数据

[root@hdp101 hadoop-2.7.7]# hadoop fs -mv

/root/.Trash/Current/root/input /root/input

6、清空回收站

[root@hdp101 hadoop-2.7.7]# hadoop fs -expunge

7.4快照管理

快照相当于对目录做一个备份,并不会立即复制所有文件,而是记录文件变化。

| 命令 | 描述 |

|---|---|

| hdfs dfsadmin -allowSnapshot 路径 | 开启指定目录的快照功能 |

| hdfs dfsadmin -disallowSnapshot 路径 | 禁用指定目录的快照功能(默认禁用) |

| hdfs dfs -createSnapshot 路径 | 对目录创建快照 |

| hdfs dfs -createSnapshot 路径 名称 | 指定名称创建快照 |

| hdfs dfs -renameSnapshot 路径 旧名称 新名称 | 重命名快照 |

| hdfs dfs lsSnapshotDir | 列出当前用户所有快照目录 |

| hdfs snapshotDiff 路径1 路径2 | 比较两个快照目录的不同之处 |

| hdfs dfs -deleteSnapshot

| 删除快照 |

- 案例实操

(1)开启/禁用指定目录的快照功能

[root@hdp101 hadoop-2.7.7]# hdfs dfsadmin -allowSnapshot /root/input

[root@hdp101 hadoop-2.7.7]# hdfs dfsadmin -disallowSnapshot /root/input

(2)对目录创建快照

[root@hdp101 hadoop-2.7.7]# hdfs dfs -createSnapshot /root/input

通过web访问hdfs://hdp101:50070/root/input/.snapshot/s……// 快照和源文件使用相同数据

[root@hdp101 hadoop-2.7.7]# hdfs dfs -lsr /root/input/.snapshot/

(3)指定名称创建快照

[root@hdp101 hadoop-2.7.7]# hdfs dfs -createSnapshot /root/input miao170508

(4)重命名快照

[root@hdp101 hadoop-2.7.7]# hdfs dfs -renameSnapshot /root/input/ miao170508 atguigu170508

(5)列出当前用户所有可快照目录

[root@hdp101 hadoop-2.7.7]# hdfs lsSnapshottableDir

(6)比较两个快照目录的不同之处

[root@hdp101 hadoop-2.7.7]# hdfs snapshotDiff

/root/input/ . .snapshot/atguigu170508

(7)恢复快照

[root@hdp101 hadoop-2.7.7]# hdfs dfs -cp /root/input/.snapshot/s20170708-134303.027 /user