Title:DRU-NET: AN EFFICIENT DEEP CONVOLUTIONAL NEURAL NETWORK FOR MEDICAL

IMAGE SEGMENTATION

摘要

本文的网络结构是受ResNet和DenseNet两个网络的启发而提出的。与ResNet相比本文的方法增加了额外的跳跃连接,但使用的模型参数要比DenseNet少的多。

基于先前的研究,由于其以多尺度方式捕获特征的能力,编码器-解码器的深度神经网络大多通过集成复杂的网络块(例如DenseNet和attentionNet)来实现更好的性能。然后这往往需要更多的参数。

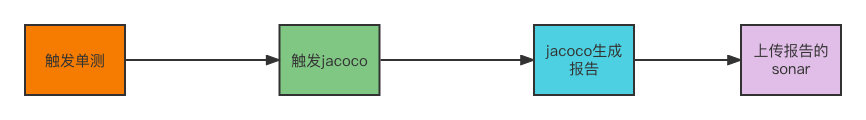

方法

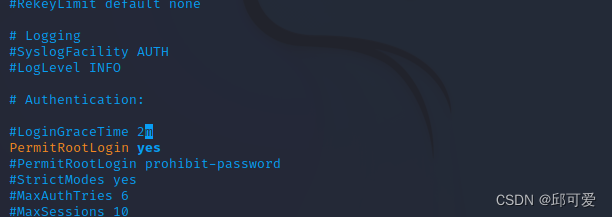

在本文的方法中,除了原始的UNet之外,每一层都增加了一个BN操作,通过使用这种方法可以更快的收敛和更稳定的进行训练。

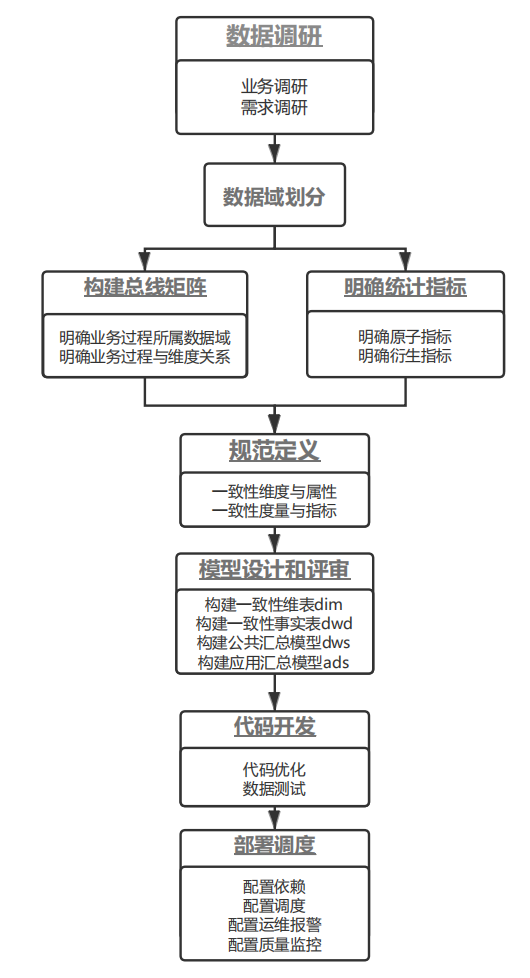

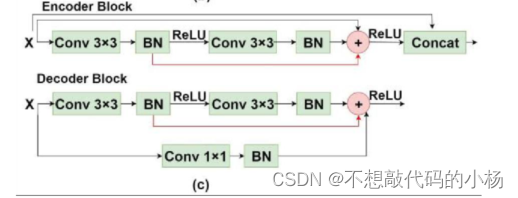

与传统的Conv-Relu操作不同,ResNet增加了跳跃连接。DenseNet由几个互相连接的DenseBlock构成。每个Dense块的输入是所有先前Dense块与第一个原始输入的级联特征图

与DenseNet相比,ResNet的一个缺点是缺乏对连续特征图所有先前卷积输出的密集连接原始ResNet在跳过连接中包含两个Conv操作(图1-(a))。如果在反向传播期间梯度在第二Conv处消失,则也不能更新第一Conv中的参数。相比之下,DenseNet利用了所有先前卷积的信息。但是DenseNet也其自身存在的固有问题,那就是较多的参数量和更重的计算负载。

通过考虑这两个网络的优缺点。本文建议在第一个卷积BN操作的输出与最后一个卷积BN的输出之间添加一个额外的连接(下图中红色快捷连接)并使用特征图聚合的求和操作。使用这个操作的原因是,添加的跳跃连接允许在第一个卷积中更新参数,即时在第二个卷积中的梯度接近于0.这也足以允许梯度被有效的反向传播

此外,对于本文方法的编码器路径中每一层将应用级联来组合输入输出。然后组合的特征图被送到下一层,这种连接不仅包括来自每个层的输入的更多信息,而且使特征图的维度与下一层中的特征图直接兼容。

此外在解码器部分使用1x1的卷积来减少输入通道数量,而不是裁剪输入通道以使尺寸与求和操作的层输出兼容。在一般情况下,如果使用了两个以上的卷积BN块,则需要将所有卷积BN操作的输出添加到最终的卷积BN输出中。

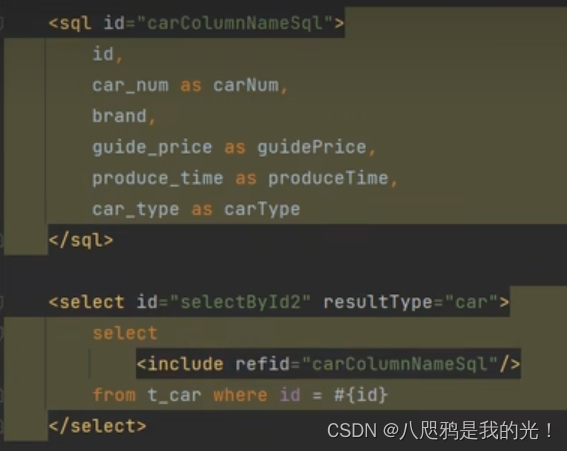

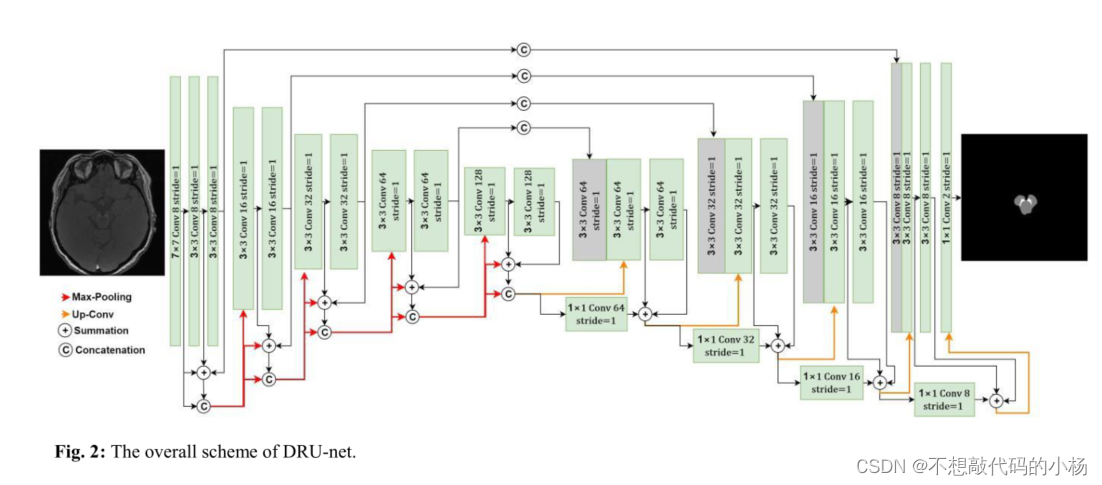

将上述提到的编码器和解码器应用到U型编解码器网络结构图如下:

总结

本文提出了一种简单而又高效的网络,旨在利用DenseNet和ResNet的优势,额外的小修改,如使用每一层的输入到输出的求和和级联来聚合特征图,使得特征学习过程更有效。通过评估公共皮肤损伤数据集和局部脑部MRI数据集上的方法,我们提出的DRU网已显示出显著优于U网、RU网和DU网,特别是对于像素数较少且训练示例数较少的标签类。