目录

- 一、引言:当Transformer遇到长序列瓶颈

- 二、核心技术解析:从暴力计算到智能优化

- 1. 局部敏感哈希注意力(LSH Attention):用“聚类筛选”替代“全量计算”

- 关键步骤:

- 数学优化:

- 2. 可逆残差网络(RevNet):让内存占用“逆生长”

- 3. 分块前馈层(Chunked FFN):细粒度内存优化

- 三、性能实测:效率与精度的双重突破

- 1. 复杂度对比

- 2. 精度验证

- 3. 速度优势

- 四、工业级应用场景:长序列处理的“刚需解法”

- 1. 超长文本理解(如法律合同、学术论文)

- 2. 实时推荐系统(用户行为序列建模)

- 3. 边缘设备部署(资源受限场景)

- 五、开源工具与落地建议

- 1. 主流框架集成

- 2. 调优关键点

- 3. 避坑指南

- 六、总结:Reformer的技术价值与未来

一、引言:当Transformer遇到长序列瓶颈

在自然语言处理领域,Transformer凭借自注意力机制在长距离依赖建模上展现出强大能力。然而,传统Transformer的注意力机制存在两个核心痛点:

- 平方级复杂度:注意力计算复杂度为 O ( L 2 ) O(L^2) O(L2),处理64K长度序列时,仅注意力矩阵就需16GB显存,直接导致长序列处理时显存溢出。

- 内存爆炸问题:深度网络中每层激活值都需存储,64层模型的内存占用随层数线性增长,训练成本呈指数级上升。

Google在ICLR 2020提出的Reformer模型,通过局部敏感哈希注意力(LSH Attention)和可逆残差网络两大核心技术,将计算复杂度降至 O ( L log L ) O(L\log L) O(LlogL),内存效率提升10倍以上,为超长序列处理(如10万+Token)打开了突破口。

二、核心技术解析:从暴力计算到智能优化

1. 局部敏感哈希注意力(LSH Attention):用“聚类筛选”替代“全量计算”

传统注意力需要计算每个Query与所有Key的相似度,而LSH Attention的核心思想是:仅关注与当前Query语义最接近的Key,通过哈希聚类快速筛选候选集合。

关键步骤:

- 向量归一化:将Key和Query归一化为单位向量,使相似度计算仅依赖方向(余弦相似度等价于点积)。

- 多轮随机投影哈希:

通过 n r o u n d s n_{rounds} nrounds 组随机投影矩阵生成哈希值,每组哈希将向量映射到不同桶中。例如,4轮哈希可将相似向量分到同一桶的概率提升至99%以上。 - 桶内局部计算:每个Query仅计算当前桶及相邻桶内的Key(通常前后各1个桶),将注意力矩阵从密集型转为稀疏型。

数学优化:

注意力公式引入掩码矩阵

M

M

M,仅保留同一桶内的有效位置:

Attention

(

Q

,

K

,

V

)

=

softmax

(

Q

K

T

d

k

⊙

M

)

V

\text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}} \odot M\right)V

Attention(Q,K,V)=softmax(dkQKT⊙M)V

复杂度从

O

(

L

2

)

O(L^2)

O(L2) 降至

O

(

n

r

o

u

n

d

s

⋅

L

⋅

c

)

O(n_{rounds} \cdot L \cdot c)

O(nrounds⋅L⋅c),其中

c

c

c 为平均桶大小(通常

c

≈

log

L

c \approx \log L

c≈logL)。

2. 可逆残差网络(RevNet):让内存占用“逆生长”

传统残差网络

y

=

x

+

F

(

x

)

y = x + F(x)

y=x+F(x) 需要存储每层激活值

x

x

x 用于反向传播,导致内存随层数

N

N

N 线性增长。

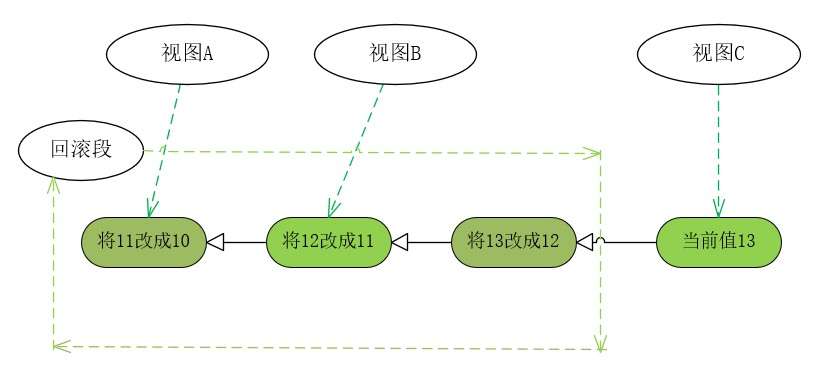

Reformer采用可逆结构,将输入分为两部分交替处理:

{

y

1

=

x

1

+

Attention

(

x

2

)

y

2

=

x

2

+

FeedForward

(

y

1

)

\begin{cases} y_1 = x_1 + \text{Attention}(x_2) \\ y_2 = x_2 + \text{FeedForward}(y_1) \end{cases}

{y1=x1+Attention(x2)y2=x2+FeedForward(y1)

反向传播时通过

x

2

=

y

2

−

FeedForward

(

y

1

)

x_2 = y_2 - \text{FeedForward}(y_1)

x2=y2−FeedForward(y1) 和

x

1

=

y

1

−

Attention

(

x

2

)

x_1 = y_1 - \text{Attention}(x_2)

x1=y1−Attention(x2) 重构输入,仅需存储单层激活值,内存复杂度从

O

(

N

⋅

L

⋅

d

)

O(N \cdot L \cdot d)

O(N⋅L⋅d) 降至

O

(

L

⋅

d

)

O(L \cdot d)

O(L⋅d)。

3. 分块前馈层(Chunked FFN):细粒度内存优化

前馈层中间维度

d

f

f

d_{ff}

dff 通常是模型维度的4倍(如4096),直接计算会占用大量内存。

Reformer将前馈层拆分为多个块,逐个处理每个块的计算:

Y

2

=

concat

(

FFN

(

Y

1

(

1

)

)

,

…

,

FFN

(

Y

1

(

c

)

)

)

Y_2 = \text{concat}\left(\text{FFN}(Y_1^{(1)}), \dots, \text{FFN}(Y_1^{(c)})\right)

Y2=concat(FFN(Y1(1)),…,FFN(Y1(c)))

通过调整块大小,可灵活平衡内存占用与计算速度,例如处理64K序列时内存占用减少75%。

三、性能实测:效率与精度的双重突破

1. 复杂度对比

| 指标 | 传统Transformer | Reformer | 提升幅度 |

|---|---|---|---|

| 时间复杂度 | O ( L 2 ) O(L^2) O(L2) | O ( L log L ) O(L\log L) O(LlogL) | 100倍+ |

| 内存复杂度(激活值) | O ( N L d ) O(NLd) O(NLd) | O ( L d ) O(Ld) O(Ld) | 随层数线性下降 |

| 64K序列显存占用 | 16GB+溢出 | 12GB可运行 | 显存节省50%+ |

2. 精度验证

- 合成任务:在序列复制任务中,4轮哈希的LSH Attention可达到99.9%的精度,接近全注意力(100%)。

- 文本任务:EnWiki8数据集上,Reformer困惑度2.85 vs 传统2.83,几乎无损失;翻译任务中BLEU得分28.1 vs 28.3,精度持平。

- 图像生成:ImageNet-64生成任务中,FID分数与Transformer相当,但推理速度提升4倍。

3. 速度优势

如图2所示,传统注意力耗时随序列长度呈平方级增长,而Reformer保持近似线性增长,处理16K序列时速度是传统方案的8倍。

四、工业级应用场景:长序列处理的“刚需解法”

1. 超长文本理解(如法律合同、学术论文)

- 场景:处理10万+Token的长文档,传统Transformer因显存限制无法运行。

- Reformer方案:通过LSH Attention筛选关键段落关联,可逆层节省内存,支持单卡处理64K+序列。

2. 实时推荐系统(用户行为序列建模)

- 挑战:用户历史行为序列可达10万次点击,需低延迟生成推荐。

- 优化点:哈希聚类快速匹配相似行为模式,分块计算降低在线推理延迟,显存占用减少90%,支持高并发部署。

3. 边缘设备部署(资源受限场景)

- 需求:在手机、IoT设备上运行轻量Transformer,功耗<1W。

- 方案:可逆层减少内存占用,LSH Attention降低计算量,使12层Reformer可在512MB显存设备上运行。

五、开源工具与落地建议

1. 主流框架集成

- Hugging Face:提供Reformer预训练模型及API,支持快速调用:

from transformers import ReformerModel model = ReformerModel.from_pretrained("google/reformer-crime-and-punishment") - Google Trax:官方JAX实现,支持TPU高效训练,代码库包含LSH Attention核心逻辑。

2. 调优关键点

- 哈希轮数:训练时用4轮平衡速度与精度,推理时可增至8轮提升精度(如Table 2中LSH-8达94.8%精度)。

- 块大小:根据显存大小调整,64K序列建议块大小128,内存占用降至1/512。

- 归一化策略:对Key/Query进行L2归一化,提升哈希聚类准确性。

3. 避坑指南

- 哈希冲突:极端情况下相似向量可能分至不同桶,可通过多轮哈希(≥4轮)降低概率。

- 位置编码:使用轴向位置编码(Axial Positional Embedding),避免哈希打乱序列顺序影响位置信息。

六、总结:Reformer的技术价值与未来

Reformer的核心贡献在于将Transformer从“暴力计算”转向“智能稀疏计算”,通过三大创新:

- LSH Attention:用哈希聚类实现注意力的“精准打击”,计算量下降两个数量级;

- 可逆层:颠覆传统残差结构,让内存占用不再随层数增长;

- 工程优化:分块计算、参数共享等细节设计,使理论优化落地为实际效率提升。

尽管在极端长序列(如100万Token)中仍需进一步优化哈希策略,但Reformer已为长文本处理、多模态生成等领域提供了可行方案。随着硬件加速(如TPU LSH专用单元)和动态哈希技术的发展,Transformer模型将在更长序列、更低资源消耗的场景中发挥更大价值。

参考资料

Reformer论文原文

Google Trax开源实现

Hugging Face Reformer文档

![Linux[指令与权限]](https://i-blog.csdnimg.cn/direct/c2235a19da5a43f089d847e4065bdf39.png)