据麦肯锡预测,到 2035 年或 2040 年,量子计算市场规模可能增长至约 800 亿美元。目前,许多量子比特技术正竞相成为首台通用、无差错量子计算机的基础,但仍面临诸多挑战。

我们将探讨量子计算的未来前景、潜力,以及它对个人和企业的影响。

走进量子计算

简而言之,量子计算利用量子力学的力量,帮助我们克服当今计算领域所面临的困难。然而,由于粒子的量子态是一种自然现象,这意味着它可以通过多种不同方式再现。

量子计算有潜力变革众多行业,因为此类计算机解决问题的速度比传统计算机快得多,且功耗更低。

因此,它将使企业能够更好地优化投资策略、加密方式,或发现新产品。其最广泛的应用领域包括密码学、数据分析、预测、模式搜索、药物研究等。

量子计算历史上的一个关键转折点是 “量子优越性” 概念的提出,它指的是量子计算机的性能超越最强大的经典超级计算机。这一成就表明,量子计算机处理复杂问题的速度比经典计算机快几十上百倍。

事实上,2019 年,谷歌在这一领域实现了量子优越性,达到了一个转折点,这表明将量子计算机用于实际有用的目的是可行的。

量子比特技术评估

目前尚未出现能够评估和比较可制造出完美量子计算机的量子比特技术的方法。不过,我们发现了评估这些技术时的六个关键考量因素和挑战:

1 .规模化保真度:这与量子计算的决定性限制密切相关,即在保持高质量水平的同时,增加量子比特的数量和复杂算法的计算能力。

-

计算速度:单个量子比特只能在有限时间内保持其量子态(相干性),因此,为了弥补这一点,门操作的速度应足够快,以便在量子比特失去相干性之前完成复杂计算。

-

多量子比特网络:能够连接在一起的量子比特越多,量子计算算法就越容易实现,最终得到的计算机性能也就越强。

-

规模化下对单个量子比特的控制:这种控制至关重要,但随着量子计算系统中量子比特数量的增加,对单个量子比特的控制变得越来越复杂。

-

冷却和环境控制:所需冷却设备在规模和功率方面的要求超出了现有设备的可行性范围。

-

制造:一些量子比特设计使用现有的生产技术,而另一些则需要新的制造技术。因此,此类生产将需要对组件进行规模化的自动化制造和测试。

核心量子比特技术

由于该行业和技术仍处于相对早期的发展阶段,麦肯锡选择了五种主要的量子比特技术:

- 光子网络:在这些网络中,每个量子比特都编码在单个光子中。首先制备初始的簇态,然后通过一系列光子测量来执行门操作。它们在大规模量子纠缠、速度以及在室温下运行的能力方面具有巨大潜力。相比之下,主要的误差来源是计算过程中光子的损失以及光子源的问题。

2.超导电路:其工作原理是将每个量子比特编码在约瑟夫森结两侧的库珀对的能级中。它们的优点包括相干性、处理速度和易于制造。此外,随着技术的成熟和更多量子比特的添加,它们可以继续使用。然而,规模化、校准、控制电子设备和冷却方面存在挑战。

-

自旋量子比特:在自旋量子比特系统中,每个量子比特都编码在半导体量子点的电子自旋中。在硅芯片上的纠缠电子之间建立双量子比特门,并且量子比特由微波电子设备控制。它们的尺寸小且制造简单是很大的优势,但它们面临着与超导体类似的许多挑战,例如规模化保真度和控制电子设备。

-

中性原子:在这项技术中,一个量子比特编码在一个原子的两个超精细基态能级中。它的优点涵盖从可扩展性到相干性和冷却等方面,但它面临的挑战主要集中在扩展到一百万个量子比特、控制电子设备以及错误率方面,目前这些方面还不太明确是否可行。

-

囚禁离子:在这里,每个量子比特都编码在一个离子的两个能级状态中。双量子比特门利用离子的激发电子态与离子链的振动模式之间的电子和声子之间的耦合。对于小型双量子比特门系统,在我们研究的这些技术中,这些囚禁离子的优点是错误率最低,并且与其他基于原子的技术相比,冷却要求也较低。规模化保真度也不是太大的挑战,因为量子比特可以被物理移动和操纵。然而,这些系统中量子比特数量的增加是最重要的障碍。

量子计算面临的挑战

尽管取得了显著进展,量子计算目前仍面临许多技术障碍,限制了其应用、可扩展性和可靠性。

由于量子比特的脆弱性、量子比特的互连性、退相干以及外部噪声,量子系统容易出错。因此,需要改进容错量子结构、量子比特相干时间和纠错方法。

另一方面,量子硬件(低温冷却系统、控制电路和量子比特制造)的制造仍然是一个技术挑战,需要跨学科的合作和创新。

- 退相干。与经典计算机相比,量子计算机极其容易受到噪声的影响,因为量子比特的量子态非常脆弱,任何干扰,如轻微的振动或温度变化,都可能对其产生不可控的影响,导致存储的信息丢失。

退相干给量子计算带来了挑战,因为为了避免错误,计算必须在退相干发生之前完成。虽然延长量子比特的相干时间是一个重要的研究领域,但解决这一问题的一个常用方法是开发纠错码。

虽然纠错码不是一个新概念,但在量子环境中,它们比在经典环境中面临更多的挑战,可能表现为相移、比特移位或两者的结合。此外,量子比特不能像经典比特那样被复制,这需要复杂得多的纠错码。

在这个过程中,通过将存储在逻辑量子比特中的量子信息编码在多个物理量子比特中,可以保护其免受错误的影响。现在有许多广泛使用的纠错码,每种码都代表了一种不同的编码量子信息的方式,例如肖尔码、斯特恩码或表面码。

- 可扩展性。可扩展性是指增加量子系统中量子比特数量的能力,以便能够解决更复杂的问题。

这是一个非常复杂的过程,因为很难连接大量的量子比特来创建更大的系统。一种可能的解决方案是使用纠错技术,该技术涉及在系统中创建冗余,以便进行错误检测和纠正。

然而,要取得成功,这些技术需要使用额外的量子比特和复杂的算法,这可能会使扩展过程更加复杂。

-

物理实现。构建量子计算机有不同的方法,例如超导电路、囚禁离子和拓扑量子比特。每种方法都有其自身的困难,目前尚不清楚哪种方法对于大规模量子计算来说是最可行的。

-

成本与可及性。目前,量子计算机价格昂贵,并且需要非常专业的环境才能运行。因此,这项技术面临的一大挑战是使其能够广泛应用。

-

人才与经验。量子计算领域需要深入理解量子力学、计算机科学和工程学,而目前这些领域的专业人才已经短缺。

找到在这三个领域都有专业知识的专业人员非常困难,这可能会减缓量子计算技术的开发和应用。

量子计算与人工智能

正如我们之前所讨论的,量子计算有潜力彻底改变许多领域,而量子计算与人工智能的结合尤其具有前景。

尽管我们仍处于理解如何用量子技术实现人工智能的早期阶段,但这种协同作用可能会带来许多潜在的好处和创新,包括人工智能能力的重大提升。

据美国国会技术大学(Capitol Technology University)称,量子计算可以提升人工智能的一些领域包括:

-

并行性与量子加速:量子计算机利用叠加和纠缠原理,使其能够同时执行多个计算。这种并行性可能会显著加速人工智能算法,特别是对于涉及处理大量数据集或解决复杂优化问题的任务。

-

优化与机器学习:量子计算对于解决机器学习中普遍存在的优化问题非常有用。量子算法(如量子近似优化算法 QAOA)可用于改进训练机器学习模型所涉及的优化任务,使过程更快、更高效。

-

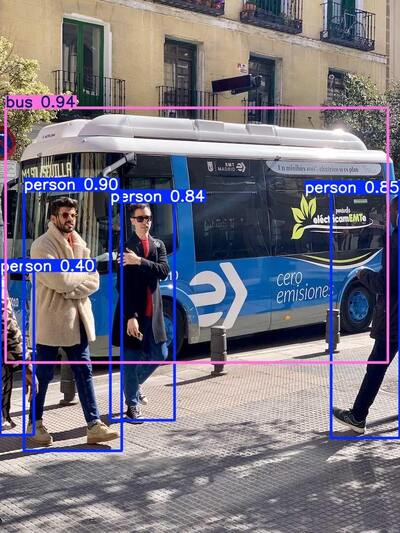

改进数据处理:由于其固有的并行性,量子计算机擅长处理和加工大量数据。这种能力可能会使需要大量数据处理的人工智能应用受益,例如自然语言处理(PLN)、图像识别和推荐系统。

-

增强加密与安全性:量子技术也对当前的加密方法构成潜在威胁,但也可用于增强人工智能应用中的安全性。一个例子是使用抗量子密码技术来保护敏感数据,确保人工智能系统的隐私和安全。

-

探索量子神经网络:量子神经网络是一个研究领域,旨在将量子计算原理与神经网络架构相结合。这可能会提供对复杂数据进行建模和表示的新方法,从而产生更强大和更具表现力的人工智能模型。

-

模拟量子系统:量子计算机擅长模拟量子系统,这可能对与量子化学、材料科学和药物研发相关的人工智能应用有益。这种能力可能会推动对复杂分子相互作用的理解以及新材料的设计取得进展。

-

能源效率:这种计算方式有可能以比经典计算机少得多的步骤解决问题,这可能会带来更节能的人工智能算法,特别是对于目前需要大量计算资源的任务。

至于量子驱动的人工智能可能面临的挑战以及未来发展,这些与量子计算本身所面临的挑战相同,例如可扩展性、纠错以及软件和编程等方面。

量子计算的未来

尽管量子计算面临诸多挑战,但其未来前景依然广阔。像国际商业机器公司(IBM)、谷歌和微软等科技巨头,以及其他研究公司,都在该领域投入了大量资金。

量子计算将成为科学研究的基础工具,使解决以前无法解决的问题变得更加容易。

研究人员在延长量子比特的相干时间、降低错误率以及开发新的量子算法方面不断取得进展。因此,各国政府也开始认识到量子计算的战略重要性,增加了资金投入并加强了合作。

随着技术的成熟,及时了解量子计算的发展动态至关重要。尽早确定这些应用场景,以及明确管理预期所涉及的挑战,这一点非常重要。这些应用场景可以在小规模上被证明是可行的,并且随着量子计算机量子比特数量的增加,相同的算法可以在更大的数据量上运行。量子计算能力的增长是呈指数级的,所以每增加一个量子比特,计算机的计算能力就会翻倍。

本文转载自 雪兽软件

更多精彩推荐请访问 雪兽软件官网