MPI(Message Passing Interface)和 NCCL(NVIDIA Collective Communications Library)都是用于并行计算和分布式计算的通信库,但它们的应用场景和设计目标有所不同。

MPI

-

设计目标:MPI 是一个通用的消息传递接口,广泛用于高性能计算(HPC)领域,支持多种硬件和网络环境。

-

应用场景:适用于大规模并行计算任务,如科学计算、气候模拟等。

-

特点:

-

支持点对点通信和集体通信。

-

跨平台,可在多种硬件和操作系统上运行。

-

提供丰富的通信原语,如

MPI_Send,MPI_Recv,MPI_Bcast等。

-

NCCL

-

设计目标:NCCL 是 NVIDIA 开发的专用于 GPU 间通信的库,优化了多 GPU 和多节点的集体通信操作。

-

应用场景:主要用于深度学习训练,特别是在多 GPU 和多节点环境下。

-

特点:

-

针对 NVIDIA GPU 和 NVLink、InfiniBand 等高速互连进行优化。

-

提供高效的集体通信操作,如

ncclAllReduce,ncclBroadcast等。 -

专为深度学习框架(如 TensorFlow、PyTorch)设计。

-

关系

-

互补性:MPI 是通用通信库,适用于多种并行计算任务;NCCL 则专注于 GPU 间通信,特别适合深度学习。

-

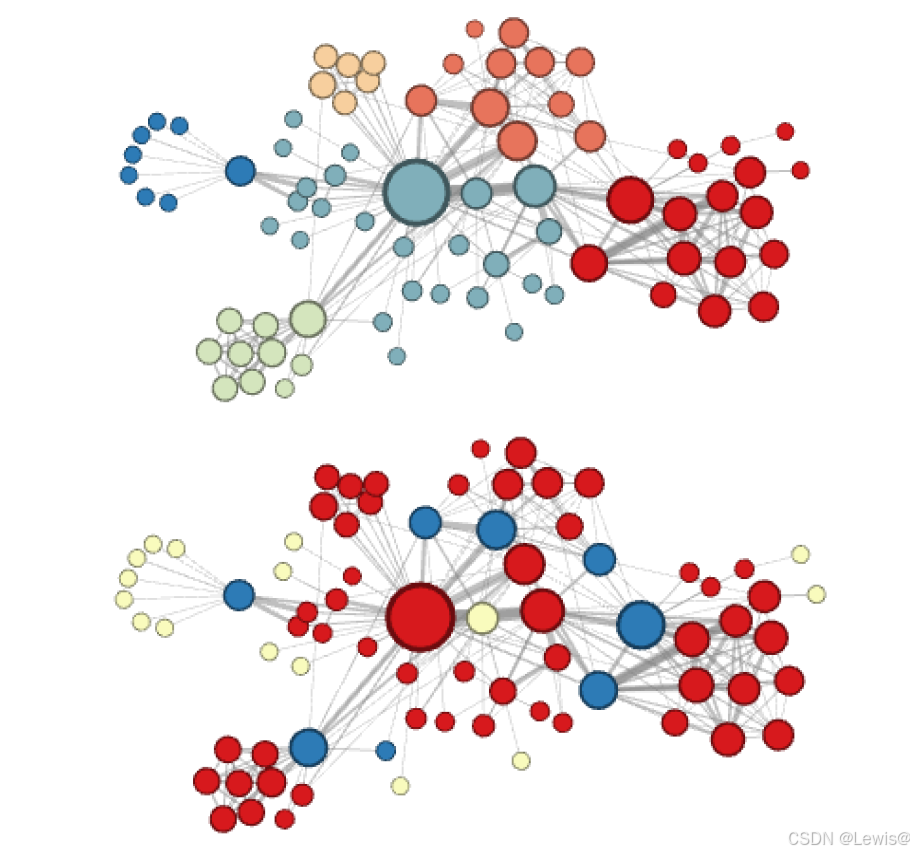

集成:在深度学习中,MPI 和 NCCL 可以结合使用。MPI 负责节点间通信,NCCL 负责节点内 GPU 间通信。例如,Horovod 框架就同时使用了 MPI 和 NCCL 来优化分布式训练。

总结

MPI 和 NCCL 各有侧重,MPI 适用于通用并行计算,NCCL 专注于 GPU 通信。在深度学习中,两者常结合使用以提升性能。