引言:一篇快速了解 DeepSeek 系列的论文。我在翻译时加入了一些可以提高 “可读性” 的连词

✅ NLP 研 2 选手的学习笔记

笔者简介:Wang Linyong,NPU,2023级,计算机技术

研究方向:文本生成、大语言模型

论文链接:https://www.techrxiv.org/doi/full/10.36227/techrxiv.173896582.25938392,2025 TechRxiv

中文标题:《DeepSeek 模型的综述》

文章目录

- 0 摘要(Abstract)

- 1 前言(Introduction)

- 2 相关工作(Related Work)

- 2.1 OpenAI GPT

- 2.2 Claude 3.5

- 2.3 LLama 3.1

- 2.4 Qwen 2.5

- 2.5 Gemini 2.0

- 3 Deepseek 及其变体(DeepSeek and Its Variants)

- 3.1 DeepSeek 7B

- 3.2 DeepSeek MoE-16B

- 3.3 DeepSeek V2

- 3.4 DeepSeek V3

- 3.5 DeepSeek R1-Zero

- 3.6 DeepSeek R1

- 4 讨论(Disscussion)

- 5 结论和未来工作(Conclusion and Future Work)

- 6 参考文献

- 7 补充说明

0 摘要(Abstract)

● 人工智能(AI)的进步依赖于能够进行类人(human-like)推理的系统,这是传统大型语言模型(LLMs)的限制,这些模型在多步逻辑、抽象概念化和潜在关系推理方面很困难。DeepSeek AI 通过计算高效的架构来解决这些挑战,包括 DeepSeek 专家混合框架(MoE,Mixture-of-Experts),在保持性能的同时降低了推理成本。DeepSeek v3(一种通用的 LLM,优化了指令遵循[instruction following]和推理)、DeepSeek Coder(代码生成和软件工程)、DeepSeek Math(符号和定量推理)、DeepSeek R1-Zero(纯强化学习,无监督微调)和 DeepSeek R1,这些模型设计了用于跨域问题解决的最小微调策略(minimal fine-tuning)。通过开源硬件不可知论的实现,DeepSeek 扩宽了对高性能 AI 的使用。本文综述了 DeepSeek 的架构进展,比较了其与最先进的 LLMs 的特点和局限性。本文还探讨了其对人工智能研究的影响,并对未来工作的潜在方向进行了详细讨论。

● 关键词:人工智能,类人推理(human-like reasoning),大型语言模型,DeepSeek,DeepSeek 专家混合框架(DeepSeek Mixture-of-Experts),DeepSeek V3,DeepSeek R1,DeepSeek R1-zero

1 前言(Introduction)

● 推理(Reasoning)是人类解决问题和做出决策的认知中,所不可或缺的一部分,是人工智能(AI)进步的核心,特别是在 LLMs 中,如 OpenAI 的 GPT-4.0、Claude 3.5、Llama 3.1、Qwen 2.5 和 Gemini 2.0 [1]-[5]。这些模型通过大型数据集中的统计模式(statistical patterns)来近似推理,从而推进自然语言处理(NLP)、代码生成和决策支持,并依赖于对标记数据的监督微调(SFT)。然而,它的计算成本很高,限制了更广泛的应用。此外,虽然在通用情况下是有效的,但由于性能的不一致,LLMs 在专项任务中是很困难的。特别是,多模态模型在空间推理和现实世界物理方面相当困难,而人工智能辅助的代码生成经常产生语法正确但功能上有缺陷的输出,需要人工监督。

● DeepSeek AI 成立于 2023 年,作为一项研究计划,以克服现有的限制和推进人工通用智能(artificial general intelligence,AGI),优先发展专项模型,以提高效率、适应性和领域专业知识 [6]。

● 在 2024 年,DeepSeek 引入了 DeepSeek Mixture-of-Experts(MoE,专家混合框架),这是一种专注于效率的架构,利用稀疏激活(sparse activation)来减少计算开销 [7]。随后,DeepSeek Coder 作为一个特定于代码的模型家族推出,从 1B 到 33B 参数,旨在简化软件开发工作流 [8]。DeepSeek Math(120B)数学相关标记可以处理高级数学和符号推理任务 [9]。DeepSeek 还推出了 V2 [10] 和 V3 [11]系列。V2 实现了多头潜在注意力(Multi-head Latent Attention,MLA)和一个具有 236B 总参数( 21B 激活)的 MoE 系统。开源模型V3 以 671B 的总参数优化了计算效率,每次查询仅激活 37B 个参数。它在 资源需求和监督数据 较少的复杂推理任务中表现出色。

● 在 2025 年,DeepSeek 发布了 R1 Zero,引入了自我验证、反思和扩展思维链(CoT),这是研究界的一个重大进步。DeepSeek 还引入了 R1,用于数学、编码和逻辑问题的解决,以增强研究和企业应用的自主决策和精度 [12]。(对于 R1 Zero 和 R1,后文有对比介绍)

● DeepSeek 开源了一套经过提炼的模型,针对在资源受限环境(如边缘计算平台或低内存系统)中的部署进行了优化。这些模型保持了可扩展性和成本效益,进一步扩展了 DeepSeek,使先进的人工智能可以跨越不同的用例。

● 本文概述了 DeepSeek 模型,重点介绍了其架构发展和应用。将它们与现有模型进行比较,概述了关键功能和局限性。还讨论了它们的进展对各个领域人工智能未来的潜在影响。

● 文章的组织结构如下:第 2 节介绍了相关工作,第 3 节讨论了 DeepSeek 模型及其变体,第 4 节进行了讨论,第 5 节总结了未来的研究方向。

2 相关工作(Related Work)

● 人工智能的最新进展促进了专用于推理、数学问题解决和代码生成的模型的发展,对通用 LLMs 进行了补充,这些模型在基于文本的任务中表现出色,但在数学精度和结构化问题解决方面存在困难。为了弥补这些差距,人工智能研究日益关注于增强下一代模型的推理能力和计算效率。

2.1 OpenAI GPT

● OpenAI 的 GPT-4 于 2023 年 3 月发布,是一个多模态模型,同时处理文本和图像 [1]。建立在 transformer 架构上,它在数学推理和语言理解等任务上超过了 GPT-3 [13],[14]。估计有 1.8T 参数,比 GPT-3 的 175B 大得多(1T = 1000B)。最初支持 8,192 个 token (GPT-4-8K)和 32,768 个token (GPT-4-32K)的上下文窗口。在 2023 年晚些时候,GPT-4 Turbo 的引入将此容量扩展到 128K 令牌。虽然 GPT-4 在图像描述和解决问题等任务中表现出色,但该模型可以生成听起来很合理但事实不正确或虚构的信息(幻觉),特别是在医学、法律或技术领域等专业领域。

2.2 Claude 3.5

● 2024 年发布的 Claude 3.5 是 Anthropic 语言模型家族 [2] 的最新进展。在以前版本的基础上,它强调安全性、对齐性和性能,并在推理、语言理解和处理文本和代码生成等复杂任务方面进行了改进。其参数约为 250B,在准确性和道德一致性方面优于早期模型。它支持多达 200K 个标记用于扩展上下文,支持更好地处理更大的输入。通过从人类反馈中强化学习(RLHF)和 Constitutional AI(宪法级人工智能)进行增强,它减少了不良反应、偏差,并更好地与人类意图保持一致。Claude 3.5 擅长于编码和科学推理等专业领域,具有更好的透明度和道德保障。然而,当复杂或模糊的输入接近上下文限制时,性能可能会下降。

2.3 LLama 3.1

● 2024 年发布的 LLaMA 3.1 是 Meta 的 LLaMA(大型语言模型Meta AI)家族的最新版本,此前是 LLaMA 1(2022)和 LLaMA 2(2023)[3]。LLaMA 1 具有多达 65B 参数,而 LLaMA 2 扩展到 70B 参数,具有较小的变体(7B,13B),增强了泛化和多语言能力。LLaMA 3.1 进一步改进了 405B 参数和 128K 令牌上下文窗口,通过分组查询注意力进行了改进,以获得更好的效率。LLaMA 3.1 擅长编码、逻辑问题解决和低资源语言任务。与 GPT-4 等封闭模型不同,它仍然是开放权重的,可自由用于研究和商业用途,但仅限于文本输入。还加了一些安全措施,例如自动化的 red-teaming(使用一个专门的团队来模拟攻击或从对手的角度测试系统的实践)和过滤训练数据,有助于将不期望的输出最小化。

2.4 Qwen 2.5

● 2024 年 6 月发布的 Qwen2 是 Qwen 系列的最新版本(阿里巴巴团队开发的),之前是 Qwen1.5(2024 年 2 月)和原始 Qwen( 2023 年 8月)[4]。Qwen1.5 具有高达 72B 参数的模型,强调效率和开源可达性,而 Qwen2 可扩展到 110B 参数,在推理、多语言支持和编码能力方面有所改进。

● Qwen2 利用了一个 128K 令牌上下文窗口,通过像 YaRN(上下文扩展微调)这样的创新来增强稳定的长上下文处理。它在数学推理、代码生成和低资源语言理解等任务上优于其前辈。所用的对齐技术包括 RLHF(基于人类反馈的强化学习)、直接偏好优化(Direct Preference Optimization,DPO)和仔细挑选的安全数据集,以减少不良反应。

2.5 Gemini 2.0

● Gemini 2.0 是谷歌最新的多模态 LLM,建立在版本 1.0 和 1.5 之上,提供更强大的跨文本,图像,音频和视频的生成 AI 能力[5]。Gemini 2.0 Flash 最初是作为试验性版本推出的,在不牺牲质量的情况下,其速度和效率明显优于其前身 Gemini 1.5 Flash。它支持智能体人工智能和原生工具使用,允许模型调用外部功能(谷歌搜索和地图),并集成流数据以扩展实时应用。通过在数学、代码生成、多语言音频输出等任务中提供更好的性能,并提高能源效率,Gemini 2.0 旨在为开发人员和最终用户提供全面的、具有较好成本效益的人工智能解决方案。

3 Deepseek 及其变体(DeepSeek and Its Variants)

● DeepSeek 模型建立在基于 transformer 的架构上,使用 分组查询注意力(Grouped Query Attention,GQA) 和 FlashAttention 2 [6] 进行优化。GQA 通过分组查询来共享 key-value 头来平衡效率和质量,FlashAttention 2 是一种计算感知的算法,通过分块和重计算来优化 GPU内存使用。这些增强减少了内存开销并提高了推理速度。核心的注意力机制遵循以下公式:

其中 Q (query)、K (key)和 V (value)是来自输入嵌入(embeddings)的投影,

d

k

d_k

dk 是缩放因子。

● 旋转位置嵌入(RoPE) 增强了 DeepSeek 中的位置编码,它通过旋转变换将相对位置信息嵌入到查询和键中。这使处理极长的 token序列(多达 200K 个 token)成为可能,克服了与长上下文任务相关的传统 transformer 约束。

3.1 DeepSeek 7B

● DeepSeek 7B 是一个 7B 参数模型,专为推理、编码和文本生成等通用任务而设计。它具有一个前范数(pre-norm),仅解码器的 Transformer 设置,在其前馈层中具有 RMSNorm 规范化和 SwiGLU 激活。该模型包含 RoPE 和 GQA,由 30 个 transformer 层、32 个注意力头和 4096 个隐藏维度组成,上下文窗口范围从 4K 到 32K token,通过 RoPE 可调节。DeepSeek Chat 是一个具有 67B 参数的更大变体,包括 95 个transformer层、64 个注意力头和 8192 个隐藏维度。

3.2 DeepSeek MoE-16B

● DeepSeek MoE-16B 是一个 16B 参数的 MoE 模型,通过 16 个专家网络 [7] 中的 2 个动态路由输入,每个 token 只激活 2.6B 参数。与类似大小的密集模型相比,这种稀疏激活降低了 70% 的推理成本,并保持了鲁棒的性能。它在各种数据集上进行了预训练,包括代码、数学和通用文本,专注于高质量数据和代码生成和数学推理等任务的专家专业化。表 1 给出了其他基于 DeepSeek 的专用变体。

| 模型 | 特点 | 说明 |

|---|---|---|

| DeepSeek Coder [8] | 1.3B - 33B | 属于以代码为中心的家族,针对存储库级别的代码完成和理解进行了优化,具有扩展的上下文窗口以处理复杂的编码任务。 |

| DeepSeek Math [9] | 使用 DeepSeek-Coder-Base v1.5 7B 和 120B 数学相关的 token 进行了预训练 | 专为高级数学解决问题而设计,通过特定领域的训练来处理具有竞争级别的挑战 |

3.3 DeepSeek V2

● DeepSeek V2 系列包括 60 层共 236B 和 21B 激活参数的 DeepSeek V2 和 DeepSeek V2 Lite,以及两个聊天机器人[10]。在架构上,它集成了 MLA、LoRA(低秩近似)和 MoE 框架,以减少内存使用,同时保持深度上下文理解。该系列在 8.1T token上进行了预训练,使用 YaRN(Yet Another RoPE Extention,YARN 是对 RoPE 的一种扩展,应用 YARN 后只需在少量的长文本数据上微调即可实现模型上下文长度的扩展)从 4K 扩展到 128K,并进行了 SFT,其中 1.2M 实例用于提升实用性,0.3M 实例用于提升安全性。该系列也通过 SFT 促进了未发布的 DeepSeek V2 Chat 的出现。它(DeepSeek V2)通过两个阶段的强化学习过程对 DeepSeek MoE 进一步进行了完善:第一阶段专注于数学和编码,使用基于编译器反馈和 ground-truth 标签的奖励模型;第二阶段的目标是实用性、安全性和规则遵从性,利用从人类偏好和人工编程中发展起来的三种奖励模型。

3.4 DeepSeek V3

● DeepSeek V3 代表了 LLMs 的重大升级,用来自多语言语料库的 14.8T token 进行预训练,并利用具有 671B 参数的稀疏 MoE 架构,每个任务[11]只激活 37B 的参数。该设计通过动态分配资源来满足特定的任务需求,从而降低运营成本,从而提高计算效率。

● 该模型包括一个由 1 个共享的路由专家和 256 个专用的路由专家组成的路由系统,具有动态偏差调整功能,确保专家利用率均衡,提高了可扩展性和可靠性。此外,多 token 预测(Multi-Token Prediction,MTP)增强了模型在复杂语言和推理任务中的能力。尽管其架构很先进,DeepSeek V3 仍然面临一些限制:

- 计算和硬件需求(Computational and Hardware Demands): 其

671B的参数需要高端硬件,限制了资源受限者的可使用性。 - 路由和负载平衡的复杂性(Complexity in Routing and Load Balancing): 模型的动态路由可能会导致路由错误或优先级过高,这可能会降低输出质量。为不同任务调整好动态偏差的研究仍然具有挑战性。

- 潜在注意力压缩风险(Latent Attention Compression Risks):MLA 在注意力模式中丢失了细节,损害了跟踪长上下文序列中细微依赖关系的能力。

其次,DeepSeek R1-Zero 和 DeepSeek R1 是 DeepSeek V3 架构的高级变体,旨在解决它的一些限制 [12]。

3.5 DeepSeek R1-Zero

● DeepSeek R1-Zero 在没有 SFT 的情况下通过强化学习进行训练,使用组相对策略优化(Group Relative Policy Optimization, GRPO),通过评估相对于一组采样节点的动作来简化训练过程 [9]。GRPO 通过基于分组的评分来计算优势,从而消除了对单独评论器模型的需求。对于每个问题 q q q, GRPO 从现行政策 π θ o l d π_{θ_{old}} πθold 中采样 G 输出 { o 1 , o 2 , ⋯ , o G } \{o_1, o_2,\cdots, o_G\} {o1,o2,⋯,oG}。政策的优化以以下目标为指导:

J G R P O ( θ ) = E [ ∑ i = 1 G min ( π θ ( o i ∣ q ) π θ old ( o i ∣ q ) A i , clip ( π θ ( o i ∣ q ) π θ old ( o i ∣ q ) , 1 − ϵ , 1 + ϵ ) A i ) − β D K L ( π θ ∣ ∣ π ref ) ] {J}_{\mathrm{GRPO}}\left( \theta \right) = \mathbb{E}\left\lbrack { \mathop{\sum}\limits_{i = 1}^{G} \min \left( \frac{ {\pi }_{\theta }( {{o}_{i} \mid q}) }{ \pi_{\theta_\text{old }}( {o}_{i} \mid q ) }A_i, {\operatorname{clip}\left( {\frac{{\pi }_{\theta }\left( {{o}_{i} \mid q}\right) }{{\pi }_{{\theta }_{\text{old}}}\left( {{o}_{i} \mid q}\right) },1 - \epsilon ,1 + \epsilon } \right) {A}_{i}}\right) - \beta {D}_{\mathrm{KL}} \left( {\pi }_{\theta}||\pi_{\text{ref}} \right) }\right \rbrack JGRPO(θ)=E[i=1∑Gmin(πθold (oi∣q)πθ(oi∣q)Ai,clip(πθold(oi∣q)πθ(oi∣q),1−ϵ,1+ϵ)Ai)−βDKL(πθ∣∣πref)]

其中, A i A_i Ai 是每个输出的优势,计算如下:

A i = r i − mean ( { r 1 , … , r G } ) std ( { r 1 , … , r G } ) {A}_{i} = \frac{{r}_{i} - \operatorname{mean}( \{ {{r}_{1},\ldots ,{r}_{G}}\}) }{\operatorname{std}( \{ {{r}_{1},\ldots ,{r}_{G}}\} ) } Ai=std({r1,…,rG})ri−mean({r1,…,rG})

其中, R i R_i Ri 表示每个输出的奖励,表示基于策略性能的行动的有效性。

另外,KL 散度惩罚 D K L D_{KL} DKL 确保策略更新与引用模型 π ref π_{\text{ref}} πref 紧密对齐,定义为:

D K L = π r e f ( o i ∣ q ) ( log π r e f ( o i ∣ q ) π θ ( o i ∣ q ) ) {D}_{\mathrm{{KL}}} = {\pi }_{\mathrm{{ref}}}( {{o}_{i} \mid q})\left( {\log \frac{{\pi }_{\mathrm{{ref}}}( {{o}_{i} \mid q) } }{{\pi }_{\theta }( {{o}_{i} \mid q) } } }\right) DKL=πref(oi∣q)(logπθ(oi∣q)πref(oi∣q))

● 奖励通过基于规则的信号指导优化过程,提高训练效率,防止黑客入侵。准确度奖励(Accuracy Reward)通过确定性检查确保答案正确,例如验证数学解答是否符合要求的格式,或代码是否通过指定的测试。格式奖励(Format Reward)通过要求推理和答案都在 <think>和 <answer> 标签内进行格式化,从而强制进行结构化推理。裁剪范围和惩罚系数

β

β

β 等超参数调节了策略更新的稳定性和粘附性,保持了平衡的学习过程。

● 上图 展示了 DeepSeek R1-Zero 模型的训练过程,显示了从输入到输出的流程。最初,输入由 LLM 处理。它们通过 GRPO 进行进一步细化,并根据 RLHF 进行调整,产生最终输出。这个循环确保了模型不断改进,在复杂任务和操作效率方面表现出色。

● DeepSeek R1-Zero 鼓励迭代自我反思和扩展推理链等涌现行为,提高了复杂任务的准确性。然而,挑战包括可读性差和语言混合。此外,当对每一组的 N N N 较小或缺乏多样性时,基于组(Group)的优势估计可能会出现高方差,导致策略更新不稳定。

3.6 DeepSeek R1

● DeepSeek R1 按顺序生成 token,并通过产生思维 token 来阐明其推理过程,从而将额外的时间用于解决问题,如 上图 所示。其训练流程包括如下步骤,如 下图 所示。

- 冷启动微调(Cold-start fine-tuning): 使用经过策划的数据集和思维链(CoT)来提高清晰度并加速强化学习。

- 以推理为中心的强化学习(Reasoning-focused RL): 通过基于规则的奖励提高编码、数学和逻辑。

- 拒绝采样和监督微调(Rejection sampling and supervised fine-tuning): 改进回答,并将能力扩展到写作、事实问答和角色扮演。

- 最终强化学习对齐(Final RL alignment): 确保坚持人类对有用性和安全性的偏好。

● 以下是 DeepSeek R1 模型的主要增强:

1) 改进的搜索策略(Improved Search Strategies): 蒙特卡洛树搜索(Monte Carlo Tree Search,MCTS),受 AlphaGo 的启发,之前试图系统地探索解空间,但被证明在计算上是不可实现的,原因是:

> 扩展搜索空间(Expanded Search Space): 标记级的生成显著增加了复杂性。

> 有效的价值模型(Ineffective Value Models): 难以训练鲁棒的指导模型导致可扩展性差。

> 收敛到局部最优(Convergence to Local Optima): 该方法通常不能对 跨复杂推理任务 的泛化。

● DeepSeek R1 用更简单的 拒绝采样方法(rejection sampling approach) 取代了 MCTS,从中间 强化学习检查点 中选择高质量的响应(responses)。通过结合不同的奖励信号,该模型不仅在推理方面有所改进,而且与人类的偏好保持一致。

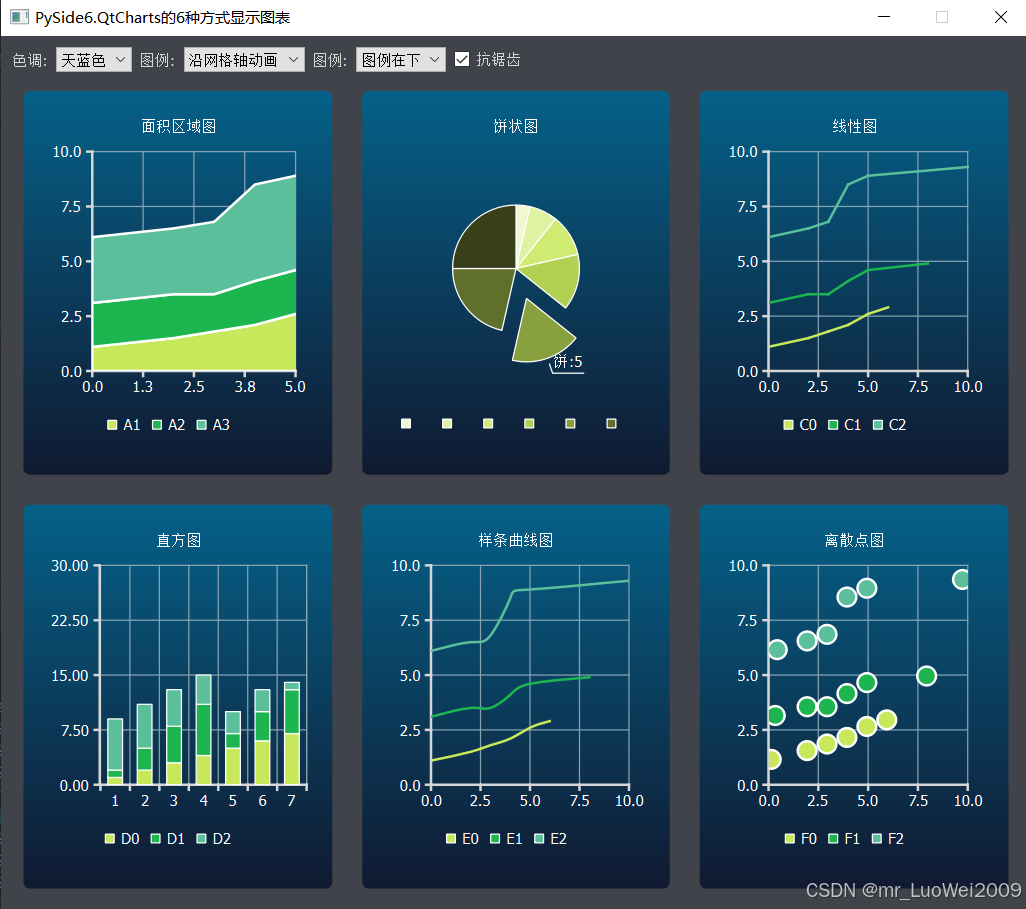

● 下表对 DeepSeek R1、ChatGPT-4、Claude 3.5、LLaMA 3.1、Qwen 2.5 和 Gemini 2.0 进行了综合比较。

| DeepSeek R1 | ChatGPT 4.0 | Claude 3.5 | LLaMA 3.1 | Qwen 2.5 | Gemini 2.0 | |

|---|---|---|---|---|---|---|

参数 | 671B | 1.8T(MoE) | 250B+ | 7B,13B,70B,405B | 最大72B | 未公开 |

上下文长度(以token为单位) | 128K | 128K | 200K | 128K | 128K | 1M |

多模态处理能力 | 文本 | 文本+图像+音频 | 文本+图像 | 文本+代码 | 文本+图像 | 文本+图像+音频+视频 |

推理方式 | 混合符号学习 | 思维链提示(CoT)、人工反馈强化学习(RLHP)、检索增强生成(RAG) | 宪法级人工智能、合成推理轨迹、少样本泛化 | 稀疏注意力、知识蒸馏 | 多跳推理、精细的对齐微调、跨语言迁移 | 多通道的推理 |

训练的数据 | 普通爬取数据、多语言数据 | 公开的文本 | 宪法级的人工智能规范 | 公共数据集、代码仓库、多语言文本 | 以中文为中心的数据、多语言语料库、特定领域的数据 | 普通爬取数据 |

输入1 百万个 token 的价格(以美元为单位) | 0.14 | 2.50 | 3.00 | 3.50 (对于 405B 的模型而言) | 0.40(对于 72B 的模型而言) | 免费 |

输出 1 百万个 token 的价格(以美元为单位) | 2.19 | 10.00 | 15.00 | 3.50 | 0.75 | 免费 |

目标用户 | 研究人员、企业的人工智能 | 一般用户、开发人员 | 法律/企业团队 | 研究与开发人员 | 中文市场 | 谷歌生态系统用户 |

API 是否可用 | 是 | 是 | 是 | 否(没有官方API,需通过第三方实现) | 否(没有官方API,需自行实现) | 是 |

优点 | 推理过程透明、成本高效、开源 | 多才多艺、有创造力、推理能力强 | 宪法级人工智能、长上下文处理 | 开源、可定制、能优化代码、低推理成本 | 强大的汉语处理能力、可处理双语任务 | 支持谷歌生态系统、支持多模态、能进行实时AI服务 |

限制 | 仅支持文本处理、存在格式问题和数据隐私问题 | 闭源、API昂贵、偶尔出现幻觉问题 | 具有过度谨慎的回复、多通道能力有限 | 硬件要求高、特定领域调优少 | 存在局部数据偏差问题、需要企业级基础设施 | 生成时的决策不够透明、符号推理有限 |

主要应用领域 | 研究、学术界、数学、编码、企业AI | 通用AI、内容生成、聊天机器人、编码 | 法律、合规、企业AI | NLP研究、开发工具、高性价比AI | 中文处理、阿里巴巴生态系统 | 跨媒体人工智能、实时人工智能服务、企业应用 |

● 这里附加一下原图(如果觉得翻译有出入,可自行对照阅读):

4 讨论(Disscussion)

● DeepSeek 与 GPT-4.0、Claude 3.5、LLaMA 3.1、Qwen 2.5 和 Gemini 2.0 等通用模型的区别在于,它优先考虑特定领域的优化、透明度和成本效率。主流 LLMs 专注于广泛的适应性,而 DeepSeek 专注于精确的推理和决策,使人工智能更实用和可靠。

● DeepSeek R1 是 DeepSeek 的最新变种,它集成了文本、数据库和知识图谱,采用思维链(Chain of Thought,CoT)进行分步推理,并采用 Pro Search 来获得上下文感知的答案。这提高了数学、编码和决策等领域的准确性,同时保持了清晰度。在编码中,R1 在给出答案之前概述它的逻辑,允许用户验证它的推理。

● 与专有模型不同,它(DeepSeek)是开放获取的,在降低成本的同时保持不同领域的竞争性性能。其高效的设计,包括 8 位浮点精度(FP8),优化了内存使用,使其能够在资源有限的环境中部署。通过降低财务和技术壁垒,DeepSeek 使资源受限的领域、较小的企业和研究人员可以获得先进的人工智能。

● DeepSeek R1、DeepSeek R1-Zero的早期版本存在格式不一致和多语言输出问题。为了解决这个问题,冷启动数据生成强制实施结构化格式化和简明的摘要以清晰。DeepSeek R1擅长:

- 优化计算(Optimized Computation): 与

32位模型相比,FP8减少了75%的内存需求。 - 特定任务的性能(Task Specific Performance): 基准测试表明,它在英语语言(DROP (

3-shotF1))、中文语言(CLUEWSC)、编码(HumanEval-Mul)和数学推理(MATH-500 (EM))方面与专有模型相匹配或优于专有模型。 - 可扩展性(Scalability): 其开放获取方法有利于医疗保健、金融和教育,这些领域的精度和成本效率至关重要。

5 结论和未来工作(Conclusion and Future Work)

● DeepSeek R1 改进了推理、效率、透明度和决策。它的效率和清晰的推理为资源节约和可理解的人工智能设定了新的标准。通过提供强大的开源性能,它挑战了专有模型,使先进的人工智能工具更容易获得,并在关键领域建立了信任。

● 未来的工作可以专注于将 DeepSeek R1 的基础能力应用于各种领域的现实挑战。在医疗保健领域,改进结构化症状分析和整合医学知识图谱可以提高诊断准确性。在教育领域,自适应辅导系统可以将复杂的概念分解为清晰、循序渐进的推理,使学习更加有效。在科学研究领域,科学研究可以受益于人工智能驱动的方法,这些方法将实验数据与理论模型连接起来,加速材料科学等领域的发现。

● 效率的提升可以通过更好的软硬件集成来实现,使 AI 在物联网和边缘设备上更有效地运行,同时降低能耗。确保自主系统和法律人工智能等高风险领域透明度的这一实现,需要可审查的推理路径和内置偏见缓解策略。通过社区驱动开发和专有增强的混合来扩展开源生态系统,可以帮助为公共和企业需求定制 AI 工具。

● 在这些领域之外,AI 在金融中的应用,如使用市场图分析的实时风险评估和通过地缘政治知识图谱集成的供应链管理,可以改变决策过程。展望未来,建立道德问责标准,向领域专家提供人工智能驱动的见解,以及完善平衡规模与精度的混合架构将是关键。DeepSeek R1 有潜力推动建立在效率、透明度和对现实世界的影响上的人工智能景观。

6 参考文献

[1] J. Achiam, S. Adler, S. Agarwal, L. Ahmad, I. Akkaya, F. L. Aleman, D. Almeida, J. Altenschmidt, S. Altman, S. Anadkat et al., “Gpt-4

technical report,” arXiv preprint arXiv:2303.08774, 2023.

[2] Anthropic, “Claude 3.5 sonnet,” Blog post, 2024, accessed: 2024-07-15. [Online]. Available: https://www.anthropic.com/news/claude-3-5-sonnet

[3] A. Dubey, A. Jauhri, A. Pandey, A. Kadian, A. Al-Dahle, A. Letman, A. Mathur, A. Schelten, A. Yang, A. Fan et al., “The llama 3 herd of

models,” arXiv preprint arXiv:2407.21783, 2024.

[4] A. Yang, B. Yang, B. Zhang, B. Hui, B. Zheng, B. Yu, C. Li, D. Liu, F. Huang, H. Wei et al., “Qwen2. 5 technical report,” arXiv preprint

arXiv:2412.15115, 2024.

[5] DeepMind, “Gemini 2.0,” https://deepmind.google/technologies/gemini/, 2023, accessed: 2025-01-01.

[6] X. Bi, D. Chen, G. Chen, S. Chen, D. Dai, C. Deng, H. Ding, K. Dong, Q. Du, Z. Fu et al., “Deepseek llm: Scaling open-source language models with longtermism,” arXiv preprint arXiv:2401.02954, 2024.

[7] D. Dai, C. Deng, C. Zhao, R. X. Xu, H. Gao, D. Chen, J. Li, W. Zeng, X. Yu, Y. Wu, Z. Xie, Y. K. Li, P. Huang, F. Luo, C. Ruan, Z. Sui, and W. Liang, “Deepseekmoe: Towards ultimate expert specialization in mixture-of-experts language models,” 2024. [Online]. Available: https://arxiv.org/abs/2401.06066

[8] D. Guo, Q. Zhu, D. Yang, Z. Xie, K. Dong, W. Zhang, G. Chen, X. Bi, Y. Wu, Y. Li et al., “Deepseek-coder: When the large language model meets programming–the rise of code intelligence,” arXiv preprint arXiv:2401.14196, 2024.

[9] Z. Shao, P. Wang, Q. Zhu, R. Xu, J. Song, X. Bi, H. Zhang, M. Zhang, Y. Li, Y. Wu et al., “Deepseekmath: Pushing the limits of mathematical reasoning in open language models,” arXiv preprint arXiv:2402.03300, 2024.

[10] A. Liu, B. Feng, B. Wang, B. Wang, B. Liu, C. Zhao, C. Dengr, C. Ruan, D. Dai, D. Guo et al., “Deepseek-v2: A strong, economical, and efficient mixture-of-experts language model,” arXiv preprint arXiv:2405.04434, 2024.

[11] A. Liu, B. Feng, B. Xue, B. Wang, B. Wu, C. Lu, C. Zhao, C. Deng, C. Zhang, C. Ruan et al., “Deepseek-v3 technical report,” arXiv preprint arXiv:2412.19437, 2024.

[12] D. Guo, D. Yang, H. Zhang, J. Song, R. Zhang, R. Xu, Q. Zhu, S. Ma, P. Wang, X. Bi et al., “Deepseek-r1: Incentivizing reasoning capability in llms via reinforcement learning,” arXiv preprint arXiv:2501.12948, 2025.

[13] A. Vaswani, “Attention is all you need,” Advances in Neural Information Processing Systems, 2017.

[14] R. Dale, “Gpt-3: What’s it good for?” Natural Language Engineering, vol. 27, no. 1, pp. 113–118, 2021.

7 补充说明

● 若有写得不对、欠妥的地方,或有疑问,欢迎评论交流。

⭐️ ⭐️ 完稿于 2025年3月4日 21:24 教研室工位 💻