以DeepSeek-R1或其他类似模型为例,涵盖环境配置、代码部署和运行测试的全流程:

准备工作

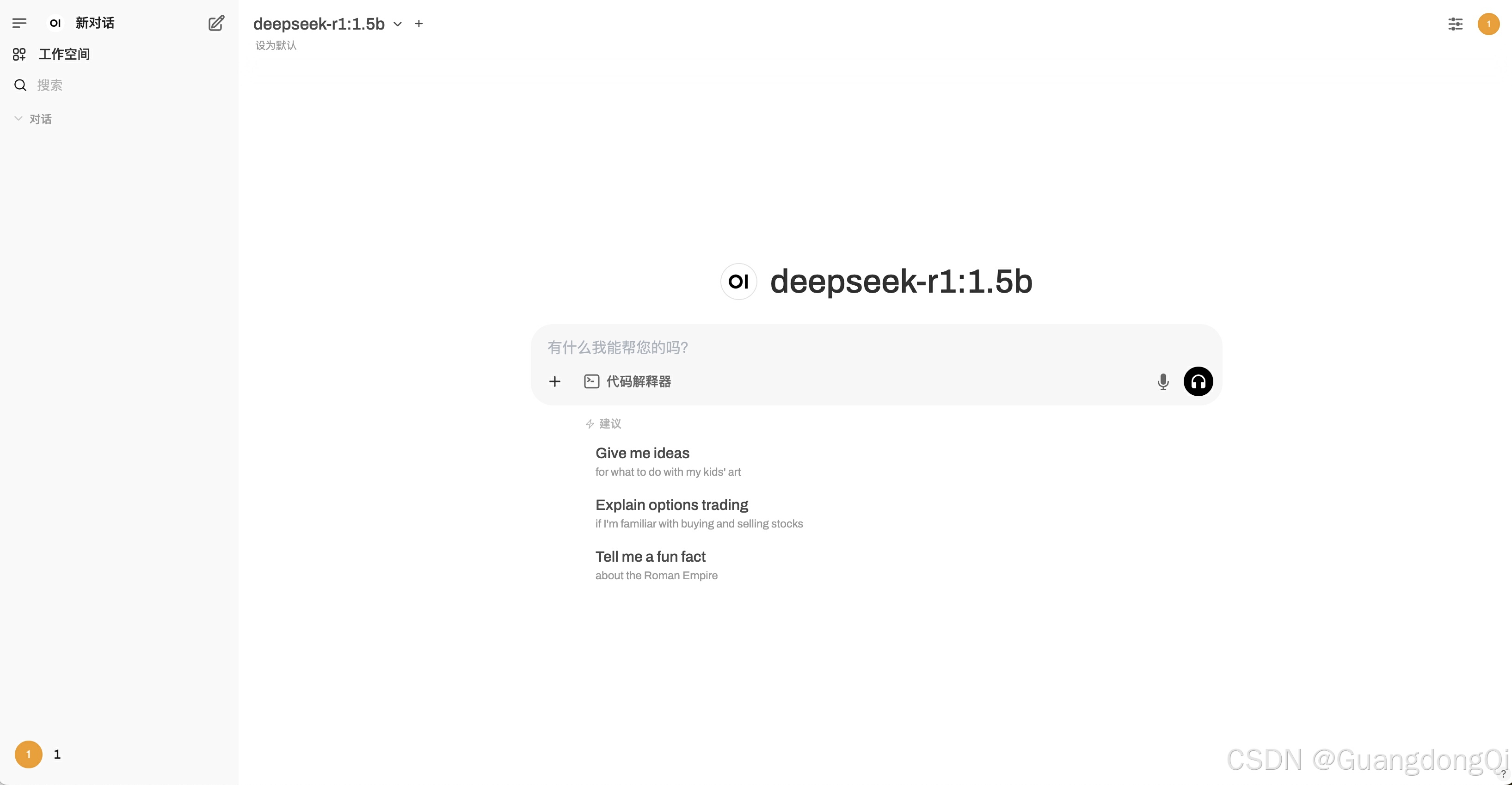

1. 注册 Cloud Studio

- 访问 [Cloud Studio 官网](https://cloudstudio.net/),使用腾讯云账号登录。

- 完成实名认证(如需长期使用)。

2. 创建工作空间

进入控制台,点击「新建工作空间」。

选择「Python」模板,配置资源:

运行环境:推荐选择 Ubuntu 18.04+(预装Python 3.8)。

资源规格:若需GPU加速,选择「GPU 加速型」;否则选「基础型」。

存储:至少分配 20GB 存储(模型文件通常较大)。

步骤 1:配置开发环境

1. 安装依赖库

打开 Cloud Studio 的终端(Terminal),依次执行以下命令:

```bash

# 更新系统包

sudo apt-get update

# 安装 Python 依赖

sudo apt-get install -y python3-pip python3-dev

# 安装 PyTorch(根据CUDA版本选择,若无GPU则用CPU版)

pip3 install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu117

# 安装 DeepSeek 所需依赖(假设项目需要)

pip3 install transformers datasets accelerate sentencepiece

```

2. 验证 GPU 可用性(如选择GPU环境)

```bash

nvidia-smi # 查看GPU信息

python3 -c "import torch; print(torch.cuda.is_available())" # 输出应为 True

```

步骤 2:部署 DeepSeek 模型

1. 克隆代码仓库

假设 DeepSeek 代码托管在 GitHub,例如官方仓库 `deepseek-ai/DeepSeek-R1`:

```bash

git clone https://github.com/deepseek-ai/DeepSeek-R1.git

cd DeepSeek-R1

```

若代码需权限访问,使用 SSH Key 或 Personal Access Token(需提前配置)。

2. 下载模型权重

从 Hugging Face 或官方渠道下载预训练模型(如 `deepseek-r1-base`):

```bash

# 示例:使用 huggingface-cli 下载

pip install huggingface_hub

huggingface-cli download deepseek-ai/deepseek-r1-base --local-dir ./model

```

3. 配置模型路径

修改代码中的模型加载路径(如 `config.json` 或 `inference.py`):

```python

# 示例代码片段

from transformers import AutoModel, AutoTokenizer

model = AutoModel.from_pretrained("./model")

tokenizer = AutoTokenizer.from_pretrained("./model")

```

步骤 3:运行推理测试

1. 编写测试脚本

- 在项目根目录创建 `demo.py`,添加示例推理代码:

```python

from transformers import pipeline

# 加载模型

generator = pipeline('text-generation', model='./model')

# 示例输入

prompt = "中国的首都是"

result = generator(prompt, max_length=50, num_return_sequences=1)

print(result[0]['generated_text'])

```

2. 执行推理

```bash

python3 demo.py

```

预期输出:生成与输入相关的文本,例如 `中国的首都是北京,位于华北平原...`。

步骤 4:部署为 API 服务(可选)

1. 安装 FastAPI 和 Uvicorn

```bash

pip install fastapi uvicorn

```

2. 创建 API 文件 `api.py`

```python

from fastapi import FastAPI

from pydantic import BaseModel

from transformers import pipeline

app = FastAPI()

generator = pipeline('text-generation', model='./model')

class RequestData(BaseModel):

prompt: str

max_length: int = 50

@app.post("/generate")

async def generate_text(data: RequestData):

result = generator(data.prompt, max_length=data.max_length)

return {"result": result[0]['generated_text']}

```

3. 启动服务

```bash

uvicorn api:app --host 0.0.0.0 --port 8080

```

4. 访问 API

在 Cloud Studio 的「端口」选项卡中,将端口 `8080` 设置为公开访问。

通过生成的临时 URL(如 `https://xxxx.cloudstudio.net`)调用 API:

```bash

curl -X POST "https://xxxx.cloudstudio.net/generate" \

-H "Content-Type: application/json" \

-d '{"prompt": "人工智能的未来是"}'

```

常见问题解决

1. 依赖冲突

使用虚拟环境隔离依赖:

```bash

pip install virtualenv

virtualenv venv

source venv/bin/activate

```

2. 模型下载失败

替换 Hugging Face 镜像源:

```bash

export HF_ENDPOINT=https://hf-mirror.com

huggingface-cli download ...

```

3. 显存不足(GPU环境)

- 减少批量大小(`batch_size`)或启用梯度裁剪。

通过以上步骤,成功在 Cloud Studio 上部署了 DeepSeek 模型,并可通过 API 提供服务。若需长期运行,建议绑定自定义域名并配置 HTTPS。

![[手机Linux] onepluse6T 系统重新分区](https://i-blog.csdnimg.cn/direct/1d68e82cb5c24ef3a410d702ffa25f2f.png)

![21.[前端开发]Day21-HTML5新增内容-CSS函数-BFC-媒体查询](https://i-blog.csdnimg.cn/direct/a3125995782f41b4b1ec54bc59b06a39.png)