目录

说明

1. AI云主机准备

1.1 Ollama配置

设置模型保存路径

配置模型驻留内存时间

查看GPU状况命令: nvidia-smi

2. Deepseek

2.1 安装与使用

3. LobeChat配置

参考

说明

调研并实例化各种AI方案,探索训练/使用方式的最佳实践。

1. AI云主机准备

可以去一些云主机服务商按小时租机器,我这里租用的是 GeForce RTX 4090 (24G) / Ubuntu 22.04云主机,有需要可点此连接申请

添加微软source公钥

wget -qO- https://packages.microsoft.com/keys/microsoft.asc | gpg --dearmor - | sudo apt-key add -

sh -c 'echo "deb [arch=amd64] https://packages.microsoft.com/repos/vscode stable main" > /etc/apt/sources.list.d/vscode.list'

更新

apt-get update && apt-get install -y apt-utils && apt-get install -y curl1.1 Ollama配置

说明:Ollama是可以运行多个LLM的集成应用,并提供api调用接口

# 安装

curl -fsSL https://ollama.com/install.sh | sh设置模型保存路径

mkdir /data/models

chown ollama:ollama /data/models

# 编辑 /etc/systemd/system/ollama.service,允许外部连接,允许跨域

[Service]

Environment="OLLAMA_MODELS=/data/models"

Environment="OLLAMA_HOST=0.0.0.0:11434"

Environment="OLLAMA_ORIGINS=*"

# 重启服务

systemctl daemon-reload

systemctl restart ollama配置模型驻留内存时间

curl http://localhost:11434/api/generate -d '{"model":"deepseek-r1:32b","keep_alive": "24h"}'

curl http://localhost:11434/api/generate -d '{"model":"deepseek-r1:7b","keep_alive": "24h"}'

# 无限期驻留

curl http://localhost:11434/api/generate -d '{"model":"deepseek-r1:32b","keep_alive": -1}'查看GPU状况命令: nvidia-smi

(base) root@app-9be824d5-463a-436f-8a2a-06a1aaf9da00:~# nvidia-smi

Sat Feb 8 11:26:30 2025

+-----------------------------------------------------------------------------------------+

| NVIDIA-SMI 550.127.08 Driver Version: 550.127.08 CUDA Version: 12.4 |

|-----------------------------------------+------------------------+----------------------+

| GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+========================+======================|

| 0 NVIDIA GeForce RTX 4090 Off | 00000000:09:00.0 Off | Off |

| 30% 33C P5 50W / 450W | 5628MiB / 24564MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

+-----------------------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=========================================================================================|

| 0 N/A N/A 1226 G /usr/lib/xorg/Xorg 4MiB |

| 0 N/A N/A 134315 C ...rs/cuda_v12_avx/ollama_llama_server 5610MiB |

+-----------------------------------------------------------------------------------------+

2. Deepseek

2.1 安装与使用

版本:1.5b,适用于一般文字编辑使用(需要1.1GB空余空间)

ollama run deepseek-r1:1.5b

版本:7b,DeepSeek的第一代推理模型,性能与OpenAl-01相当,包括从基于Llama和Qwen的DeepSeek-R1中提取的六个密集模型(需要

4.7GB空余空间)

ollama run deepseek-r1:7b

版本:8b,(需要4.9GB空余空间)

ollama run deepseek-r1:8b

版本:14b,(需要9GB空余空间)

ollama run deepseek-r1:14b

版本:32b,(需要20GB空余空间)

ollama run deepseek-r1:32b

版本:70b,(需要43GB空余空间)

ollama run deepseek-r1:70b

版本:671b,(需要404GB空余空间)

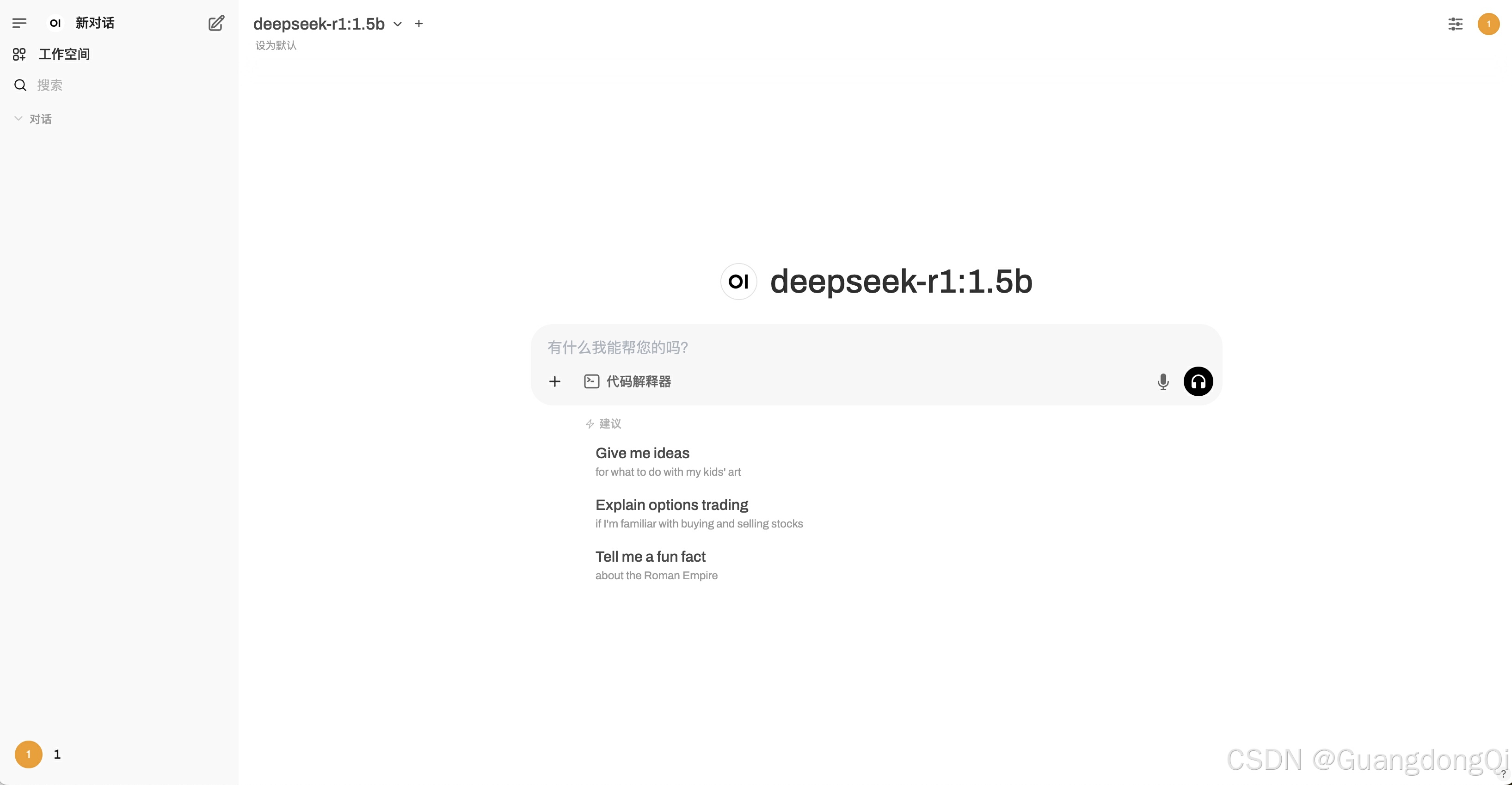

ollama run deepseek-r1:671b3. LobeChat配置

说明:LobeChat是一个LLMs 聊天应用与开发框架 (官网:GitHub - lobehub/lobe-chat: 🤯 Lobe Chat - an open-source, modern-design AI chat framework. Supports Multi AI Providers( OpenAI / Claude 3 / Gemini / Ollama / Qwen / DeepSeek), Knowledge Base (file upload / knowledge management / RAG ), Multi-Modals (Vision/TTS/Plugins/Artifacts). One-click FREE deployment of your private ChatGPT/ Claude application.)

找台服务器,配个docker compose容器方式运行

lobe-chat:

image: lobehub/lobe-chat

container_name: lobe-chat

restart: always

ports:

- '3210:3210'

environment:

ACCESS_CODE: youknow

DEFAULT_AGENT_CONFIG: |

model 'deepseek-r1'

provider 'ollama'

params.max_tokens 300

plugins 'search-engine,lobe-image-designer'

tts.sttLocale 'zh-CN'

ENABLED_OPENAI: 0

ENABLED_OLLAMA: 1

LLM_HOST: "https://ollama-api.your.com:30133"

OLLAMA_PROXY_URL: "https://ollama-api.your.com:30133"

OLLAMA_MODEL_LIST: deepseek-r1

初次访问如果不能正常运行,可能需设置下应用设置中的Ollama服务地址:

效果

参考

- LobeChat Model Service Providers - E... · LobeHub

- 在ubuntu系统中下载ollama并且修改ollama中模型的保存路径_ollama 修改模型路径-CSDN博客

- 轻松部署 DeepSeek R1:基于 Ollama、Chatbox 平台的操作指南-CSDN博客

- 手把手教你使用 Ollama 和 LobeChat 快速本地部署 DeepSeek R1 模型,创建个性化 AI 助手-阿里云开发者社区

![[手机Linux] onepluse6T 系统重新分区](https://i-blog.csdnimg.cn/direct/1d68e82cb5c24ef3a410d702ffa25f2f.png)

![21.[前端开发]Day21-HTML5新增内容-CSS函数-BFC-媒体查询](https://i-blog.csdnimg.cn/direct/a3125995782f41b4b1ec54bc59b06a39.png)