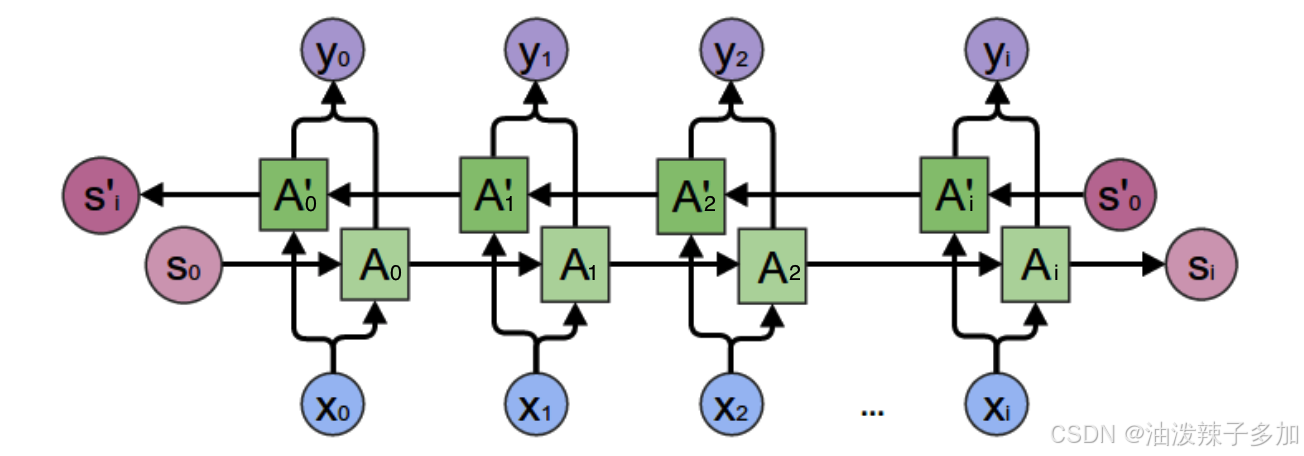

1. 模型架构

RNN(Recurrent Neural Network)是一种具有循环结构的神经网络,它能够处理序列数据。与传统的前馈神经网络不同,RNN通过将当前时刻的输出与前一时刻的状态(或隐藏层)作为输入传递到下一个时刻,使得它能够保留之前的信息并用于当前的决策。

- 输入层:输入数据的每一时刻(如时间序列数据的每个时间步)都会传递到网络。

- 隐藏层:RNN的核心是循环结构,它将先前的隐藏状态与当前的输入结合,生成当前的隐藏状态。通常,RNN的隐藏层包含多个神经元,且它们的状态是由上一时刻的输出状态递归计算得来的。

- 输出层:基于隐藏层的输出,生成预测结果。

RNN通过共享参数和权重来处理任意长度的序列输入,能够用于语言模型、时间序列预测等任务。

2. 算法实现(PyTorch)

在PyTorch中实现一个简单的RNN模型,通常需要以下几个步骤:

import torch

import torch.nn as nn

import torch.optim as optim

import torch.nn.functional as F

from sklearn.metrics import mean_squared_error

import matplotlib.pyplot as plt

# 定义RNN模型类

class RNN(nn.Module):

def __init__(self, input_size, hidden_size, num_layers, forecast_horizon):

super(RNN, self).__init__()

self.input_size = input_size

self.hidden_size = hidden_size

self.num_layers = num_layers

self.forecast_horizon = forecast_horizon

# 定义RNN层

self.rnn = nn.RNN(input_size=self.input_size, hidden_size=self.hidden_size,

num_layers=self.num_layers, batch_first=True)

# 定义全连接层

self.fc1 = nn.Linear(self.hidden_size, 64)

self.fc2 = nn.Linear(64, self.forecast_horizon) # 输出5步的数据

# Dropout层,防止过拟合

self.dropout = nn.Dropout(0.2)

def forward(self, x):

# 初始化隐藏状态

h_0 = torch.randn(self.num_layers, x.size(0), self.hidden_size).to(device)

# 通过RNN层进行前向传播

out, _ = self.rnn(x, h_0)

# 只取最后一个时间步的输出

out = F.relu(self.fc1(out[:, -1, :])) # 输出通过全连接层1并激活

out = self.fc2(out) # 输出通过全连接层2,预测未来5步的数据

return out

# 准备训练数据

# 假设你已经准备好了数据,X_train, X_test, y_train, y_test等

# 并且 X_train, X_test 是形状为 (samples, time_steps, features) 的三维数组

# 设置设备,使用GPU(如果可用)

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

print(f'Using device: {device}')

# 将数据转换为torch tensors,并转移到设备(GPU/CPU)

X_train_tensor = torch.Tensor(X_train).to(device)

X_test_tensor = torch.Tensor(X_test).to(device)

# 将y_train和y_test调整形状为(batch_size, forecast_horizon),即去掉最后一维

y_train_tensor = torch.Tensor(y_train).squeeze(-1).to(device) # 将 y_train.shape 从 (batch_size, forecast_horizon, 1) -> (batch_size, forecast_horizon)

y_test_tensor = torch.Tensor(y_test).squeeze(-1).to(device) # 将 y_test.shape 从 (batch_size, forecast_horizon, 1) -> (batch_size, forecast_horizon)

# 初始化RNN模型

input_size = X_train.shape[2] # 特征数量

hidden_size = 64 # 隐藏层神经元数量

num_layers = 2 # RNN层数

forecast_horizon = 5 # 预测的目标步数

model = RNN(input_size, hidden_size, num_layers, forecast_horizon).to(device)

# 定义损失函数和优化器

criterion = nn.MSELoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 训练模型

def train_model(model, X_train, y_train, X_test, y_test, epochs=2000, batch_size=1024):

train_loss = []

val_loss = []

for epoch in range(epochs):

model.train()

optimizer.zero_grad()

# 前向传播

output_train = model(X_train)

# 计算损失

loss = criterion(output_train, y_train)

loss.backward()

optimizer.step()

train_loss.append(loss.item())

# 计算验证集损失

model.eval()

with torch.no_grad():

output_val = model(X_test)

val_loss_value = criterion(output_val, y_test)

val_loss.append(val_loss_value.item())

if (epoch + 1) % 100 == 0:

print(f'Epoch [{epoch+1}/{epochs}], Train Loss: {loss.item():.4f}, Validation Loss: {val_loss_value.item():.4f}')

# 绘制训练损失和验证损失曲线

plt.plot(train_loss, label='Train Loss')

plt.plot(val_loss, label='Validation Loss')

plt.title('Loss vs Epochs')

plt.xlabel('Epochs')

plt.ylabel('Loss')

plt.legend()

plt.show()

# 训练模型

train_model(model, X_train_tensor, y_train_tensor, X_test_tensor, y_test_tensor, epochs=2000)

# 评估模型

def evaluate_model(model, X_test, y_test):

model.eval()

with torch.no_grad():

y_pred = model(X_test)

y_pred_rescaled = y_pred.cpu().numpy()

y_test_rescaled = y_test.cpu().numpy()

# 计算均方误差

mse = mean_squared_error(y_test_rescaled, y_pred_rescaled)

print(f'Mean Squared Error: {mse:.4f}')

return y_pred_rescaled, y_test_rescaled

# 评估模型性能

y_pred_rescaled, y_test_rescaled = evaluate_model(model, X_test_tensor, y_test_tensor)

# 保存模型

def save_model(model, path='./model_files/multisteos_rnn_model.pth'):

torch.save(model.state_dict(), path)

print(f'Model saved to {path}')

# 保存训练好的模型

save_model(model)

1.代码解析

(1)反向传播

def forward(self, x):

# 初始化隐藏状态

h_0 = torch.randn(self.num_layers, x.size(0), self.hidden_size).to(device)

# 通过RNN层进行前向传播

out, _ = self.rnn(x, h_0)

# 只取最后一个时间步的输出

out = F.relu(self.fc1(out[:, -1, :])) # 输出通过全连接层1并激活

out = self.fc2(out) # 输出通过全连接层2,预测未来5步的数据

return out

- 此处

h_0是RNN的初始隐藏状态,形状为(num_layers, batch_size, hidden_size),它存储了每一层在时间步t=0的初始隐藏状态; out中存储的是 最后一层的所有时间步的隐藏状态,PyTorch 的nn.RNN系列实现中,out始终返回的是 最后一层 的隐藏状态;例如,3层的 RNN,out中的数据是第3层的隐藏状态,前两层的状态不会在out中;out[:, -1, :]取的是最后一层并且最后一个时间步的隐藏状态,这是因为在许多任务中(如预测未来值),最后时间步的隐藏状态通常包含了整个序列的信息,因此可以作为最终的特征表示;_是 所有层 的最后一个时间步的隐藏状态,通常会有多个层(即num_layers > 1时),其形状为(num_layers, batch_size, hidden_size);

3. 训练使用方式

- 数据准备:通常RNN处理时间序列数据。数据需要转换成合适的格式,即将每个数据点按时间顺序组织成序列样本。

- 损失函数:对于回归任务,通常使用均方误差(MSE),而分类任务则使用交叉熵损失。

- 优化器:使用Adam或SGD等优化器来更新网络权重。

- 批处理和梯度裁剪:RNN的训练可能遇到梯度爆炸或梯度消失的问题,可以使用梯度裁剪(gradient clipping)来缓解。

4. 模型优缺点

优点:

- 时间序列建模:RNN可以处理具有时序依赖的数据(如语音、文本、股市等)。

- 共享权重:RNN通过在时间步之间共享权重,减少了模型的参数数量。

- 灵活性:RNN可以处理不同长度的输入序列。

缺点:

- 梯度消失/爆炸:在长序列中,RNN容易出现梯度消失或梯度爆炸的问题,导致训练困难。

- 训练效率低:传统的RNN难以捕捉长时间跨度的依赖关系,训练速度较慢。

- 局部依赖:RNN在捕获远程依赖时表现较差,容易受到短期记忆的影响。

5. 模型变种

-

LSTM (Long Short-Term Memory)

- LSTM 是RNN的一种变种,通过引入“记忆单元”来解决标准RNN中的梯度消失问题。它使用了三个门控机制——输入门、遗忘门和输出门,来控制信息的存储与更新,从而能够捕捉长时间跨度的依赖。

-

GRU (Gated Recurrent Unit)

- GRU是LSTM的一个简化版本,具有类似的性能但较少的参数。它合并了LSTM中的遗忘门和输入门为一个“更新门”,使得模型更为简洁。

-

Bidirectional RNN

- 双向RNN在处理序列数据时,通过同时考虑从前向和反向两个方向的信息,能够提高模型的表达能力,尤其在文本处理任务中有较好表现。

-

Attention机制

- Attention机制不仅在NLP任务中广泛使用,还被引入到RNN中,帮助模型关注输入序列中最重要的部分,从而有效处理长时间序列和远程依赖问题。

-

Transformer

- Transformer模型去除了传统RNN中的循环结构,完全基于自注意力机制(self-attention)来建模序列的依赖关系,避免了RNN的梯度消失问题,并能够并行处理序列。

6. 模型特点

- 时序数据建模:RNN特别适用于处理时序数据,可以理解序列中前后时间步之间的依赖关系。

- 状态更新:RNN通过隐藏层的状态传递,实现了对历史信息的持续更新和记忆。

- 参数共享:与传统的前馈神经网络不同,RNN在每个时间步使用相同的权重,因此模型在处理长序列时参数效率较高。

7. 应用场景

- 自然语言处理:

- 语言模型:RNN可以用于生成语言模型,如生成文本或对句子进行语言建模。

- 机器翻译:通过编码器-解码器结构,RNN(尤其是LSTM和GRU)在序列到序列(seq2seq)任务中非常有效。

- 语音识别:将语音信号转化为文字的过程中,RNN用于捕捉语音的时序特性。

- 时间序列预测:

- 股市预测:RNN可以用于基于历史股市数据预测未来价格。

- 天气预测:使用RNN模型预测未来几天的气候变化。

- 销售预测:基于历史销售数据预测未来销售量。

- 生成模型:

- 文本生成:基于RNN的文本生成模型(如char-level语言模型)可以生成与输入数据风格相似的文本。

- 音乐生成:RNN可以用来生成音乐序列,模仿人类作曲的风格。

- 视频分析:

- 视频分类:利用RNN在视频帧序列中的时序特性进行分类。

- 动作识别:RNN可以捕捉视频序列中的动作模式,用于人类行为分析。

![[云讷科技]Kerloud Falcon四旋翼飞车虚拟仿真空间发布](https://i-blog.csdnimg.cn/direct/e5cb55bc9d894ffb8a6e05b6ef317b14.png#pic_center)