引言

在人工智能的领域中,自然语言处理(NLP)是一个充满挑战的分支,它的目标是让计算机能够理解和生成人类语言。Transformer模型,作为NLP的基石,已经极大地推动了这一领域的发展。然而,为了进一步提升模型的性能,科学家们不断探索和创新。LLaMA模型,就是这样一种创新的尝试,它通过一系列独特的设计,改进了标准的Transformer架构,使其在处理语言任务时更加高效和有效。

1. 前置层归一化(Pre-normalization)

在标准的Transformer模型中,层归一化(Layer Normalization)是在每个子层(如多头自注意力层和前馈网络层)之后进行的,这被称为后置层归一化(Post-normalization)。然而,LLaMA模型采用了前置层归一化,即在每个子层之前进行归一化。这种设计有助于稳定训练过程并加速收敛。

2. RMSNorm归一化函数

LLaMA模型使用RMSNorm作为其归一化函数。RMSNorm通过计算输入向量的平方根均值来归一化输入,这有助于模型更好地处理不同规模的输入数据。RMSNorm的公式如下: 其中, 是输入向量, 是向量的维度。

3. SwiGLU激活函数

LLaMA模型的前馈网络层采用了SwiGLU激活函数,这是一种结合了Swish和GLU优点的激活函数。SwiGLU的公式如下: 其中, 表示逐元素相乘, 是sigmoid函数, 和 是可学习的参数。

4. 旋转位置嵌入(RoPE)

为了更好地捕捉序列中元素的位置信息,LLaMA模型使用了旋转位置嵌入。RoPE通过将位置信息编码为旋转矩阵,并与词嵌入相乘,从而将位置信息融入到模型的注意力机制中。RoPE的旋转矩阵可以表示为: 其中, 是与位置相关的旋转角度。

5. 整体架构与GPT-2类似

LLaMA模型的整体Transformer架构与GPT-2相似,这可能意味着它采用了类似的解码器结构和自回归生成方式。这种架构有利于生成连贯且相关的文本。

结论

LLaMA模型通过这些创新的设计,不仅提高了Transformer模型的训练效率和性能,而且使其在处理复杂的自然语言处理任务时更加有效。这些改进就像是给模型装上了超级大脑,让它能够更好地理解我们的语言,为我们提供更加智能的服务。

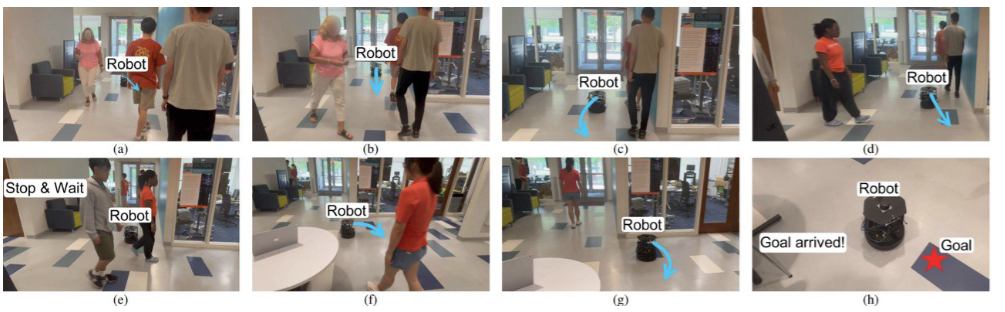

图示解释

图中展示了LLaMA模型的架构,其中包含了12个Transformer层,每层都包括多头自注意力层、全连接层和层归一化。这些层的组合使得模型能够深入理解文本内容,并进行文本预测和分类。通过这种结构,LLaMA模型能够处理各种NLP任务,如机器翻译、文本摘要、情感分析等。