我自己的原文哦~ https://blog.51cto.com/whaosoft/12358456

#GaussianPretrain

万能3D高斯预训练表示!爆拉3D检测、Occ、高精地图等四大任务!

受Tesla的技术的推动,越来越多的厂商开始走"纯视觉"的路线,多数方案还是集中在从多视图输入图像中提取鸟瞰图(BEV)特征,来解决下游目标检测、在线地图等各种应用。尽管有监督的方法还是占主导地位,但是它们非常依赖精确的GT标注,成本高、难度大往往成为一个比较显著的瓶颈。相反,大量且易于获取的未标记数据为提高性能提供了一个充满希望的途径。这就是所谓的自监督预训练技术,其核心思想是,通过利用精心设计的代理任务,从丰富的未标记数据中学习有意义的表示。然而当前的一些方案要么无法捕捉到有效的几何信息,要么无不能学习到详细的纹理信息。

3D Gaussian Splatting(3D-GS)以点云的形式表示,为场景重建提供了强大的表示,通过位置、颜色、旋转、缩放和不透明度等属性编码几何和纹理信息。正是受到3D-GS在有效场景表示和Masked autoencoders(MAE)在2D图像自监督学习中的成功的启发,作者提出了一种新颖的预训练方法GaussianPretrain,它结合了3D-GS和MAE方法,用于3D视觉学习中的预训练任务。

作者的方法包括两个关键创新:

- LiDAR深度指导掩码生成器。为了提高效率,作者只关注从多视图图像中的有限数量的有效掩码补丁中学习高斯信息。这些补丁由MAE策略识别,并进一步过滤,只包括那些具有LiDAR深度监督的补丁。

- 基于射线的3D高斯锚点指导策略:对于每个LiDAR投影像素,执行射线投射操作到3D空间以采样体素内的点。作者引入了一组可学习的高斯锚点来指导从3D体素中作为体积LiDAR点的高斯属性的学习,并预测相关属性(例如,深度、不透明度)。这使得模型能够通过3D Gaussian Splatting同时理解场景的几何和纹理信息。

- 论文链接:https://arxiv.org/pdf/2411.12452

相关工作

自动驾驶中的预训练

使用对比学习和掩码信号建模来捕获语义和纹理信息,在2D图像上的预训练已经取得了巨大的成功。但是,自动驾驶的视觉预训练需要准确的几何表示。目前有的研究,比如,UniScene和OccNet利用占用预测进行预训练,而ViDAR 从历史帧图像预测未来的LiDAR数据。尽管这些方法在捕获几何信息方面是有效的,但却无法学习详细的纹理信息。相反,像Self-OCC 、UniPAD 和MIM4D 这样的方法使用NeRF 来渲染RGB图像和深度图,学习了纹理但几何信息有限。OccFeat 在占用预测期间使用知识蒸馏从图像基础模型转移纹理信息,但会产生高昂的预训练成本。相比之下,作者的工作引入了3D Gaussian Splatting进行自动驾驶的视觉预训练,有效地捕获纹理和几何信息,来解决这些限制。

从NeRF到3D-GS

Neural Radiance Fields (NeRF) 通过隐式表示场景的颜色和密度,参数化多层感知机(MLP)结合体积渲染技术,实现了令人印象深刻的渲染质量。后续工作已成功将NeRF扩展到各种任务,但是这些工作都需要针对每个场景来优化,由于优化和渲染速度慢,限制了它们的效率。相比之下,3D Gaussian Splatting 通过各向异性高斯显式表示场景,通过可微光栅化实现实时渲染。然而,由于依赖于特定场景的优化,它倾向于过度拟合特定场景。最近的方法通过预测高斯参数的前馈方式来缓解这个问题,这样就不需要针对每个场景来优化了。例如,GPSGaussian 从图像对执行极线校正和视差估计,依赖立体图像和真实的深度图。同样,Spatter Image 专注于从单一视图重建单个对象的3D结构。这两种方法因为效率低,仅限于对象重建,并且依赖于特定的输入格式,如图像对或单一视图。在本文中,作者将3D Gaussian Splatting扩展到视觉预训练任务中,通过在3D空间中预设固定位置的3D高斯锚点,克服了与视图数量和深度图需求相关的问题,标志着3D-GS的新应用。

3D Gaussian Splatting

3D GS由于其高效的光栅化设计和显式表示,在场景表示、编辑和新视角合成方面展现出强大的能力。通常,场景由一组高斯组成,这些高斯通常从重建方法或LiDAR数据中得到的点云初始化而来。每个高斯被赋予可学习的属性,包括方向、颜色、位置、尺度和不透明度。在渲染过程中,这些3D高斯被使用可微光栅化投影到2D图像平面上。对于场景表示任务,通过将渲染输出与真实图像进行监督,迭代优化高斯属性。对于3D空间中的一个高斯点,它被定义为

其中和分别指的是高斯的均值中心和3D协方差矩阵。投影到2D后,有2D协方差矩阵,其中视图变换由表示,雅可比矩阵对应于变换的线性近似。最后,像素颜色是从N个有序高斯中渲染出来的,混合方程为

其中是用球谐表示的高斯颜色,是这个高斯对当前像素的不透明度影响。是透明度。

方法论

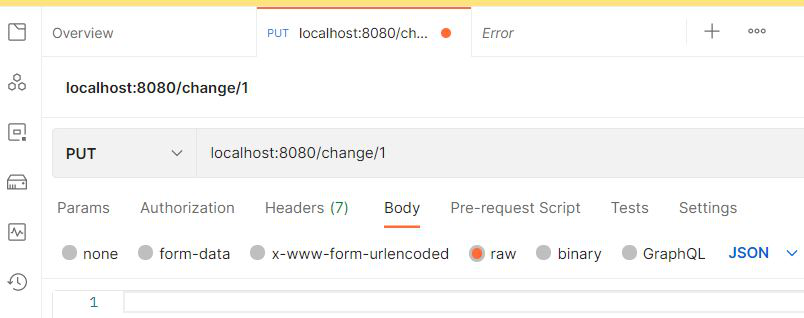

图3展示了作者GaussianPretrain的结构,一个使用3D-GS表示进行视觉预训练的简单、创新且高效的框架。给定带有有效掩码补丁的多视图图像,作者的目标是通过解码每个场景的高斯参数 来重建RGB、深度和占用,其中、、和分别是3D高斯的位置、不透明度、协方差和颜色信息,K表示最大高斯锚点的数量。

LiDAR 深度引导掩模生成器

受MAE 的启发,作者对多视图图像应用随机补丁掩码,表示为M。此外,稀疏卷积被用来替代图像主干中的传统卷积,如SparK 的实现增强了性能和泛化能力。为了计算效率,作者只关注从有限的一组有效掩码补丁中学习高斯参数。此外,作者通过检查LiDAR点是否在某个深度范围内来双重检查掩码区域。

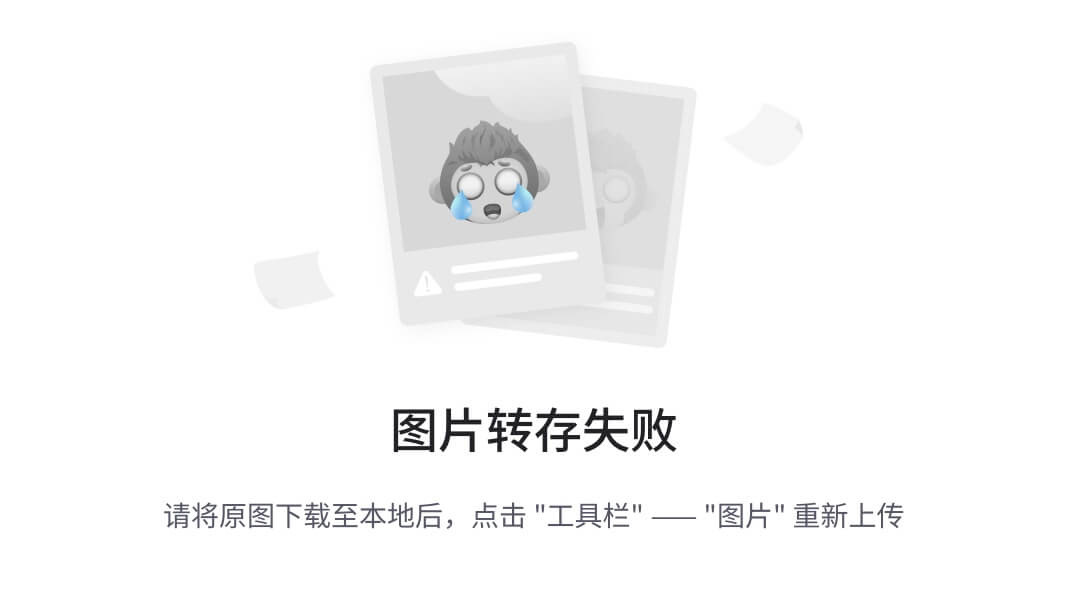

如图4所示,如果一组点投影到图像中的掩码补丁,并且它们的深度落在[a, b]的范围内,掩码区域将被标记为有效,。这种策略确保作者的模型集中于前景,避免了对天空等不相关背景元素的不必要关注。

基于射线引导的 3D 高斯锚点

为了使模型能够同时理解场景的几何和纹理信息,作者引入了一系列在3D空间中的可学习高斯锚点。这些锚点引导从3D体素网格中派生的高斯属性的学习,被视为体积LiDAR点。考虑由表示的LiDAR投影像素,它对应于从相机延伸到3D空间的射线R。沿着这个射线,作者采样D个射线点,其中是沿射线的相应深度。每个在有效掩码区域M′中的采样射线点p可以立即反投影到3D空间,使用投影矩阵摘要作为3D高斯锚点,。这种策略不仅消除了完整图像渲染的需要,显著减少了内存使用,而且还实现了RGB、深度和占用的同时重建。

体素编码

在大多数感知任务中,通常使用视图变换器生成鸟瞰图(BEV)特征,然后用于后续的下游任务。值得注意的是,作者的预训练方法与任何类型的视图变换器兼容。在作者的基线模型UVTR 中,采用lift-splat-shoot (LSS)方法,并将通道维度扩展以包含高度维度,产生3D体素特征,其中C、H、W和Z分别代表通道数以及沿x、y和z轴的维度。此外,对于每个LiDAR投影像素,作者执行射线投射操作,从3D体素网格V中提取Nt个采样目标体素,其中存在高斯锚点。

Gaussian 参数解码

如图3所示,通过将概念化为3D高斯锚点,这种统一表示使作者能够高效地捕获高质量、细粒度的细节,提供对场景更全面的了解。特别地,每个3D高斯锚点由属性特征化,所提出的高斯映射G定义为:

其中x是3D空间中高斯锚点的位置,、、、分别代表颜色、旋转、缩放和不透明度的高斯参数图。由于多视图图像中的重叠区域,像素级的高斯参数预测可能会导致由于重叠splats引起的歧义。相比之下,作者认为直接从3D体素特征预测高斯参数是更好的选择。给定体素特征V和中心坐标x,作者使用三线性插值来采样相应的特征f(x)如下:

高斯参数图由预测头生成,定义为h = MLP(·),由多个MLP层组成。每个预测头专门设计用于根据采样的特征f(x)回归特定参数。对于颜色和不透明度参数,作者使用sigmoid函数进行范围[0,1]的回归,如下所示:

其中、分别表示颜色和不透明度的头。在用于形成高斯表示之前,旋转图应该被归一化,因为它表示一个四元数,以确保单位大小,而缩放图需要激活以满足其范围,如下所示:

其中、分别表示旋转头和缩放头。

通过重构信号来监督

为了在MAE策略下更好地重建掩码区域,作者使用从高斯表示派生的不同重建信号来监督学习过程。具体来说,RGB、深度和占用信号是基于有效掩码补丁中预测的高斯锚点参数解码的。

RGB Reconstruction. 由于作者不需要重建任意视角的图像,作者直接预测固定视点的RGB,而不是使用球谐系数。在预测高斯锚点参数后,作者使用GS中的相关方程来解码颜色信息,以渲染每个目标重建像素的图像RGB值图,表示为。具体来说,方程中的值被预测的RGB替换。

Depth Reconstruction. 受NeRF风格体积渲染中的深度实现启发,作者以类似于RGB重建的方式整合每个splat的深度。作者从3DGS参数近似每个像素的z深度。该过程如下:

其中n是高斯锚点的数量,是第i个高斯锚点在视图空间中的z深度坐标,实现了高效的深度渲染,计算开销最小。是图像的深度图。

Occupancy Reconstruction. 3DGS点的不透明度属性自然适用于视觉感知,特别是占用预测任务。与GaussianFormer不同,后者使用不透明度进行语义逻辑,作者直接将不透明度解释为占用位置的指示。完全不透明的高斯锚点表示在x处存在被占用的位置。形式上,对于每个目标体素,作者在体素内的高斯锚点中取最大不透明度值来表示占用概率,表示为。这种直接将不透明度映射到占用的方法,为利用3D Gaussian Splatting进行占用预测提供了自然而有效的方式。

其中k是目标体素中的高斯锚点数量。

Loss Function. 总结来说,整体预训练损失函数由颜色损失、深度损失和占用损失组成:

其中 , 是每个射线的GT颜色和深度。 表示占用的GT,如果它包含至少一个LiDAR点,则被认为是占用的。 和 分别是目标像素和目标体素的计数。

实验结果

作者使用nuScenes数据集来训练和验证。

不同任务上的结果

3D Object Detection. 作者在表1中比较了GaussianPretrain与以前SOTA方法的结果。以UniPAD作为基线,该基线是在UVTR-C/StreamPETR上实现的。作者的方法在NDS和mAP上分别超过了UniPAD-C 0.8和0.7个百分点。与StreamPETR相比,改进进一步获得了0.9 NDS,达到了48.8和38.6在NDS和mAP上,达到了没有任何测试时增强的现有最先进方法的水平。

HD Map Construction. 正如表2所示,作者评估了其训练模型在nuScenes数据集上对HD地图构建任务的性能。这项任务要求模型理解道路拓扑和交通规则,需要对场景的纹理信息有详细的了解。作者使用MapTR 来评估GaussianPretrain捕获这些信息的能力。得益于作者有效的高斯表示预训练,MapTR在mAP上实现了1.9%的改进。

3D Occupancy Prediction. 高斯锚点的不透明度属性自然适合占用预测任务。在表3中,作者在Occ3D-nuScenes上进行了3D占用预测的实验。表中报告了SOTA方法的性能,这些性能记录在Occ3d 的工作中。作者在BEVFormer 和PanoOCC上实现了作者的框架,比BEVFormer提高了0.6% mIoU的性能,比SOTA方法PanoOCC进一步提高了0.8% mIoU。这也突出了作者预训练图的有效性。

预训练方法上的结果

作者以在ImageNet上预训练的UVTR-C作为基线,并在表4中比较了GaussianPretrain与以前的预训练方法。

- DD3D:利用深度估计进行预训练。

- SparK:将MAE纳入预训练方法。

- FCOS3D:在预训练阶段使用3D标签进行监督。

- UniPAD:基于NeRF的渲染预训练范式。

作者的GaussianPretrain,将3D-GS整合到视觉预训练中,大大提高了7.1%的NDS和9.0%的mAP。它优于所有其他方法,分别达到了32.0 NDS和32.3 mAP。

消融实验

GaussianPretrain’s losses: 为了验证每个重建信号的有效性,作者在UVTR和BEVFomer上进行了3D检测和占用任务的实验。RGB损失引导模型从重建图像中学习场景的纹理信息,而深度损失鼓励模型在2D平面上学习几何信息,尽管这本身不足以捕获完整的3D几何信息。相比之下,占用损失监督模型在3D空间内学习全面的几何信息。如表7所示,每个组成部分都做出了积极贡献,当全部使用时,取得了最佳结果。

Gaussian Anchor Numbers: 作者进行了消融研究,以检查不同数量的高斯锚点对性能指标的影响,如表8所示。在达到1024个射线时,观察到最显著的增益,超过这个数量,相对于额外的资源需求,改进较小。

Efficiency & consumption: 基于NeRF的方法通常受到慢收敛和高GPU内存消耗的困扰。相比之下,作者的基于3D-GS的方法提供了可比的渲染质量,并且具有更快的收敛速度和更优越的效率,用于自由视图渲染。在表9中,作者比较了NeRF基础的UniPAD和作者的解码器模块之间的效率和内存消耗。值得注意的是,GaussianPretrain明显减少了约30%的内存使用,并减少了大约40.6%的延迟,同时保持了相似的参数大小。

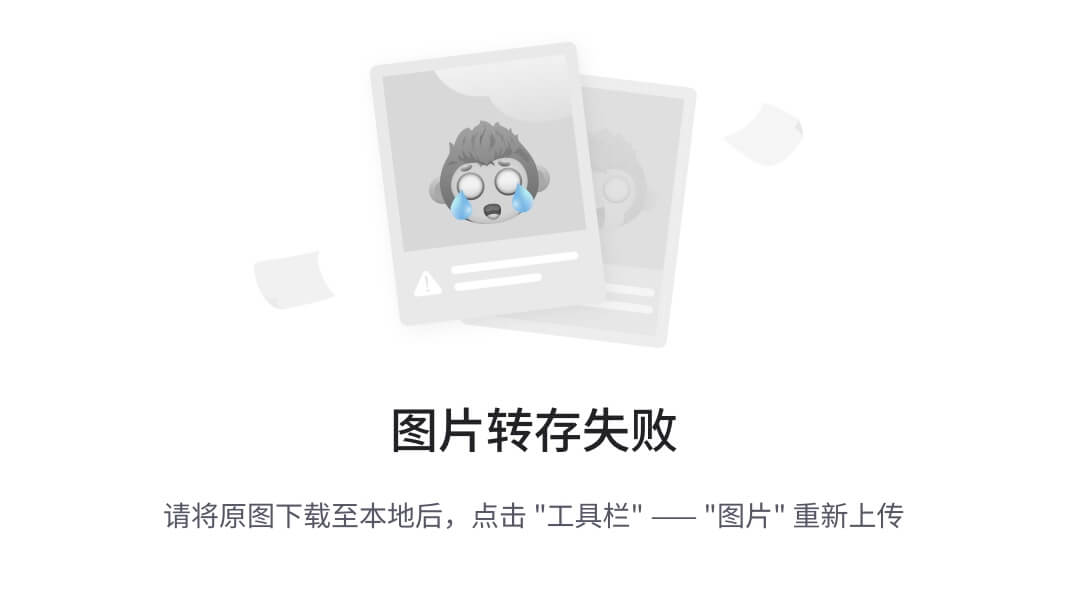

Supervised Pre-training: 作者展示了GaussianPretrain在减少对注释的依赖方面的有效性,通过微调UVTR,从完整数据集到1/4子集的范围。如图5所示,作者的方法在只有一半监督样本的情况下超过了基线5.5% mAP,即32.0% mAP vs. 26.5% mAP。这表明GaussianPretrain可以有效利用未标记数据来补偿减少的监督,即使在注释较少的情况下也能提高性能。

Different Conditions: 作者在表6中报告了在不同距离、天气条件和光照情况下的性能,这得益于作者在UVTR-C上有效的预训练,GaussianPretrain实现了卓越的鲁棒性和整体最佳性能。

总结

在这项工作中,作者首次将3D Gaussian Splatting技术引入视觉预训练任务。作者的GaussianPretrain在各种3D感知任务中展现出显著的有效性和鲁棒性,包括3D目标检测、高清地图重建和占用预测,同时具有效率和较低的内存消耗。不过,当前框架仍然存在某些局限性。特别是,它没有明确地结合时间或多模态信息,这两者对于许多自动驾驶应用至关重要。在未来的工作中,作者计划扩展GaussianPretrain以利用这些信息,并进一步提高其性能。

#具身智能训练数据集

具身智能训练要求智能体通过与环境的物理交互来学习智能行为,数据集对于具身智能的训练效果有着至关重要的影响,提高训练效果的根源在于使用丰富多样的数据集,让具身智能体接触到各种不同的情况,从而学习到更广泛的技能和应对策略。然而,数据集的数据采集过程复杂且成本高昂,数据标注工作往往需要专业知识和大量的人工劳动。

ARIO数据集 - 机器人控制

数据集链接:https://openi.pcl.ac.cn/ARIO/ARIO_Dataset

项目链接:https://imaei.github.io/project_pages/ario/

论文链接:https://arxiv.org/pdf/2408.10899

ARIO(All Robots In One)是鹏城实验室建立的大规模统一数据集,旨在解决现有数据集在开发多功能通用实体智能体方面的不足。ARIO支持 5 种感官模态,基于时间戳对齐多模态数据,采用统一数据架构,有统一配置,增强数据多样性,涵盖多种数据来源:(1)从真实场景收集:使用 Cobot Magic 平台(双手机器人移动操作平台)、Cloud Ginger XR - 1 平台(5G 轮式人形云机器人)。(2)从模拟平台生成,包括Habitat 的对象导航任务、MuJoCo 的操作任务、SeaWave 的操作任务。(3)从开源数据集转换,基于 Open X - Embodiment 数据集、基于 RH20T 数据集、基于 ManiWAV 数据集。

ARIO 数据集可用于训练具身智能体,以提高它们在各种任务和环境中的性能和适应性。ARIO拥有多模态特性,包含 2D 和 3D 视觉数据、触觉、声音和文本形式的数据,使得开发者可以在多种任务上进行模型训练;解决了多个现有数据集之间数据结构不一致的问题,显著减少前期数据清洗和预处理的时间。

G1数据集 - 人形机器人操作

开源数据采集的链接:https://github.com/unitreerobotics/avp_teleoperate

开源学习算法的链接:https://github.com/unitreerobotics/unitree_IL_lerobot

开源数据集和模型的链接:https://huggingface.co/UnitreeRobotics

宇树科技公布了开源 G1 人形机器人操作数据集,用以训练人形机器人,适配多种开源方案。宇树 G1 人形机器人操作数据集具有以下特点:(1)多样化的操作能力展示:通过演示视频可以看到,G1 人形机器人能够完成拧瓶盖倒水、叠三色积木、将摄像头放入包装盒、收集物品并存储、双臂抓取红色木块并将其放入黑色长方形容器中等复杂操作,显示出高度的灵活性和实用性。(2)数据采集方式创新:使用苹果的 Vision Pro 对 G1 进行遥操作控制。(3)丰富的数据维度:数据集中的图像分辨率为 640×480,每个手臂和灵巧手的状态及动作维度为 7。目前包含拧瓶盖倒水、叠三色积木、包装摄像头、存储物品、双臂抓取和放置等五大类操作的数据集。

RT-1数据集 - 机器人操作

论文链接:https://robotics-transformer.github.io/assets/rt1.pdf

开源链接:https://github.com/google-research/robotics_transformer

项目主页:https://robotics-transformer2.github.io/

RT-1 数据集是用于训练和评估机器人学习模型 RT-1 的数据集,旨在构建一个能够处理多种任务、对新任务和环境具有良好泛化能力的机器人系统。数据收集使用 13 个来自 Everyday Robots 的移动机械臂,在三个厨房环境(两个真实办公室厨房和一个训练环境)中收集数据。数据由人类提供演示,并为每个情节标注执行任务的文本描述,指令通常包含动词和描述目标对象的名词。

RT-1 能够执行超过 700 个语言指令,根据指令中的动词将其分组为不同技能,如拾取、放置、打开和关闭抽屉、取放抽屉中的物品、直立放置细长物品、推倒物品、拉餐巾和打开罐子等。涵盖多种行为和对象,通过增加 “pick” 技能的对象多样性来提升技能的泛化能力,并在实验中扩展了技能,包括一些现实的长指令任务,如在办公室厨房场景中的复杂操作。

RT-1 包含超过 130k 个机器人演示,这些演示构成了 744 个不同的任务指令,涉及多种技能和大量不同的对象。数据集中的技能和指令涵盖了多个领域,如物体操作、环境交互等,以支持机器人在不同场景下的任务执行和学习。

QT-Opt - 抓取

论文链接:https://arxiv.org/pdf/1806.10293

开源链接:https://github.com/quantumiracle/QT_Opt

QT-Opt 数据集是为训练机器人的视觉抓取策略而收集的大规模数据集,通过 7 个机器人在四个月内收集了超过 580k 次真实世界的抓取尝试,旨在让机器人学习通用的抓取技能,能够在未见过的物体上实现高成功率的抓取。

在收集数据集时,使用 7 个 KUKA LBR IIWA 机械臂,每个机械臂配备一个两指夹爪和一个位于肩部上方的 RGB 相机来收集数据。数据收集过程中,为了使模型能够学习到通用的抓取策略,使用了多样化的物体,这些物体在训练过程中定期更换,每 4 小时更换一次(在工作时间内),夜间和周末则保持不变。收集的数据包括机器人的相机观察(RGB 图像,分辨率为 472x472)、夹爪状态(开或关的二进制指示)以及夹爪相对于地面的垂直位置等信息。数据收集总共耗时约 800 机器人小时,数据量达到 4TB,足以训练出具有高成功率的抓取策略模型。

BridgeData - 机器人学习与泛化

论文链接:https://arxiv.org/pdf/2308.12952

项目主页:https://rail-berkeley.github.io/bridgedata/

BridgeData V2 是一个用于大规模机器人学习研究的数据集,旨在促进机器人学习方法的发展,包含丰富的机械臂操作行为数据,以支持多种任务和环境下的技能学习与泛化研究。数据集包含 60,096 条轨迹,其中 50,365 条专家演示轨迹和 9,731 条脚本策略收集的轨迹。涵盖 13 种技能,包括基础操作如拾取和放置、推动、重新定向物体,以及更复杂的操作如开门、关门、抽屉操作、擦拭表面、折叠布料、堆叠积木、扭转旋钮、翻转开关、转动水龙头、拉链操作和使用工具清扫颗粒状介质等。这些技能适用于多种环境和物体,确保学习到的技能具有通用性。包含 24 种环境,如厨房、水槽、桌面等,以及 100 多种物体。环境和任务的多样性使数据集能够支持多种学习方法的评估和研究,有助于机器人学习在不同场景下的任务执行和技能泛化。

TACO - RL - 长时域操作

论文链接:http://tacorl.cs.uni-freiburg.de/paper/taco-rl.pdf

项目链接:http://tacorl.cs.uni-freiburg.de/

数据集链接:https://www.kaggle.com/datasets/oiermees/taco-robot

TACO - RL 使用的数据集是通过在模拟和真实环境中对机器人进行远程操作收集的,包含机器人与环境交互的状态 - 动作序列,用于训练分层策略以解决长时域机器人控制任务,支持机器人从无结构的游戏数据中学习通用技能并实现复杂任务的执行。

收集的数据为无结构的游戏数据,未针对特定任务进行标记,包含多种机器人操作行为,如推动、抓取、放置物体,操作抽屉、滑动门和与 LED 按钮交互等,具有丰富的多样性和复杂性。数据集用于训练低层级策略,通过对无结构数据进行自动编码,学习从潜在计划到动作的映射,提取一系列基本行为原语。高层级策略通过离线强化学习(RL)利用后见之明重标记技术进行训练。

CLVR - 遥控

数据集链接:https://github.com/clvrai/clvr_jaco_play_dataset

CLVR Jaco Play Dataset 是一个专注于遥控机器人领域的数据集,共 14.87 GB,由南加州大学和 KAIST 的研究团队发布,它提供了 1,085 个遥控机器人 Jaco2的片段,并配有相应的语言注释。

FurnitureBench - 长时域操作

论文链接:https://arxiv.org/pdf/2305.12821

项目链接:https://clvrai.github.io/furniture-bench/

数据集链接:https://clvrai.github.io/furniture-bench/docs/tutorials/dataset.html

FurnitureBench是一个用于测试真实机器人复杂长时域操作任务的数据集。数据集聚焦于家具组装这一复杂长时域操作任务,其任务层次结构长,涉及家具部件的选择、抓取、移动、对齐和连接等步骤,平均任务时长在 60 - 230 秒(600 - 2300 低层级步骤)。任务要求机器人具备多种复杂技能,如精确抓取(不同家具部件抓取姿态各异)、部件重定向(通过拾取放置或推动实现)、路径规划(避免碰撞已组装部件)、插入和拧紧(精确对齐并重复操作)等。

通过使用 Oculus Quest 2 控制器和键盘对机器人进行远程操作来收集数据,历时 219 小时,涵盖八个家具模型。针对不同家具模型和初始化水平(低、中、高)收集了不同数量的演示数据。每个演示的时间步长因任务长时域性质而在 300 - 3000 步左右。数据收集过程中,通过使用不同颜色温度的单光面板并改变其位置和方向,以及每集随机化前视图相机姿势来增加数据多样性。

Cable Routing - 多阶段电缆布线

论文链接:https://arxiv.org/abs/2307.08927

项目链接:https://sites.google.com/view/cablerouting/home

数据集链接:https://sites.google.com/view/cablerouting/data

该数据集是为训练机器人的电缆布线策略而收集的,用于支持分层模仿学习系统,使机器人能够学习执行多阶段电缆布线任务,应对复杂的电缆操作挑战。数据集中包含了多种电缆形状、夹取位置和方向的变化,以及不同数量夹子(一夹、两夹、三夹)的布线任务数据,有助于训练出具有泛化能力的策略。

针对单夹电缆布线任务,通过人类专家远程操作机器人在不同位置和夹取方向上执行任务来收集数据。共收集 1442 条夹取轨迹,每条轨迹时长约 3 - 5 秒,包含约 20 个时间步,每个时间步包含机器人相机图像(四个)、机器人配置状态向量和人类远程操作员的指令动作。在训练单夹布线策略和其他原语后,通过人类专家按顺序触发原语以执行完整的多阶段电缆布线任务来收集数据。在一夹、两夹或三夹的场景下,电缆初始状态为平放在桌子上的任意形状,专家输入原语,机器人执行,同时记录整个轨迹的感官信息。

RoboTurk - 模仿学习

论文链接:https://arxiv.org/abs/1811.02790

项目链接:https://github.com/RoboTurk-Platform/roboturk_real_dataset

数据集链接:https://roboturk.stanford.edu/dataset_real.html

ROBOTURK 数据集是通过众包平台收集的用于机器人学习任务的大规模数据集,旨在解决机器人模仿学习中数据收集困难的问题,使机器人能够从大量的人类演示中学习操作技能,应对复杂的操作任务。数据涵盖了不同用户在多种任务和操作条件下的演示,包括不同物体的操作(如 lifting 任务中的立方体、picking 任务中的各种物品、assembly 任务中的螺母等)以及不同的操作场景,有助于训练出具有泛化能力的机器人策略。

#量产之问

1.大佬,想问一下有没有通过视觉大模型来做行为预测的工作呀?

回答1:应该是有的,有类似occworld的工作,九月份有个综述可以看下【自动驾驶中的大模型!】全面概...

2.请问,用多模态大语言模型去挖掘带有目标物体(文本 prompt )的图片,现在推荐的预训练大语言模型或者框架吗?我目前能够 到想到 base model 的是 sam 和 clip 结合。但不知道对小目标的精确度性能如何。

回答1:大模型我还不太熟悉,我理解你是想做类似grounding的任务,小目标可以搜下arxiv,按照小目标的关键词搜索下

3.对于NOA功能怎么确定域控里跑的是啥地图?HD/SD/HQ map?

回答1:至少可视化界面上你看不出来。。。只能猜吧?可以这样,去一些hard case场景看看,或者没有高精地图的地方看看(不太可能采集到的),看看效果咋样,如果效果很差,说明依赖高精

回答2:也不能单纯以来高精,现在无图的效果基本上可以和有图对齐了。域控里面跑的啥地图要找下游规控问一下,SD这种信息都是图商提供的,算法怎么用 下游怎么用都不是固定的模式

回答3:可视化界面可以看出来是不是HD,对地面标志(左转,右转,掉头)的识别如果在跳动,说明不是HD,是靠感知的呲牙

4.大佬,数据处理(大模型自动标注)和三维重建那个方向更值得选?

回答1:我觉得都可以,算是上下游关系了,重建后再去做一些自动标注。个人觉得如果能接触到大模型相关的知识,做自动标注方向吧,接触的训练模型方面更多一些,三维重建需要很多SLAM,Nerf还有3DGS知识,看你背景如何。

5.有协同检测数据集opv2v、v2xset的网盘链接吗,从官网下载流量不够....

回答1:去opendatalab搜索下

6.有人会魔改pytorch源码吗?pytorch源码目录繁多,根本搞不清都是哪些做用啥的,有人知道要魔改一个算子的话,需要从哪里入手吗?

回答1:魔改算子?这个有点难,比如采样插值等等,你要看底层代码,然后修改完之后怎么封装等等

回答2:官方文档有写如何自定义算子,你去看看呢

7.提问:想做单相机的bev感知,以kitti数据集做参考,请问在自制数据的时候,是否可以只用一个16线激光雷达和一个彩色相机采集数据。如果不行,还有哪些传感器是必备的呢

回答1:分不分量产车和真值车,真值还需要稠密些的点云标注

回答2:目前还不用在车上,现在是想先采些数据,做3D目标检测和BEV检测,是不是没有GPS/IMU也可以

8.请问我跑多目标跟踪代码,CPU占用比较多,但是也会用到一点GPU,最好在网上租什么服务器,我看网上单独租CPU的其中并没有GPU,所以不能单独租CPU,昨天试2080ti,内存没有跑满,但是跑的也是比较慢。

回答1:一般这种代码后处理比较多,所以cpu占用多一些。服务器根据你的需要就可以了,一般跟踪对gpu需求不高

回答2:有些库里面的算子可能有gpu加速,主要还是cpu为主

9.各位佬上午好~想问一下针对BEV空间中的栅格划分,现在有使用动态变化方式的方案吗?例如近/远处的格子分辨率不同或者近远处密集/稀疏程度有差别

回答1:这种不行吧,动态划分一些2d feat到bev上的cuda算子不好做吧

10.你好,我是一名基础架构的工程师,学习自驾是想了解,自驾算法会对视频图像进行抽帧,每帧都是很小的图片,请问下在工业落地的时候,如何解决海量小文件读取的性能瓶颈?本人想到有两条路:

第一条就是把大量的图片合成一个大图片,类似pickle这样的解决方案?

第二条就是在训练框架里面,每次输入源做优化,把很多相近时间段内的图片灌进去,避免出现读随机性?

本人对算法框架的输入源控制不太熟悉,因此想请教下这两种方法落地可行性,还有没有其他工业界落地比较好的方案?多谢

回答1:在实车运行时,自驾算法是按照时间序列输入图像和其他传感器数据的,不会同时海量小图。如果是训练模型这个阶段,也会分batch进行。

11.想请问一下,目前视觉做一些3d目标检测之类的,如何适配不同相机,不同场景的呢?例如单目3d检测,训练涉及到使用相机内参,如何适配到其他相机。bevformer之类的?

回答1:两种方式,要么做域迁移,要么直接用虚拟相机。一般涉及到相机内参的事情,换个相机就不咋好用了,所以领域有一些域迁移的工作,少量本相机的样本+其它成像的数据,一起做优化。还有就是直接把相机模型统一,但这样会遇到一个问题,那就是可能视场角不太一样

12.相同的运算,改变运算顺序,会影响程序的运行结果吗?一段基本上都是乘法和加法的程序,运算结果和理想中的有一些误差,有可能是什么原因啊?

回答1:第一,要给点伪代码出来看看

第二,有可能是改变运算顺序的时候,如i++这些可能会有使用习惯不当导致获取结果不同。

第三,如果是一串很复杂的加法和乘法逻辑,那就一步步全部拆开,分步写等等。

第四就是使用分段调试,先对不同段之间的逻辑调换顺序,一点点调试看结果哪里会有差异

13.3dod的细分类(比如面包车小轿车之类)一般是怎么做的哇?

回答1:标注细分下

14.请教一下,移动机器人基于局部路径规划决策,传统的算法和基于深度强化学习的算法有没有比较好的算法可以推荐学习一下的。有开源的代码就更好了

回答1:机器人导航汇总链接:涉及移动机器人、水下机器人、视觉-语言导航、ROS等

综述

Autonomous Navigation and Collision Avoidance for Mobile Robots: Classification and Review

- 论文链接:[2410.07297] Autonomous Navigation and Collision A...我们的“具身智能之心”星球比较多哈哈

15.请问联合轨迹预测有没有什么常用的数据集,上次只做了Argoverse2被审稿人喷了

回答1:waymo interaction prediction benchmark也可以

回答2:这也能被喷,argoverse waymo这几个常用的都要跑跑嘛

16.介绍一下个人情况,本人研一,北京双非学校,目前方向是自动驾驶,但是没有任何人带,导师不是这个领域,跟着导师的小老师做,小老师是车辆工程专业的老师,但是做的比较传统,提供不了太大帮助,但个人非常适合这种自由度高但资源少的局面,也有信心去把这件事情做好。

我的目的是读博,因为我想做的是一些创造和探索性质的工作,当然最重要的肯定是想把自己的想法实现,自由度能高一些,自己想做什么就大程度能做什么,一开始想做规控,学习了控制的一些经典算法比如PID,LQR,在carsim上简单做了实验,但是肤浅的觉得传统控制领域(指的是应用在自动驾驶领域内的)没有太多空间去做了,无非是基于学习去优化一下原有的方法(这里是说研究空间,不是工程实际应用)。

而且端到端一直弄的我心痒痒的,所以我开始去较为深入的了解端到端,看了星球发布的端到端学习路线,认真看了端到端行业报告和几场PPT讲座,感觉我自己去弄端到端有点自不量力的感觉,而且实验室只有一张quadro RTX8000的卡。

其次比较关注的就是轨迹预测和3D目标检测方面。

因为我一直是想能先通过一些相较于端到端较为容易上手的而且实验室资源能够支持的模块入手,逐渐向端到端靠拢,而目标检测作为端到端依赖的最初起点,以及轨迹预测又作为模块端到端的起点,所以重点关注了一下这两个模块,而且觉得这两个模块的学习思维应该比较接近端到端的学习思维

问题:

1.那如果我要读博,还想做端到端,应该到底从哪入手呢,是3D目标检测,还是轨迹预测,还是说从其他的模块开始

2.我以上的这个思路是不是正确的,有没有认知上的偏差

3.从硕士三年,或者说两年半这个长线来看,基于我这个计划,我要提前做什么部署呢,需要注意哪些细小但举足轻重的东西呢

我一直想自己推测一个结果出来,可发现知之甚少,所以请教各位老师,感谢各位老师的悉心解答,谢谢各位老师!

回答1:有几个问题你需要想办法,自动驾驶感知的算力问题,端到端需要的算力也很大

1、端到端可以直接基于开源的算法入手,但你是小白入门,学习的过程差什么补什么,像3D目标检测、轨迹预测你在学习的过程都会针对性的补充学习

2、我看你整体的描述,觉得你整体上还在入门的阶段,有这些困惑很正常,大体两三个月就会越来越清晰要做什么 3、你现在所要做的就是紧跟前沿,热点随时会变,持续学习

17.请教一个问题,在nuScenes上跑点云语义分割,只用单帧进行训练,数据增强只有旋转翻转这样的简单增强,指标很低。我用SparseUnet,PTV3,Cylinder3D搞了都很低。同样的网络,在waymo上指标没有那么差。

是不是nuScenes数据集过于稀疏的原因呢?还是有其他原因呢?

回答1:第一你跑的算法有没有在nuScenes上进行实验,第二其他在nuScenes上实验的算法配置是怎样,这些你对比下

18.大佬们好,雷达cfar前数据(频谱数据)和camera有哪些融合方案或者论文可以参考,最好是稀疏的方法,求甩在我脸上

回答1:centerfusion、RCBEV可以看看

19.想问下有没有介绍相机,激光雷达等传感器原理的书籍或资料,包括传感器内部的原理和故障分析等等,感谢!

回答1:硬件这块确实没见过,相机的话有一些相机标定的书,激光雷达这些是不是看产品手册会更好?

回答2:B站上搜 激光雷达 拆解

20.目前在自动驾驶领域 有没有真实数据和生成数据相结合的数据集

回答1:一般有用合成数据结合生成数据一起用提升性能的,直接做一个真实+合成意义不大,合成数据可以根据真实的做

回答2:这里面有些数据集,你可以看看【计算机视觉中的合成数据增强方法】

21.occ bev可以使用广角和鱼眼镜头一起组合使用么,因为提特征的网络是一样的,不同畸变的镜头一起组合使用有问题么,各个厂家有使用鱼眼镜头做occ bev任务么

回答1:大部分是去了畸变再进网络,地平线7号有篇部署ParkingE2E到J6的Demo就是这么做的。老哥也在做鱼眼Occ吗,可以交流下

22.现在大模型的可部署性怎么样?现在在车载芯片上可以用好大模型吗?

回答1:可以部署的,把模型裁一裁。本质还是transformer的部署。大模型可以用在座舱和端到端,可以参考下理想小鹏长安的发布会

#博世将裁员5500人,汽车行业寒冬来了?

博世在华面临的情况完全不同,它反而需要加快速度,跟上中国车企智能化和电动化转型节奏

博世计划在全球裁员5550人,其中包括德国工厂3800人。德国当地时间11月22日,博世和德国工会组织IG Metall发布上述信息,IG Metall反对博世这一计划。

博世曾在11月初警告,如果2024年财务目标无法实现,将在全球范围进行裁员。博世称,汽车市场销量疲软,行业整体出现产能过剩。同时,行业转向电动化、智能驾驶、集中式软件控制等方面的速度不及预期,汽车企业正在推迟或放弃很多这些领域的项目。博世是全球最大的汽车零部件供应商,难免受到影响。

近期欧洲车企也在密集采取措施降本或裁员。11月20日,福特汽车宣布将在欧洲裁员4000人,数量相当于欧洲员工总数的14%。

11月21日,大众汽车集团与工会进行了新一轮劳资谈判,双方还没有就关键条款达成一致。工会威胁将在12月1日举行大规模罢工。

#DeSiRe-GS

专为自动驾驶而生!彻底摒弃3D框,动静态重建完美解耦(UC Berkeley最新)

UC Berkeley最新的工作,提出了DeSiRe GS。全新自监督高斯飞溅表示,可以在复杂的驾驶场景中实现有效的静态-动态分解和高保真表面重建。我们的方法采用动态街道高斯的两阶段优化流水线。在第一阶段,由于3DGS只能重建动态环境中的静态区域,因此首先提取2D运动目标mask。然后这些提取的2D运动先验以可微的方式映射到高斯空间,在第二阶段利用动态高斯的有效公式。结合引入的几何正则化,我们的方法能够解决自动驾驶中数据稀疏引起的过拟合问题,重建与物体表面对齐而不是漂浮在空中的物理上合理的高斯分布。此外,我们引入了时间跨视图一致性,以确保跨时间和视点的一致性,从而实现高质量的表面重建。综合实验证明了DeSiRe GS的效率和有效性,超越了先前的自监督技术,实现了与依赖外部3D边界框标注的方法相当的准确性。

- 开源链接:https://github.com/chengweialan/DeSiRe-GS

总结来说,本文的主要贡献如下:

- 本文基于3DGS无法成功建模动态区域的简单观察,从外观差异中轻松提取运动信息。

- 然后以可微的方式使用time-varying高斯将提取的局部帧中的2D运动先验提取到全局高斯空间中。

- 引入了有效的3D正则化和时间交叉视图一致性,以生成物理上合理的高斯球,进一步增强高质量的分解和重建。

相关工作回顾

城市场景重建。新视图合成的最新进展,如神经辐射场(NeRF)和3D高斯散斑(3DGS),显著推进了城市场景重建。许多研究已经将NeRF集成到自动驾驶的工作流程中。Urban Radiance Fields结合了激光雷达和RGB数据,而Block NeRF和Mega NeRF则对大型场景进行了分区,以进行并行训练。然而,动态环境带来了挑战。NSG使用神经场景图来分解动态场景,SUDS引入了一个用于4D场景表示的多分支哈希表。EmerNeRF和RoDUS等自我监督方法可以有效地应对动态场景挑战。EmerNeRF通过场景流估计捕获目标对应关系,RoDUS利用基于核的鲁棒训练策略结合语义监督。

在基于3DGS的城市重建中,最近的工作引起了人们的关注。StreetGaussians使用球谐函数分别对静态和动态场景进行建模,而DrivingGaussian引入了用于静态背景和动态目标重建的特定模块。OmniRe通过动态高斯场景图统一了静态和动态对象重建。

静态动态分解。几种方法试图对动态和静态部件的变形进行建模。D-NeRF、Nerfiles、Deformable GS和4D-GS通过引入变形场扩展了vanilla NeRF或3DGS。他们计算规范到观测的转换,并通过变形网络分离静态和动态组件。然而,由于学习密集变形参数需要大量的计算资源,将这些方法应用于大规模驾驶场景具有挑战性,不准确的分解会导致次优性能。

对于自动驾驶场景,NSG将动态和静态部分建模为神经场景图中的节点,但需要额外的3D注释。其他基于NeRF的方法利用多分支结构分别训练时变和时不变特征。基于3DGS的方法,也侧重于静态-动态分离,但仍面临局限性。PVG为每个高斯函数分配速度和寿命等属性,区分静态和动态。然而,这种分离仍然不完整,缺乏彻底性。

神经表面重建。传统的神经曲面重建方法更侧重于真实的几何结构。随着神经辐射场(NeRF)技术的兴起,神经隐式表示显示出高保真表面重建的前景。StreetSurf建议在城市环境中解开近景和远景,以更好地进行隐式表面重建。

3D GS重新引起了人们对显式几何重建的兴趣,最近的工作侧重于几何正则化技术。SuGaR通过引入和附加正则化项将高斯椭球体与物体表面对齐,而2DGS直接用2D圆盘替换3D椭球体,并利用截断符号距离函数(TSDF)融合深度图,实现无噪声的表面重建。PGSR引入了单视图和多视图正则化,以实现多视图一致性。GSDF和NeuSG将3D高斯与神经隐式SDF相结合,以增强表面细节。TrimGS通过修剪不准确的几何体来细化表面结构,保持与3DGS和2DGS等早期方法的兼容性。虽然这些方法在小规模重建中表现出色,但较新的作品旨在解决大规模的城市场景。RoGS提出了与路面物理特性相一致的2D高斯曲面表示。

DeSiRe-GS方法详解

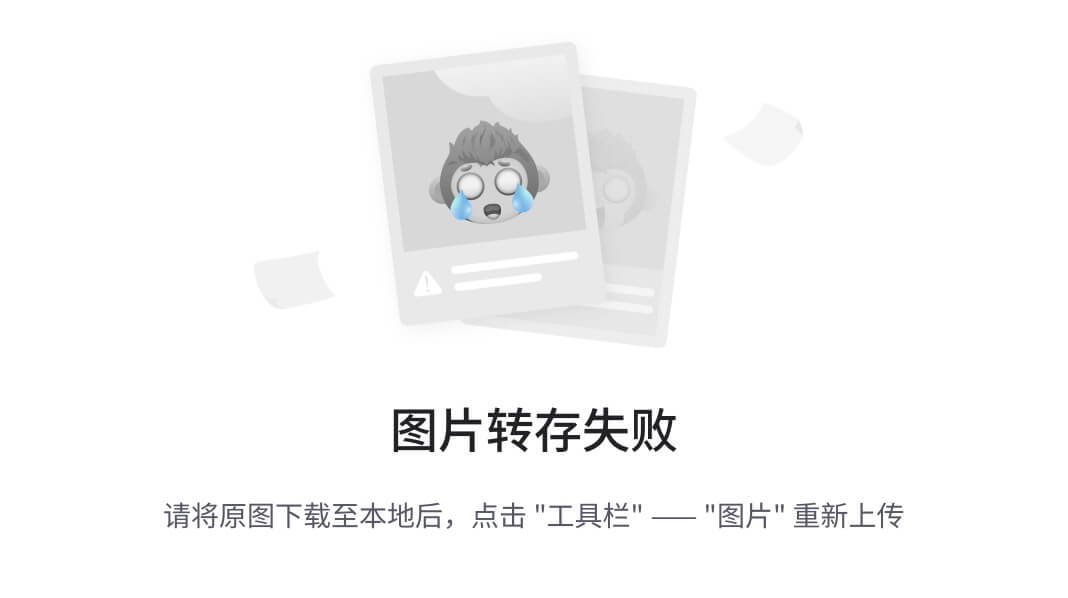

如图2所示,训练过程分为两个阶段。我们首先通过计算渲染图像和GT图像之间的特征差来提取2D运动mask。在第二阶段,我们使用PVG将2D运动信息提取到高斯空间中,从而能够以可微的方式纠正每个高斯的不准确属性。

Dynamic Mask Extraction (stage I)

在第一阶段,我们观察到3D高斯散斑(3DGS)在重建静态元素方面表现良好,例如驾驶场景中停放的汽车和建筑物。然而它很难准确地重建动态区域,因为原始的3DGS没有包含时间信息。如图2(阶段1)所示,这种限制会导致渲染图像中出现重影状浮点等伪影。为了解决这个问题,我们利用静态和动态区域之间的显著差异,开发了一种有效的方法来提取编码运动信息的分割mask。

最初,采用预训练的基础模型从渲染图像和用于监督的GT图像中提取特征。设F表示从渲染图像I中提取的特征,F表示从GT图像I中抽取的特征。为了区分动态和静态区域,我们计算相应特征之间的每像素相异度D。相异度度量D对于类似特征接近0,表示静态区域,对于不同特征接近1,对应于动态区域。

当预训练模型被冻结时,计算出的相异度得分不涉及任何可学习的参数。我们提出了一种多层感知器(MLP)解码器来预测动态度δ,而不是对D应用简单的阈值来生成运动分割mask。该解码器利用提取的特征,其中包含丰富的语义信息,同时采用相异性得分来指导和优化解码器的学习过程。

通过采用等式7中定义的损失函数,解码器被优化以预测与动态区域对应的D较高的区域中的较低值,从而最小化损失。然后,我们可以获得二进制掩码编码运动信息(ε是固定阈值):

在训练过程中,图像渲染和mask预测的联合优化是相辅相成的。通过在监控过程中排除动态区域,渲染图像和GT图像之间的差异变得更加明显,从而有助于提取运动蒙版。

Static Dynamic Decomposition (stage II)

虽然第一阶段提供了有效的动态mask,但这些mask仅限于图像空间而不是3D高斯空间,并且依赖于GT图像。这种依赖性限制了它们在新型视图合成中的适用性,在这种情况下,监督图像可能不可用。

为了将2D运动信息从第一阶段桥接到3D高斯空间,我们采用了PVG,一种动态场景的统一表示(第3节)。然而,PVG对图像和稀疏深度图监督的依赖带来了挑战,因为很难从间接监督信号中学习到准确的运动模式。因此,如图2(第2阶段)所示,渲染的速度图V通常包含噪声异常值。例如,速度应为零的道路和建筑物等静态区域没有得到有效处理。这导致场景分解不令人满意,PVG经常对预期速度为零的区域进行错误分类。

为了缓解这个问题并生成更精确的高斯表示,我们结合了从第一阶段获得的分割mask来正则化2D速度图V,该速度图V是从3D空间中的高斯图渲染的。

最小化Lv会惩罚速度应为零的区域,有效地消除了原始PVG产生的噪声异常值。该过程将运动信息从2D局部帧传播到全局高斯空间。对于每个高斯分布,通过应用一个简单的阈值,可以区分动态和静态高斯分布。与PVG和S3Gaussian相比,这种方法实现了更优的自监督分解,而不需要额外的3D标注,如之前方法中使用的边界框。

Surface Reconstruction

Geometric Regularization

Flattening 3D高斯:受2D高斯散斑(2DGS)的启发,我们的目标是将3D椭球体压平成2D圆盘,使优化的高斯更好地符合物体表面,并实现高质量的表面重建。3DGS的尺度s=(s1,s2,s3)定义了椭球体沿三个正交轴的大小。最小化沿最短轴的比例有效地将3D椭球体转换为2D磁盘。缩放正则化损失为:

![]()

法线推导:曲面法线对于曲面重建至关重要。以前的方法通过向每个高斯函数附加一个法向量来合并法线,然后使用该法向量来渲染法线图N。使用地面真值法线图来监督高斯法线的优化。然而,这些方法往往无法实现精确的表面重建,因为它们忽略了尺度和法线之间的内在关系。我们不附加单独的法向量,而是直接从尺度向量s中推导出法向量n。法向量方向自然与对应于最小尺度分量的轴对齐,因为高斯在展平正则化后形状像圆盘。

![]()

通过这种法线公式,梯度可以反向传播到尺度向量,而不是附加的法线向量,从而促进高斯参数的更好优化。正常损失是:

![]()

Giant高斯正则化:我们观察到,3DGS和PVG都可以在不进行额外正则化的情况下产生超大高斯椭球,特别是在无界驱动场景中,如图3(a)所示。

我们的主要目标是拟合适当缩放的高斯分布,以支持精确的图像渲染和表面重建。虽然具有低不透明度的超大高斯椭球体对渲染图像的影响可能很小,但它们会严重损害表面重建。这是一个在仅关注2D图像渲染的现有方法中经常被忽视的局限性。为了解决这个问题,我们为每个高斯函数引入了一个惩罚项:

![]()

Temporal Spatial Consistency

在驾驶场景中,视图的稀疏性通常会导致高斯优化过程中对训练视图的过拟合。单视图图像丢失特别容易受到远距离无纹理区域的挑战。因此,依赖图像和稀疏深度图的光度监督是不可靠的。为了解决这个问题,我们建议通过利用时间交叉视图信息来增强几何一致性。

在假设静态区域的深度在不同视图之间随时间保持一致的情况下,我们引入了一个跨视图时空一致性模块。对于参考系中深度值为dr的静态像素(ur,vr),我们将其投影到最近的相邻视图——重叠最大的视图。使用相机内部函数K和外部函数Tr、Tn,相邻视图中的相应像素位置计算如下:

![]()

然后,我们查询相邻视图中(un,vn)处的深度值dn。将其投影回3D空间,得到的位置应与通过将(ur,vr,dr)反向投影到参考系而获得的位置对齐:

![]()

为了加强交叉视图深度一致性,我们应用几何损失来优化高斯分布,定义为:

![]()

这种损失促使高斯人随着时间的推移在视图中产生几何一致的深度。

优化

第一阶段:在第一阶段,我们的目标是利用运动掩模和渲染图像的联合优化来有效地学习运动掩模。因此,我们只使用遮蔽图像损失LI:

![]()

![]()

第二阶段:我们使用阿尔法混合来渲染深度图、法线图和速度图,如下所示:

![]()

![]()

实验结果

结论

本文提出了一种用于驾驶场景中静态动态分解和高质量表面重建的自监督方法DeSiRe GS。通过引入运动掩模模块并利用时间几何一致性,DeSiRe GS解决了动态对象建模和数据稀疏性等关键挑战。

#理想汽车大模型算法工程师面试,被问的瑟瑟发抖

最近面试了理想汽车大模型岗位,被面试官强度拉满了...不仅问到了很多大模型的基础,还有RAG、强化学习、部署的各种问题,尤其是对大模型如何落地自动驾驶进行了很长时间的讨论。毕竟理想的VLM是国内首个上车的,这块的经验积累还是比较丰富。

本文章主要记录了本小菜研找实习的坎坷历程,欢迎大佬们给建议!!!

1. 自我介绍

自我介绍环节主要是让大家进入快速面试状态,聊聊个人基本信息、教育背景、工作经历和技能特长等等。

2. 项目面

因为我简历上面写一个RAG项目,所以面试官主要围绕RAG进行提

- 问聊一下RAG项目总体思路?

- 在做RAG项目过程中遇到哪些问题?怎么解决的?

- RAG项目里面有哪一些亮点?目前开源的RAG项目非常多,你的项目和他们有什么区别?

- ...

通用大模型也问到了很多基础的内容:

- 阿里的Qwen-VL

- 任意模态算法X-InstructBLIP

- 统一视觉任务大模型的Florence2

- ...

3. 技术问题回答

3.1 简单介绍一下大模型存在哪些问题?有什么好的解决方法?

- 大模型幻觉问题

- 外挂知识库

- 大模型微调

- 强化学习

- ...

3.2 大模型加速框架了解多少,知不知道原理 如何进行加速优化?

- vLLM

- vLLm 运行大模型非常快主要使用以下方法实现的

- 先进的服务吞吐量

- 通过PageAttention 对attention key & value 内存进行有效的管理

- 对于输入请求的连续批处理

- 高度优化的CUDA kernels

- OpenLLM

- OpenLLM 运行大模型非常快主要使用以下方法实现的

- 促进实际生产过程中的大模型的部署,微调,服务和监测.

- TensorRT-llm

- DeepSpeed-MII 运行大模型非常快主要使用以下方法实现的

- 组装优化大语言模型推理解决方案的工具,提供Python API 来定义大模型,并为 NVIDIA GPU 编译高效的 TensorRT 引擎.

3.3 如何看待自动驾驶大模型?以及如何落地自动驾驶大模型?

这块聊了很多自动驾驶大模型的工作,像经典的DriveGPT4、OpenDriveLab的DriveLM,当然也离不开理想自己的工作DriveVLM,估计也是他们快慢双系统借鉴的核心算法。实战这块我自己跑过DriveLM,面试官还是比较感兴趣的,这块深入聊聊蛮多算法细节。

目前来看国内端到端的技术路线已经明确:就是端到端+大模型!据我了解,除了理想,像长安/小鹏都宣称大模型上车了。智能座舱和具身智能这块也是当下非常火爆的方向。未来大模型除了指导快系统外,像数据挖掘、标注等等应该都值得进一步探索。

#极氪副总裁加入新公司

据悉,极氪副总裁、电子电气架构负责人谢保军离职之后,加入了奇瑞旗下的大卓科技。

大卓智能在组织变化上并不止谢保军的加入。今年大卓智能的管理团队的架构发生了调整变化。原本是谷俊丽为CEO,曹光植为CTO,一个负责整体统筹管理,一个负责技术开发。而今年原奇瑞内部自动驾驶技术中心负责人张晓洪被派到大卓智能,担任COO,负责智驾产品技术、项目开发工作。

张晓洪是华为背景出身,曾担任华为汽车BU智能驾驶产品项目群总监,于2021年加入蔚来,后又从蔚来跳槽到奇瑞。

大卓智能人事变化的背后是奇瑞在智驾上着急追赶。在今年,奇瑞董事长尹同跃在多个场合对大卓智能董事长高新华表示,要把智驾水平追上去做到头部阵营。

其实着急的不止是奇瑞,今年各家传统主机厂都在密集的调整动作。有的在切换智驾供应商体系,把量产干的拉跨的踢掉,换上技术实力强的,最典型的是集体”投华“拥抱华为;有的在对自研团队调整,烧钱但不干出东西的自研负责人被调整。

11月份的广州车展上,在奇瑞的展台上尹总接待了探访的何小鹏。当着何小鹏的面,尹总叮嘱高新华,在智能化上要追赶上何小鹏的背影。

尹总和何小鹏聊了聊智驾。尹总称赞小鹏的智能化做的太棒了,又调侃的说何小鹏“你们是年轻精英,把我们这些老汉逼得也要开始搞人工智能了”。

何小鹏也给尹总分享了一个“小经验”,智驾直播一定要BOSS亲自上,这样才能使技术团队有足够的压力全力以赴,才会把智驾体验做好。

对于传统主机厂做智驾这个事来说,何小鹏的话点出了关键。老大就得像普通用户一样去体验测试,才能摸清真实技术水平。而不是只听汇报,汇报这个事本来就容易层层注水,就容易陷入“信息茧房”处境之中。

无论是采用供应商还是自研方案,做的到底怎么样,拉出来溜溜就知道了。就像尹总说的,找个最难开的城市、最拥堵的时间段,来一次“小考”。