池化层(Pooling Layer),也被称为下采样层,是深度学习神经网络中常用的一种层级结构。它通常紧跟在卷积层之后,对卷积层输出的特征图进行下采样操作。

一、定义与功能

池化层的主要作用是通过减少特征图的尺寸来降低计算量,并且可以提取出特征图的主要信息。它通常紧跟在卷积层之后,对卷积层输出的特征图进行下采样操作。下采样是一种减少数据维度的方法,可以有效地降低模型复杂度,提高模型的泛化能力。具体操作则是,基于局部相关性的思想,通过从局部相关的一组元素中进行采样或信息聚合,从而得到新的元素值。

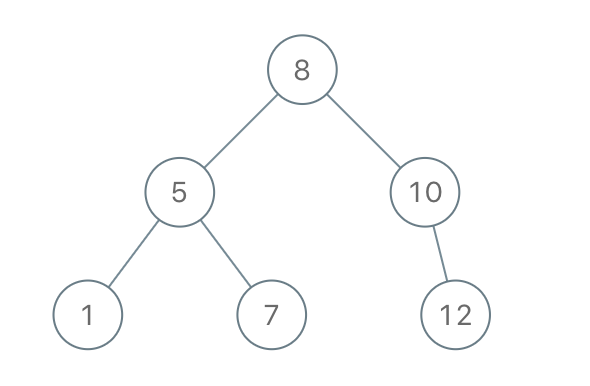

CNN架构中一般要进行多次池化操作,以实现尺寸缩减功能。

图1 CNN架构中一般要进行多次池化操作

二、池化层的参数

池化层通常有以下几个参数:

- 池化窗口大小(kernel_size):池化操作的窗口大小,决定了局部区域的范围。

- 步幅(stride):窗口在特征图上滑动的步长,决定了输出特征图的尺寸。

- 填充(padding):在特征图的边缘添加额外的像素,以控制池化后特征图的尺寸。

三、常见类型

池化层有多种类型,常见的包括最大池化(Max Pooling)、平均池化(Average Pooling)以及全局池化(Global Pooling)等。

1. 最大池化(Max Pooling)

最大池化,选择每个区域(池化层的感受野)中的最大值作为输出。这种方法可以保留输入数据中最显著的特征,同时减少计算量。

池化层的输入数据以5×5大小为例,考虑池化层感受野窗口大小

,步长

的情况,如图2。绿色虚线方框代表第一个感受野的位置,感受野元素集合为{1,-1,-1,-2},在最大池化采样的方法下

。绿色实线方框代表第二个感受野的位置。

图2 最大池化第一步

同当逐渐移动感受野窗口至最右边,此时窗口已经到达输入边缘,按照卷积层同样的方式,感受野窗口向下移动一个步长,并回到行首,如图3:

图3 最大池化中间步骤

循环往复,直至最下方、最右边,获得最大池化层的输出,长宽为4×4,略小于输入的高宽,如图4:

图4 最大池化最后一步

通过精心设计池化层感受野的高宽和步长

参数,可以实现各种降维运算。比如,一种常用的池化层设定是感受野大小

,步长

,这样可以实现输出只有输入高宽一半的目的。如下图,感受野

,步长

,输入

高宽为4×4 ,输出

高宽只有2×2。

图5 调整池化层感受野的高宽和步长以改变输出尺寸

2. 平均池化(Average Pooling)

平均池化,取每个区域(池化层的感受野)内的平均值作为输出。与最大池化相比,平均池化更加平滑,可以在一定程度上减少噪声。

池化层的输入数据以5×5大小为例,考虑池化层感受野窗口大小

,步长

的情况,如图6。绿色实线方框代表第一个感受野的位置,感受野元素集合为{1,-1,-1,-2},在最平均池化采样的方法下

。

图6 平均池化

3. 全局池化(Global Pooling)

全局池化,将整张特征图压缩成一个值,通常用于分类任务的最后一层。全局池化可以减少参数数量,提高模型的泛化性能。常见的全局池化包括全局最大池化(Global Max Pooling)和全局平均池化(Global Average Pooling)。

(1)全局最大池化(Global Max Pooling)

全局最大池化将每个通道的整个特征图缩减为一个值,常用于分类任务的最后一层。

图7 全局最大池化

(2)全局平均池化(Global Average Pooling)

全局平均池化将每个通道的整个特征图缩减为一个值,常用于分类任务的最后一层。

图8 全局平均池化

四、特点与优势

1. 降低计算量:通过减少特征图的尺寸,池化层可以显著降低后续层的计算量。

2. 提取主要特征:池化层能够提取出特征图的主要信息,去除冗余和噪声。

3. 平移不变性:池化层对输入数据的微小平移变化具有一定的鲁棒性。

五、改进方法

尽管池化层在神经网络中具有诸多优势,但也存在信息丢失和忽略重要特征的问题。为了解决这些问题,研究人员提出了一些改进的方法:

1. 自适应池化(Adaptive Pooling):是一种灵活的池化方法,根据输入数据的特性自适应地调整池化窗口的大小和步长,以匹配特定的输出尺寸。

2. 金字塔池化:采用不同尺寸的池化窗口对输入数据进行多尺度采样,以捕捉更多特征信息。

六、应用场景

池化层在卷积神经网络中扮演着重要的角色,广泛应用于图像分类、目标检测、图像分割等任务中。通过与其他层级结构(如卷积层、全连接层等)相结合,可以构建出高效、准确的深度学习模型。

综上所述,池化层是深度学习神经网络中不可或缺的一部分。它通过下采样操作有效地降低计算量、提取主要特征,并具有一定的平移不变性。随着深度学习技术的不断发展,池化层将在更多领域得到广泛应用和深入研究。