用于网络爬行的免费软件库、软件包和 SDK?或者它是您需要的网络抓取工具吗?

嘿,我们是 Apify 。您可以在 Apify 平台上构建、部署、共享和监控您的抓取工具和爬虫。 来看看我们吧。

如果您厌倦了专有网络抓取工具的限制和成本,或者厌倦了被单一供应商锁定,开源网络爬虫和抓取工具可以提供灵活的、可定制的替代方案。

但并非所有开源工具都是相同的。

有些是成熟的库,能够处理大规模数据提取项目,而另一些则擅长动态内容,或者是较小、轻量级任务的理想选择。正确的工具取决于您项目的复杂性、您需要的数据类型以及您首选的编程语言。

我们在这里介绍的库、框架和 SDK 考虑到了开发人员的多样化需求,因此您可以选择满足您要求的工具。

什么是开源网络爬虫和网络爬虫?

开源网络爬虫和抓取工具可让您根据需要调整代码,而无需支付许可证或限制费用。爬虫收集广泛的数据,而爬虫则针对特定信息。像下面这样的开源解决方案提供了社区驱动的改进、灵活性和可扩展性——不受供应商锁定。

2024 年排名前 11 位的开源网络爬虫和爬虫

1. 克劳利

语言:Node.js、Python | GitHub:15.4K+ 星 | 关联

Crawlee 是一个完整的网络抓取和浏览器自动化库,旨在快速有效地构建可靠的爬虫。凭借内置的防屏蔽功能,它使您的机器人看起来像真正的人类用户,从而降低了被屏蔽的可能性。

Crawlee 可在 Node.js 和 Python 中使用,提供统一的界面,支持 HTTP 和无头浏览器爬行,使其适用于各种抓取任务。它与 Cheerio 和 Beautiful Soup 等库集成,以实现高效的 HTML 解析,并与 Puppeteer 和 Playwright 等无头浏览器集成,以实现 JavaScript 渲染。

该库在可扩展性方面表现出色,可以根据系统资源自动管理并发,轮换代理以提高效率,并采用类人的浏览器指纹来避免检测。 Crawlee 还通过持久 URL 队列以及数据和文件的可插入存储来确保稳健的数据处理。

优点:

- 只需更改几行代码,即可在简单的 HTTP 请求/响应处理和复杂的 JavaScript 页面之间轻松切换。

- 内置复杂的防阻塞功能,例如代理旋转和生成类人指纹。

- 集成用于常见任务(如链接提取、无限滚动和阻止不需要的资源)的工具,以及对 Cheerio 和 JSDOM 的支持,提供了一个开箱即用的全面抓取工具包。

缺点:

- 其全面的功能集以及了解 HTTP 和基于浏览器的抓取的要求可能会造成陡峭的学习曲线。

? Node.js 的 Crawlee 网页抓取教程

最适合:Crawlee 非常适合寻求使用 JavaScript/TypeScript 和 Python 管理简单和复杂的 Web 抓取和自动化任务的开发人员和团队。它对于抓取结合静态和动态页面的 Web 应用程序特别有效,因为它允许在不同类型的爬虫之间轻松切换以处理每种情况。

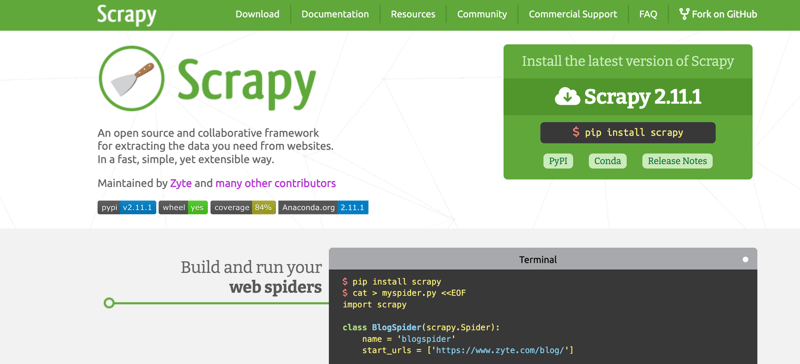

2. Scrapy

语言:Python | GitHub:52.9k 星 | 关联

Scrapy 是 Python 生态系统中最完整、最流行的网页抓取框架之一。它是使用事件驱动的网络框架 Twisted 编写的,赋予 Scrapy 异步功能。

作为专门为数据提取而设计的综合性网络爬虫框架,Scrapy 提供了对处理请求、处理响应以及以多种格式(包括 CSV、JSON 和 XML)导出数据的内置支持。

它的主要缺点是它不能原生处理动态网站。但是,您可以使用 Playwright 或 Selenium 等浏览器自动化工具配置 Scrapy 来解锁这些功能。

? 了解有关使用 Scrapy 进行网页抓取的更多信息<