1. 定义:

- 每一个节点都跟其后面所有的神经元相连

- 两层之间所有神经元都有权重连接,通常全连接层在卷积神经网络尾部

- 也就是跟传统的神经网络神经元的连接方式是一样的

2. 作用:

- 全连接层(fully connected layers,FC)在整个卷积神经网络中起到“分类器”的作用。

- 如果说卷积层、池化层和激活函数层等操作是将原始数据映射到隐层特征空间的话,全连接层则起到将学到的“分布式特征表示”映射到样本标记空间(样本输出空间)的作用。

- 简单来说:它把特征值整合到一起,输出为一个值。

- 这样做的好处:就是大大减少特征位置对分类带来的影响。

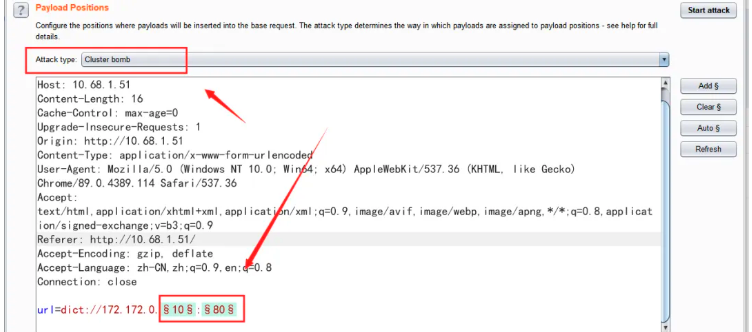

3. 应用举例:

-

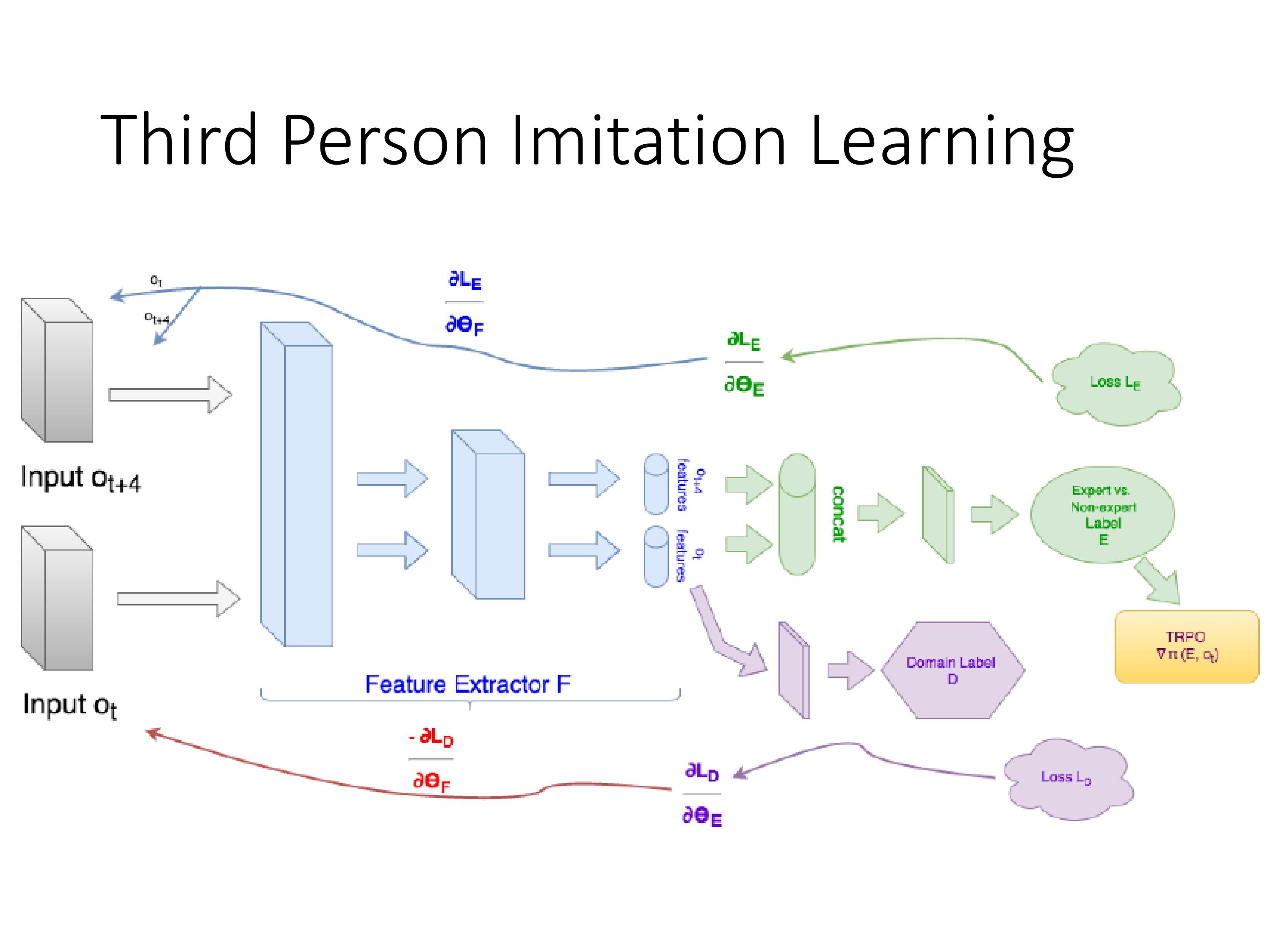

从上图我们可以看出,猫在不同的位置,输出的feature值相同,但是位置不同。

-

对于电脑来说,特征值相同,但是特征值位置不同,那分类结果也可能不一样。

-

这时全连接层filter的作用就相当于

猫在哪我不管,只要找到猫就可以,于是让全连接层filter去把这个猫找到,实际就是把feature map 整合成一个值。

这个值大,有猫,这个值小,那就可能没猫,和这个喵在哪关系不大了,鲁棒性有大大增强。 -

因为空间结构特性被忽略了,所以全连接层不适合用于在方位上找Pattern的任务,比如segmentation。

-

全连接层中一层的一个神经元就可以看成一个多项式(类似加权平均),我们用许多神经元去拟合数据分布

-

但只用一层fully connected layer 有时候没法解决非线性问题,而如果有两层或以上fully connected layer就可以很好地解决非线性问题了

4. 其它理解

-

通过特征提取,实现分类,我们现在的任务是去区别一图片是不是猫

-

假设这个神经网络模型已经训练完了,全连接层已经知道

-

当我们得到以上特征,我就可以判断这个是猫。因为全连接层的作用主要就是实现分类(Classification)

-

同一层的其他神经元,要么猫的特征不明显,要么没找到

当我们把这些找到的特征组合在一起,发现最符合要求的是猫

ok,我认为这是猫了 -

这细节特征又是怎么来的?

就是从前面的卷积层,下采样层来的

5. 其它

-

全连接

![[学习笔记]线段树(全)](https://i-blog.csdnimg.cn/direct/f6ba796612d54bee9ecfb80f62c8ce6b.png#pic_center)