一、说明

这篇文章收集了有影响力的 10 个想法,我们将来可能会看到更多。

对于每个想法,我们将重点介绍 1-2 篇执行良好的论文。为了保持列表简洁,这里没有涵盖所有相关工作。该列表必然是主观的,涵盖主要与迁移学习和泛化相关的想法。其中大多数(除了一些例外)都不是趋势(但我怀疑有些可能会在 2019 年变得更加“时尚”)。

1) 无监督 MT

ICLR 2018 上有两篇无监督的 MT 论文。令人惊讶的是,它们根本有效,但与监督系统相比,结果仍然很低。在 EMNLP 2018 上,无监督 MT 取得了长足的进步,来自同一两组的两篇论文比他们以前的方法有了显着改进。我的亮点:

- 基于短语的神经无监督机器翻译(EMNLP 2018):该论文在提炼无监督机器翻译的三个关键要求方面做得很好:良好的初始化、语言建模和反向任务建模(通过回译)。这三个在其他无监督的情况下也是有益的,我们将在下面看到。对逆向任务进行建模可以强制执行循环一致性,这已用于不同的方法中,尤其是在 CycleGAN 中。该论文进行了广泛的实验,甚至对两种资源匮乏的语言对(英语-乌尔都语和英语-罗马尼亚语)进行了评估。我们希望将来能看到更多关于低资源语言的工作。

无监督 MT 的三个原则的玩具插图。A) 两个单语数据集。B) 初始化。C) 语言建模。D) 回译(Lample et al., 2018)。

2) 预训练语言模型

使用预训练语言模型可能是今年最重要的 NLP 趋势,因此我不会在这里花太多时间。已经有大量令人难忘的方法:ELMo、ULMFiT、OpenAI Transformer 和 BERT。我的亮点:

- 深度语境化单词表示 (NAACL-HLT 2018):介绍 ELMo 的论文广受赞誉。除了令人印象深刻的实证结果外,它的亮点是仔细的分析部分,它梳理了各种因素的影响并分析了表示中捕获的信息。词义消歧 (WSD) 分析本身(左下方)执行得很好。两者都表明,LM 本身提供的 WSD 和 POS 标记性能接近最先进的技术。

与基线相比,第一层和第二层双向语言模型的词义消歧(左)和 POS 标记(右)结果(Peters et al., 2018)。

3) 常识推理数据集

将常识纳入我们的模型是前进的最重要方向之一。然而,创建好的数据集并不容易,即使是流行的数据集也显示出很大的偏差。今年,有一些执行良好的数据集试图向模型传授一些常识,例如来自华盛顿大学的 Event2Mind 和 SWAG。SWAG 出乎意料地很快得到解决。我的亮点:

- 视觉常识推理 (arXiv 2018):这是第一个包含每个答案的基本原理(解释)的视觉 QA 数据集。此外,问题需要复杂的推理。创建者不遗余力地解决可能的偏差,确保每个答案的先验正确概率为 25%(每个答案在整个数据集中出现 4 次,错误答案出现 3 次,正确答案出现 1 次);这需要使用计算相关性和相似性的模型来解决约束优化问题。希望防止可能的偏差将成为创建数据集时的常见组成部分。最后,看看数据的👇华丽呈现就知道了。

VCR:给定一张图像、一个区域列表和一个问题,模型必须回答问题并提供理由来解释为什么它的答案是正确的(Zellers et al., 2018)。

4) 元学习

元学习在小样本学习、强化学习和机器人技术中得到了广泛应用,最突出的例子是与模型无关的元学习 (MAML),但在 NLP 中的成功应用很少见。元学习对于训练示例数量有限的问题最有用。我的亮点:

- 低资源神经机器翻译的元学习 (EMNLP 2018):作者使用 MAML 来学习良好的翻译初始化,将每个语言对视为一个单独的元任务。适应低资源语言可能是 NLP 中元学习最有用的设置。特别是,将多语言迁移学习(如多语言 BERT)、无监督学习和元学习相结合是一个很有前途的方向。

迁移学习、多语言迁移学习和元学习之间的区别。实线:学习初始化。虚线:微调路径(Gu et al., 2018)。

5) 稳健的无监督方法

今年,我们和其他人观察到,当语言不同时,无监督的跨语言单词嵌入方法就会失效。这是迁移学习中的一种常见现象,其中源和目标设置之间的差异(例如,域适应中的域、持续学习和多任务学习中的任务)会导致模型恶化或失败。因此,使模型对此类更改更健壮非常重要。我的亮点:

- 一种用于单词嵌入的完全无监督跨语言映射的稳健自学习方法 (ACL 2018):本文不是元学习初始化,而是利用他们对问题的理解来制作更好的初始化。特别是,它们将两种语言中的单词配对,这些单词具有相似的单词分布。这是使用领域专业知识和分析中的见解来提高模型稳健性的一个很好的示例。

三个单词的相似性分布。等效翻译(“two”和“due”)比不相关的词(“two”和“cane”——意思是“狗”;Artexte et al., 2018)。

6) 理解表示

为了更好地理解表示,已经付出了很多努力。特别是,“诊断分类器”(旨在衡量学习的表示是否可以预测某些属性的任务)已经变得非常普遍。我的亮点:

- 剖析上下文词嵌入:架构和表示 (EMNLP 2018):本文在更好地理解预训练语言模型表示方面做得很好。他们在精心设计的无监督和有监督的任务中广泛研究学习的单词和跨度表示。结果发现:预训练表示在较低层学习与低级形态和句法任务相关的任务,在较高层学习长距离语义。对我来说,这确实表明预训练的语言模型确实捕获了与在 ImageNet 上预训练的计算机视觉模型相似的属性。

BiLSTM 和 Transformer 预训练表示在(从左到右)POS 标记、选区解析和无监督共指分辨率上的每层性能(Peters等人,2018 年)。

7) 巧妙的辅助任务

在许多情况下,我们已经看到越来越多地使用多任务学习和精心选择的辅助任务。对于一项好的辅助任务,数据必须易于访问。最突出的例子之一是 BERT,它使用下一句预测(已在 Skip-thoughts 中使用,最近在 Quick-thoughts 中使用)效果很好。我的亮点:

- 语义结构的句法支架 (EMNLP 2018):本文提出了一项辅助任务,通过预测每个跨度的相应句法组成类型来预训练跨度表示。尽管在概念上很简单,但辅助任务对跨度级别的预测任务(如语义角色标签和共指解析)有很大的改进。本文表明,在目标任务所需的级别(此处:跨度)学习的专业表示是非常有益的。

- pair2vec: 用于跨句子推理的组合词对嵌入 (arXiv 2018):与此类似,本文通过最大化词对与其上下文的逐点互信息来预训练词对表示。这鼓励模型学习更有意义的词对表示,而不是更一般的目标,例如语言建模。预训练的表示在需要跨句子推理的任务(如 SQuAD 和 MultiNLI)中非常有效。我们可以期待看到更多的预训练任务,这些任务捕获了特别适合某些下游任务的属性,并与语言建模等更通用的任务相辅相成。

来自 OntoNotes 的语法、PropBank 和共引用注释。PropBank SRL 参数和共指提及在句法成分之上进行注释。几乎每个论点都与句法成分有关(Swayamdipta et al., 2018)。

8) 将半监督学习与迁移学习相结合

随着迁移学习的最新进展,我们不应忘记使用目标任务特定数据的更明确方法。事实上,预训练表示与许多形式的半监督学习相辅相成。我们探索了自我标记方法,这是半监督学习的一个特殊类别。我的亮点:

- 使用交叉视图训练进行半监督序列建模 (EMNLP 2018):本文表明,一个概念上非常简单的想法,确保输入的不同视图上的预测与主模型的预测一致,可以在不同的任务集上带来收益。这个想法类似于 word dropout,但允许利用未标记的数据来使模型更加健壮。与其他自集成模型(如 mean teacher)相比,它是专门为特定的 NLP 任务设计的。随着隐式半监督学习的大量工作,我们希望看到更多明确尝试对目标预测进行建模的工作。

辅助预测模块看到的输入:辅助 1:他们前往__________________。辅助 2:他们前往华盛顿_______。辅助 3:乘飞机_____________华盛顿。辅助 4:飞机________________________(Clark et al., 2018)。

9) 大型文档的 QA 和推理

问答 (QA) 方面已经取得了许多发展,出现了一系列 新的 QA 数据集。除了对话式 QA 和执行多步推理外,QA 最具挑战性的方面是综合叙述和大量信息。我的亮点:

- NarrativeQA 阅读理解挑战赛 (TACL 2018):本文基于回答有关整个电影剧本和书籍的问题,提出了一个具有挑战性的新 QA 数据集。虽然当前方法仍然无法完成这项任务,但模型可以选择使用摘要(而不是整本书)作为上下文,选择答案(而不是生成答案)以及使用 IR 模型的输出。这些变体使任务更加可行,并使模型能够逐渐扩展到完整设置。我们需要更多像这样的数据集,这些数据集会带来雄心勃勃的问题,但仍然设法使它们可访问。

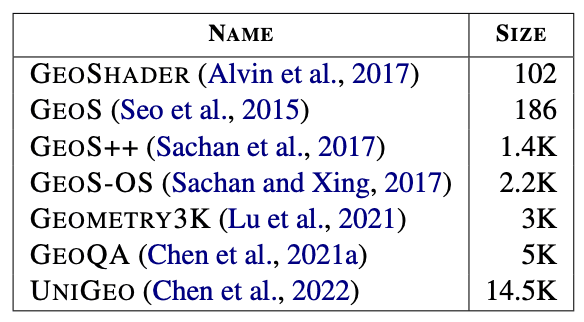

QA 数据集的比较(Kočiský et al., 2018)。

10) 感应偏置

归纳偏差(如 CNN 中的卷积)、正则化、随机失活和其他机制是神经网络模型的核心部分,它们充当正则化器,使模型更具样本效率。然而,提出一个广泛有用的归纳偏差并将其合并到模型中是具有挑战性的。我的亮点:

- 人类注意力的序列分类 (CoNLL 2018):本文提议使用来自眼动追踪语料库的人类注意力来规范 RNN 中的注意力。鉴于当前许多模型(如 Transformers)都使用注意力,因此找到更有效地训练注意力的方法是一个重要的方向。很高兴看到另一个例子,即人类语言学习可以帮助改进我们的计算模型。

- 语义角色标签的语言知情自我注意 (EMNLP 2018):这篇论文有很多值得喜欢的地方:一个在句法和语义任务上联合训练的 Transformer;在测试时注入高质量解析的能力;以及域外评估。它还通过训练一个 Attention Head 来处理每个标记的句法父级,从而规范 Transformer 的多头注意力,使其对语法更加敏感。我们可能会看到更多 Transformer 注意力头用作辅助预测器的例子,专注于输入的特定方面。

10 年的 PropBank 语义角色标签。语言知情自我注意 (LISA) 与其他方法在域外数据上的比