秋招面试专栏推荐 :深度学习算法工程师面试问题总结【百面算法工程师】——点击即可跳转

💡💡💡本专栏所有程序均经过测试,可成功执行💡💡💡

近年来,基于深度学习的人脸检测算法取得了很大进步。这些算法大致可以分为两类,即类似于Faster R-CNN的两阶段检测器和类似于YOLO的一阶段检测器。由于在一阶段检测器中准确性和速度之间有更好的平衡,因此它们被广泛应用于许多应用中。本文介绍了一个名为RFE的感受野增强模块,用于增强小目标的感受野。文章在介绍主要的原理后,将手把手教学如何进行模块的代码添加和修改,并将修改后的完整代码放在文章的最后,方便大家一键运行,小白也可轻松上手实践。以帮助您更好地学习深度学习目标检测YOLO系列的挑战。

专栏地址:YOLO11入门 + 改进涨点——点击即可跳转 欢迎订阅

目录

1. 论文

2. RFEM的代码实现

2.1 将RFEM添加到YOLO11中

2.2 更改init.py文件

2.3 添加yaml文件

2.4 在task.py中进行注册

2.5 执行程序

3.修改后的网络结构图

4. 完整代码分享

5. GFLOPs

6. 进阶

7.总结

1. 论文

论文地址:YOLO-FaceV2: A Scale and Occlusion Aware Face Detector——点击即可跳转

官方代码:官方代码仓库——点击即可跳转

2. RFEM的代码实现

2.1 将RFEM添加到YOLO11中

关键步骤一: 将下面代码粘贴到在/ultralytics/ultralytics/nn/modules/block.py中

class CBLinear(nn.Module):

"""CBLinear."""

def __init__(self, c1, c2s, k=1, s=1, p=None, g=1):

"""Initializes the CBLinear module, passing inputs unchanged."""

super(CBLinear, self).__init__()

self.c2s = c2s

self.conv = nn.Conv2d(c1, sum(c2s), k, s, autopad(k, p), groups=g, bias=True)

def forward(self, x):

"""Forward pass through CBLinear layer."""

outs = self.conv(x).split(self.c2s, dim=1)

return outs

class CBFuse(nn.Module):

"""CBFuse."""

def __init__(self, idx):

"""Initializes CBFuse module with layer index for selective feature fusion."""

super(CBFuse, self).__init__()

self.idx = idx

def forward(self, xs):

"""Forward pass through CBFuse layer."""

target_size = xs[-1].shape[2:]

res = [F.interpolate(x[self.idx[i]], size=target_size, mode="nearest") for i, x in enumerate(xs[:-1])]

out = torch.sum(torch.stack(res + xs[-1:]), dim=0)

return out

class TridentBlock(nn.Module):

def __init__(self, c1, c2, stride=1, c=False, e=0.5, padding=None, dilate=None, bias=False):

super(TridentBlock, self).__init__()

if padding is None:

padding = [1, 2, 3]

if dilate is None:

dilate = [1, 2, 3]

self.stride = stride

self.c = c

c_ = int(c2 * e)

self.padding = padding

self.dilate = dilate

self.share_weightconv1 = nn.Parameter(torch.Tensor(c_, c1, 1, 1))

self.share_weightconv2 = nn.Parameter(torch.Tensor(c2, c_, 3, 3))

self.bn1 = nn.BatchNorm2d(c_)

self.bn2 = nn.BatchNorm2d(c2)

self.act = nn.SiLU()

nn.init.kaiming_uniform_(self.share_weightconv1, nonlinearity="relu")

nn.init.kaiming_uniform_(self.share_weightconv2, nonlinearity="relu")

if bias:

self.bias = nn.Parameter(torch.Tensor(c2))

else:

self.bias = None

if self.bias is not None:

nn.init.constant_(self.bias, 0)

def forward_for_small(self, x):

residual = x

out = nn.functional.conv2d(x, self.share_weightconv1, bias=self.bias)

out = self.bn1(out)

out = self.act(out)

out = nn.functional.conv2d(out, self.share_weightconv2, bias=self.bias, stride=self.stride,

padding=self.padding[0],

dilation=self.dilate[0])

out = self.bn2(out)

out += residual

out = self.act(out)

return out

def forward_for_middle(self, x):

residual = x

out = nn.functional.conv2d(x, self.share_weightconv1, bias=self.bias)

out = self.bn1(out)

out = self.act(out)

out = nn.functional.conv2d(out, self.share_weightconv2, bias=self.bias, stride=self.stride,

padding=self.padding[1],

dilation=self.dilate[1])

out = self.bn2(out)

out += residual

out = self.act(out)

return out

def forward_for_big(self, x):

residual = x

out = nn.functional.conv2d(x, self.share_weightconv1, bias=self.bias)

out = self.bn1(out)

out = self.act(out)

out = nn.functional.conv2d(out, self.share_weightconv2, bias=self.bias, stride=self.stride,

padding=self.padding[2],

dilation=self.dilate[2])

out = self.bn2(out)

out += residual

out = self.act(out)

return out

def forward(self, x):

xm = x

base_feat = []

if self.c is not False:

x1 = self.forward_for_small(x)

x2 = self.forward_for_middle(x)

x3 = self.forward_for_big(x)

else:

x1 = self.forward_for_small(xm[0])

x2 = self.forward_for_middle(xm[1])

x3 = self.forward_for_big(xm[2])

base_feat.append(x1)

base_feat.append(x2)

base_feat.append(x3)

return base_feat

class RFEM(nn.Module):

def __init__(self, c1, c2, n=1, e=0.5, stride=1):

super(RFEM, self).__init__()

c = True

layers = [TridentBlock(c1, c2, stride=stride, c=c, e=e)]

c1 = c2

for i in range(1, n):

layers.append(TridentBlock(c1, c2))

self.layer = nn.Sequential(*layers)

self.bn = nn.BatchNorm2d(c2)

self.act = nn.SiLU()

def forward(self, x):

out = self.layer(x)

out = out[0] + out[1] + out[2] + x

out = self.act(self.bn(out))

return out2.2 更改init.py文件

关键步骤二:修改modules文件夹下的__init__.py文件,先导入函数

然后在下面的__all__中声明函数

2.3 添加yaml文件

关键步骤四:在/ultralytics/ultralytics/cfg/models/11下面新建文件yolo11_RFEM.yaml文件,粘贴下面的内容

- 目标检测

# Ultralytics YOLO 🚀, AGPL-3.0 license

# YOLO11 object detection model with P3-P5 outputs. For Usage examples see https://docs.ultralytics.com/tasks/detect

# Parameters

nc: 80 # number of classes

scales: # model compound scaling constants, i.e. 'model=yolo11n.yaml' will call yolo11.yaml with scale 'n'

# [depth, width, max_channels]

n: [0.50, 0.25, 1024] # summary: 319 layers, 2624080 parameters, 2624064 gradients, 6.6 GFLOPs

s: [0.50, 0.50, 1024] # summary: 319 layers, 9458752 parameters, 9458736 gradients, 21.7 GFLOPs

m: [0.50, 1.00, 512] # summary: 409 layers, 20114688 parameters, 20114672 gradients, 68.5 GFLOPs

l: [1.00, 1.00, 512] # summary: 631 layers, 25372160 parameters, 25372144 gradients, 87.6 GFLOPs

x: [1.00, 1.50, 512] # summary: 631 layers, 56966176 parameters, 56966160 gradients, 196.0 GFLOPs

# YOLO11n backbone

backbone:

# [from, repeats, module, args]

- [-1, 1, Conv, [64, 3, 2]] # 0-P1/2

- [-1, 1, Conv, [128, 3, 2]] # 1-P2/4

- [-1, 2, C3k2, [256, False, 0.25]]

- [-1, 1, Conv, [256, 3, 2]] # 3-P3/8

- [-1, 2, C3k2, [512, False, 0.25]]

- [-1, 1, Conv, [512, 3, 2]] # 5-P4/16

- [-1, 2, C3k2, [512, True]]

- [-1, 1, Conv, [1024, 3, 2]] # 7-P5/32

- [-1, 2, C3k2, [1024, True]]

- [-1, 1, SPPF, [1024, 5]] # 9

- [-1, 2, C2PSA, [1024]] # 10

- [-1, 1, RFEM, [1024]]

# YOLO11n head

head:

- [-1, 1, nn.Upsample, [None, 2, "nearest"]]

- [[-1, 6], 1, Concat, [1]] # cat backbone P4

- [-1, 2, C3k2, [512, False]] # 13

- [-1, 1, nn.Upsample, [None, 2, "nearest"]]

- [[-1, 4], 1, Concat, [1]] # cat backbone P3

- [-1, 2, C3k2, [256, False]] # 16 (P3/8-small)

- [-1, 1, Conv, [256, 3, 2]]

- [[-1, 13], 1, Concat, [1]] # cat head P4

- [-1, 2, C3k2, [512, False]] # 19 (P4/16-medium)

- [-1, 1, Conv, [512, 3, 2]]

- [[-1, 10], 1, Concat, [1]] # cat head P5

- [-1, 2, C3k2, [1024, True]] # 22 (P5/32-large)

- [[16, 19, 22], 1, Detect, [nc]] # Detect(P3, P4, P5)

- 语义分割

# Ultralytics YOLO 🚀, AGPL-3.0 license

# YOLO11 object detection model with P3-P5 outputs. For Usage examples see https://docs.ultralytics.com/tasks/detect

# Parameters

nc: 80 # number of classes

scales: # model compound scaling constants, i.e. 'model=yolo11n.yaml' will call yolo11.yaml with scale 'n'

# [depth, width, max_channels]

n: [0.50, 0.25, 1024] # summary: 319 layers, 2624080 parameters, 2624064 gradients, 6.6 GFLOPs

s: [0.50, 0.50, 1024] # summary: 319 layers, 9458752 parameters, 9458736 gradients, 21.7 GFLOPs

m: [0.50, 1.00, 512] # summary: 409 layers, 20114688 parameters, 20114672 gradients, 68.5 GFLOPs

l: [1.00, 1.00, 512] # summary: 631 layers, 25372160 parameters, 25372144 gradients, 87.6 GFLOPs

x: [1.00, 1.50, 512] # summary: 631 layers, 56966176 parameters, 56966160 gradients, 196.0 GFLOPs

# YOLO11n backbone

backbone:

# [from, repeats, module, args]

- [-1, 1, Conv, [64, 3, 2]] # 0-P1/2

- [-1, 1, Conv, [128, 3, 2]] # 1-P2/4

- [-1, 2, C3k2, [256, False, 0.25]]

- [-1, 1, Conv, [256, 3, 2]] # 3-P3/8

- [-1, 2, C3k2, [512, False, 0.25]]

- [-1, 1, Conv, [512, 3, 2]] # 5-P4/16

- [-1, 2, C3k2, [512, True]]

- [-1, 1, Conv, [1024, 3, 2]] # 7-P5/32

- [-1, 2, C3k2, [1024, True]]

- [-1, 1, SPPF, [1024, 5]] # 9

- [-1, 2, C2PSA, [1024]] # 10

- [-1, 1, RFEM, [1024]]

# YOLO11n head

head:

- [-1, 1, nn.Upsample, [None, 2, "nearest"]]

- [[-1, 6], 1, Concat, [1]] # cat backbone P4

- [-1, 2, C3k2, [512, False]] # 13

- [-1, 1, nn.Upsample, [None, 2, "nearest"]]

- [[-1, 4], 1, Concat, [1]] # cat backbone P3

- [-1, 2, C3k2, [256, False]] # 16 (P3/8-small)

- [-1, 1, Conv, [256, 3, 2]]

- [[-1, 13], 1, Concat, [1]] # cat head P4

- [-1, 2, C3k2, [512, False]] # 19 (P4/16-medium)

- [-1, 1, Conv, [512, 3, 2]]

- [[-1, 10], 1, Concat, [1]] # cat head P5

- [-1, 2, C3k2, [1024, True]] # 22 (P5/32-large)

- [[16, 19, 22], 1, Segment, [nc, 32, 256]] # Segment(P3, P4, P5)

- 旋转目标检测

# Ultralytics YOLO 🚀, AGPL-3.0 license

# YOLO11 object detection model with P3-P5 outputs. For Usage examples see https://docs.ultralytics.com/tasks/detect

# Parameters

nc: 80 # number of classes

scales: # model compound scaling constants, i.e. 'model=yolo11n.yaml' will call yolo11.yaml with scale 'n'

# [depth, width, max_channels]

n: [0.50, 0.25, 1024] # summary: 319 layers, 2624080 parameters, 2624064 gradients, 6.6 GFLOPs

s: [0.50, 0.50, 1024] # summary: 319 layers, 9458752 parameters, 9458736 gradients, 21.7 GFLOPs

m: [0.50, 1.00, 512] # summary: 409 layers, 20114688 parameters, 20114672 gradients, 68.5 GFLOPs

l: [1.00, 1.00, 512] # summary: 631 layers, 25372160 parameters, 25372144 gradients, 87.6 GFLOPs

x: [1.00, 1.50, 512] # summary: 631 layers, 56966176 parameters, 56966160 gradients, 196.0 GFLOPs

# YOLO11n backbone

backbone:

# [from, repeats, module, args]

- [-1, 1, Conv, [64, 3, 2]] # 0-P1/2

- [-1, 1, Conv, [128, 3, 2]] # 1-P2/4

- [-1, 2, C3k2, [256, False, 0.25]]

- [-1, 1, Conv, [256, 3, 2]] # 3-P3/8

- [-1, 2, C3k2, [512, False, 0.25]]

- [-1, 1, Conv, [512, 3, 2]] # 5-P4/16

- [-1, 2, C3k2, [512, True]]

- [-1, 1, Conv, [1024, 3, 2]] # 7-P5/32

- [-1, 2, C3k2, [1024, True]]

- [-1, 1, SPPF, [1024, 5]] # 9

- [-1, 2, C2PSA, [1024]] # 10

- [-1, 1, RFEM, [1024]]

# YOLO11n head

head:

- [-1, 1, nn.Upsample, [None, 2, "nearest"]]

- [[-1, 6], 1, Concat, [1]] # cat backbone P4

- [-1, 2, C3k2, [512, False]] # 13

- [-1, 1, nn.Upsample, [None, 2, "nearest"]]

- [[-1, 4], 1, Concat, [1]] # cat backbone P3

- [-1, 2, C3k2, [256, False]] # 16 (P3/8-small)

- [-1, 1, Conv, [256, 3, 2]]

- [[-1, 13], 1, Concat, [1]] # cat head P4

- [-1, 2, C3k2, [512, False]] # 19 (P4/16-medium)

- [-1, 1, Conv, [512, 3, 2]]

- [[-1, 10], 1, Concat, [1]] # cat head P5

- [-1, 2, C3k2, [1024, True]] # 22 (P5/32-large)

- [[16, 19, 22], 1, OBB, [nc, 1]] # Detect(P3, P4, P5)温馨提示:本文只是对yolo11基础上添加模块,如果要对yolo11n/l/m/x进行添加则只需要指定对应的depth_multiple 和 width_multiple。

# YOLO11n

depth_multiple: 0.50 # model depth multiple

width_multiple: 0.25 # layer channel multiple

max_channel:1024

# YOLO11s

depth_multiple: 0.50 # model depth multiple

width_multiple: 0.50 # layer channel multiple

max_channel:1024

# YOLO11m

depth_multiple: 0.50 # model depth multiple

width_multiple: 1.00 # layer channel multiple

max_channel:512

# YOLO11l

depth_multiple: 1.00 # model depth multiple

width_multiple: 1.00 # layer channel multiple

max_channel:512

# YOLO11x

depth_multiple: 1.00 # model depth multiple

width_multiple: 1.50 # layer channel multiple

max_channel:5122.4 在task.py中进行注册

关键步骤四:在parse_model函数中进行注册,添加RFEM,

先在task.py导入函数

然后在task.py文件下找到parse_model这个函数,如下图,添加RFEM,

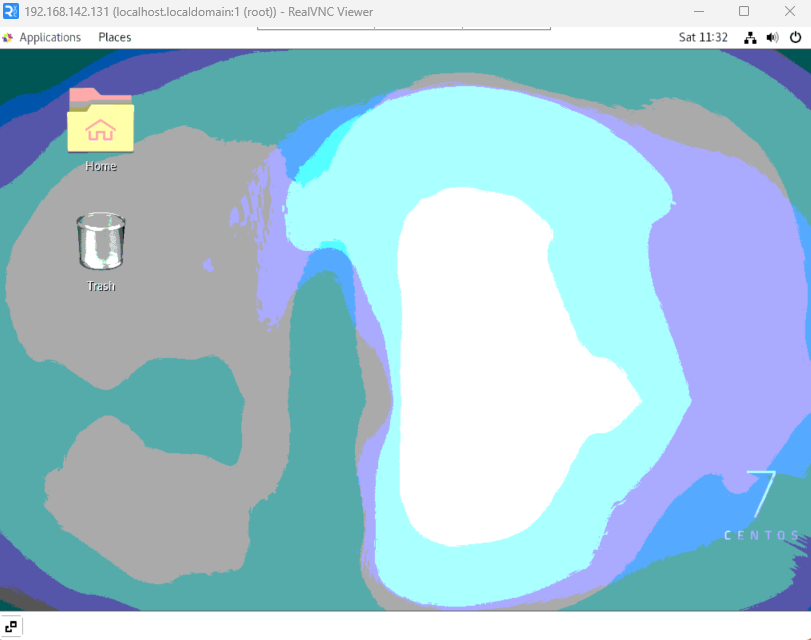

2.5 执行程序

关键步骤五:在ultralytics文件中新建train.py,将model的参数路径设置为yolo11_RFEM.yaml的路径即可

建议大家写绝对路径,确保一定能找到

from ultralytics import YOLO

import warnings

warnings.filterwarnings('ignore')

from pathlib import Path

if __name__ == '__main__':

# 加载模型

model = YOLO("ultralytics/cfg/11/yolo11.yaml") # 你要选择的模型yaml文件地址

# Use the model

results = model.train(data=r"你的数据集的yaml文件地址",

epochs=100, batch=16, imgsz=640, workers=4, name=Path(model.cfg).stem) # 训练模型🚀运行程序,如果出现下面的内容则说明添加成功🚀

from n params module arguments

0 -1 1 464 ultralytics.nn.modules.conv.Conv [3, 16, 3, 2]

1 -1 1 4672 ultralytics.nn.modules.conv.Conv [16, 32, 3, 2]

2 -1 1 6640 ultralytics.nn.modules.block.C3k2 [32, 64, 1, False, 0.25]

3 -1 1 36992 ultralytics.nn.modules.conv.Conv [64, 64, 3, 2]

4 -1 1 26080 ultralytics.nn.modules.block.C3k2 [64, 128, 1, False, 0.25]

5 -1 1 147712 ultralytics.nn.modules.conv.Conv [128, 128, 3, 2]

6 -1 1 87040 ultralytics.nn.modules.block.C3k2 [128, 128, 1, True]

7 -1 1 295424 ultralytics.nn.modules.conv.Conv [128, 256, 3, 2]

8 -1 1 346112 ultralytics.nn.modules.block.C3k2 [256, 256, 1, True]

9 -1 1 164608 ultralytics.nn.modules.block.SPPF [256, 256, 5]

10 -1 1 249728 ultralytics.nn.modules.block.C2PSA [256, 256, 1]

11 -1 1 328960 ultralytics.nn.modules.block.RFEM [256, 256]

12 -1 1 0 torch.nn.modules.upsampling.Upsample [None, 2, 'nearest']

13 [-1, 6] 1 0 ultralytics.nn.modules.conv.Concat [1]

14 -1 1 111296 ultralytics.nn.modules.block.C3k2 [384, 128, 1, False]

15 -1 1 0 torch.nn.modules.upsampling.Upsample [None, 2, 'nearest']

16 [-1, 4] 1 0 ultralytics.nn.modules.conv.Concat [1]

17 -1 1 32096 ultralytics.nn.modules.block.C3k2 [256, 64, 1, False]

18 -1 1 36992 ultralytics.nn.modules.conv.Conv [64, 64, 3, 2]

19 [-1, 13] 1 0 ultralytics.nn.modules.conv.Concat [1]

20 -1 1 119488 ultralytics.nn.modules.block.C3k2 [448, 128, 1, False]

21 -1 1 147712 ultralytics.nn.modules.conv.Conv [128, 128, 3, 2]

22 [-1, 10] 1 0 ultralytics.nn.modules.conv.Concat [1]

23 -1 1 378880 ultralytics.nn.modules.block.C3k2 [384, 256, 1, True]

24 [16, 19, 22] 1 1310848 ultralytics.nn.modules.head.Detect [80, [256, 448, 384]]

YOLO11_RFEM summary: 327 layers, 3,831,744 parameters, 3,831,728 gradients, 11.3 GFLOPs3.修改后的网络结构图

4. 完整代码分享

这个后期补充吧~,先按照步骤来即可

5. GFLOPs

关于GFLOPs的计算方式可以查看:百面算法工程师 | 卷积基础知识——Convolution

未改进的YOLO11n GFLOPs

改进后的GFLOPs

6. 进阶

可以与其他的注意力机制或者损失函数等结合,进一步提升检测效果

7.总结

通过以上的改进方法,我们成功提升了模型的表现。这只是一个开始,未来还有更多优化和技术深挖的空间。在这里,我想隆重向大家推荐我的专栏——《YOLO11改进有效涨点》。这个专栏专注于前沿的深度学习技术,特别是目标检测领域的最新进展,不仅包含对YOLO11的深入解析和改进策略,还会定期更新来自各大顶会(如CVPR、NeurIPS等)的论文复现和实战分享。

为什么订阅我的专栏? ——《YOLO11改进有效涨点》

-

前沿技术解读:专栏不仅限于YOLO系列的改进,还会涵盖各类主流与新兴网络的最新研究成果,帮助你紧跟技术潮流。

-

详尽的实践分享:所有内容实践性也极强。每次更新都会附带代码和具体的改进步骤,保证每位读者都能迅速上手。

-

问题互动与答疑:订阅我的专栏后,你将可以随时向我提问,获取及时的答疑。

-

实时更新,紧跟行业动态:不定期发布来自全球顶会的最新研究方向和复现实验报告,让你时刻走在技术前沿。

专栏适合人群:

-

对目标检测、YOLO系列网络有深厚兴趣的同学

-

希望在用YOLO算法写论文的同学

-

对YOLO算法感兴趣的同学等

![BUUCTF-[2019红帽杯]easyRE(Reverse逆向)](https://i-blog.csdnimg.cn/blog_migrate/07f1d38f4016697dd0de99fb33db44b9.png)