GNN

思想:近朱者赤近墨者黑

GNN的流程:

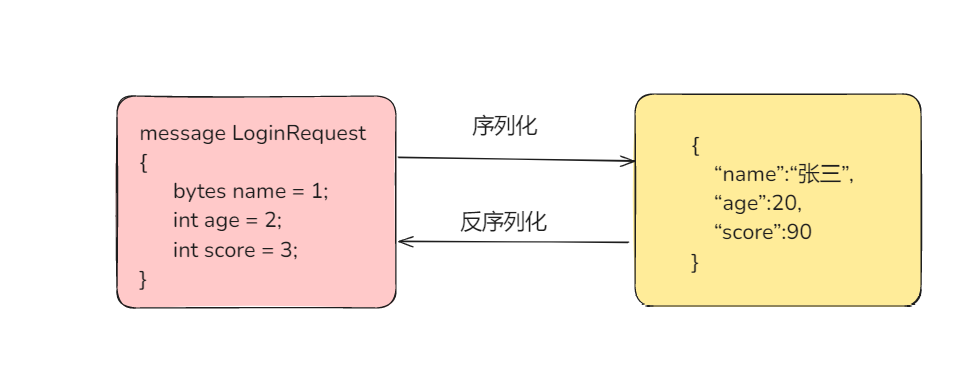

- 聚合(把邻居的信息贴到自己身上来,作为它自己特征的补足)

- 更新

- 循环(为什么要多次?看以下例子)

GNN能干嘛?

- 1.结点分类(比如判断A是哪一类);算loss后可以对前面式子中a、b、c训练优化

- 2.关联预测(比如预测A和B有没有可能有关系

GNN可以得到包含graph的结构信息

iDrug: Integration of drug repositioning and drug-target prediction via cross-network embedding

药物重定位就是老药新用的意思:一个药不止能作用一个靶点、可以作用很多靶点,并且可能一个靶点能影响很多疾病,所以一个药会有多个能治的病。找到老药能治的新的病就是药物重定位

文章出发点:

1、一般来说,drug-disease(药物-疾病)任务和drug-target(药物-蛋白)任务都是当作两个任务来进行处理的。但是因为药物怎样来治疗一个疾病通常是药物能影响某个靶点,而这个靶点能治疗某个疾病。所以这两个任务关联度很高

2、本文将这两个关联度很高的任务进行融合

3、提出一种模型iDrug,将药物重定位和靶点预测整合到一个过程中,用cross-network embedding进行建模,并且提出了一种知识转移的方法,从一个领域到另一个领域

4、iDrug的模型表现十分优秀

在这个网络结构上学习embedding,所谓学习embedding就是学习药物和疾病的表示

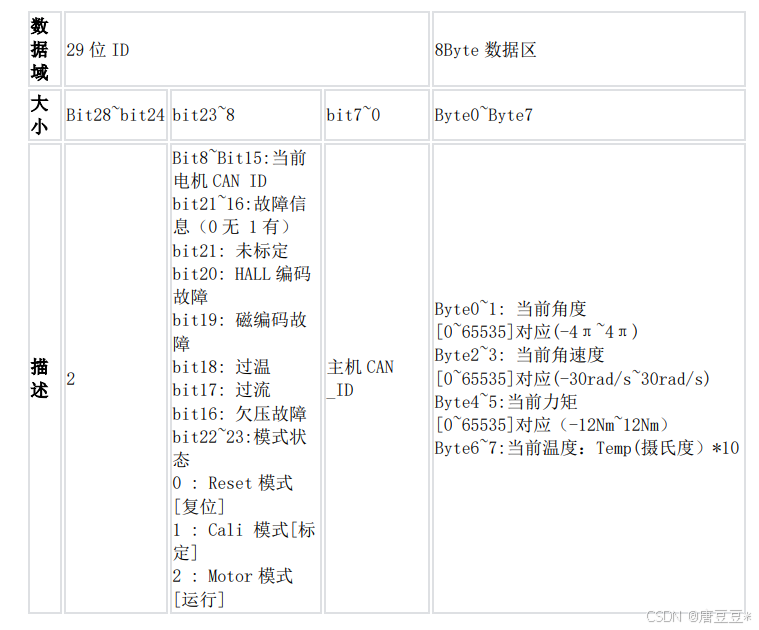

一般如果要计算药物-药物相似度,可以用SMILES或者其他。疾病-疾病相似度,可以用match?做语义相似度。这里target-target(蛋白质-蛋白质)相似度是用smith-waterman计算

虽然是跨域,首先要把域内事情处理好:

域内就是简单的矩阵分解的方法:重构X矩阵(也就是关联矩阵),让U(代表药物的特征)V(代表疾病的特征)两个矩阵相乘趋近原始的关联矩阵X,然后乘上一个权重,然后让它们的值最小。矩阵分解理解为:生成两个feature,也就是两个embedding,让它们能够重构回原来的矩阵

这个部分是拉普拉斯平滑

可以认为是一个小trick,一个小的改进,主目标还是前面那个矩阵分解。类似于正则化的一种,相当于一种补足的改进

网络间模型:

翻到前面的图,发现锚关联是没有用到的,怎么用锚关联呢?——假设此时我们在两个领域内都分别学习到了药物的特征表达。那么问题来了,这些药物有一些其实是一样的。基于的理论就是,同一种药物在两个领域内的表达(feature)应该趋近于相似

S相当于刚才那个锚连接矩阵,如果第i行第j列是1,说明领域1的第i个药物与领域2的第j个药物是一样的

U(药物表达)

S乘上U表示只管两个领域内都存在的药物,而那些两个领域内没有重合的药物不管

然后把它们做一个映射,再减去它们原本药物的表达,再让这个值最小

最后它的总loss是 领域内矩阵分解的loss+跨领域保证两个相同drug分布相近的loss+拉普拉斯平滑+正则化

以上就是它整个方法的模型,下面再说说结果

GCN

图卷积神经网络

GNN的一种特殊形式

GCN的主要变化就是在“聚合”这一步

这个过程中abc值如何设定?GCN就是来解决abc值的设定问题的

但这个方法是有问题的:

A上面加了个波浪线就是A矩阵加上了自环,也就是加上了一个单位阵

拉普拉斯对称归一化矩阵

GCN本质上就是在平均法的基础上扩增了针对每个结点的度做了一个对称归一化

知乎

-

为何要归一化?

采用加法规则时,对于度大的节点特征越来越大,而对于度小的节点却相反,这可能导致网络训练过程中梯度爆炸或者消失的问题。 -

如何归一化?

简单的归一化方法:

D ^ − 1 A ^ \hat{D}^{-1}\hat{A} D^−1A^,但是这样得到的矩阵是非对称阵

所以使用 D ^ − 1 / 2 A ^ D ^ − 1 / 2 \hat{D}^{-1/2}\hat{A}\hat{D}^{-1/2} D^−1/2A^D^−1/2

我们对 A ^ \hat{A} A^ 左乘 D ^ − 1 / 2 \hat{D}^{-1/2} D^−1/2 ,右乘 D ^ − 1 / 2 \hat{D}^{-1/2} D^−1/2,得到 D ^ − 1 / 2 A ^ D ^ − 1 / 2 \hat{D}^{-1/2}\hat{A}\hat{D}^{-1/2} D^−1/2A^D^−1/2。这样既得到了近似的归一化也保持了矩阵对称性。(左乘是行变换,右乘是列变换。)

同时我们观察一下归一化的矩阵与特征向量矩阵的乘积:

这种聚合方式实际上就是在对邻接求和取平均。

而

D

^

−

1

/

2

A

^

D

^

−

1

/

2

\hat{D}^{-1/2}\hat{A}\hat{D}^{-1/2}

D^−1/2A^D^−1/2 这种归一化方式,将不再单单地对领域节特征点取平均,它不仅考虑了节点i对度,也考虑了邻接节点j的度,当邻居节点j度数较大时,它在聚合时贡献地会更少。这也比较好理解,存在B->A<-C<-[D,E,F] 这么一个图,当使用这种归一化矩阵,在对A这个节点的特征进行更新时,B占的权重会更大,C占的权重会更小。因为B对A产生影响,与A对B产生对影响是一样的(无向图),由于B只有A这个邻居,所以A对B影响很大;同样地,C对A产生影响,与A对C产生对影响是一样的,因为C有很多节点,所以A对C节点对影响没那么大,即C对A节点对影响没那么大。

Should Graph Convolution Trust Neighbors?A Simple Causal Inference Method

GAT

前面说到 GCN 主要是做了一个归一化

之前的结点之间的重要性,都是根据 度 来做处理。GAT是让模型自动来学习A对B的重要性等

注意这里的*是点乘,也就是计算向量内积,所以分子最后计算结果是一个值

e_ij就是圈内的值,i和j就比如上面图里的A和C

多头注意力机制

就是为了确保gat更稳定

比如爱好是一个gat,经济状况又是一个gat

所谓多头比如刚才那样的gat使用3套。要优化的参数就只有W和a

这个图里每一种颜色的箭头就是一套gat,分别优化W和a

第一个公式就是单头的

多头的就是第二个公式,比如这里三种颜色因此K=3。由于三套attention最后都会生成h_i撇,竖线就是拼接起来

第三个公式就是如果直接拼接起来效果不太好,可以使用平均的方法

学习链接

视频