整理了AAAI2022 D-vlog: Multimodal Vlog Dataset for Depression Detection 论文的阅读笔记

- 背景

- 方法

- 特征提取

- 模型

- 实验

- 数据集

- 主实验

- 不同模态的性能

- 性别的影响

背景

以往关于抑郁症检测的工作大多集中在实验室环境下对抑郁症个体的检测,难以在实践中推广。本文提出了一个多模态抑郁症数据集D-Vlog,由从YouTube收集的961个vlog(即约160小时)组成,并手工标注为抑郁/非抑郁,表1展示了D-vlog与其他抑郁症检测数据集的比较。这是一个视听融合的多模态二分类任务。

方法

本文提出了一个多模态深度学习模型从收集的数据中提取的声学和视觉特征来检测抑郁症。采用交叉注意机制来有效地捕捉声音和视觉特征之间的关系,并为抑郁检测生成有用的多模态表示。

特征提取

首先将每个视频日志的音频序列分割成秒。从每个音频片段(一秒)中提取25个低电平声学描述符(LLDs)。对于每个片段的25个特征取平均值,将所有片段连接起来,得到音频向量。

对于视觉特征,使用dlib,这是一个著名的用于人脸识别和验证等计算机视觉任务的开源软件。在vlog中每帧(1 FPS)提取68个面部坐标(即x和y坐标),并通过连接每个x和y坐标获得136维向量。如果在帧中没有检测到人脸,则用零向量替换。

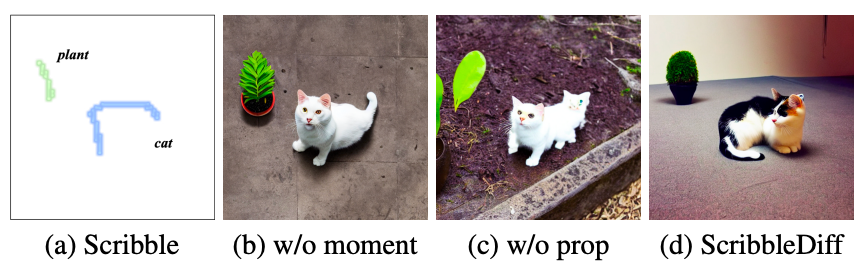

特征提取的过程如图二所示。

模型

本文提出了一个基于多模态视听融合的深度学习方法,称之为“Depression Detector”,该模型由以下组件组成:(1) 单峰变压器编码器,(2) 多峰变压器编码器,以及 (3) 检测层。如图三所示:

本文的模型实际上就是三个Transformer模块。以声学和视觉特征向量作为输入,两个单峰Transformer编码器生成单峰表示。接下来,多模态Transformer编码器整合声音和视觉单模态表示,以生成给定vlog的最终表示。通过学习多模态表示,抑郁检测层最终预测出vlog的抑郁标签。使用的损失函数就是二元交叉熵。

实验

数据集

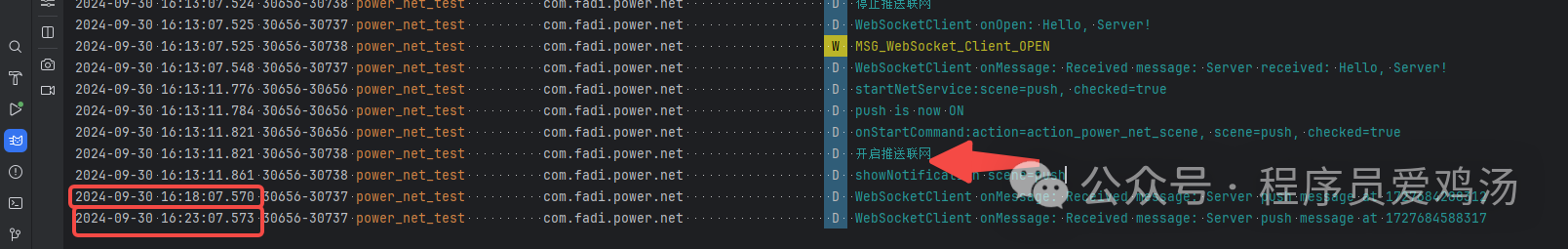

将数据集以7:1:2的比例分成训练集、验证集和测试集,数据集中还有一个性别参数,如表3所示:

主实验

本文所用的baseline都是比较简单的,不再赘述,实验结果如表4所示。

我们可以观察到,所有融合基线模型的性能都低于所提出的模型。这表明采用交叉注意的融合方法可以跨模态捕获有用的知识。与基线比较,发现BLSTM和TFN比传统的机器学习方法如LR、SVM和RF具有更高的性能。这是因为BLSTM和TFN被设计为考虑输入特征的顺序信息,而传统的机器学习模型无法学习这些信息。建议的模型达到65.57%的加权平均召回率和63.50%的加权平均f1得分。这表明所提出的两级变压器编码器和多模态融合方法可以生成捕捉抑郁说话人明显特征的表征。

不同模态的性能

为了分析每种模态(即音频和视觉)对检测抑郁症的重要性,本文对每种模态训练的单模态模型进行了性能分析。结果如表5所示,用声学特征训练的模型比用视觉特征训练的模型获得了更高的性能(加权平均f1得分的58.55%)。也就是说,在抑郁症检测中,声学特征比视觉特征更有用。

性别的影响

为了研究性别如何影响对抑郁的感知。首先用特定的性别(即男性或女性)训练和验证建议的模型。与之前的工作一致,该模型在男性非语言特征集上的抑郁检测性能高于女性集。这意味着,在视频博客中,男性抑郁者的言语和面部表情往往表现出与非抑郁男性不同的明显指标。