今天给大家介绍一个零样本主题驱动图像生成方法EZIGen,它会从你提供的主体图像中提取出重要特征,就像是给图像做一个“身份识别”,确保生成的新图像能够保留主体的独特特征。接下来,EZIGen会根据你输入的文本提示,生成一个粗略的图像布局,

比如确定图像的大致形状和颜色。然后,它会将主体的特征逐步转移到这个布局上,就像在给图像“穿衣服”,确保主体的外观与文本提示一致。这个过程是迭代进行的,意味着如果第一次生成的效果不够好,EZIGen会继续调整图像,直到达到你满意的效果。这样的设计使得生成的图像不仅保留了主体的身份,还能很好的符合你的描述。

EZIGen 通过集成精心设计的参考 UNet 提取器和解耦指导来增强零样本主题驱动生成,在保持灵活性的同时保留主题身份。

相关链接

论文地址:http://arxiv.org/abs/2409.08091v1

项目主页:https://zichengduan.github.io/pages/EZIGen

代码链接:https://github.com/ZichengDuan/EZIGen

论文阅读

EZIGen:通过精确的主题编码和解耦引导增强零样本主题驱动图像生成

摘要

零样本主体驱动图像生成旨在生成包含给定示例图像中的主体的图像。挑战在于在与文本提示对齐的同时保留主体的身份,这通常需要修改主体外观的某些方面。尽管基于扩散模型的方法取得了进步,但现有方法仍然难以平衡身份保留与文本提示对齐。在本研究中,我们对这个问题进行了深入调查,并发现了在保持强大平衡的同时实现有效身份保留的关键见解。我们的主要发现包括:

-

主体图像编码器的设计显著影响身份保留质量

-

生成初始布局对于文本对齐和身份保留都至关重要。

基于这些见解,我们引入了一种名为 EZIGen 的新方法,它采用了两种主要策略:基于预训练稳定扩散模型的 UNet 架构精心设计的主题图像编码器,以确保高质量的身份转移,遵循分离指导阶段并迭代细化初始图像布局的过程。通过这些策略,EZIGen 使用统一模型和少 100 倍的训练数据在多个主题驱动的基准上取得了最先进的结果。

方法

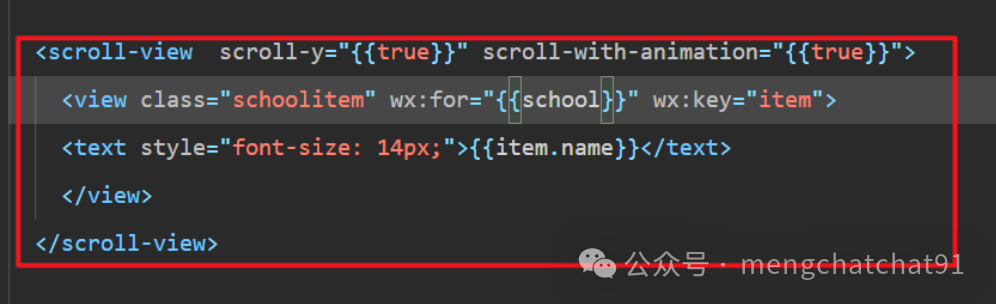

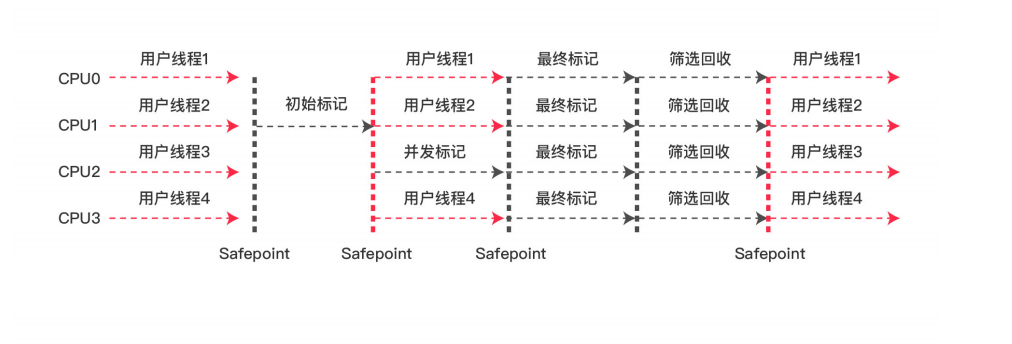

EZIGen说明。 从编码和注入主体特征开始,我们使用固定的参考 UNet 在给定噪声主体图像的模拟后期去噪过程中提取一组中间潜在特征,然后我们将这些特征视为离线主体指导并通过可学习适配器将其注入到主 UNet。然后我们展示如何将生成过程解耦为布局生成过程和外观传输过程。我们首先利用文本提示作为文本指导,使用原始文本引导的扩散过程来获得中间时间步t的布局潜在,然后我们结合离线主体指导将主体外观转移到其余时间步的布局潜在中。最后,为了实现完整的转移,我们开发了迭代外观传输机制,通过向生成的图像添加噪声来重复外观传输过程,并继续重复N次直到满意为止。

解耦操作的详细说明。第 1 行表示纯文本指导下的原始稳定扩散生成过程。第 2 行表示在每一步中除了文本指导外还添加了主题指导。第 3 行表示解耦操作,其中我们仅在后期生成步骤中添加主题指导。第 4 行显示迭代生成设计,其中采用第 3 行的不完整结果,并在主题指导下反复添加噪声和去噪,直到主题身份完全转移。

实验

DreamBench 数据集上的结果

EZIGen展示了令人惊叹的主题身份保存能力,同时又不牺牲文本提示的依从性,超越了所有以前的竞争对手。

DreamEdit 数据集上的结果

EZIGen方法配备前景/背景蒙版和图像反转时,它自然是一个主题驱动的编辑器,并且它在 DreamEditBench 数据集上表现出色。

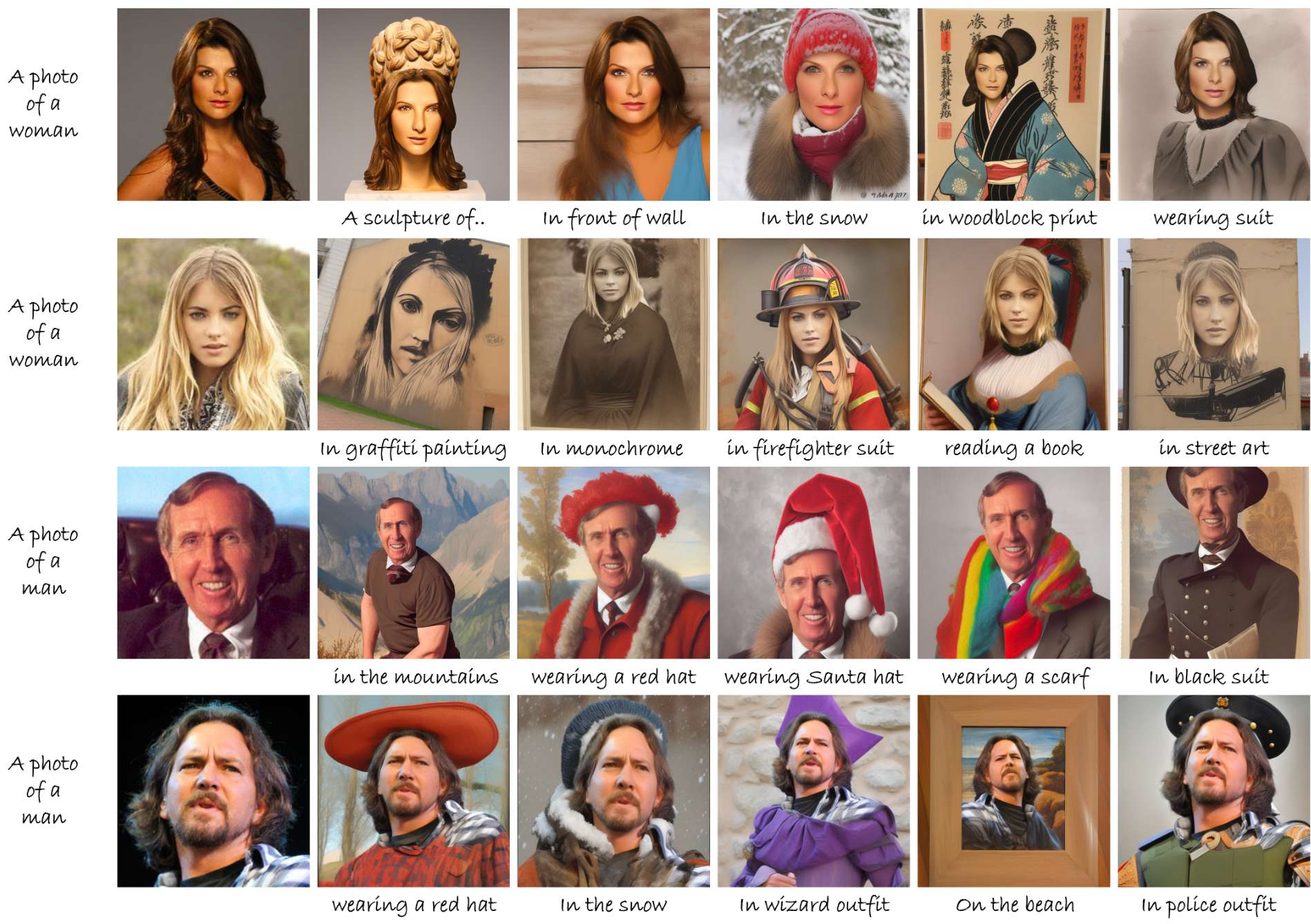

FastComposer 基准测试的结果

由于高质量的特征提取和解耦生成技术,EZIGen方法可以生成具有多功能性的高质量人脸图像,而无需在特定领域或大规模数据集上进行训练。

主题插值

根据迭代生成的性质,EZIGen方法在主题驱动的编辑期间使用图像时自动进行插值。

主题驱动的生成

主题驱动编辑

人类内容生成

结论

本文介绍了EZIGen,这是一种用于零样本主体驱动图像生成的新型框架。通过采用来自稳定扩散模型的精心设计的参考 UNet,我们的方法在主体特征提取方面表现出色,从而实现了卓越的主体身份保存。然后,通过明确分离文本和主体指导并提出迭代外观转移过程,我们展示了我们的方法如何平衡身份保存与文本提示连贯性,超越了以前方法的局限性,这些方法通常难以实现这种平衡。通过在多个基准测试和内部模型分析上进行大量实验,我们的模型证明了它能够作为主体驱动图像生成任务的强大且多功能的解决方案。