通过多因素聚类的半监督小样本学习

引用:Ling J, Liao L, Yang M, et al. Semi-supervised few-shot learning via multi-factor clustering[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2022: 14564-14573.

论文地址:下载地址

论文代码:https://gitlab.com/smartllvlab/cluster-fsl

Abstract

标记数据的稀缺性和模型过拟合问题一直是小样本学习中的挑战。最近,半监督小样本学习被提出,以获取未标记样本的伪标签来扩展支持集。然而,在生成伪标签的过程中,未标记数据与标记数据之间的关系并未得到充分利用,这些伪标签中的噪声会直接损害模型的学习效果。为了解决图像分类中的上述问题,本文提出了一种基于聚类的半监督小样本学习方法(cluster-FSL)。通过使用多因素协同表示,我们设计了一种新颖的多因素聚类(MFC)方法,用于融合小样本数据分布的信息,可以基于标记数据为未标记样本生成软和硬伪标签。我们利用 MFC 为未标记样本生成的伪标签来扩展支持集,以获取更多的分布信息。此外,在微调阶段对支持集进行鲁棒的数据增强,以增加标记样本的多样性。我们通过在三个流行的基准数据集 miniImageNet、tieredImageNet 和 CUB-200-2011 上与其他小样本学习方法进行比较,验证了 cluster-FSL 的有效性。消融实验进一步表明,我们的 MFC 可以有效融合标记样本的分布信息,并提供高质量的伪标签。我们的代码可在以下链接获取:https://gitlab.com/smartllvlab/cluster-fsl

1. Introduction

基于神经网络的深度学习方法1在计算机视觉领域取得了巨大突破并得到了广泛应用234。然而,深度学习模型需要大量的标记数据来学习大规模的参数。此外,现实生活中的场景复杂多样。例如,在一些实际问题中,存在一些很少被观测到的对象,如嫌疑人的面部、稀有动物的照片等,这使得标记数据的收集变得困难。受人类视觉系统的启发,小样本学习5678的发展受到广泛关注,它在一定程度上缓解了深度模型对训练数据的强烈需求。

小样本学习的目标是基于经验,从极少量的样本中学习新的概念或行为。由于小样本学习的特殊性,如何缓解由于样本稀缺而导致的模型难以拟合类别分布的过拟合问题,一直是小样本学习的重点和难点。随着小样本学习的发展,已有从模型、数据和学习算法三个方面来解决上述问题的方法。基于模型的方法910旨在通过设计适应小样本情况的模型来学习样本之间的交互信息。在数据方面,研究人员探索了各种丰富训练数据的方法,如数据增强91112,通过翻转、裁剪、平移、旋转和缩放对数据进行预处理。然而,数据增强需要昂贵的人工成本,并且严重依赖领域知识,导致某些数据增强方法对特定数据集具有局限性。基于学习方法的小样本图像分类13146旨在通过元学习或迁移学习策略,利用不同子任务中共享的元知识或可迁移知识来提高模型的泛化能力。然而,由于小样本标记数据无法为近期模型学习提供丰富且关键的信息,小样本学习的性能仍然不尽如人意。

当任务包含少量标记样本以及针对新类别的额外未标记数据时,一种直接的方法是利用未标记样本来缓解标记样本的稀缺性。半监督学习方法已经有效地探索了未标记数据,包括弱数据增强与强数据增强的结合15、一致性正则化16、对抗扰动正则化17等,在不使用大量标注样本的情况下实现了非常令人兴奋的性能表现。如果将半监督学习与小样本学习相结合(例如,挖掘未标记样本的伪标签),那么数据稀缺等问题在一定程度上是可以解决的。最近的一些结合半监督学习的小样本图像分类研究18196主要关注于提高未标记样本伪标签预测的准确性,并期望获得更多正确的伪标签以扩展训练集。然而,现有方法难以获得完全正确的伪标签,如何避免错误伪标签对模型训练的影响以及如何利用样本分布信息来辅助伪标签的获取仍然是当前的挑战。

为了解决上述问题,本文提出了一种基于聚类的半监督小样本学习(cluster-FSL)方法用于图像分类。通过引入标记样本作为聚类的因素,并利用多因素字典表示未标记数据,我们提出了多因素聚类(MFC)来指导未标记样本伪标签的获取,该方法结合了标记和未标记样本的分布信息以辅助聚类,从而获得更准确的伪标签。在微调阶段,我们设计了鲁棒的数据增强来增强支持集,并采用 MFC 模块来预测查询样本的软标签,从而学习更具判别性的特征分布。在测试阶段,我们使用 MFC 替代标签传播来为未标记样本分配更准确的伪标签,以扩展测试支持集。实验结果表明,cluster-FSL 在 miniImageNet、tiered-ImageNet 和 CUB-200-2011 上取得了最先进的性能(例如,当骨干网络为 ResNet-12 时,在 miniImageNet 的 5-way 1-shot 场景中提升了 2.45%)。

我们的主要贡献可总结如下:1. 我们提出了一种新颖的多因素聚类(MFC)算法,它包含了标记和未标记样本的因素,并通过多因素字典利用这些因素之间的分布信息,从而生成更准确的聚类结果。2. 我们将所提出的 MFC 以一种新颖的方式集成到微调阶段和测试阶段,有效地输出高质量的伪标签来扩展查询和测试支持集。

2. Related Works

2.1 基于学习的小样本图像分类

基于学习的小样本图像分类算法旨在设计一种适用于小样本场景的训练和更新模式。迁移学习和元学习方法最近被成功应用于小样本分类。

基于迁移学习的方法在大量来自基础类别的数据上对模型进行预训练,并将预训练模型适应于识别新类别的小样本学习任务。Kozerawski 等人14学习了一种将预训练模型提取的嵌入特征映射到分类决策边界的迁移函数。在文献13中,Yoo 等人识别了深度网络中每一层具有相似激活模式的神经元组,然后通过逐组反向传播使用训练集进行微调。基于迁移学习的方法可以训练出具有强大表示能力的特征提取器。为了充分利用这些方法,我们借助所提出的 MFC 微调预训练模型以提高我们方法的性能。

基于元学习的方法,也称为“学习如何学习”,旨在学习一种范式,可以通过使用小样本训练样本来识别新类别20。研究人员从以下几个方面改进了基于元学习的方法:嵌入模块和共享距离度量方法212210,模型参数的初始分布2324,以及模型参数的更新策略和规则2526。作为一种经典且常用的解决小样本分类任务的有效方法,尽管这些方法取得了快速发展,但样本稀缺的问题仍然是一个挑战。

最近,Rodríguez 等人27提出使用嵌入传播(Embedding Propagation, EP)作为流形平滑的无监督非参数正则化方法,并将 EP 应用于一种传导式分类器。然而,该方法在标记样本的扩展方面存在局限性,阻碍了性能的进一步提升。为了解决 EPNet28 的问题,我们使用所提出的 MFC 模块来获取未标记样本的伪标签,这可以有效地缓解标记样本的稀缺问题。

2.2 基于伪标签获取的半监督小样本方法

将小样本图像分类方法与半监督学习相结合,通过获取未标记数据的伪标签来扩展标记数据,并缓解样本稀缺的问题。例如,在文献18中,通过在未标记样本的分布中引入类原型来预测伪标签;在文献19中,使用标签传播来获取伪标签;在文献20中,使用预训练的分类器来预测伪标签;在文献29中,利用标记和未标记数据分布的流形结构来预测伪标签。在获得伪标签后,这些方法直接将其作为标记样本用于模型的微调和训练。然而,这些方法忽略了错误的伪标签对模型训练的影响。

为了减少错误伪标签的影响,Wu 等人30设定了优先级来选择具有信息性的未标记样本,以用于随后的训练过程;而 Sun 等人31提出在每轮优化中限制选择的未标记样本数量,并优先选择高置信度的伪标记样本。Huang 等人32提出了一种伪损失置信度度量(Pseudo-Loss Confidence Metric,PLCM),该方法将不同任务的伪标记数据映射到统一的度量空间,并根据其伪损失的分布成分置信度来估计伪标记的置信度。然而,利用训练好的分类器逐个独立预测未标记样本的方法忽略了数据分布层面的信息。未标记样本的类内和类间关系以及未标记样本与标记样本的分布信息对伪标签获取的影响没有被考虑。

最近,Huang 等人提出了一种基于迁移学习的半监督小样本方法——泊松传递网络(Poisson Transfer Network, PTN)33。PTN 模型改进了基于图的小样本学习中挖掘标记和未标记数据之间关系的能力,我们的 cluster-FSL 同样致力于增强这种能力。然而,我们提出的 MFC 利用多个因素来构建特征字典,从而使整体聚类有效地加强标记和未标记数据之间的关系,使聚类更加简洁和可解释。Wang 等人34提出模型根据实例可信度推理(Instance Credibility Inference, ICI)来测量的可信度迭代选择伪标签实例以进行分类器训练。然而,如果不直接提高伪标签的质量,那么错误伪标签对模型的影响无法减少。此外,ICI 通过增加附带参数的稀疏性来解决线性回归假设,并根据稀疏度对伪标签实例进行排序,而我们的 MFC 通过融合标记数据的分布来构建字典,并在聚类时使用重构误差来计算距离。

3. 基于聚类的半监督小样本学习

获取高置信度的未标记样本伪标签是半监督小样本学习模型需要解决的一个主要挑战。为有效解决上述挑战,我们提出了一种新颖的基于聚类的半监督小样本学习模型(cluster-FSL),该模型通过多因素聚类来获取未标记数据的高质量伪标签。此外,我们提出的 cluster-FSL 利用鲁棒的数据增强和 MFC 模块来学习更具判别性的特征,以提高性能。在这里,我们首先介绍多因素聚类,然后详细介绍 cluster-FSL 的三个阶段(例如,预训练、微调和测试)。

3.1. Problem Definition

在小样本分类任务中,数据集被划分为训练集、验证集和测试集,即

D

=

{

D

train

,

D

val

,

D

test

}

D = \{D_{\text{train}}, D_{\text{val}}, D_{\text{test}}\}

D={Dtrain,Dval,Dtest}。其中

D

train

=

{

X

train

,

Y

train

}

D_{\text{train}} = \{X_{\text{train}}, Y_{\text{train}}\}

Dtrain={Xtrain,Ytrain} 包含所有训练数据及其对应的标签,

D

test

=

{

X

test

,

Y

test

}

D_{\text{test}} = \{X_{\text{test}}, Y_{\text{test}}\}

Dtest={Xtest,Ytest} 包含所有测试数据及其对应的标签。训练集和测试集中的所有类别分别用

C

train

C_{\text{train}}

Ctrain 和

C

test

C_{\text{test}}

Ctest 表示,且

C

train

∩

C

test

=

∅

C_{\text{train}} \cap C_{\text{test}} = \emptyset

Ctrain∩Ctest=∅。验证集中的类别与

C

train

C_{\text{train}}

Ctrain 和

C

test

C_{\text{test}}

Ctest 均不重叠。

参考情景学习,我们构建了

n

n

n 个独立的小样本任务以形成序列集合

Γ

=

{

T

train

i

,

T

test

i

}

i

=

1

n

\Gamma = \{T_{\text{train}}^i, T_{\text{test}}^i\}_{i=1}^n

Γ={Ttraini,Ttesti}i=1n。对于每个训练任务

T

train

i

T_{\text{train}}^i

Ttraini,我们从训练集中随机选择

N

N

N 个类别,并从每个类别中随机选择

K

K

K 个样本来组成训练支持集

S

train

=

{

x

s

i

,

y

s

i

}

i

=

1

N

×

K

S_{\text{train}} = \{x_{\text{s}}^i, y_{\text{s}}^i\}_{i=1}^{N \times K}

Strain={xsi,ysi}i=1N×K,其中

x

s

i

∈

X

train

x_{\text{s}}^i \in X_{\text{train}}

xsi∈Xtrain,

y

s

i

∈

Y

train

y_{\text{s}}^i \in Y_{\text{train}}

ysi∈Ytrain。从相同的

N

N

N 个类别中,我们选择

q

q

q 个不重复的样本来组成训练查询集

Q

train

=

{

x

q

i

,

y

q

i

}

i

=

1

N

×

q

Q_{\text{train}} = \{x_{\text{q}}^i, y_{\text{q}}^i\}_{i=1}^{N \times q}

Qtrain={xqi,yqi}i=1N×q,其中

x

q

i

∈

X

train

x_{\text{q}}^i \in X_{\text{train}}

xqi∈Xtrain,

y

q

i

∈

Y

train

y_{\text{q}}^i \in Y_{\text{train}}

yqi∈Ytrain。验证集

D

val

D_{\text{val}}

Dval 用于确定最佳模型,在验证集上取得最高准确率的模型将被选中。

对于每个测试任务

T

test

i

T_{\text{test}}^i

Ttesti,模型也从测试集中随机选择

N

N

N 个类别,并从每个类别中随机选择

K

K

K 个样本来组成测试支持集

S

test

=

{

x

s

j

,

y

s

j

}

j

=

1

N

×

K

S_{\text{test}} = \{x_{\text{s}}^j, y_{\text{s}}^j\}_{j=1}^{N \times K}

Stest={xsj,ysj}j=1N×K,并从每个类别中选择

q

q

q 个不重复的样本来组成测试查询集

Q

test

=

{

x

q

j

,

y

q

j

}

j

=

1

N

×

q

Q_{\text{test}} = \{x_{\text{q}}^j, y_{\text{q}}^j\}_{j=1}^{N \times q}

Qtest={xqj,yqj}j=1N×q。此外,我们从测试集中未被选择的

N

N

N 个类别中随机选择

u

u

u 个样本,并去除其标签以组成未标记集

U

test

=

{

x

u

j

}

j

=

1

N

×

u

U_{\text{test}} = \{x_{\text{u}}^j\}_{j=1}^{N \times u}

Utest={xuj}j=1N×u。

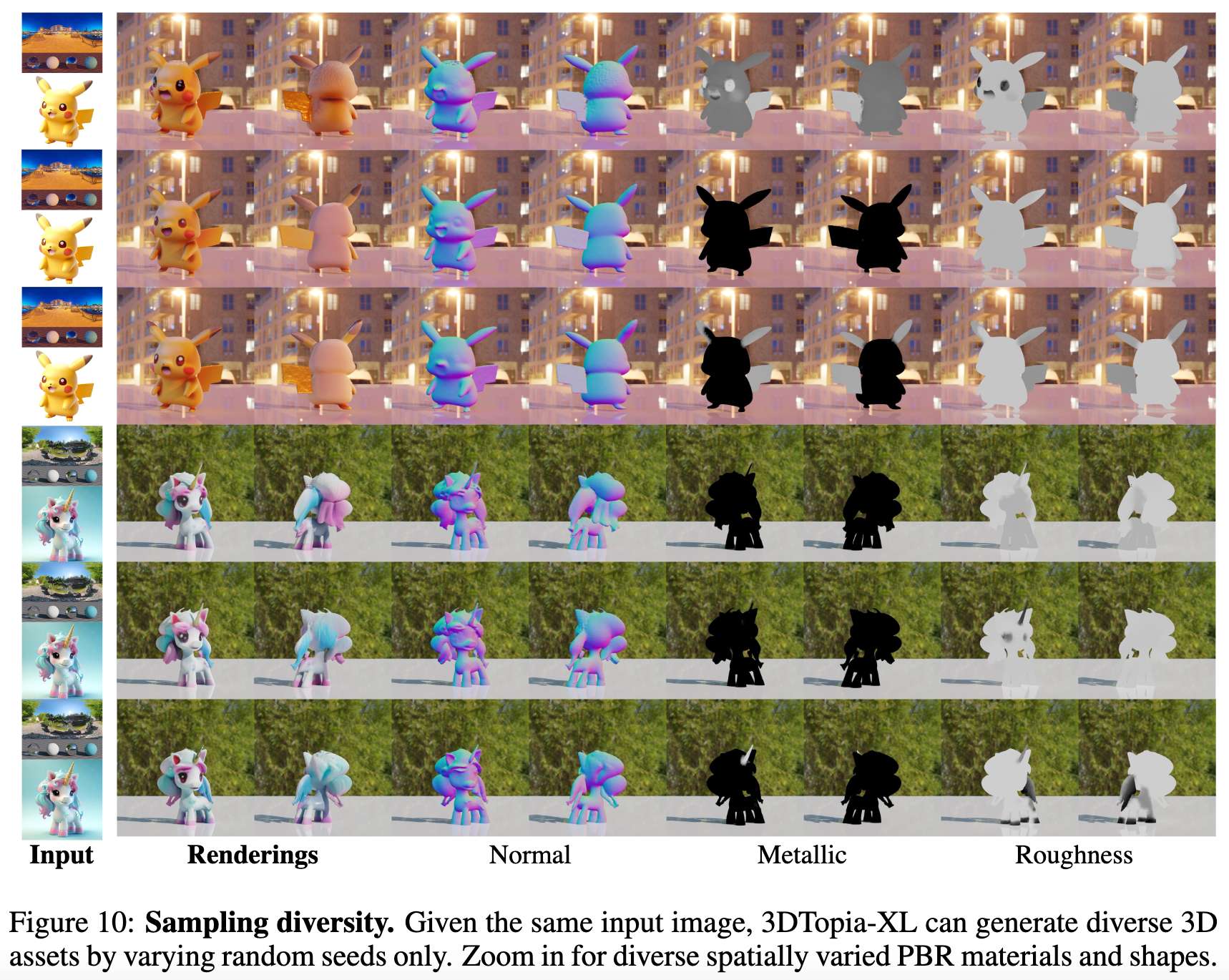

3.2 多因素聚类

给定一个标记集 L L L 和一个未标记集 U U U,我们提出了一种称为多因素聚类(MFC)的聚类方法,通过利用样本与多个因素(例如聚类中心和标记样本)之间的距离来预测 U U U 中样本的伪标签。通过利用多因素来构建特征字典并使用重构误差作为距离度量,我们的 MFC 适用于小样本场景,从而获得未标记样本的伪标签。

伪标签获取 在小样本学习任务中,标记样本数量很少,并且类别数量是已知的。在

N

N

N-way

K

K

K-shot 设置下,MFC 中的聚类表示为

C

=

{

C

i

}

i

=

1

N

C = \{C_i\}_{i=1}^N

C={Ci}i=1N,其中

N

N

N 是聚类的数量。每个聚类的中心通过标记样本的类内平均值初始化:

c

i

∗

=

1

K

∑

j

=

1

K

l

i

j

(1)

c_i^* = \frac{1}{K} \sum_{j=1}^K l_i^j \tag{1}

ci∗=K1j=1∑Klij(1)

其中,

l

i

j

∈

L

l_i^j \in L

lij∈L 是第

i

i

i 个类别标记样本的第

j

j

j 个嵌入表示,

c

i

∗

c_i^*

ci∗ 表示第

i

i

i 个聚类的中心。

传统的聚类方法18只考虑未标记样本与每个聚类中心之间的距离,而忽略了数据分布信息以及同类别的 K K K 个标记样本的特征信息。我们将聚类的因素视为可以表示聚类的嵌入表示(例如聚类中心和标记样本),并提出多因素聚类(MFC),它为每个聚类设置了多个因素,并改进了计算未标记样本到每个聚类的距离的方法。

MFC 中第 i i i 个聚类的因素 F F F 定义为 F i = [ l i 1 , ⋯ , l i K , c i ∗ ] F_i = [l_i^1, \cdots, l_i^K, c_i^*] Fi=[li1,⋯,liK,ci∗],包含了一个聚类中心以及标记集中属于第 i i i 个聚类的样本。

为了解决小样本问题,所提出的 MFC 采用所有类别特定的因素作为字典,以协同表示未标记样本

u

i

∈

U

u_i \in U

ui∈U:

β

~

i

=

arg

min

β

i

∥

u

i

−

F

β

i

∥

2

2

+

ϵ

∥

β

i

∥

2

2

(2)

\tilde{\beta}_i = \arg \min_{\beta_i} \| u_i - F \beta_i \|_2^2 + \epsilon \| \beta_i \|_2^2 \tag{2}

β~i=argβimin∥ui−Fβi∥22+ϵ∥βi∥22(2)

其中,

ϵ

\epsilon

ϵ 是常数 0.01 用于正则化表示,

β

~

i

=

[

β

~

i

,

1

,

β

~

i

,

2

,

⋯

,

β

~

i

,

N

]

T

\tilde{\beta}_i = [\tilde{\beta}_{i,1}, \tilde{\beta}_{i,2}, \cdots, \tilde{\beta}_{i,N}]^T

β~i=[β~i,1,β~i,2,⋯,β~i,N]T,

β

~

i

,

j

∈

R

(

K

+

1

)

×

1

\tilde{\beta}_{i,j} \in \mathbb{R}^{(K+1) \times 1}

β~i,j∈R(K+1)×1 是与第

j

j

j 个聚类相关的子系数向量。我们参考了协同表示中的求解方法35来解决公式 (2) 中的

β

~

i

\tilde{\beta}_i

β~i。然后,我们将与每个聚类相关的重构误差作为未标记样本到聚类的距离,如图 1 所示。重构误差定义为:

d

i

,

j

=

∥

u

i

−

F

j

β

~

i

,

j

∥

2

2

(3)

d_{i,j} = \| u_i - F_j \tilde{\beta}_{i,j} \|_2^2 \tag{3}

di,j=∥ui−Fjβ~i,j∥22(3)

计算这个重构误差考虑了所有类别的因素,使得不同聚类的因素能够竞争性地表示未标记数据,输出更稳健的聚类。

图1 MFC 的聚类过程。其中,黑色点表示更新后的聚类中心,灰黑色点表示更新前的聚类中心。

根据未标记数据

u

i

u_i

ui 到每个聚类的最小重构误差,聚类结果表示为:

α

i

=

arg

min

1

≤

j

≤

N

d

i

,

j

\alpha_i = \arg \min_{1 \leq j \leq N} d_{i,j}

αi=argmin1≤j≤Ndi,j每个聚类更新为:

C

~

α

i

=

C

α

i

∪

{

u

i

}

,

c

j

∗

=

1

∣

C

~

j

∣

∑

z

k

∈

C

~

j

z

k

∀

j

=

1

,

2

,

⋯

,

N

(4)

\tilde{C}_{\alpha_i} = C_{\alpha_i} \cup \{u_i\}, \quad c_j^* = \frac{1}{|\tilde{C}_j|} \sum_{z_k \in \tilde{C}_j} z_k \quad \forall j = 1, 2, \cdots, N \tag{4}

C~αi=Cαi∪{ui},cj∗=∣C~j∣1zk∈C~j∑zk∀j=1,2,⋯,N(4)

其中,

c

j

∗

c_j^*

cj∗ 是第

j

j

j 个聚类中心,用于更新聚类因素。

相较于仅使用一个因素,多因素可以使聚类更准确,因为它们可以更好地表示聚类的嵌入流形。经过多次迭代,当聚类和聚类中心不再变化时,聚类表示为

C

=

{

C

1

,

C

2

,

⋯

,

C

N

}

C = \{C_1, C_2, \cdots, C_N\}

C={C1,C2,⋯,CN}。我们采用最后一次迭代的聚类结果来为未标记数据获得软标签和硬标签。未标记样本

u

i

u_i

ui 的软标签

p

i

=

[

p

i

,

1

,

p

i

,

2

,

⋯

,

p

i

,

N

]

p_i = [p_{i,1}, p_{i,2}, \cdots, p_{i,N}]

pi=[pi,1,pi,2,⋯,pi,N] 定义为:

p

i

,

j

=

e

−

log

(

d

i

,

j

/

τ

)

∑

k

=

1

N

e

−

log

(

d

i

,

k

/

τ

)

(5)

p_{i,j} = \frac{e^{-\log(d_{i,j} / \tau)}}{\sum_{k=1}^N e^{-\log(d_{i,k} / \tau)}} \tag{5}

pi,j=∑k=1Ne−log(di,k/τ)e−log(di,j/τ)(5)

其中,

τ

\tau

τ 是温度参数,

p

i

,

j

p_{i,j}

pi,j 表示未标记样本

u

i

u_i

ui 被预测为第

j

j

j 类的概率。因此,硬标签为:

y

~

i

=

arg

max

j

p

i

,

j

\tilde{y}_i = \arg \max_j p_{i,j}

y~i=argmaxjpi,jMFC 的详细步骤在算法 1 中显示。

| 算法1 多因素聚类过程描述 |

|---|

| 输入: 标记集 L = { l i , y i } i = 1 N × K L = \{l_i, y_i\}_{i=1}^{N \times K} L={li,yi}i=1N×K,未标记集 U = { u i } i = 1 N × u U = \{u_i\}_{i=1}^{N \times u} U={ui}i=1N×u |

| 输出: 未标记集 P = { p i , y ~ i } i = 1 N × u P = \{p_i, \tilde{y}_i\}_{i=1}^{N \times u} P={pi,y~i}i=1N×u 中样本的伪标签 |

| 1:while True do |

| 2: for 每个未标记样本 u i ∈ U u_i \in U ui∈U do |

| 3: 使用公式 (3) 计算重构误差 d i , j d_{i,j} di,j |

| 4: 获得聚类结果 α i = arg min 1 ≤ j ≤ N d i , j \alpha_i = \arg \min_{1 \leq j \leq N} d_{i,j} αi=argmin1≤j≤Ndi,j |

| 5: 使用公式 (4) 更新聚类和聚类中心 |

| 6: end for |

| 7: if 聚类中心保持不变 then |

| 8: 使用公式 (5) 计算软伪标签 p i p_i pi 和硬伪标签 y ~ i \tilde{y}_i y~i |

| 9: Break |

| 10: end if |

| 11:end while |

3.3 训练过程

为了训练一个具有良好泛化能力的模型,我们首先使用 D train D_{\text{train}} Dtrain 通过全监督学习和自监督学习来训练一个预训练模型。然后,我们使用序列集 Γ \Gamma Γ 通过多因素聚类和标签传播36来微调预训练模型。

3.3.1 预训练阶段

我们使用交叉熵损失将模型的分类预测与真实标签进行拟合。对于自监督学习,我们在模型中添加了另一个预测图像旋转的分类器,该方法与文献 [33] 中相同。在这种情况下,预训练模型可以从图像中提取出用于小样本任务的具有代表性的嵌入。

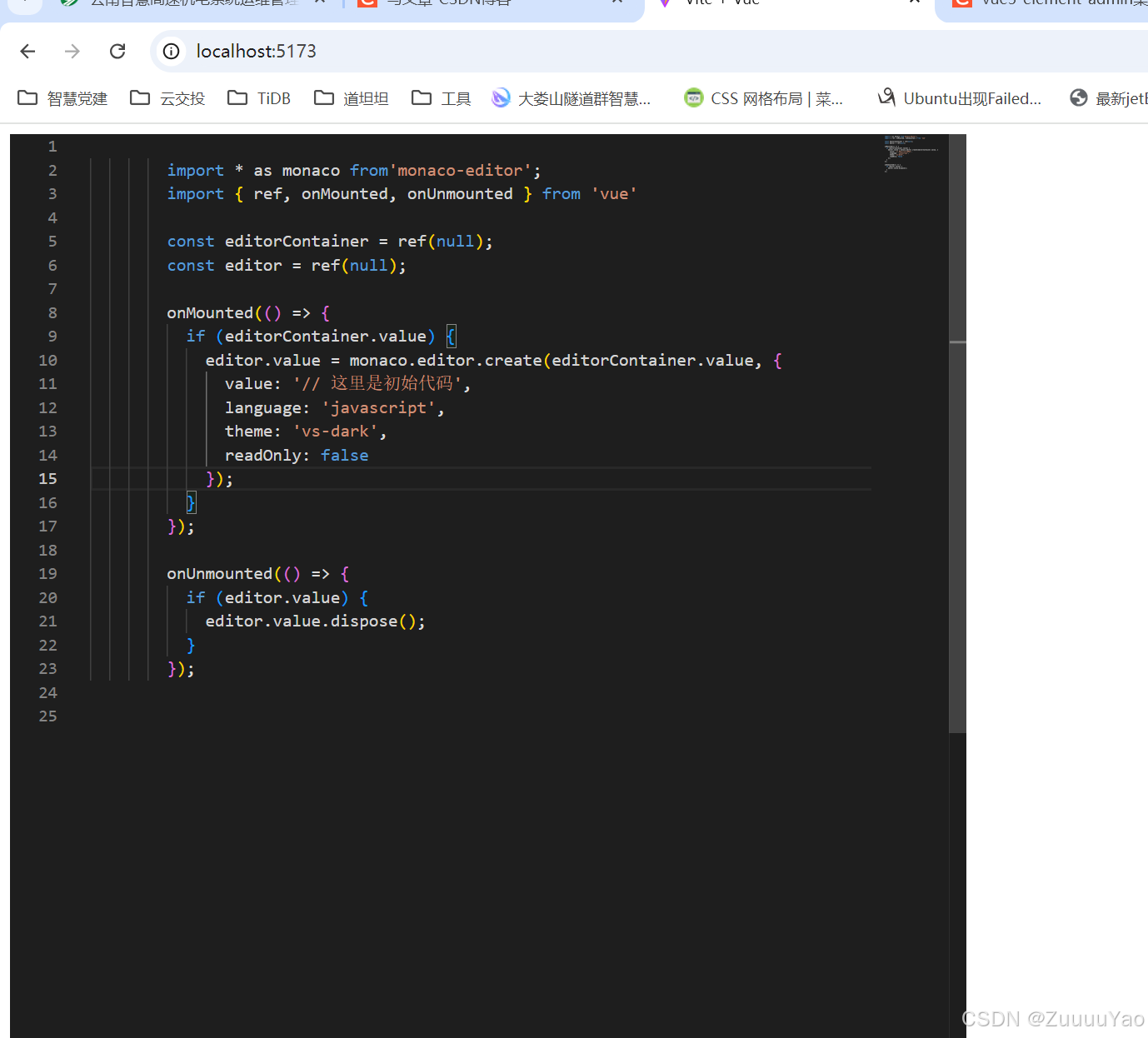

图2 微调阶段的框架。首先,我们使用更鲁棒的数据增强来增强支持集。增强后的支持集和查询集的样本经过特征提取和嵌入传播,以获得特征

z

~

\tilde{z}

z~。然后基于支持集,MFC 模块和标签传播模块获取查询集样本的软标签。

3.3.2 使用数据增强和 MFC 进行微调

在此阶段,如图 2 所示,我们引入了用于支持集的数据增强以及基于 MFC 的交叉熵损失,以学习一个具有良好泛化能力且能够提取强大嵌入的编码器。我们保留预训练模型的编码器并舍弃其分类器,通过序列学习对编码器进行微调。对于一个训练任务

T

i

T_i

Ti,它包含支持集

S

train

S_{\text{train}}

Strain 和查询集

Q

train

Q_{\text{train}}

Qtrain。我们对支持集使用 Randaugment [3] 以避免过拟合。由于在小样本学习中支持集的规模太小,模型容易对少量数据过拟合。然而,Randaugment 可以显著改变图像,从而增加模型拟合数据分布的难度。增强后的支持集表示为

ag

(

S

train

)

=

{

ag

(

x

s

i

)

,

y

s

i

}

i

=

1

N

×

K

\text{ag}(S_{\text{train}}) = \{\text{ag}(x_{\text{s}}^i), y_{\text{s}}^i\}_{i=1}^{N \times K}

ag(Strain)={ag(xsi),ysi}i=1N×K。在模型提取增强后的支持集和查询集的所有样本的嵌入后,我们使用嵌入传播 [33] 来处理这些特征:

z

~

i

=

ep

(

z

i

,

Z

)

(6)

\tilde{z}_i = \text{ep}(z_i, Z) \tag{6}

z~i=ep(zi,Z)(6)

其中

Z

=

{

z

1

,

z

2

,

⋯

,

z

N

×

(

K

+

q

)

}

Z = \{z_1, z_2, \cdots, z_{N \times (K+q)}\}

Z={z1,z2,⋯,zN×(K+q)} 表示来自

ag

(

S

train

)

\text{ag}(S_{\text{train}})

ag(Strain) 和

Q

train

Q_{\text{train}}

Qtrain 图像的嵌入集合。

ep

(

⋅

,

⋅

)

\text{ep}(\cdot, \cdot)

ep(⋅,⋅) 是嵌入传播,可以通过嵌入之间的欧氏距离来增加嵌入流形的平滑性。

我们分别基于多因素聚类和标签传播 [12] 构建了两个交叉熵损失:

l

ft

=

λ

l

MFC

+

(

1

−

λ

)

l

LP

(7)

l_{\text{ft}} = \lambda l_{\text{MFC}} + (1 - \lambda) l_{\text{LP}} \tag{7}

lft=λlMFC+(1−λ)lLP(7)

其中,

λ

\lambda

λ 是超参数,

l

MFC

l_{\text{MFC}}

lMFC 是基于多因素聚类的交叉熵损失,

l

LP

l_{\text{LP}}

lLP 是基于标签传播的交叉熵损失。

对于多因素聚类,

ag

(

S

train

)

\text{ag}(S_{\text{train}})

ag(Strain) 可以被视为一个训练任务

T

i

T_i

Ti 中的标记集,而

Q

train

Q_{\text{train}}

Qtrain 可以被视为未标记集。我们可以通过 MFC 获得训练查询样本的软伪标签,然后使用真实标签来计算交叉熵损失:

l

MFC

=

−

1

q

∑

i

=

1

q

log

p

i

,

y

q

i

(8)

l_{\text{MFC}} = -\frac{1}{q} \sum_{i=1}^q \log p_{i, y_{\text{q}}^i} \tag{8}

lMFC=−q1i=1∑qlogpi,yqi(8)

其中

p

i

,

y

q

i

p_{i, y_{\text{q}}^i}

pi,yqi 表示第

i

i

i 个查询样本在 MFC 中被预测为

y

q

i

y_{\text{q}}^i

yqi 类别的概率。概率

p

i

,

j

p_{i,j}

pi,j 定义在公式 (5) 中。

类似地,基于标签传播的交叉熵损失定义为:

l

LP

=

−

1

q

∑

i

=

1

q

log

p

~

i

,

y

q

i

(9)

l_{\text{LP}} = -\frac{1}{q} \sum_{i=1}^q \log \tilde{p}_{i, y_{\text{q}}^i} \tag{9}

lLP=−q1i=1∑qlogp~i,yqi(9)

其中

p

~

i

,

y

q

i

\tilde{p}_{i, y_{\text{q}}^i}

p~i,yqi 是通过标签传播 [12] 获得的预测概率。

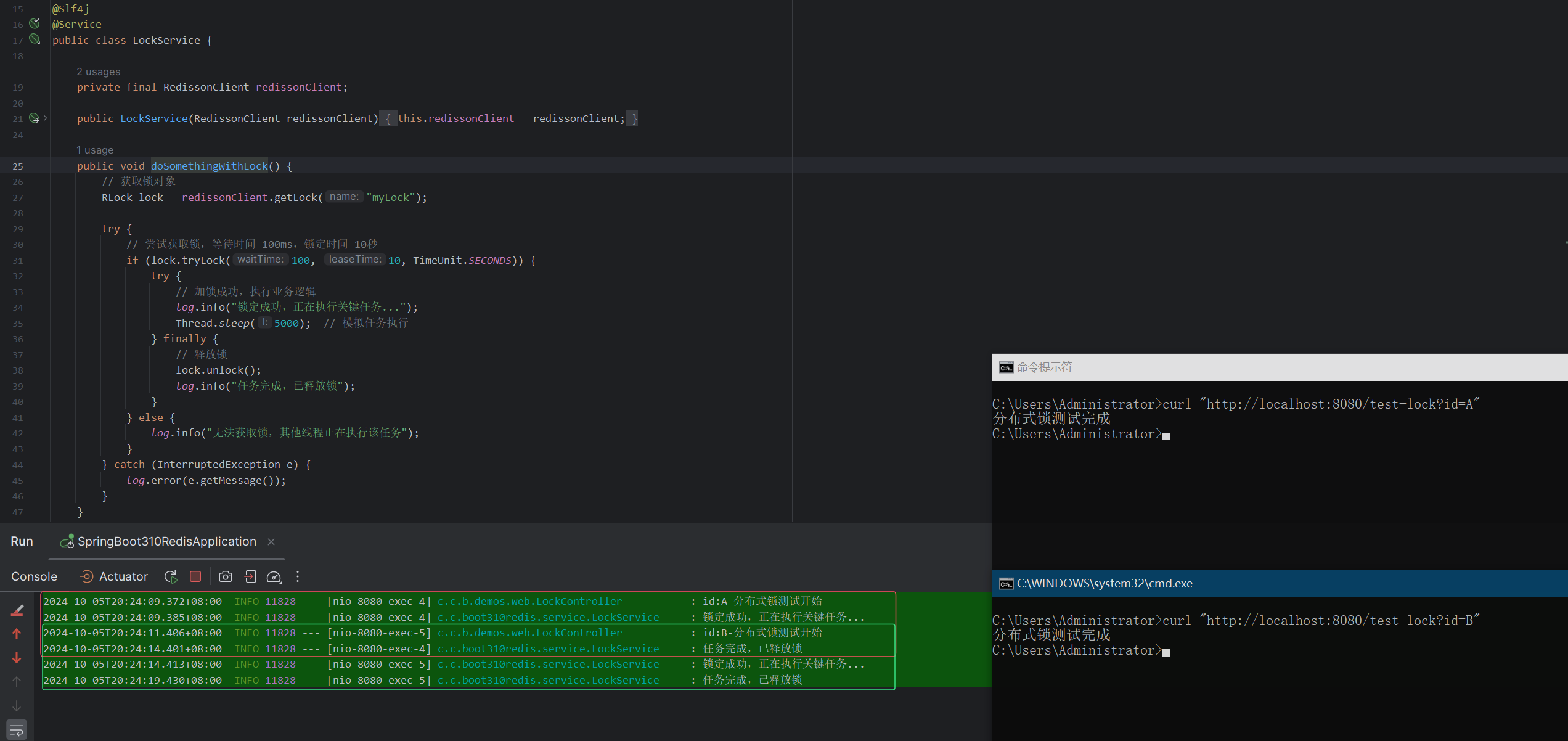

3.3.3 使用 MFC 在测试阶段扩展支持集

在此阶段,如图 3 所示,我们利用测试支持集 S test S_{\text{test}} Stest 和未标记集 U test U_{\text{test}} Utest 中的样本来推断测试查询集 Q test Q_{\text{test}} Qtest 中样本的类别。与 EPNet [33] 不同,我们使用 MFC 为未标记数据分配伪标签并扩展测试支持集。然后,通过使用扩展后的支持集进行标签传播,得到测试查询集 Q test Q_{\text{test}} Qtest 中样本的类别。使用 MFC 的优势在于,MFC 可以为小样本任务中的未标记数据生成高质量的伪标签。

图3 测试阶段的框架。在对未标记样本和支持样本进行特征提取后,使用 MFC 模块获取未标记样本的伪标签,以扩展支持集。扩展后的支持集用于与查询集进行标签传播,从而获得查询集样本的标签。

我们通过训练好的编码器从

{

S

test

,

Q

test

,

U

test

}

\{S_{\text{test}}, Q_{\text{test}}, U_{\text{test}}\}

{Stest,Qtest,Utest} 中提取嵌入表示,并在这些嵌入表示上应用嵌入传播。

S

test

S_{\text{test}}

Stest 被视为标记集,用于通过 MFC 对

U

test

U_{\text{test}}

Utest 中的未标记数据进行聚类。我们选择具有高置信度伪标签的未标记数据来形成一个子集:

U

~

test

=

{

(

x

u

i

,

y

~

i

)

∣

x

u

i

∈

U

test

}

(10)

\tilde{U}_{\text{test}} = \{(x_{\text{u}}^i, \tilde{y}_i) | x_{\text{u}}^i \in U_{\text{test}}\} \tag{10}

U~test={(xui,y~i)∣xui∈Utest}(10)

其中,

y

~

i

\tilde{y}_i

y~i 是 MFC 为

x

u

i

x_{\text{u}}^i

xui 获得的硬伪标签。测试支持集更新为:

S

′

=

S

test

∪

U

~

test

(11)

S' = S_{\text{test}} \cup \tilde{U}_{\text{test}} \tag{11}

S′=Stest∪U~test(11)

最后,我们基于扩展后的测试支持集 S ′ S' S′ 使用标签传播来预测 Q test Q_{\text{test}} Qtest 中数据的标签。

4 Experiment

4.1. Datasets

miniImageNet 数据集是由 Vinyals 等人 21 从 ImageNet 1 数据集中提取的一个子集。我们的实验使用了数据集中的所有 60,000 张图像,并根据传统小样本学习方法 21 10 37 38 的标准,将 100 个类别划分为 64 个训练类别、16 个验证类别和 20 个测试类别。

tieredImageNet 由 Ren 等人 18 提出用于小样本学习,是从 ImageNet 1 数据集中提取的另一个子集。它包含 34 个超级类别,可进一步分为 608 个类别,总共包含 779,165 张图像。我们的实验使用了该数据集中的所有图像数据,并根据传统小样本学习方法 39 40,将这些超级类别划分为 20 个训练超级类别(351 个类别)、6 个验证超级类别(97 个类别)和 8 个测试超级类别(160 个类别)。

CUB 41 42 数据集是一个基于 CUB200 43 的细粒度数据集,包含 200 个类别和 11,788 张图像,这些图像被划分为 100 个基础类别、50 个验证类别和 50 个新类别。

4.2. Model Settings

在预训练阶段,cluster-FSL 模型在所有训练类别和数据上进行 200 个 epoch 的训练,批量大小为 128。dropout 率为 0.1,权重衰减为 0.0005,动量为 0.9。预训练网络使用随机梯度下降(SGD)算法进行更新,初始学习率为 0.1。当验证损失在 10 个 epoch 内没有改善时,学习率乘以 0.1。当特征提取器的结构为 ResNet-12 时,输出特征维度 n n n 为 512;当结构为 WRN-28-10 时,输出特征维度 n n n 为 640。

在微调阶段,cluster-FSL 模型在 200 个 epoch 上进行训练,迭代次数为 600,权重衰减为 0.0005,动量为 0.9。模型使用随机梯度下降方法更新,学习率为 0.001,当模型达到停滞时,学习率乘以 0.1。

在测试阶段,cluster-FSL 模型在 1000 个 epoch 上进行测试,使用模型分类结果的平均准确率作为评估结果。每个小样本任务中的类别数 N N N 为 5。对于每个类别,支持样本的数量 K K K 为 1 和 5,查询样本的数量 q q q 为 15,未标记样本的数量 u u u 为 100。超参数 λ \lambda λ 为 0.8,温度参数 τ \tau τ 为 0.1,超参数 ϵ \epsilon ϵ 为 0.01。聚类过程的迭代次数为 10。

4.3. Comparative Experiment

比较实验的基线模型包括 EPNet 27、ICI 34 和一些经典或最新的小样本学习方法,如 TADAM 44、MTL 6、MetaOpt-SVM 45、CAN 46、LST 10 和 LEO 40;半监督小样本学习方法,如 TPN 19、TransMatch 20 和 PLAIN 47;以及基于图网络的方法 wDAE-GNN 39。此外,还对 PTN 33 和 Ren 等人 18 提出的聚类方法进行了比较实验,包括 Soft K-Means、Soft K-Means+Cluster、Masked Soft K-Means。我们使用定量分析和比较方法测试 cluster-FSL 模型的分类准确性,并评估模型的性能。在两个场景下进行了实验,即 5-way 1-shot 和 5-way 5-shot,这是小样本学习领域中的两种常见场景。以 ResNet-12 和 WRN-28-10 为骨干网络,我们在 miniImageNet、tieredImageNet 和 CUB-200-2011 数据集上获得了比较实验结果,如表 1、表 2 和表 3 所示。

表 1. cluster-FSL 模型在 miniImageNet 数据集的 5-way 1-shot 和 5-way 5-shot 场景下 1000 个小样本任务的平均分类准确率。

| Methods | backbone | miniImageNet 5-way 1-shot | miniImageNet 5-way 5-shot |

|---|---|---|---|

| TADAM | ResNet-12 | 58.50±0.30% | 76.70±0.30% |

| MTL | ResNet-12 | 61.20±1.80% | 75.50±0.80% |

| MetaOpt-SVM | ResNet-12 | 62.64±0.61% | 78.60±0.46% |

| CAN | ResNet-12 | 67.19±0.55% | 80.64±0.35% |

| LST | ResNet-12 | 70.10±1.90% | 78.70±0.80% |

| EPNet | ResNet-12 | 66.50±0.89% | 81.06±0.60% |

| TPN | ResNet-12 | 59.46% | 75.65% |

| PLAIN | ResNet-12 | 74.38±2.06% | 82.02±1.08% |

| EPNet-SSL | ResNet-12 | 75.36±1.01% | 84.07±0.60% |

| cluster-FSL(our) | ResNet-12 | 77.81±0.81% | 85.55±0.41% |

| - | - | - | - |

| Soft K-Means | WRN-28-10 | 50.09±0.45% | 64.59±0.28% |

| Soft K-Means+Cluster | WRN-28-10 | 49.03±0.24% | 63.08±0.18% |

| Masked Soft K-Means | WRN-28-10 | 50.41±0.31% | 64.39±0.24% |

| LEO | WRN-28-10 | 61.76±0.08% | 77.59±0.12% |

| wDAE-GNN | WRN-28-10 | 62.96±0.62% | 78.85±0.10% |

| EPNet | WRN-28-10 | 70.74±0.85% | 84.34±0.53% |

| TransMatch | WRN-28-10 | 62.93±1.11% | 82.24±0.59% |

| ICI | WRN-28-10 | 71.41% | 81.12% |

| EPNet-SSL | WRN-28-10 | 79.22±0.92% | 88.05±0.51% |

| PTN | WRN-28-10 | 81.57±0.94% | 87.17±0.58% |

| cluster-FSL(our) | WRN-28-10 | 82.63±0.79% |

在表 1 中,与在 miniImageNet 数据集上表现最佳的 EPNet-SSL 27 相比,当骨干网络为 ResNet-12 时,cluster-FSL 模型在 1-shot 和 5-shot 场景下分别实现了 2.45% 和 1.48% 的提升。当骨干网络为 WRN-28-10 时,我们的 cluster-FSL 在 1-shot 和 5-shot 场景下分别实现了 1.06% 和 0.73% 的提升。表 2 展示了在 tieredImageNet 数据集上的比较实验结果。当骨干网络为 ResNet-12 时,cluster-FSL 在 1-shot 和 5-shot 场景下分别实现了 2.10% 和 1.46% 的提升,达到了最先进的性能。当骨干网络为 WRN-28-10 时,我们的 cluster-FSL 在 1-shot 和 5-shot 场景下也分别实现了 1.04% 和 1.04% 的提升。在 CUB-200-2011 数据集上,表 3 展示了 cluster-FSL 相比 EPNet 27 和 ICI 34 的性能提升。

表 2. cluster-FSL 模型在 tieredImageNet 数据集的 5-way 1-shot 和 5-way 5-shot 场景下 1000 个小样本任务的平均分类准确率。

| Methods | backbone | tieredImageNet 5-way 1-shot | tieredImageNet 5-way 5-shot |

|---|---|---|---|

| MetaOpt-SVM | ResNet-12 | 65.99±0.72% | 81.56±0.53% |

| CAN | ResNet-12 | 73.21±0.58% | 84.93±0.38% |

| LST | ResNet-12 | 77.70±1.60% | 85.20±0.80% |

| EPNet | ResNet-12 | 76.53±0.87% | 87.32±0.64% |

| PLAIN | ResNet-12 | 82.91±2.09% | 88.29±1.25% |

| EPNet-SSL | ResNet-12 | 81.79±0.97% | 88.45±0.61% |

| cluster-FSL(our) | ResNet-12 | 83.89±0.81% | 89.94±0.46% |

| - | - | - | - |

| Soft K-Means | WRN-28-10 | 51.52±0.36% | 70.25±0.31% |

| Soft K-Means+Cluster | WRN-28-10 | 51.85±0.25% | 69.42±0.17% |

| Masked Soft K-Means | WRN-28-10 | 52.39±0.44% | 69.88±0.20% |

| LEO | WRN-28-10 | 66.33±0.05% | 81.44±0.09% |

| wDAE-GNN | WRN-28-10 | 68.16±0.16% | 83.09±0.12% |

| EPNet | WRN-28-10 | 78.50±0.91% | 88.36±0.57% |

| ICI | WRN-28-10 | 85.44% | 89.12% |

| EPNet-SSL | WRN-28-10 | 83.68±0.99% | 89.34±0.59% |

| PTN | WRN-28-10 | 84.70±1.14% | 89.14±0.71% |

| cluster-FSL(our) | WRN-28-10 | 85.74±0.76% | 90.18±0.43% |

比较实验的结果表明,我们的 cluster-FSL 在 1-shot 和 5-shot 场景下均表现出卓越的性能。此外,我们的 MFC 在加强多因素之间的关系方面具有更强的能力。

表 3. cub-200-2011 数据集上集群 fsl 模型的 5-way 1-shot 和 5-way 5-shot 场景中 1000 个few-shot 任务的平均分类准确率

| Methods | backbone | CUB-200-2011 5-way 1-shot | CUB-200-2011 5-way 5-shot |

|---|---|---|---|

| EPNet | ResNet-12 | 82.85±0.81% | 91.32±0.41% |

| cluster-FSL(our) | ResNet-12 | 87.36±0.71% | 92.17±0.31% |

| ICI | WRN-28-10 | 91.11% | 92.98% |

| EPNet | WRN-28-10 | 87.75±0.70% | 94.03±0.33% |

| cluster-FSL | WRN-28-10 | 91.80±0.58% | 95.07±0.23% |

4.4. Ablation Studies

在本节中,我们对每个阶段中各个模块的作用进行了完整的消融实验,并统一使用 WRN-28-10 作为骨干网络,在 5-way 1-shot 和 5-way 5-shot 下评估准确性。为了验证 MFC 在获取更高准确性伪标签方面的有效性,我们在 miniImageNet 和 tieredImageNet 数据集上对比了在 cluster-FSL 下不同的伪标签获取方法,例如标签传播 27 和 K-means,结果如表 4 所示。实验结果表明,与标签传播和 K-means 聚类相比,MFC 模块在 miniImageNet 和 tieredImageNet 数据集上有显著提升,这表明多因素包含更多的样本分布信息,并提高了分类准确性。

表 4. 在 5-way 5-shot 设置下,不同伪标签获取方法对基于 cluster-FSL 模型的影响。

| Methods | miniImageNet | tieredImageNet |

|---|---|---|

| Label propagation | 87.99±0.37% | 89.45±0.45% |

| Kmeans | 88.05±0.40% | 88.48±0.53% |

| MFC(our) | 89.16±0.35% | 90.18±0.43% |

为了验证 cluster-FSL 中包含的 MFC 和标签传播模块在实验结果中所起的关键作用,我们对微调和测试阶段的各个组件进行了全方位的消融实验,如表 5 所示。对于微调阶段,我们比较了仅使用标签传播、仅使用 MFC 模块以及两者都使用的模型。在微调阶段的这三种情况下,我们探讨了测试阶段不同设置对性能的影响。对于测试阶段,表 5 中的“MFC+LP”表示测试模型使用 MFC 获得扩展支持集,然后使用标签传播来预测查询集的标签。“LP”表示我们仅使用标签传播来推断查询集的标签。结果表明,MFC 在模型中起到了重要作用,并且能够提升模型的性能。

表 5。在 5 路 1-shot 设置中,mfc 和标签传播 (lp) 对 clust-fsl 的微调和测试阶段的影响。

| Settings | Fine-tune LP | Fine-tune MFC | Fine-tune MFC + LP | |

|---|---|---|---|---|

| Test | LP MFC + LP | 78.71% 80.88% | 79.32% 82.56% | 79.81% 82.70% |

在模型的微调阶段,支持集通过数据增强进行了扩展,并且查询样本由 MFC 模块进行预测。因此,我们对这两个部分进行了消融实验,结果如表 6 所示,展示了数据增强和 MFC 的效果。

表 6。在 5 路 1-shot 设置中,mfc 和数据增强对 clust-fsl 微调阶段的影响。

| Data Augmentation | MFC | ACC |

|---|---|---|

| × | × | 79.87±1.10% |

| √ | × | 80.88±1.07% |

| × | √ | 81.73±1.09% |

| √ | √ | 82.70±1.03% |

4.5. Parameters Analysis

我们的 cluster-FSL 模型有一个超参数 λ \lambda λ,其中公式 (7) 中的 λ \lambda λ 用于在微调阶段控制 MFC 和标签传播的比例。参数分析实验在 miniImageNet 数据集上进行,使用 WRN-28-10 作为骨干网络,并采用 5-way 1-shot 设置。如图 4 所示, λ = 0.8 \lambda = 0.8 λ=0.8 时可以获得最佳准确率,为 82.70%。当 λ \lambda λ 的值为 0 或 1 时,对应于在模型的微调阶段公式 (7) 中不考虑 MFC 或标签传播的影响。

图4 不同

λ

\lambda

λ 对 miniImageNet 数据集在 5-way 1-shot 设置下的影响。

5. Conclusion

我们提出了一种新颖的基于聚类的半监督小样本学习(cluster-FSL)图像分类方法,有效地缓解了样本稀缺的问题。在 cluster-FSL 中,我们通过整合标记数据和未标记数据的因素提出了一种多因素聚类(MFC)算法,有效地提高了伪标签的质量。此外,在模型的微调阶段,我们使用了更鲁棒的数据增强来进一步扩充数据集,并结合多因素聚类和标签传播的联合监督来训练模型。在三个基准数据集上,我们的 cluster-FSL 相比其他小样本学习方法取得了最先进的性能。

Olga Russakovsky, Jia Deng, Hao Su, Jonathan Krause, Sanjeev Satheesh, Sean Ma, Zhiheng Huang, Andrej Karpathy, Aditya Khosla, Michael Bernstein, et al. Imagenet large scale visual recognition challenge. International journal of computer vision, 115(3):211–252, 2015. ↩︎ ↩︎ ↩︎

Alex Krizhevsky, Ilya Sutskever, and Geoffrey E Hinton. Imagenet classification with deep convolutional neural networks. Advances in neural information processing systems, 25:1097–1105, 2012. ↩︎

Shaoqing Ren, Kaiming He, Ross Girshick, and Jian Sun. Faster r-cnn: Towards real-time object detection with region proposal networks. Advances in neural information processing systems, 28:91–99, 2015. ↩︎

Jonathan Long, Evan Shelhamer, and Trevor Darrell. Fully convolutional networks for semantic segmentation. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 3431–3440, 2015. ↩︎

Limeng Qiao, Yemin Shi, Jia Li, Yaowei Wang, Tiejun Huang, and Yonghong Tian. Transductive episodic-wise adaptive metric for few-shot learning. In Proceedings of the IEEE/CVF International Conference on Computer Vision, pages 3603–3612, 2019. ↩︎

Qianru Sun, Yaoyao Liu, Tat-Seng Chua, and Bernt Schiele. Meta-transfer learning for few-shot learning. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 403–412, 2019. ↩︎ ↩︎ ↩︎ ↩︎

Juan-Manuel Perez-Rua, Xiatian Zhu, Timothy M Hospedales, and Tao Xiang. Incremental few-shot object detection. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 13846–13855, 2020. ↩︎

Jianzhu Guo, Xiangyu Zhu, Chenxu Zhao, Dong Cao, Zhen Lei, and Stan Z Li. Learning meta face recognition in unseen domains. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 6163– 6172, 2020. ↩︎

Hang Qi, Matthew Brown, and David G Lowe. Low-shot learning with imprinted weights. In 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 5822–5830. IEEE, 2018. ↩︎ ↩︎

Flood Sung, Yongxin Yang, Li Zhang, Tao Xiang, Philip HS Torr, and Timothy M Hospedales. Learning to compare: Relation network for few-shot learning. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 1199–1208, 2018. ↩︎ ↩︎ ↩︎ ↩︎

Sagie Benaim and Lior Wolf. One-shot unsupervised cross domain translation. In Proceedings of the 32nd International Conference on Neural Information Processing Systems, pages 2108–2118, 2018. ↩︎

Yabin Zhang, Hui Tang, and Kui Jia. Fine-grained visual categorization using meta-learning optimization with sample selection of auxiliary data. In European Conference on Computer Vision, pages 241–256. Springer, 2018. ↩︎

Donghyun Yoo, Haoqi Fan, Vishnu Naresh Boddeti, and Kris M Kitani. Efficient k-shot learning with regularized deep networks. In Thirty-Second AAAI Conference on Artificial Intelligence, 2018. ↩︎ ↩︎

Jedrzej Kozerawski and Matthew Turk. CLEAR: Cumulative learning for one-shot one-class image recognition. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 3446–3455, 2018. ↩︎ ↩︎

Kihyuk Sohn, David Berthelot, Nicholas Carlini, Zizhao Zhang, Han Zhang, Colin A Raffel, Ekin Dogus Cubuk, Alexey Kurakin, and Chun-Liang Li. Fixmatch: Simplifying semi-supervised learning with consistency and confidence. Advances in Neural Information Processing Systems, 33, 2020. ↩︎

Samuli Laine and Timo Aila. Temporal ensembling for semi-supervised learning. arXiv preprint arXiv:1610.02242, 2016. ↩︎

Antti Tarvainen and Harri Valpola. Mean teachers are better role models: Weight-averaged consistency targets improve semi-supervised deep learning results. In Proceedings of the 31st International Conference on Neural Information Processing Systems, pages 1195–1204, 2017. ↩︎

Mengye Ren, Eleni Triantafillou, Sachin Ravi, Jake Snell, Kevin Swersky, Joshua B Tenenbaum, Hugo Larochelle, and Richard S Zemel. Meta-learning for semi-supervised few-shot classification. In International Conference on Learning Representations, 2018. ↩︎ ↩︎ ↩︎ ↩︎ ↩︎

Y Liu, J Lee, M Park, S Kim, E Yang, SJ Hwang, and Y Yang. Learning to propagate labels: Transductive propagation network for few-shot learning. In 7th International Conference on Learning Representations, ICLR 2019, 2019. ↩︎ ↩︎ ↩︎

Zhongjie Yu, Lin Chen, Zhongwei Cheng, and Jiebo Luo. Transmatch: A transfer-learning scheme for semi-supervised few-shot learning. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 12856–12864, 2020. ↩︎ ↩︎ ↩︎

Oriol Vinyals, Charles Blundell, Timothy Lillicrap, Daan Wierstra, et al. Matching networks for one shot learning. Advances in neural information processing systems, 29:3630–3638, 2016. ↩︎ ↩︎ ↩︎

Jake Snell, Kevin Swersky, and Richard Zemel. Prototypical networks for few-shot learning. Advances in Neural Information Processing Systems, 30:4077–4087, 2017. ↩︎

Chelsea Finn, Pieter Abbeel, and Sergey Levine. Model-agnostic meta-learning for fast adaptation of deep networks. In International Conference on Machine Learning, pages 1126–1135. PMLR, 2017. ↩︎

Alex Nichol, Joshua Achiam, and John Schulman. On first-order meta-learning algorithms. arXiv preprint arXiv:1803.02999, 2018. ↩︎

Zhenguo Li, Fengwei Zhou, Fei Chen, and Hang Li. Meta-sgd: Learning to learn quickly for few-shot learning. arXiv preprint arXiv:1707.09835, 2017. ↩︎

Sachin Ravi and Hugo Larochelle. Optimization as a model for few-shot learning. 2016. ↩︎

Pau Rodríguez, Issam Laradji, Alexandre Drouin, and Alexandre Lacoste. Embedding propagation: Smoother manifold for few-shot classification. In European Conference on Computer Vision, pages 121–138. Springer, 2020. ↩︎ ↩︎ ↩︎ ↩︎ ↩︎

Tsendsuren Munkhdalai and Hong Yu. Meta networks. In International Conference on Machine Learning, pages 2554–2563. PMLR, 2017. ↩︎

Michalis Lazarou, Tania Stathaki, and Yannis Avrithis. Iterative label cleaning for transductive and semi-supervised few-shot learning. In Proceedings of the IEEE/CVF International Conference on Computer Vision, pages 8751–8760, 2021. ↩︎

Yu Wu, Yutian Lin, Xuanyi Dong, Yan Yan, Wanli Ouyang, and Yi Yang. Exploit the unknown gradually: One-shot video-based person re-identification by stepwise learning. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 5177–5186, 2018. ↩︎

Xinzhe Li, Qianru Sun, Yaoyao Liu, Qin Zhou, Shibao Zheng, Tat-Seng Chua, and Bernt Schiele. Learning to self-train for semi-supervised few-shot classification. Advances in Neural Information Processing Systems, 32:10276–10286, 2019. ↩︎

Kai Huang, Jie Geng, Wen Jiang, Xinyang Deng, and Zhe Xu. Pseudo-loss confidence metric for semi-supervised few-shot learning. In Proceedings of the IEEE/CVF International Conference on Computer Vision, pages 8671–8680, 2021. ↩︎

Huaxi Huang, Junjie Zhang, Jian Zhang, Qiang Wu, and Chang Xu. PTN: A poisson transfer network for semi-supervised few-shot learning. In Proceedings of the AAAI Conference on Artificial Intelligence, volume 35, pages 1602–1609, 2021. ↩︎ ↩︎

Yikai Wang, Chengming Xu, Chen Liu, Li Zhang, and Yanwei Fu. Instance credibility inference for few-shot learning. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 12836–12845, 2020. ↩︎ ↩︎ ↩︎

Lei Zhang, Meng Yang, and Xiangchu Feng. Sparse representation or collaborative representation: Which helps face recognition? In 2011 International conference on computer vision, pages 471–478. IEEE, 2011. ↩︎

Ahmet Iscen, Giorgos Tolias, Yannis Avrithis, and Ondrej Chum. Label propagation for deep semi-supervised learning. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 5070–5079, 2019. ↩︎

Victor Garcia and Joan Bruna. Few-shot learning with graph neural networks. In 6th International Conference on Learning Representations, ICLR 2018, 2018. ↩︎

Jongmin Kim, Taesup Kim, Sungwoong Kim, and Chang D Yoo. Edge-labeling graph neural network for few-shot learning. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 11–20, 2019. ↩︎

Spyros Gidaris and Nikos Komodakis. Generating classification weights with gnn denoising autoencoders for few-shot learning. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 21–30, 2019. ↩︎ ↩︎

Andrei A Rusu, Dushyant Rao, Jakub Sygnowski, Oriol Vinyals, Razvan Pascanu, Simon Osindero, and Raia Hadsell. Meta-learning with latent embedding optimization. In International Conference on Learning Representations, 2018. ↩︎ ↩︎

Wei-Yu Chen, Yen-Cheng Liu, Zsolt Kira, Yu-Chiang Frank Wang, and Jia-Bin Huang. A closer look at few-shot classification. In International Conference on Learning Representations, 2019. ↩︎

Nathan Hilliard, Lawrence Phillips, Scott Howland, Artëm Yankov, Courtney D Corley, and Nathan O Hodas. Few-shot learning with metric-agnostic conditional embeddings. arXiv preprint arXiv:1802.04376, 2018. ↩︎

Peter Welinder, Steve Branson, Takeshi Mita, Catherine Wah, Florian Schroff, Serge Belongie, and Pietro Perona. Caltech-ucsd birds 200. 2010. ↩︎

Boris N Oreshkin, Pau Rodriguez, and Alexandre Lacoste. TADAM: task dependent adaptive metric for improved few-shot learning. In Proceedings of the 32nd International Conference on Neural Information Processing Systems, pages 719–729, 2018. ↩︎

Kwonjoon Lee, Subhransu Maji, Avinash Ravichandran, and Stefano Soatto. Meta-learning with differentiable convex optimization. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 10657–10665, 2019. ↩︎

Ruibing Hou, Hong Chang, Bingpeng Ma, Shiguang Shan, and Xilin Chen. Cross attention network for few-shot classification. In Proceedings of the 33rd International Conference on Neural Information Processing Systems, pages 4003–4014, 2019. ↩︎

Pan Li, Guile Wu, Shaogang Gong, and Xu Lan. Semi-supervised few-shot learning with pseudo label refinement. In 2021 IEEE International Conference on Multimedia and Expo (ICME), pages 1–6. IEEE, 2021. ↩︎