现在开发的系统有大量知识汇总统计、跑批处理需求的同学可以尝试一下,看看能不能解决自己目前的问题~~ 可能是一个解决方案

Anthropic 推出的 Message Batches API ,专门用于帮助开发者批量处理大量请求。它的主要目的是通过一次性处理大量非实时任务,节省时间和降低成本。简单来说,它适合那些不需要即时响应的任务,特别是需要处理大量数据的场景。

用途和好处:

- 批量处理请求:你可以一次性提交多达 10,000 个查询,而不必担心实时响应的速度。每批任务会在 24 小时内完成处理,这样你可以把多个任务集中到一起处理,而不是一条一条发送。

- 成本降低:相比标准的API调用,这个API的费用减少了50%。这对于需要处理大量数据但又不需要即时结果的应用场景来说非常划算。

- 高效处理大规模数据:适合那些需要处理海量数据的任务,比如:

- 分析客户反馈

- 翻译大量文档

- 分析企业文档库

- 对数据集进行分类或模型评估

- 不影响实时API限额:使用这个批量API处理任务,不会占用你的标准API调用限额,意味着你可以同时进行批量处理和即时响应的任务。

应用场景:

- 内容分析:企业可以用它来批量分析大量客户反馈或社交媒体评论。

- 翻译服务:批量翻译大量文档,而不必一条条提交。

- 数据分类:处理大型数据集,比如整理公司文档库或生成数据报告。

价格优势

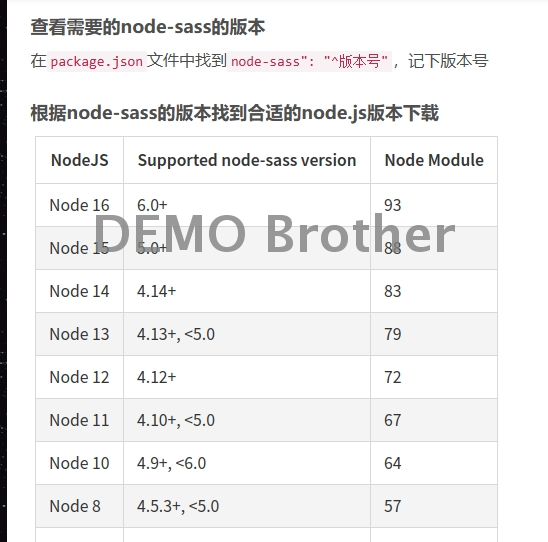

Anthropic 的 Message Batches API 提供按处理的输入和输出 tokens 来收费,具体定价根据使用的模型不同而有所不同。以下是目前支持的 Claude 模型和相应的定价信息:

Claude 3.5 Sonnet

- 输入费用:$1.50/百万 tokens

- 输出费用:$7.50/百万 tokens

Claude 3 Opus

- 输入费用:$7.50/百万 tokens

- 输出费用:$37.50/百万 tokens

Claude 3 Haiku

- 输入费用:$0.125/百万 tokens

- 输出费用:$0.625/百万 tokens

价格说明:

- 输入 tokens:指的是你提交的请求中的文本量。

- 输出 tokens:指的是 API 返回的文本量。

这个 API 相比标准 API 便宜 50%,特别适合需要处理大量数据但不需要实时响应的任务。

使用案例

Quora 是一个以用户为基础的问题和答案平台,他们利用 Anthropic 的批量 API 进行内容总结和亮点提取,来为其用户提供新的功能。

- 成本节省:通过批量处理 API,Quora 能够在大量请求中节省成本。相比实时处理请求,批量处理更加经济高效。

- 简化复杂度:Quora 的产品经理 Andy Edmonds 表示,使用批量 API 简化了并行处理大量查询的复杂性。他们可以将一批查询提交给 API,然后在 24 小时内下载处理结果,而不需要管理复杂的实时查询系统。

- 提升工程师效率:通过这种方式,Quora 的工程师能够将更多的时间用于解决更复杂、更具创造性的问题,而不是在查询管理上耗费过多精力。