计算机前沿技术-人工智能算法-大语言模型-最新研究进展-2024-10-06

目录

文章目录

- 计算机前沿技术-人工智能算法-大语言模型-最新研究进展-2024-10-06

- 目录

- 1. A LLM-Powered Automatic Grading Framework with Human-Level Guidelines Optimization

- 摘要:

- 研究背景:

- 问题与挑战:

- 如何解决:

- 创新点:

- 算法模型:

- 实验效果:

- 推荐阅读指数:

- 推荐理由:

- 2. General Preference Modeling with Preference Representations for Aligning Language Models

- 摘要:

- 研究背景:

- 问题与挑战:

- 如何解决:

- 创新点:

- 算法模型:

- 实验效果:

- 推荐阅读指数:

- 推荐理由:

- 3. GraphIC: A Graph-Based In-Context Example Retrieval Model for Multi-Step Reasoning

- 摘要:

- 研究背景:

- 问题与挑战:

- 如何解决:

- 创新点:

- 算法模型:

- 实验效果:

- 推荐阅读指数:

- 推荐理由:

- 4. CodePMP: Scalable Preference Model Pretraining for Large Language Model Reasoning

- 摘要:

- 研究背景:

- 问题与挑战:

- 如何解决:

- 创新点:

- 算法模型:

- 实验效果:

- 推荐阅读指数:

- 推荐理由:

- 5. SEAL: SEmantic-Augmented Imitation Learning via Language Model

- 摘要:

- 研究背景:

- 问题与挑战:

- 如何解决:

- 创新点:

- 算法模型:

- 实验效果:

- 推荐阅读指数:

- 推荐理由

- 后记

1. A LLM-Powered Automatic Grading Framework with Human-Level Guidelines Optimization

Authors: Yucheng Chu, Hang Li, Kaiqi Yang, Harry Shomer, Hui Liu, Yasemin Copur-Gencturk and Jiliang Tang

https://arxiv.org/abs/2410.02165

一个由大型语言模型驱动的自动评分框架,具有人类水平的指导方针优化

摘要:

文章提出了一个名为GradeOpt的统一多代理自动短答案评分(ASAG)框架,该框架利用大型语言模型(LLMs)作为评分员对开放性简答题(SAGs)进行评分。GradeOpt框架通过自我反思机制自动优化原始评分指南,以提高评分准确性和与人类评分员的行为一致性。通过在教育内容知识(PCK)和内容知识(CK)问题上的实验,证明了GradeOpt在评分准确性和与人类评分员行为一致性方面相较于现有基线模型的优越性能。

研究背景:

在教育分析(LA)中,开放式简答题(SAGs)被广泛认为是提供对学习者反应更深入了解的有力工具。然而,SAGs在实践中常常因为评分工作量大和评估不一致性而面临挑战。随着自然语言处理(NLP)技术的进步,自动短答案评分(ASAG)提供了一个有希望的解决方案。但是,现有的ASAG算法通常在泛化能力上受限,并且往往是针对特定问题定制的。

问题与挑战:

现有的ASAG算法在泛化到不同类型的问题上存在困难,并且依赖于大量标注样本。此外,深度学习模型在样本数量有限时容易过拟合,并且其“黑箱”特性限制了它们的应用。

如何解决:

文章提出了一个多代理ASAG框架,通过迭代反射机制自动优化评分指南。框架包括三个基于LLM的代理:评分员(Grader)、反射器(Reflector)和提炼器(Refiner),它们协同工作以提高训练数据集上的分类准确性。

创新点:

- 提出了一个统一的多代理ASAG框架,利用LLMs进行评分。

- 引入了反射器和提炼器代理,通过自我反思自动优化评分指南。

- 实现了一个迭代优化过程,通过错误反馈改进评分规则。

- 提出了一种基于错误反馈的测试时适应性训练方法。

算法模型:

GradeOpt框架包括训练阶段和测试时适应阶段。在训练阶段,通过多代理系统协同预测评分、识别错误并提出规则修改建议来优化评分指南。在测试时适应阶段,系统首先对一小批未标记的答案样本执行分布外(OOD)测试,然后根据需要进行测试时训练。

实验效果:

实验结果表明,GradeOpt在评分准确性和与人类评分员行为一致性方面均优于现有基线模型。例如,在PCK和CK问题上,GradeOpt的平均Cohen’s Kappa值达到了0.85,而其他模型如RoBERTa和SBERT的平均值分别为0.65和0.35。

算法代码:

推荐阅读指数:

8/10

推荐理由:

这篇文章提出了一个创新的自动评分框架,可以显著减轻教育工作者的评分负担,并提供一致和准确的评分。

2. General Preference Modeling with Preference Representations for Aligning Language Models

Authors: Yifan Zhang, Ge Zhang, Yue Wu, Kangping Xu, Quanquan Gu

https://arxiv.org/abs/2410.02197

用于语言模型对齐的偏好表示的通用偏好建模

摘要:

文章提出了一种新的方法来对齐基础模型与人类价值观,通过捕捉复杂的人类偏好结构。传统奖励建模方法,如布拉德利-特里(Bradley-Terry, BT)奖励模型,在表达能力上存在限制,尤其是在处理非传递性偏好时。尽管监督对偏好模型(PairPM)可以表达一般偏好,但它们的实现高度特定,并且由于比较多个响应时的二次查询复杂度,导致计算成本高昂。文章介绍了偏好表示学习,一种将响应嵌入到潜在空间中以有效捕捉复杂偏好结构的方法,实现了线性查询复杂度。此外,提出了基于偏好分数的通用偏好优化(General Preference Optimization, GPO),它将基于人类反馈的强化学习泛化。实验结果显示,所提出的通用偏好表示模型(General Preference representation model, GPM)在RewardBench基准测试中的表现超过了BT奖励模型达5.6%,并且在有效建模循环偏好方面的表现相当于随机猜测。此外,在AlpacaEval2.0和MT-Bench等下游任务的评估中,与GPO和我们的通用偏好模型一起进行的语言模型后训练,显示出显著的性能提升。

研究背景:

对齐语言模型与人类意图和价值观对于改进文本生成和增强决策制定策略至关重要。现有方法通常依赖于奖励建模,但这些方法在处理复杂或非传递性人类偏好时面临挑战。

问题与挑战:

现有的偏好模型在表达能力和计算效率方面存在挑战,尤其是在处理复杂的人类偏好时。

如何解决:

文章提出了一种新的偏好表示学习方法,通过将响应嵌入到潜在空间中来捕捉复杂的偏好结构,并通过偏好分数的通用偏好优化来实现语言模型的对齐。

创新点:

- 提出了一种新的偏好表示学习方法,通过嵌入技术捕捉偏好结构。

- 提出了通用偏好优化(GPO),一种新的基于偏好分数的优化方法。

- 实现了与BT模型相比在基准测试中的性能提升,以及在处理循环偏好方面的有效性。

算法模型:

文章提出的通用偏好表示模型(GPM)通过在潜在空间中建模偏好来实现偏好概率的高效计算。此外,文章还提出了一种基于偏好分数的优化方法,用于在训练过程中优化语言模型。

实验效果:

在RewardBench基准测试中,GPM在多个任务上的表现超过了BT模型,性能提升最高达5.6%。在AlpacaEval2.0和MT-Bench等下游任务中,使用GPM进行后训练的语言模型显示出显著的性能提升。

推荐阅读指数:

9/10

推荐理由:

这篇文章提出了一种创新的方法来对齐语言模型与人类偏好,这对于自然语言处理和机器学习领域的研究者来说是非常有价值的。

3. GraphIC: A Graph-Based In-Context Example Retrieval Model for Multi-Step Reasoning

Authors: Jiale Fu, Yaqing Wang, Simeng Han, Jiaming Fan, Chen Si, Xu Yang

https://arxiv.org/abs/2410.02203

GRAPHIC:一种用于多步推理的基于图的上下文示例检索模型

摘要:

文章提出了一种名为GraphIC的新方法,它利用基于图的推理过程表示,结合贝叶斯网络(BNs)来选择上下文示例(In-Context Examples, ICEs),以提高大型语言模型(LLMs)在多步推理任务中的性能。GraphIC通过图结构过滤掉与推理过程无关的浅层语义信息,同时保留核心推理结构。贝叶斯网络特别适合于多步推理任务,因为它们能够捕捉推理步骤之间的依赖性和进展。实验结果表明,GraphIC在数学推理、代码生成和逻辑推理等任务中,无论是在有效性还是效率方面,都优于无需训练和需要训练的模型。

研究背景:

在上下文学习(In-Context Learning, ICL)中,通过在输入中直接包含几个示例,可以使大型语言模型(LLMs)泛化到新任务,而无需更新参数。然而,ICL的有效性在很大程度上依赖于所选择的示例。

问题与挑战:

传统的基于文本的嵌入方法在选择示例时常常是不够的,因为它们主要关注语义级别的相似性,这在需要多步推理的任务中会带来显著的局限性。

如何解决:

文章提出了GraphIC方法,它通过图表示法来改进示例的检索过程,从而更好地对齐于任务的推理过程。

创新点:

- 提出了“思想图”(thought graph)的概念,用于模拟认知过程中的推理步骤。

- 利用贝叶斯网络来模拟思想图,并估计与查询问题推理过程相关的概率密度。

- 通过个性化的PageRank机制来模拟人类在复杂问题解决过程中经常回顾初始假设的认知倾向。

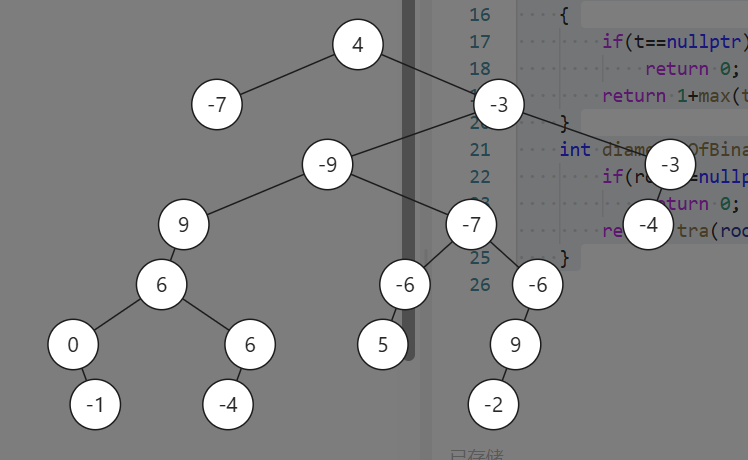

算法模型:

GraphIC模型包括以下关键步骤:

- 生成候选示例和查询问题的“思想图”。

- 使用贝叶斯网络来模拟每个思想图,并估计相关参数。

- 选择参数化思想模式的示例,以最大化查询问题思想图上的概率密度。

实验效果:

在包括数学推理、代码生成和逻辑推理在内的四种多步推理任务中,GraphIC在无需训练的情况下,性能超过了其他需要训练和不需要训练的基线模型。

推荐阅读指数:

8/10

推荐理由:

这篇文章提出了一个创新的方法来改进大型语言模型在多步推理任务中的性能,这对于自然语言处理和人工智能领域的研究人员来说是非常有价值的。

4. CodePMP: Scalable Preference Model Pretraining for Large Language Model Reasoning

Authors: Huimu Yu, Xing Wu, Weidong Yin, Debing Zhang, Songlin Hu

https://arxiv.org/abs/2410.02229

CodePMP:面向大型语言模型推理的可扩展偏好模型预训练

摘要:

文章提出了CodePMP,这是一个可扩展的偏好模型预训练(PMP)流程,它利用来自公开高质量源代码的大量合成代码-偏好对来增强大型语言模型(LLMs)的推理能力。CodePMP通过在大规模合成代码-偏好对上预训练偏好模型来提高奖励模型(RM)微调的效率。在数学推理任务(GSM8K、MATH)和逻辑推理任务(ReClor、LogiQA2.0)上的评估表明,CodePMP显著提高了LLMs的推理性能,并突出了可扩展偏好模型预训练在有效奖励建模中的重要性。

研究背景:

大型语言模型(LLMs)在自然语言理解和生成方面取得了显著进展,但增强LLMs的推理能力,特别是通过人类反馈的强化学习(RLHF),由于高质量偏好数据的稀缺性,仍然具有挑战性。

问题与挑战:

现有的基于人类反馈的奖励模型(RM)预训练方法依赖于公开来源的大规模偏好数据,但这些数据对于推理任务来说往往不够丰富,且手动注释这些数据成本高昂。

如何解决:

CodePMP通过从GitHub等平台上可用的大量源代码生成合成的偏好对来解决这个问题。这些代码数据经过处理,生成用于偏好模型预训练的数据集。

创新点:

- 提出了一种新颖的偏好模型预训练方法,使用代码数据来提高LLMs在推理任务中的表现。

- 展示了CodePMP在多个推理任务中的有效性,包括数学和逻辑推理。

- 证明了CodePMP在提高奖励模型微调准确性和Best-of-N性能方面的显著改进。

算法模型:

CodePMP利用两个不同能力的代码语言模型(CodeLLMs)生成代码片段,一个生成高质量(被选择)的响应,另一个生成较差的(被拒绝)响应。这些<被选择,被拒绝>对形成了预训练数据集,用于预训练偏好模型。

实验效果:

实验结果显示,在数学推理和逻辑推理任务上,CodePMP预训练的模型在RM准确性和Best-of-N性能方面均优于直接微调的RM。

推荐阅读指数:

7/10

推荐理由:

这篇文章提出了一种创新的方法来提高大型语言模型在复杂推理任务中的性能。CodePMP通过利用代码数据来预训练偏好模型,减少了对人工注释数据的依赖,同时提高了模型在推理任务中的样本效率和性能。这对于自然语言处理和人工智能领域的研究人员来说是非常有价值的。

5. SEAL: SEmantic-Augmented Imitation Learning via Language Model

Authors: Chengyang Gu, Yuxin Pan, Haotian Bai, Hui Xiong, Yize Chen

https://arxiv.org/abs/2410.02231

SEAL:通过语言模型进行语义增强的模仿学习

摘要:

文章介绍了SEAL,这是一个新颖的框架,利用大型语言模型(LLMs)强大的语义和世界知识来指定子目标空间,并在没有任务层次结构先验知识的情况下,将状态预先标记为语义有意义的子目标表示。SEAL采用了双编码器结构,结合了监督的LLM引导的子目标学习和无监督的向量量化(VQ)以获得更强大的子目标表示。此外,SEAL还结合了一个过渡增强的低级规划器,以更好地适应子目标转换。实验表明,SEAL在小专家数据集和复杂长时序任务的设置中,性能超过了现有的分层模仿学习(HIL)方法和基于LLM的规划方法。

研究背景:

层次化模仿学习(HIL)是一种有前景的方法,用于处理长时序决策任务。然而,由于缺乏详细的监督标签用于子目标学习,以及依赖于成百上千的专家演示,这使得HIL成为一个挑战。

问题与挑战:

现有的基于文本的嵌入选择方法主要关注捕获语义级别的相似性,这在需要多步推理的任务中遇到显著局限性。此外,这些方法在从专家轨迹中学习子目标时面临挑战,因为这些轨迹通常没有明确的标签。

如何解决:

SEAL框架通过使用LLM生成的高级计划来辅助子目标学习和策略训练,从而解决了这些挑战。SEAL利用LLM从完整的任务语言指令中提取子目标,并使用这些子目标作为训练高层次子目标编码器的监督标签。

创新点:

- 提出了一种新颖的利用预训练LLM来生成高级计划并提供语义有意义的子目标表示的方法。

- 引入了双编码器结构,结合了监督的LLM基础子目标学习和无监督的VQ表示,以提高子目标学习的可靠性和鲁棒性。

- 设计了一个过渡增强的低级策略代理,通过为子目标转换点分配更高的权重来强调这些状态的重要性。

算法模型:

SEAL框架包括一个高层次的子目标编码器和一个低层次的策略代理,它们通过最小化损失函数来共同训练。SEAL使用LLM来指导子目标学习,并结合无监督的VQ来提高子目标表示的鲁棒性。

实验效果:

在KeyDoor和Grid-World任务中的实验结果表明,SEAL在小专家数据集和复杂长时序任务中的表现优于多种现有的HIL方法。SEAL在成功完成任务方面展现了更高的成功率和子目标完成率。

推荐阅读指数:

8/10

推荐理由

这篇文章提出了一种创新的方法,通过结合LLM的强大语义理解能力来增强模仿学习,特别是在处理需要多步推理的复杂任务方面。SEAL框架的提出为长时序决策任务提供了一种有效的解决方案,值得一读。

后记

如果您对我的博客内容感兴趣,欢迎三连击(点赞,关注和评论),我将持续为您带来计算机人工智能前沿技术(尤其是AI相关的大语言模型,深度学习,计算机视觉相关方向)最新学术论文及工程实践方面的内容分享,助力您更快更准更系统地了解 AI前沿技术。

![[git] github管理项目之环境依赖管理](https://i-blog.csdnimg.cn/direct/5cdd35d1023d45fba1697f7089d8dd6f.png)