关于深度实战社区

我们是一个深度学习领域的独立工作室。团队成员有:中科大硕士、纽约大学硕士、浙江大学硕士、华东理工博士等,曾在腾讯、百度、德勤等担任算法工程师/产品经理。全网20多万+粉丝,拥有2篇国家级人工智能发明专利。

社区特色:深度实战算法创新

获取全部完整项目数据集、代码、视频教程,请进入官网:zzgcz.com。竞赛/论文/毕设项目辅导答疑,v:zzgcz_com

1. 项目简介

本项目的目标是使用深度学习模型对细胞图像进行分割和计数,从而实现对医学或生物图像的自动分析和处理。细胞图像分割和计数是细胞生物学领域中的一个重要研究方向,它能够有效地帮助研究人员自动化处理大规模细胞图像数据,减少人工标注工作量,并提高分析效率和准确性。本项目基于经典的U-Net模型,该模型是一种广泛应用于图像分割任务的卷积神经网络架构。U-Net模型通过对输入图像进行编码和解码操作,逐层提取图像特征并重建输出图像,使得它在处理医学图像数据时具备很高的分割精度。具体而言,U-Net采用“U”字形结构,包括下采样编码器和上采样解码器,这种结构使模型能够在多尺度上捕捉图像中的细节信息,适用于精细的分割任务。本项目将其应用于细胞图像分割,旨在识别和计数每一个细胞的轮廓与位置,从而为后续的细胞数量统计、细胞形态分析及其他定量研究提供可靠的工具支持。项目实现过程中使用了Keras框架,并结合了数据增强和自定义损失函数来提高模型的鲁棒性和适用性。通过该项目,研究人员可以更轻松地实现复杂的细胞分割任务,加速生物医学研究的进展。

2.技术创新点摘要

- 网络结构优化:项目基于经典的U-Net模型进行改进,采用了更深的网络层次结构,使模型能够在多尺度上捕捉到图像中的细节信息。特别是针对医学图像分割,项目通过增加卷积层数和引入Dropout层来增强模型的特征提取能力,并有效防止过拟合,从而提高模型在训练数据较少情况下的表现。项目中采用了

he_normal初始化器和relu激活函数组合,使得网络在训练时能够更快地收敛,降低梯度消失的风险。 - 自定义数据增强策略:在

data_strength.py中实现了一个自定义的图像增强类Augmentation,通过对输入的训练数据进行多种方式的变换(如旋转、平移、缩放、剪切和翻转),大幅度提升了训练数据的多样性,防止模型过拟合。该类特别针对医学图像的特征(如细胞的形态结构)进行优化,使增强后的数据能够更好地模拟不同细胞的形态变化。 - 基于边缘检测的后处理方法:项目创新性地结合了OpenCV的边缘检测(Canny边缘检测)和轮廓发现(findContours)算法,来进行图像分割后的细胞计数。模型分割出的细胞区域通过边缘检测算法进一步识别轮廓,从而对每个细胞进行精准计数。这种结合了传统图像处理方法和深度学习的混合策略,提高了分割后图像的准确性。

- 轻量化设计与硬件适配:项目在设计时考虑了硬件环境的限制,将原始512×512分辨率的图像下采样至256×256,再进行批处理以适配有限的硬件资源。并且在训练时选取较小的批量(batch_size=2),从而降低了内存占用,确保模型在普通硬件条件下依然能够高效运行。

3. 数据集与预处理

本项目使用的数据集来源于ISBI细胞分割挑战赛,该数据集包含经过标注的细胞显微图像。原始数据集由30张分辨率为512×512的 .tif 格式图像组成,每张图像包含不同数量和形态的细胞,且在亮度、对比度等方面存在一定的差异性。数据集中包括训练图像和对应的标注图像(即每个细胞的精确分割轮廓),这些图像主要用于训练和验证深度学习模型的分割效果。

在数据预处理中,本项目采用了以下步骤进行处理和优化:

- 图像尺寸调整:由于原始512×512分辨率图像的计算开销较大,项目将图像尺寸调整为256×256,并对所有图像进行批处理,以适应硬件资源的限制。此过程保留了图像中的主要细节信息,同时显著降低了计算资源的需求。

- 归一化处理:所有输入的图像数据在加载时会被归一化至

[0, 1]的浮点数值区间,这样能够消除图像中亮度变化对模型训练的影响,并加速网络的收敛过程。 - 数据增强:针对细胞图像中形态多变、位置随机的特点,项目实现了自定义数据增强策略。使用了

rotation_range(随机旋转)、width_shift_range(水平偏移)、height_shift_range(竖直偏移)、shear_range(剪切变换)、zoom_range(随机缩放)以及horizontal_flip(水平翻转)等多种数据增强操作,使模型能够在训练时看到更多的图像变种,从而提升其对不同形态细胞的泛化能力。 - 标签数据转换:对于分割标签,本项目对其进行了多类转换和归一化处理,确保所有分割后的标签数据在同一维度上进行处理,从而提升了模型对细胞轮廓的识别效果。

4. 模型架构

1) 模型结构逻辑及数学公式

本项目采用的是经典的U-Net模型,该模型是一种全卷积神经网络(FCN),专门用于图像分割任务。U-Net模型由编码器(Encoder)和解码器(Decoder)组成,形成“U”字形结构,具备跳跃连接(skip connections),从而能够在解码阶段融合低层特征信息,提升分割精度。模型的具体结构如下:

输入层:

- 输入尺寸为

(256, 256, 1)的单通道灰度图像。

X = Input ( ( 256 , 256 , 1 ) ) X = \text{Input}((256, 256, 1)) X=Input((256,256,1))

卷积层与池化层:

- 编码器部分由4个卷积模块(

conv1到conv4)构成。每个模块包含两层Conv2D卷积操作和一个MaxPooling2D下采样操作,通道数逐渐增加(64, 128, 256, 512),并使用ReLU作为激活函数。卷积核大小为3×3,padding 方式为same,初始化方式为he_normal。

Conv2D ( F , K , activation = ′ r e l u ′ , padding = ′ s a m e ′ ) \text{Conv2D}(F, K, \text{activation}='relu', \text{padding}='same') Conv2D(F,K,activation=′relu′,padding=′same′)

其中: F是滤波器数量(如 64、128 等), K 是卷积核大小(3×3)。

瓶颈层:

- 经过4次下采样后,模型在

conv5层达到最深处(1024个通道)。此层之后添加Dropout层(0.5),以防止过拟合。

Dropout ( 0.5 ) \text{Dropout}(0.5) Dropout(0.5)

上采样与卷积层:

- 解码器部分通过

UpSampling2D(上采样操作)逐步恢复图像的空间分辨率,并且每个上采样层与编码器的对应层进行特征拼接(concatenate)。这种跳跃连接(skip connection)保留了高分辨率的特征,使模型能够更好地定位目标边界。解码器部分的通道数逐步减少(512, 256, 128, 64)。

UpSampling2D ( s i z e = ( 2 , 2 ) ) \text{UpSampling2D}(size=(2, 2)) UpSampling2D(size=(2,2))

输出层:

- 最终输出经过

Conv2D(1×1卷积)压缩至1个通道,并使用sigmoid激活函数,输出每个像素点的分割概率。

Conv2D ( 1 , 1 , activation = ′ s i g m o i d ′ ) \text{Conv2D}(1, 1, \text{activation}='sigmoid') Conv2D(1,1,activation=′sigmoid′)

- 模型的整体训练流程

数据增强: 使用 ImageDataGenerator 模块对输入图像进行多种随机变换(旋转、平移、缩放、水平翻转等),提高模型的泛化能力。

模型编译: 使用 Adam 优化器(学习率设为 1e-4),损失函数为 binary_crossentropy,度量指标为 accuracy。

模型训练: 使用 fit_generator 进行模型训练,输入批量大小为 2,每个 epoch 进行 300 次迭代,训练 10 个 epoch。

模型评估与预测: 训练完成后使用 predict_generator 在测试集上进行预测,并将结果保存为 .npy 格式。

- 评估指标

交叉熵损失(Binary Cross-Entropy) : 交叉熵损失用于衡量模型输出与真实标签之间的差异,定义如下:

Loss = − 1 N ∑ i = 1 N [ y i ⋅ log ( p i ) + ( 1 − y i ) ⋅ log ( 1 − p i ) ] \text{Loss} = -\frac{1}{N} \sum_{i=1}^N [y_i \cdot \log(p_i) + (1-y_i) \cdot \log(1-p_i)] Loss=−N1i=1∑N[yi⋅log(pi)+(1−yi)⋅log(1−pi)]

其中,yi为真实标签,pi为模型预测概率。

准确率(Accuracy) : 用于衡量分割结果的整体正确率。

5. 核心代码详细讲解

2. 模型架构构建

class myUnet(keras.Model):def init(self, img_rows=256, img_cols=256):

self.img_rows = img_rows

self.img_cols = img_cols

解释:定义了 myUnet 类,继承自 Keras 的 Model,同时指定输入图像的尺寸为 256×256。

def unet(self, pretrained_weights=None):

inputs = Input((self.img_rows, self.img_cols, 1))

解释:模型的输入层,接受一个尺寸为 256×256×1 的单通道灰度图像。

conv1 = Conv2D(64, 3, activation='relu', padding='same', kernel_initializer='he_normal')(inputs)

conv1 = Conv2D(64, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv1)

pool1 = MaxPooling2D(pool_size=(2, 2))(conv1)

解释:第一层卷积模块,包含两个 64 个滤波器的 3×3 卷积操作,激活函数为 ReLU。padding='same' 确保输出尺寸与输入相同,he_normal 初始化权重。随后使用 MaxPooling2D 进行 2×2 大小的下采样。

conv5 = Conv2D(1024, 3, activation='relu', padding='same', kernel_initializer='he_normal')(pool4)

drop5 = Dropout(0.5)(conv5)

解释:瓶颈层使用 1024 个滤波器进行卷积,并通过 Dropout (0.5)防止过拟合。此层代表模型编码器部分的最深层次。

up6 = Conv2D(512, 2, activation='relu', padding='same', kernel_initializer='he_normal')(UpSampling2D(size=(2, 2))(drop5))

merge6 = concatenate([drop4, up6], axis=3)

解释:解码器部分使用 UpSampling2D 对特征图进行上采样,并通过 Concatenate 操作将其与编码器对应层的输出进行拼接,形成跳跃连接(skip connection),有助于保留高分辨率的特征信息。

conv10 = Conv2D(1, 1, activation='sigmoid')(conv9)

解释:最后一层输出为 1 个通道的 1×1 卷积层,使用 sigmoid 激活函数,将每个像素的分割概率输出到 [0,1] 区间,用于二分类问题。

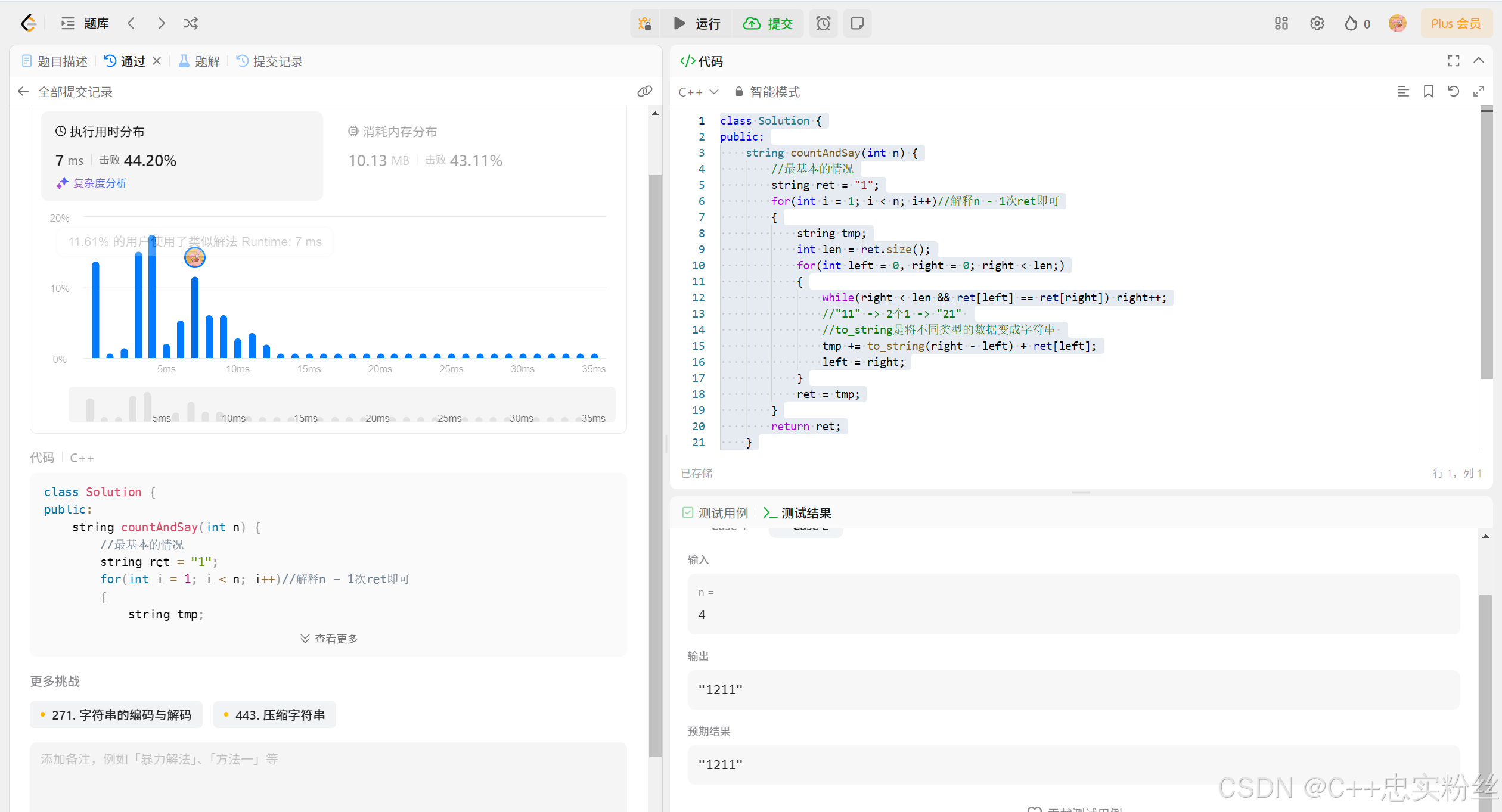

3. 模型训练与评估

model.compile(optimizer=Adam(lr=1e-4), loss='binary_crossentropy', metrics=['accuracy'])

解释:编译模型,使用 Adam 优化器,学习率为 1e-4,损失函数为 binary_crossentropy,并且评估指标为 accuracy(准确率)。

model_checkpoint = ModelCheckpoint('my_unet.hdf5', monitor='loss', verbose=1, save_best_only=True)

解释:使用 ModelCheckpoint 回调函数,监控训练过程中的损失值,并保存训练过程中损失值最低的模型。

model.fit_generator(myunet, steps_per_epoch=300, epochs=10, verbose=1, callbacks=[model_checkpoint])

解释:使用 fit_generator 训练模型,设置每个 epoch 执行 300 步,共训练 10 个 epoch。使用之前定义的回调函数保存最优模型。

4. 模型评估与预测

testGene = data.testGenerator("./data_set/test")

model = load_model('my_unet.hdf5')

imgs_mask_test = model.predict_generator(testGene, 30, verbose=1)

解释:加载已保存的最优模型,并在测试集上使用 predict_generator 进行分割预测,预测结果为每个像素的概率输出,结果保存为 .npy 文件格式。

6. 模型优缺点评价

模型优点:

- 高效的分割性能:U-Net 模型在图像分割任务中表现优异,尤其是在医学图像分割中,能够精准地提取目标区域的边界和轮廓。通过对输入图像的多尺度特征提取,模型能够捕捉到不同分辨率下的图像细节。

- 跳跃连接(Skip Connections)设计:U-Net 使用对称的“U”型架构,采用跳跃连接将编码器和解码器相连,保留了低分辨率特征图中丢失的细节信息,从而有效解决了传统卷积网络在上采样时信息丢失的问题。

- 适用于小数据集:由于 U-Net 使用了强大的数据增强方法,并且引入了

Dropout层以防止过拟合,因此在小规模医学图像数据集上也能取得较好的分割效果。

模型缺点:

- 参数量较大:U-Net 的深层结构导致模型参数量较大,占用较多内存,训练时计算开销较高,不适合在资源受限的环境(如移动端设备)中使用。

- 对超参数敏感:模型对学习率、损失函数以及优化器的选择较为敏感,需要反复调试才能取得最佳性能。此外,批量大小(batch size)设置不当可能导致训练过程中的不稳定。

- 局限于单一分割任务:U-Net 设计主要针对图像分割任务,如果应用于多目标检测或其他任务时,需要在模型结构上做较大调整。

模型改进方向:

- 引入注意力机制(Attention) :可在解码阶段加入注意力模块,如 Attention U-Net 结构,以提升模型在复杂图像中的分割效果。

- 多任务学习:在分割任务中加入其他辅助任务(如边界检测),通过联合学习提升模型的分割精度。

- 超参数优化:利用自动化超参数调优工具(如 Optuna)对学习率、Dropout 率、卷积层数等进行调优,提升模型性能。

↓↓↓更多热门推荐:

WaveNet模型实现电力预测

更多项目数据集、代码、教程点击下方名片↓↓↓

![[大语言模型-算法优化] 微调技术-LoRA算法原理及优化应用详解](https://i-blog.csdnimg.cn/direct/7d81fb702c5b42b4a9adc2a8a6bee102.png)