[大语言模型-算法优化] 微调技术-LoRA算法原理及优化应用详解

前言:

古人云: 得卧龙者,得天下。

然在当今大语言模型流行的时代,同样有一句普世之言: 会微调技术者,得私域大模型部署之道!

在众多微调技术中,LoRA (LOW-RANK ADAPTATION, lora)低秩适应是最常用的一种技术手段,尤其是当你面临多私域数据应用大模型部署,并且计算资源及内存资源又非常有限之时。

1. 背景简介

随着GPT等大语言模型的陆续出现,人们逐步发现和接受了这样一个现实规律: 增加数据量和模型参数往往是提升深度网络模型性能最简单粗暴的方法。 目前主流的大模型参数量,通常都是千亿级别起步,并且还在不断持续地扩大。

大型语言模型(LLM)的微调是为了使模型更好地适应特定的任务或领域。微调通常在模型的预训练阶段之后进行,预训练阶段模型在大量无标签数据上学习通用的语言特征,而微调阶段则使用特定任务的数据对模型进行进一步训练,以提高其在该任务上的表现。

微调技术主要包括以下几种:

-

全参数微调:在这种方法中,模型的所有参数都会根据特定任务的数据进行更新。这种方法能够充分利用预训练模型的通用特征,但可能需要更多的计算资源。

-

参数高效微调(PEFT):这是一种旨在减少微调参数数量和计算复杂度的方法,以减轻大型预训练模型的训练负担。PEFT包括多种技术,如:

- LoRA(Low-Rank Adaptation):通过在模型的关键层次中引入小型、低秩的矩阵来实现模型行为的微调,而无需对整个模型结构进行大幅度修改。这种方法在不显著增加额外计算负担的前提下,能够有效地微调模型,同时保留模型原有的性能水准 。

- QLoRA(Quantized Low-Rank Adaptation):结合了LoRA方法与深度量化技术,通过量化预训练模型为4位,大幅减少了模型存储需求,同时保持了模型精度的最小损失 。

- 适配器调整(Adapter Tuning):在模型的每个层或选定层之间插入小型神经网络模块,称为“适配器”。这些适配器是可训练的,而原始模型的参数则保持不变 。

- 前缀调整(Prefix Tuning):通过在输入数据前增加前缀来给模型提供一些先验知识,以提升微调效果。

- 提示调整(Prompt Tuning):通过设计特定的提示(prompt)来引导模型更好地完成特定任务。

- P-Tuning及P-Tuning v2:这些方法通过调整模型的注意力机制来提高微调效率。

微调的效果取决于多种因素,包括微调策略的选择、数据集的质量、模型的规模等。例如,LoRA方法已经在多个业务场景中证明了其有效性,能够在保持模型性能的同时显著减少训练参数量和显存占用 。而QLoRA则通过量化技术进一步降低了显存占用,使得在资源有限的环境下部署和训练大型模型成为可能 。通过选择合适的微调技术,可以在有限的资源下实现高效的模型定制。

2. LoRA算法

在2021年,一篇由微软公司研究者撰写的论文《LoRA: Low-Rank Adaptation of Large Language Models 》首次提出LoRA算法,论文作者包括 Edward Hu, Yelong Shen, Phillip Wallis, Zeyuan Allen-Zhu, Yuanzhi Li, Shean Wang, Weizhu Chen。这篇论文旨在解决大型语言模型在特定任务或领域适应时面临的模型微调挑战。简要而言,LoRA(Low-Rank Adaptation)算法是一种用于大型语言模型微调的技术,它通过在模型的每个Transformer层中引入可训练的低秩矩阵来适应特定任务,而不是微调所有预训练的权重。这种方法显著减少了可训练参数的数量,从而降低了存储和计算成本,同时避免了在微调过程中可能发生的灾难性遗忘。

如上图所示,假设预训练的模型参数为

W

0

∈

R

m

×

n

W_{0} \in \mathcal{R}^{m \times n}

W0∈Rm×n, 我们通常的LLM微调则是希望利用新的领域训练数据对模型进行更新,学习一个

Δ

W

∈

R

m

×

n

\Delta W \in \mathcal{R}^{m \times n}

ΔW∈Rm×n, 从而使得模型参数更新为

W

′

W^{'}

W′, 即:

W

′

=

W

0

+

Δ

W

.

W^{'} = W_{0} + \Delta W.

W′=W0+ΔW.

由于

Δ

W

∈

R

m

×

n

\Delta W \in \mathcal{R}^{m \times n}

ΔW∈Rm×n是一个维度与原始模型参数同纬度的巨大矩阵,在模型参数微调时会消耗大量的计算资源和内存资源。为了解决这个问题,微软的研究者提出,可以使用低秩自适应(Low-Rank Adaptation, LoRA)技术。具体而言,则是:

Δ

W

=

A

B

\Delta W = AB

ΔW=AB

其中,矩阵

A

∈

R

m

×

r

A \in \mathcal{R}^{m \times r}

A∈Rm×r,

B

∈

R

r

×

n

B \in \mathcal{R}^{r \times n}

B∈Rr×n, 这里的关键点是

r

<

<

{

m

,

n

}

r << \{m, n\}

r<<{m,n}.

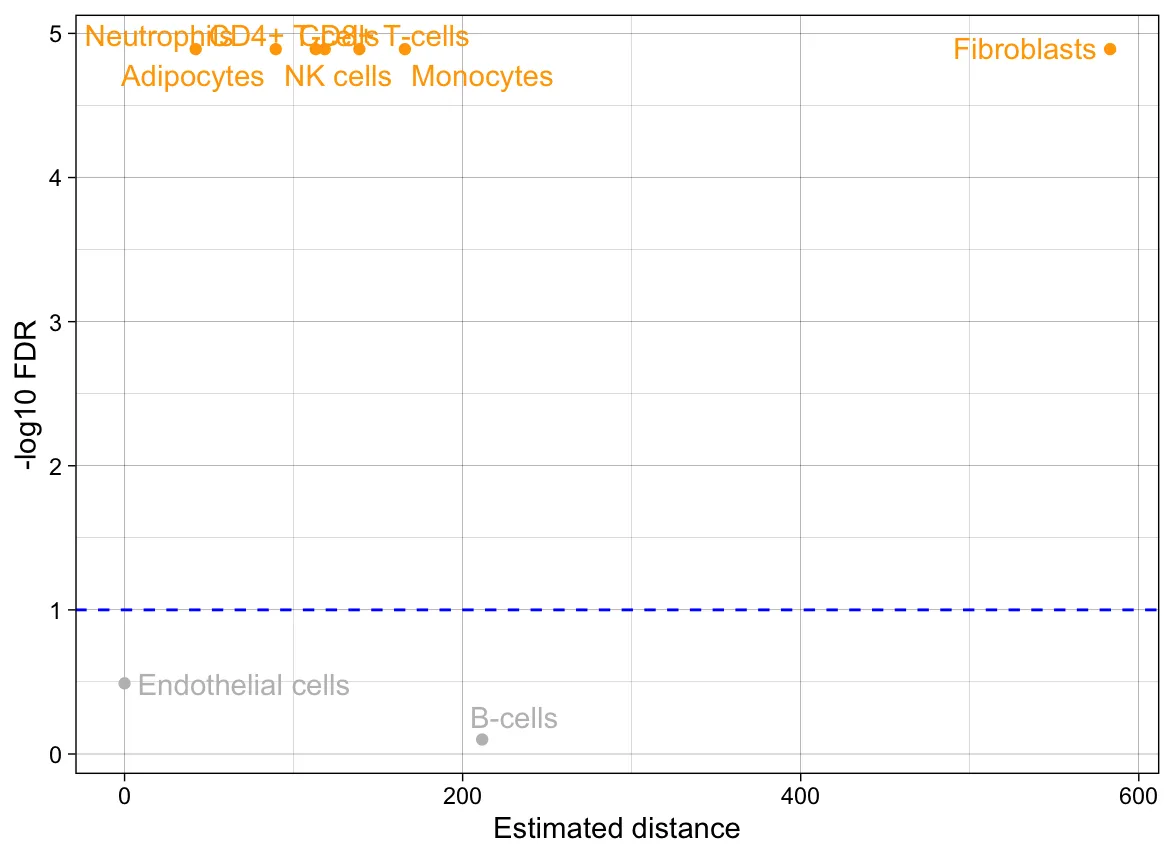

对于LoRA技术与普通的微调FT技术的区别,大致可以参考下面这个图:

在不同规模的语言模型中,LoRA算法的表现通常是有效的。例如,在GPT-3 175B模型上,LoRA能够减少可训练参数的数量高达10000倍,并且减少GPU内存需求约3倍。实验结果表明,即使训练参数大幅减少,LoRA在模型质量上也能与全参数微调相媲美或更好。这表明LoRA在保持模型性能的同时,显著提高了训练和部署的效率。

具体性能对比数据可以参考以下实验结果:

- 在RoBERTa模型上,使用LoRA微调的参数数量为0.3M,与其他方法相比,在GLUE基准测试中取得了与全参数微调相当的性能。

- 在DeBERTa XXL模型上,LoRA微调的参数数量为4.7M,在GLUE基准测试中也表现出色。

- 在GPT-2模型上,LoRA在E2E NLG Challenge任务中的表现超过了一些具有相似或更少可训练参数的基线方法。

这些结果表明,LoRA算法在不同规模的语言模型中都能有效工作,并且在减少资源消耗的同时保持或提高了模型的性能。这些发现对于需要在资源有限的环境中部署大型语言模型的应用场景尤其有价值。

实际在微调大型模型时,以下是一些技巧和考虑因素:

-

选择合适的微调策略:全参数微调虽然可以获得最佳效果,但资源消耗大。LoRA作为一种参数高效的微调方法,可以在保持资源效率的同时,通过避免灾难性遗忘来提高微调质量。

-

确定微调的层:可以选择只微调模型的特定层,例如注意力机制层,或者选择微调所有线性层,这可能会提高微调质量。

-

配置LoRA适配器:在LoRA配置中,可以定义低秩适配器的参数,如秩(r)、目标模块(target_modules)、LoRA比例因子(lora_alpha)、dropout率等。这些参数的选择会对微调结果产生显著影响。

-

数据准备:为了进行有监督的微调,需要将数据转换为适合的格式,即提示-响应对。

-

训练参数:定义训练参数,如训练周期、批量大小和其他训练超参数。

-

模型部署:在部署时,需要考虑是否合并适配器权重到预训练模型中,这可能会影响推理延迟。

3. QLoRA

论文: https://arxiv.org/pdf/2305.14314

QLoRA(Quantized Low-Rank Adaptation)是2024年提出的一种用于大型语言模型(LLMs)微调的技术,它通过量化和低秩矩阵分解来减少模型在微调过程中的内存占用和计算成本。在论文中,作者提出QLORA,一种高效的微调方法,能够在保持16位全精度微调任务性能的同时,显著降低内存使用量。通过在冻结的4位量化预训练语言模型中反向传播梯度到低秩适配器(LoRA),QLORA能够在单个48GB GPU上微调65B参数模型。最佳模型系列名为Guanaco,其在Vicuna基准测试上的表现超越了所有以前公开发布的模型,达到了ChatGPT性能的99.3%,同时仅需在单个GPU上微调24小时。QLORA引入了多项创新以节省内存:(a) 4位NormalFloat(NF4),一种新的数据类型,对于正态分布的权重在信息理论上是最优的;(b) 双重量化,通过量化量化常数来减少平均内存占用;© 页面优化器,使用NVIDIA统一内存来管理内存峰值。

算法原理

-

量化(Quantization):QLoRA通过量化技术将模型参数从浮点数转换为低精度的表示,如4-bit量化。这种方法减少了模型参数的内存占用,同时通过特定的量化策略(如NormalFloat量化)来保持模型性能。

-

低秩矩阵分解(Low-Rank Adaptation):QLoRA利用低秩矩阵分解的思想,将原始的高维权重矩阵分解为两个低秩矩阵的乘积,从而减少需要更新的参数数量。

-

分页优化器(Paged Optimizers):QLoRA使用分页优化器来管理内存使用,通过NVIDIA统一内存特性在CPU和GPU之间自动页面传输,以避免内存不足错误。

应用效果

- QLoRA能够在单个GPU上进行大型模型的微调,显著降低了对硬件资源的需求。

- 它能够在保持模型性能的同时,减少内存占用和计算成本,使得在资源有限的环境中也能进行大型模型的微调。

- 实验表明,QLoRA优化后的模型在多个自然语言处理任务上取得了与全精度模型相媲美的性能。

使用技巧

-

选择合适的量化策略:QLoRA使用NormalFloat量化来确保量化过程在信息理论上是最优的,这有助于保持模型性能。

-

调整低秩适配器的参数:QLoRA通过调整低秩适配器的参数(如秩r和缩放系数alpha)来控制模型的微调程度,这些参数的选择对模型性能有重要影响。

-

利用分页优化器管理内存:通过使用分页优化器,QLoRA可以在内存紧张的情况下继续训练,这对于在内存较小的设备上微调大型模型尤为重要。

-

实验和调优:QLoRA的性能可能受到多种因素的影响,包括数据集的质量、模型的大小和结构等。通过实验和调优,可以找到最佳的微调配置。

-

硬件选择:虽然QLoRA可以在消费级GPU上运行,但更大的内存和更强大的计算能力可以进一步提高微调的效率和模型的性能。

QLoRA作为一种高效的大型语言模型微调方法,通过量化技术和低秩矩阵分解,为自然语言处理领域的研究者和开发者提供了一种新的工具和方法,有助于推动LLMs在实际应用中的更广泛应用和发展。

参考资料

[1] https://www.thepaper.cn/newsDetail_forward_25531528

[2] Hu, Edward J., et al. “Lora: Low-rank adaptation of large language models.” arXiv preprint arXiv:2106.09685 (2021).

[3] Dettmers, Tim, et al. “Qlora: Efficient finetuning of quantized llms.” Advances in Neural Information Processing Systems 36 (2024).

后记

如果您对我的博客内容感兴趣,欢迎三连击(点赞,关注和评论),我将持续为您带来计算机人工智能前沿技术(尤其是AI相关的大语言模型,深度学习,计算机视觉相关方向)最新学术论文及工程实践方面的内容分享,助力您更快更准更系统地了解 AI前沿技术。