文章目录

- 导图

- 1. Hadoop的安全风险

- 2. 常见攻击方式

- 3. Hadoop的自带安全功能

- 4. Apache Knox和Apache Ranger等安全框架

- 5. 安全策略建议

导图

1. Hadoop的安全风险

Hadoop最初设计为在可信网络中运行,因此默认安全性较低。常见的安全风险包括:

- 未经授权的访问:Hadoop默认不启用认证和授权功能,攻击者可以直接通过客户端连接并操作数据。

- 数据传输安全:节点间的数据传输默认是明文的,容易被网络窃听攻击截获。

- 伪造节点攻击:攻击者可以伪装成Hadoop集群中的一个节点,获取数据,甚至影响资源调度。

2. 常见攻击方式

- 未经授权的客户端访问:由于缺乏认证机制,攻击者可以通过连接Hadoop集群执行未经授权的操作。

- 数据窃听:黑客可以在网络层控制交换机或网络设备,拦截并读取节点间明文传输的数据。

- 伪造节点加入集群:攻击者伪装成合法节点,甚至可能假冒NameNode,控制资源分配和数据流。

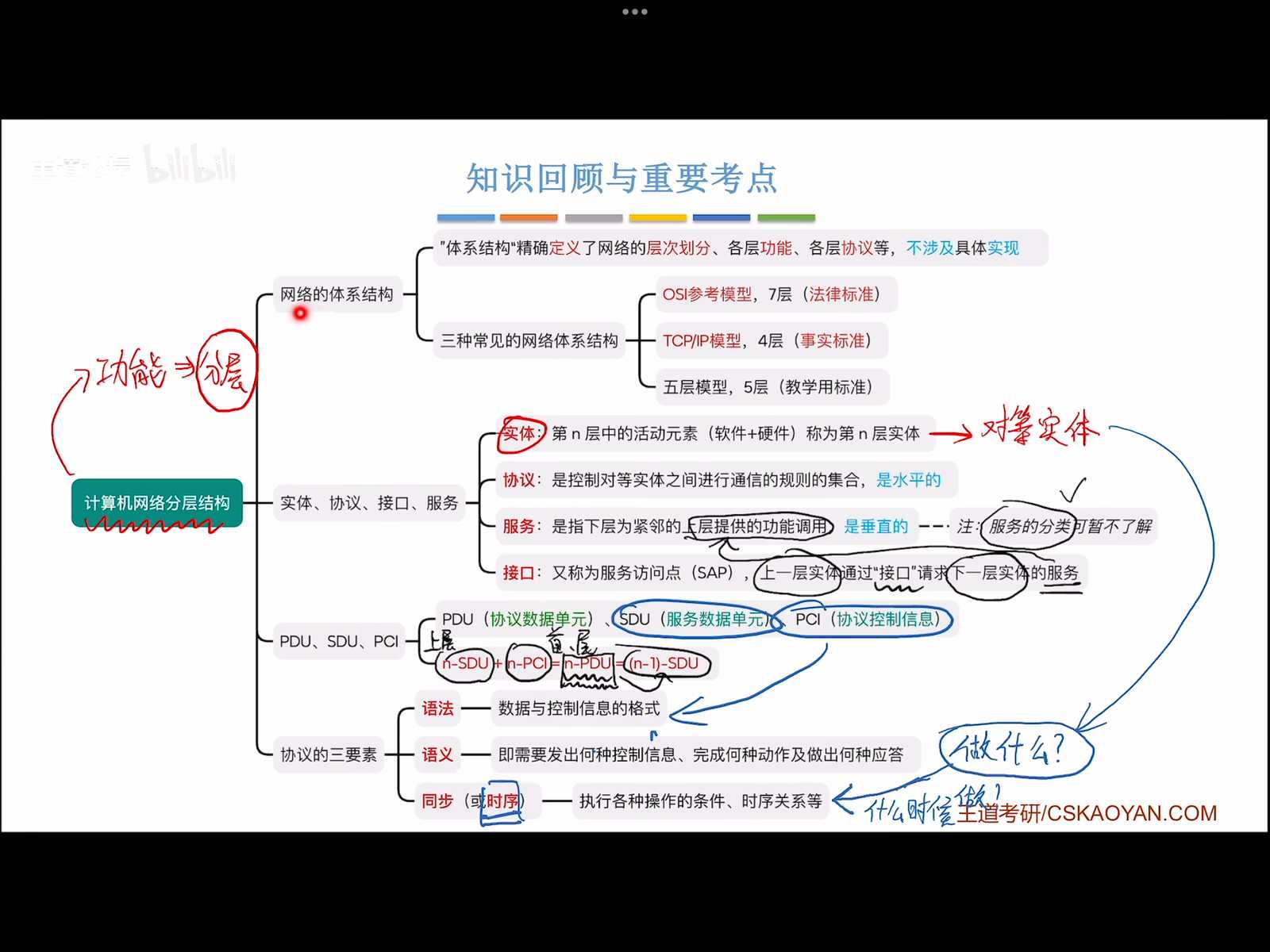

3. Hadoop的自带安全功能

Hadoop通过引入Kerberos协议,提供了节点和服务间的身份认证。Kerberos协议可以确保只有经过认证的节点和服务才能参与集群中的数据操作。认证流程包括:

- Keytab文件:每个节点在加入Hadoop集群时,需要一个Kerberos生成的密钥文件,用以保证服务的身份验证。

- Principal格式:Keytab文件中的Principal用于唯一标识服务,包含

username/host@realm的格式,通过绑定节点和服务实现身份确认。

此外,HDFS支持数据加密,通过加密区(Zone)对存储在分布式文件系统中的数据进行加密存储。加解密过程依赖于Key Management Server (KMS),该服务器会根据用户请求分配加密密钥。

4. Apache Knox和Apache Ranger等安全框架

在Hadoop生态系统中,除了自带的安全功能,开发者可以通过集成外部的安全框架来增强认证、授权、审计功能。主要包括:

-

Apache Knox:它充当Hadoop的安全网关,所有请求必须经过Knox验证。Knox可以集中管理认证并与Kerberos集成,实现用户认证与授权。

-

Apache Sentry:类似于Ranger,提供集中的授权机制,但主要适用于特定工具如Hive和Impala。随着Apache Ranger的广泛应用,Sentry逐渐被整合进Ranger中。

- Apache Ranger:它提供了集中化的授权管理,通过轻量级插件来为Hadoop的不同组件(如HDFS、Hive等)实现访问控制和审计功能。Ranger支持基于角色的访问控制(Role-Based Access Control, RBAC),并且可以与Knox配合使用,提供认证和授权的组合方案。

5. 安全策略建议

在分布式大数据环境中,推荐使用Apache Knox + Apache Ranger的组合来确保Hadoop集群的安全:

- 认证:通过Kerberos和Apache Knox实现用户和节点的身份认证。

- 授权:通过Apache Ranger的集成插件,对Hadoop生态中的所有组件实施统一的授权控制。

- 审计:使用Ranger来追踪并记录所有授权操作,提供详细的审计日志。

- 加密:在HDFS中创建加密Zone,结合KMS进行密钥管理,确保数据存储安全。