引言

在迅速发展的人工智能领域,整合多种数据模态(如文本、图像、音频和传感器数据)是一个极具挑战性的任务。传统的单一模型AI系统通常难以应对同时处理多模态时产生的指数级复杂性。而这正是混合专家(Mixture of Experts,MoE)框架展现其真正价值的地方。虽然MoE本身相较于强大的单一模型AI解决方案可能显得影响较小,但其在多模态系统中的应用是革命性的。通过将每种模态交给特定的专家模型,MoE多模态系统能够有效管理复杂性,从而提高数据处理和整合的效率。

理解混合专家(MoE)

模态在MoE中的作用

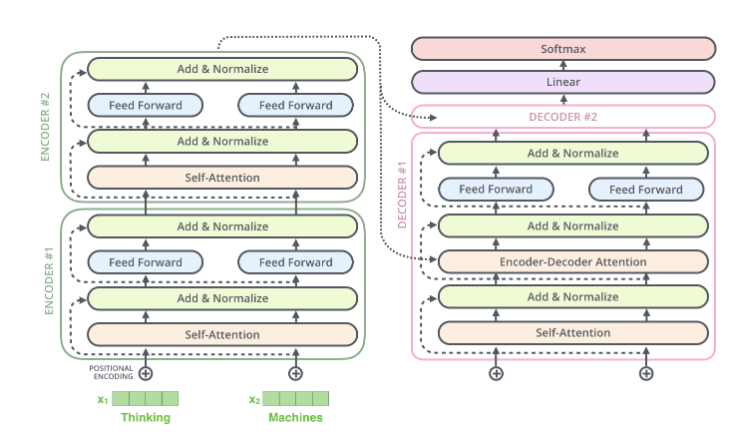

混合专家架构的核心在于,通过专家模型的专门化优势,每个专家都能被精心调优以处理特定的数据模态。在多模态情境下,各数据类型的差异性十分显著——文本数据需要自然语言处理技术,图像需要计算机视觉算法,而音频数据则要求信号处理方法。试图构建一个能有效处理所有这些模态的单一模型通常是不现实的,原因在于缺乏足够的对齐数据以及各模态处理要求的巨大差异。MoE通过为每个模态分配一个专家,从而简化了整体系统设计并提高了性能。

当前形势

目前,多模态MoE系统在需要整合多种输入类型的应用中处于前沿。自动驾驶、多媒体内容分析、虚拟助手等领域依赖于同时处理多个模态。例如,自动驾驶车辆需要解读来自摄像头的视觉数据、来自LIDAR的空间数据,以及来自GPS和地图的上下文数据。通过在MoE框架中为每种模态分配专门的专家,这些系统能够比传统模型更有效地处理复杂输入。

挑战与未来方向

多模态MoE系统的主要挑战在于整合不断增加的模态。随着模态数量的增加,系统的复杂性成倍增长。对齐来自不同源的数据以生成一致的输出变得更加困难,尤其是在模态并不自然对齐或同步的情况下。此外,往往缺乏涵盖所有模态的完整集成数据,使得训练一个能够处理所有内容的模型变得困难。

展望未来,多模态MoE系统的进步将集中在改进模态的整合与对齐上。研究人员正在探索如何在不需要对系统进行大规模重构的情况下引入新模态的方法,包括开发可以跨越不同模态的通用特征表示,从而实现更顺畅的数据整合。

多模态MoE系统的重要性

引言

多模态MoE系统代表了AI领域中的重要创新,提供了应对多样化数据类型复杂性结构化的方法。随着模态的增加,处理和整合它们的复杂性成倍增加。由于缺乏足够对齐的数据以及各模态之间的本质差异,构建一个处理所有模态的单一模型变得不切实际。多模态MoE系统通过整合所需数量的特定数据专家,每个专家都有效地处理其负责的模态,从而应对了这一挑战。

现状

这些系统在需要同时处理多种数据类型的领域尤其常见。例如,在多媒体内容分析中,结合文本、视觉和音频数据能够实现更丰富、更准确的内容解读和推荐。多模态MoE系统对每个模态的精确处理能力远远超过可能会在处理如此多样化数据时显得力不从心的传统模型。

挑战与未来预测

尽管多模态MoE系统具有显著优势,但它们面临着巨大的挑战。一个主要问题是新模态的整合,通常需要对系统进行广泛的重新校准并引入新的专家模型。对齐来自这些不同源的数据以生成一致的输出仍然是一个复杂的任务,尤其是在数据的多样性和数量不断增加的情况下。

对于多模态MoE系统的未来预测,重点是提升其适应性和灵活性。研究人员正在探索简化新模态整合的方法,可能通过自动化的专家创建和整合过程。此外,随着保持上下文和意义的需要日益明确,研究者们还需要开发更复杂的对齐技术,以便动态同步来自不同模态的数据。

使用LangChain实现多模态MoE

LangChain简介

LangChain 提供了一个强大的框架,用于实现多模态MoE系统。其模块化架构允许开发人员创建和管理专门的工具或代理——每个工具或代理作为特定模态的专家。通过简化这些专家的整合,LangChain使在统一系统内高效处理多样化数据类型成为可能。

实际实现

下面是一个使用LangChain设置能够处理文本和图像数据的基本多模态MoE系统的全面示例:

from langchain.tools import BaseTool

# 定义处理文本的专家工具

class TextExpertTool(BaseTool):

name = "text_expert"

def run(self, input_text):

# 实现文本处理逻辑,例如情感分析

return f"处理过的文本: {input_text}"

# 定义处理图像的专家工具

class ImageExpertTool(BaseTool):

name = "image_expert"

def run(self, input_image):

# 实现图像处理逻辑,例如目标识别

return f"处理过的图像数据: {input_image}"

# 定义一个选择使用哪个专家的函数,基于输入数据的模态

def gating_function(input_data):

if isinstance(input_data, str):

return "text_expert"

elif isinstance(input_data, bytes): # 假设图像数据是字节格式

return "image_expert"

else:

raise ValueError("不支持的输入类型")

# 实现MoE代理

class MoEAgent:

def __init__(self, tools):

self.tools = {tool.name: tool for tool in tools}

def run(self, input_data):

expert_name = gating_function(input_data)

expert_tool = self.tools.get(expert_name)

if not expert_tool:

raise ValueError(f"未找到适合给定输入的专家: {expert_name}")

return expert_tool.run(input_data)

# 使用MoE系统示例

tools = [TextExpertTool(), ImageExpertTool()]

moe_agent = MoEAgent(tools)

# 测试文本输入

text_result = moe_agent.run("你好,这是一个文本示例。")

print(text_result)

# 测试图像输入(假设图像数据是字节字符串)

image_result = moe_agent.run(b'\x89PNG\r\n\x1a\n...')

print(image_result)

在这个代码中:

- TextExpertTool 和 ImageExpertTool 是处理文本和图像数据的专门专家。

- gating_function 根据数据模态将输入数据路由到合适的专家。

- MoEAgent 管理专家并使用正确的专家处理输入数据。

这种模块化方法使得通过添加新的专家工具和更新gating_function能够轻松扩展系统以支持更多模态。

讨论

多模态MoE系统成功的关键在于通过专门的专家有效处理不同的模态。通过专注于模态特定的处理,每个专家都可以为其数据类型采用最合适的算法和技术。这不仅提高了性能,还简化了新模态的整合,因为每个专家在MoE框架中是独立操作的。

虽然路由机制是必要的以正确处理输入数据,但主要挑战在于管理多个模态带来的复杂性。随着模态数量的增加,开发人员必须确保系统保持一致性,并且专家的整合不会导致冲突或低效。

结论

多模态混合专家系统代表了人工智能领域的一大进步,解决了处理多种数据类型时产生的指数级复杂性。通过将每种模态交给特定的专家模型处理,这些系统克服了传统单一模型的局限性,后者往往由于缺乏对齐数据以及数据类型本质上的差异而难以有效处理所有模态。

使用LangChain等框架实现多模态MoE系统,使开发人员能够构建可扩展和适应性强的AI应用程序。通过将模态作为MoE的关键要素,这些系统能够高效整合尽可能多的数据类型,并由专家级精度处理每种类型。这种方法不仅提高了性能,还允许随着新模态的出现,系统可以持续扩展。

随着AI领域的不断发展,模态特定处理在MoE框架中的重要性只会增加。整合多个模态的挑战将推动创新,促使更复杂的数据对齐和专家协调方法的

出现。最终,拥抱多模态MoE系统将使得AI应用程序更准确地反映现实世界中复杂、多方面的数据。

附录

- 模态(Modality):指数据的不同类型,例如文本、图像、音频等。

- 混合专家(Mixture of Experts, MoE):一种AI架构,通过多个专门的专家模型来处理不同的数据模态。

- LangChain:一个用于实现多模态系统的框架,提供了模块化架构以简化专家工具的管理和整合。

🍀后记🍀

博客的关键词集中在编程、算法、机器人、人工智能、数学等等,持续高质量输出中。

🌸唠嗑QQ群:兔叽の魔术工房 (942848525)

⭐B站账号:白拾ShiroX(活跃于知识区和动画区)

✨GitHub主页:yhbcode000(工程文件)

⛳Discord社区:AierLab(人工智能社区)