摘要

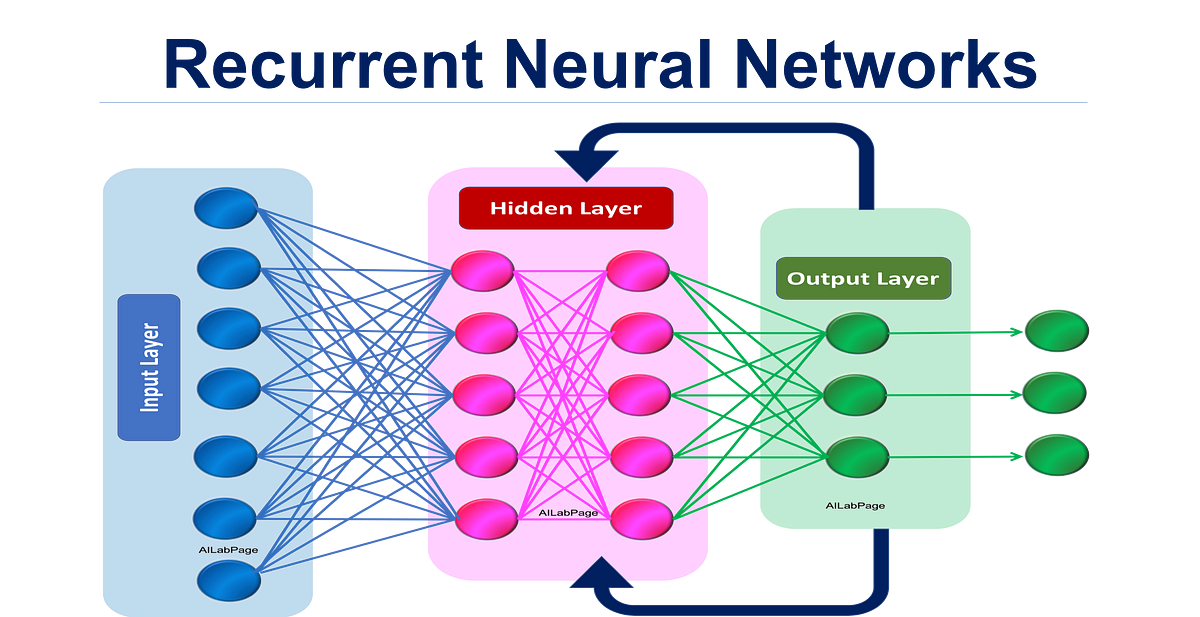

摘要:轻量级卷积神经网络(CNN)专为移动设备上的应用而设计,具有更快的推理速度。卷积操作只能在窗口区域内捕捉局部信息,这限制了性能的进一步提升。将自注意力引入卷积可以很好地捕捉全局信息,但会极大地拖累实际速度。本文提出了一种硬件友好的注意力机制(称为 DFC 注意力),并展示了一种用于移动应用的新 GhostNetV2 架构。提出的 DFC 注意力基于全连接层构建,不仅能在常见硬件上快速执行,还能捕捉远距离像素之间的依赖关系。作者进一步重新审视了之前 GhostNet 中的表达瓶颈,并提出通过 DFC 注意力增强由廉价操作生成的扩展特征,使得 GhostNetV2 块能够同时聚合局部和远距离信息。

理论介绍

GhostNetV2 提供了以下几种常见的模型权重,不同宽度缩放因子(Width Scaling):

- 1.0x: 标准模型。

- 1.3x: 模型深度比1.0x更深。

- 1.6x: 更大的模型版本,适用于计算资源较多的设备。

大家可以根据不同场景选择合适的模型宽度缩放因子,本文选择 1.0,具体可见第二章的代码。

GhostNet、GhostNetV2、GhostNetV3 模型在 参数量(M)、FLOPs(M)及 ImageNet 的 top1 结果对比情况如下:

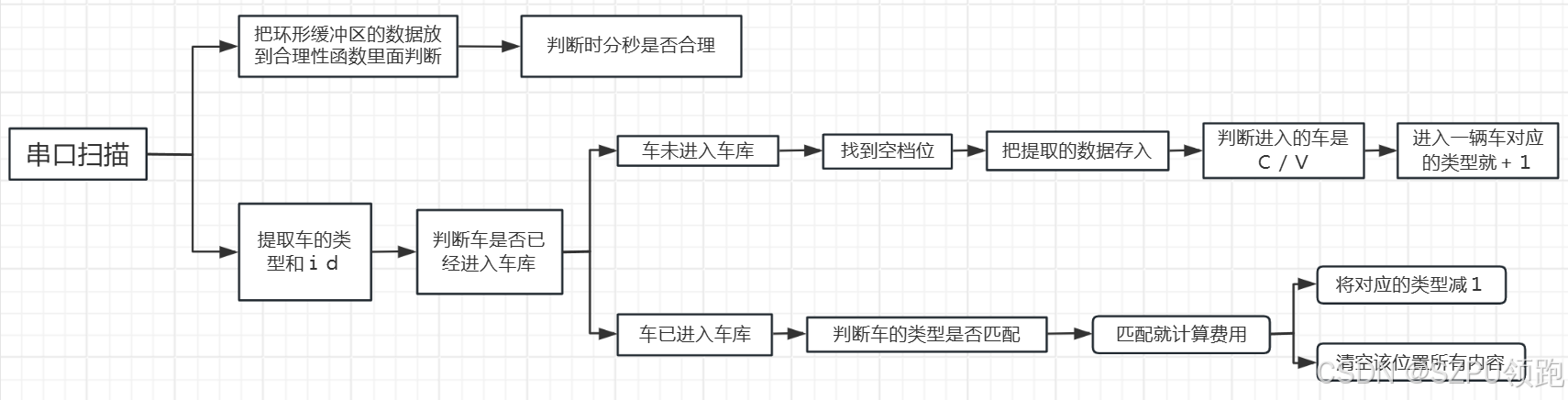

GhostNetV1 和 GhostNetV2 架构示意图如下图所示。Ghost 块是一个反向残差瓶颈,包含两个 Ghost 模块,其中 DFC 注意力增强了扩展特征以提高表达能力。

GhostNetV1 是一种轻量化模型,通过“Ghost 模块”减少冗余计算。Ghost 模块将 1×1 卷积和深度卷积结合在一起,生成一部分特征图后,通过廉价的操作生成剩